GitHub: https://github.com/chatsapi/ChatsAPI

ライブラリ: https://pypi.org/project/chatsapi/

人工知能は業界を変革しましたが、それを効果的に導入することは依然として困難な課題です。複雑なフレームワーク、遅い応答時間、急峻な学習曲線が、企業と開発者の両方にとって障壁となっています。 ChatsAPI をご利用ください。これは、比類のないスピード、柔軟性、シンプルさを実現するように設計された、画期的な高性能 AI エージェント フレームワークです。

この記事では、ChatsAPI のユニークな点、それがゲームチェンジャーである理由、そして開発者が比類のない簡単さと効率でインテリジェントなシステムを構築できるようにする方法を明らかにします。

ChatsAPI のユニークな点は何ですか?

ChatsAPI は単なる AI フレームワークではありません。それは AI 主導のインタラクションにおける革命です。その理由は次のとおりです:

- 比類のないパフォーマンス ChatsAPI は、SBERT 埋め込み、HNSWlib、BM25 ハイブリッド検索を活用して、これまで構築された中で最速のクエリマッチング システムを提供します。

速度: 応答時間がミリ秒未満である ChatsAPI は、世界最速の AI エージェント フレームワークです。 HNSWlib を利用した検索により、大規模なデータセットであっても、ルートと知識を超高速で取得できます。

効率: SBERT と BM25 のハイブリッド アプローチは、セマンティックな理解を従来のランキング システムと組み合わせて、速度と精度の両方を保証します。

LLM とのシームレスな統合

ChatsAPI は、OpenAI、Gemini、LlamaAPI、Ollama などの最先端の大規模言語モデル (LLM) をサポートしています。これにより、LLM をアプリケーションに統合する複雑さが簡素化され、より良いエクスペリエンスの構築に集中できるようになります。動的ルートマッチング

ChatsAPI は自然言語理解 (NLU) を使用して、比類のない精度でユーザーのクエリを事前定義されたルートに動的に照合します。

@trigger などのデコレーターを使用してルートを簡単に登録します。

ユースケースがどれほど複雑であっても、@extract でパラメーター抽出を使用して入力処理を簡素化します。

- シンプルなデザイン 私たちは、パワーとシンプルさは共存できると信じています。 ChatsAPI を使用すると、開発者は堅牢な AI 駆動システムを数分で構築できます。複雑なセットアップや構成に苦労する必要はもうありません。

ChatsAPI の利点

高パフォーマンスのクエリ処理

従来の AI システムは速度か精度のいずれかで苦労していますが、ChatsAPI は両方を実現します。膨大なナレッジ ベースから最適な一致を見つける場合でも、大量のクエリを処理する場合でも、ChatsAPI は優れています。

柔軟なフレームワーク

ChatsAPI は、次のものを構築しているかどうかにかかわらず、あらゆるユースケースに適応します。

- カスタマー サポート チャットボット。

- インテリジェントな検索システム。

- 電子商取引、ヘルスケア、教育向けの AI を活用したアシスタント。

開発者向けに構築

開発者によって開発者のために設計された ChatsAPI は以下を提供します:

- クイック スタート: わずか数ステップで環境をセットアップし、ルートを定義し、運用を開始します。

- カスタマイズ: デコレーターを使用して動作を調整し、特定のニーズに合わせてパフォーマンスを微調整します。

- 簡単な LLM 統合: 最小限の労力で OpenAI や Gemini などのサポートされている LLM を切り替えます。

ChatsAPI はどのように機能しますか?

ChatsAPI はその中核として、次の 3 段階のプロセスを通じて動作します。

- ルートの登録: @trigger デコレータを使用してルートを定義し、関数に関連付けます。

- 検索と一致: ChatsAPI は SBERT 埋め込みと BM25 ハイブリッド検索を使用して、ユーザー入力と適切なルートを動的に一致させます。

- パラメータの抽出: @extract デコレータを使用すると、ChatsAPI はパラメータを自動的に抽出して検証し、複雑な入力の処理を容易にします。

結果は?高速、正確、そして驚くほど使いやすいシステムです。

使用例

カスタマーサポート

非常に高速なクエリ解決により顧客との対話を自動化します。 ChatsAPI により、ユーザーは関連性のある回答を即座に得ることができるため、満足度が向上し、運用コストが削減されます。ナレッジベース検索

ユーザーが意味を理解して膨大なナレッジ ベースを検索できるようにします。ハイブリッド SBERT-BM25 アプローチにより、正確でコンテキストを認識した結果が保証されます。会話型 AI

ユーザー入力をリアルタイムで理解し、それに適応する会話型 AI エージェントを構築します。 ChatsAPI はトップ LLM とシームレスに統合し、自然で魅力的な会話を提供します。

なぜ気にする必要があるのでしょうか?

他のフレームワークは柔軟性やパフォーマンスを約束しますが、ChatsAPI のように両方を実現できるものはありません。私たちは次のようなフレームワークを作成しました:

- 市場の他のものより速い。

- セットアップと使用がより簡単。

- よりスマート。セマンティック アプローチとキーワード ベースのアプローチを融合した独自のハイブリッド検索エンジンを備えています。

ChatsAPI を使用すると、開発者は複雑さやパフォーマンスの低下に悩まされることなく、AI の可能性を最大限に引き出すことができます。

始め方

ChatsAPI を始めるのは簡単です:

- フレームワークをインストールします。

pip install chatsapi

- ルートを定義します。

from chatsapi import ChatsAPI

chat = ChatsAPI()

@chat.trigger("Hello")

async def greet(input_text):

return "Hi there!"

- メッセージからデータを抽出します

from chatsapi import ChatsAPI

chat = ChatsAPI()

@chat.trigger("Need help with account settings.")

@chat.extract([

("account_number", "Account number (a nine digit number)", int, None),

("holder_name", "Account holder's name (a person name)", str, None)

])

async def account_help(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

Run your message (with no LLM)

@app.post("/chat")

async def message(request: RequestModel, response: Response):

reply = await chat.run(request.message)

return {"message": reply}

- 会話 (LLM を使用) — 完全な例

import os

from dotenv import load_dotenv

from fastapi import FastAPI, Request, Response

from pydantic import BaseModel

from chatsapi.chatsapi import ChatsAPI

# Load environment variables from .env file

load_dotenv()

app = FastAPI() # instantiate FastAPI or your web framework

chat = ChatsAPI( # instantiate ChatsAPI

llm_type="gemini",

llm_model="models/gemini-pro",

llm_api_key=os.getenv("GOOGLE_API_KEY"),

)

# chat trigger - 1

@chat.trigger("Want to cancel a credit card.")

@chat.extract([("card_number", "Credit card number (a 12 digit number)", str, None)])

async def cancel_credit_card(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

# chat trigger - 2

@chat.trigger("Need help with account settings.")

@chat.extract([

("account_number", "Account number (a nine digit number)", int, None),

("holder_name", "Account holder's name (a person name)", str, None)

])

async def account_help(chat_message: str, extracted: dict):

return {"message": chat_message, "extracted": extracted}

# request model

class RequestModel(BaseModel):

message: str

# chat conversation

@app.post("/chat")

async def message(request: RequestModel, response: Response, http_request: Request):

session_id = http_request.cookies.get("session_id")

reply = await chat.conversation(request.message, session_id)

return {"message": f"{reply}"}

# set chat session

@app.post("/set-session")

def set_session(response: Response):

session_id = chat.set_session()

response.set_cookie(key="session_id", value=session_id)

return {"message": "Session set"}

# end chat session

@app.post("/end-session")

def end_session(response: Response, http_request: Request):

session_id = http_request.cookies.get("session_id")

chat.end_session(session_id)

response.delete_cookie("session_id")

return {"message": "Session ended"}

- LLM クエリに準拠するルート — 単一クエリ

await chat.query(request.message)

ベンチマーク

従来の LLM (API) ベースのメソッドは、通常、リクエストごとに約 4 秒かかります。対照的に、ChatsAPI は、LLM API 呼び出しを行わずに、リクエストを 1 秒未満、多くの場合はミリ秒以内に処理します。

チャット ルーティング タスクを 472 ミリ秒以内に実行します (キャッシュなし)

チャット ルーティング タスクを 21 ミリ秒以内に実行します (キャッシュ後)

チャット ルーティング データ抽出タスクを 862 ミリ秒以内に実行します (キャッシュなし)

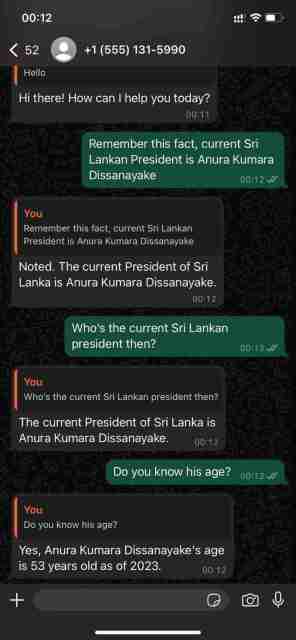

WhatsApp Cloud API を使用した会話機能の実証

ChatsAPI — 機能階層

ChatsAPI は単なるフレームワークではありません。それは、AI システムの構築と操作方法におけるパラダイム シフトです。 ChatsAPI は、速度、精度、使いやすさを組み合わせることで、AI エージェント フレームワークの新しいベンチマークを設定します。

今すぐ革命に参加して、ChatsAPI が AI の状況を変革する理由をご覧ください。

始める準備はできましたか?今すぐ ChatsAPI を始めて、AI 開発の未来を体験してください。

以上がChatsAPI — 世界最速の AI エージェント フレームワークの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

Pythonの実行モデル:コンパイル、解釈、またはその両方?May 10, 2025 am 12:04 AM

Pythonの実行モデル:コンパイル、解釈、またはその両方?May 10, 2025 am 12:04 AMpythonisbothcompiledinterted.whenyourunapythonscript、itisfirstcompiledintobytecode、これはdenepythonvirtualmachine(pvm).thishybridapproaChallowsforplatform-platform-denodent-codebutcututicut。

Pythonはラインごとに実行されますか?May 10, 2025 am 12:03 AM

Pythonはラインごとに実行されますか?May 10, 2025 am 12:03 AMPythonは厳密に行ごとの実行ではありませんが、最適化され、インタープレーターメカニズムに基づいて条件付き実行です。インタープリターは、コードをPVMによって実行されるBytecodeに変換し、定数式または最適化ループを事前促進する場合があります。これらのメカニズムを理解することで、コードを最適化し、効率を向上させることができます。

Pythonの2つのリストを連結する代替品は何ですか?May 09, 2025 am 12:16 AM

Pythonの2つのリストを連結する代替品は何ですか?May 09, 2025 am 12:16 AMPythonに2つのリストを接続する多くの方法があります。1。オペレーターを使用しますが、これはシンプルですが、大きなリストでは非効率的です。 2。効率的ですが、元のリストを変更する拡張メソッドを使用します。 3。=演算子を使用します。これは効率的で読み取り可能です。 4。itertools.chain関数を使用します。これはメモリ効率が高いが、追加のインポートが必要です。 5。リストの解析を使用します。これはエレガントですが、複雑すぎる場合があります。選択方法は、コードのコンテキストと要件に基づいている必要があります。

Python:2つのリストをマージする効率的な方法May 09, 2025 am 12:15 AM

Python:2つのリストをマージする効率的な方法May 09, 2025 am 12:15 AMPythonリストをマージするには多くの方法があります。1。オペレーターを使用します。オペレーターは、シンプルですが、大きなリストではメモリ効率的ではありません。 2。効率的ですが、元のリストを変更する拡張メソッドを使用します。 3. Itertools.chainを使用します。これは、大規模なデータセットに適しています。 4.使用 *オペレーター、1つのコードで小規模から中型のリストをマージします。 5. numpy.concatenateを使用します。これは、パフォーマンス要件の高い大規模なデータセットとシナリオに適しています。 6.小さなリストに適したが、非効率的な追加方法を使用します。メソッドを選択するときは、リストのサイズとアプリケーションのシナリオを考慮する必要があります。

コンパイルされた通信言語:長所と短所May 09, 2025 am 12:06 AM

コンパイルされた通信言語:長所と短所May 09, 2025 am 12:06 AMcompiledlanguagesOfferspeedandsecurity、foredlanguagesprovideeaseofuseandportability.1)compiledlanguageslikec arefasterandsecurebuthavelOnderdevelopmentsplat dependency.2)

Python:ループのために、そして最も完全なガイドMay 09, 2025 am 12:05 AM

Python:ループのために、そして最も完全なガイドMay 09, 2025 am 12:05 AMPythonでは、forループは反復可能なオブジェクトを通過するために使用され、条件が満たされたときに操作を繰り返し実行するためにしばらくループが使用されます。 1)ループの例:リストを通過し、要素を印刷します。 2)ループの例:正しいと推測するまで、数値ゲームを推測します。マスタリングサイクルの原則と最適化手法は、コードの効率と信頼性を向上させることができます。

Python concatenateリストを文字列に入れますMay 09, 2025 am 12:02 AM

Python concatenateリストを文字列に入れますMay 09, 2025 am 12:02 AMリストを文字列に連結するには、PythonのJoin()メソッドを使用して最良の選択です。 1)join()メソッドを使用して、 '' .join(my_list)などのリスト要素を文字列に連結します。 2)数字を含むリストの場合、連結する前にマップ(str、数字)を文字列に変換します。 3) '、'などの複雑なフォーマットに発電機式を使用できます。 4)混合データ型を処理するときは、MAP(STR、Mixed_List)を使用して、すべての要素を文字列に変換できるようにします。 5)大規模なリストには、 '' .join(lage_li)を使用します

Pythonのハイブリッドアプローチ:コンピレーションと解釈を組み合わせたMay 08, 2025 am 12:16 AM

Pythonのハイブリッドアプローチ:コンピレーションと解釈を組み合わせたMay 08, 2025 am 12:16 AMpythonusesahybridapproach、コンコイリティレーショントビテコードと解釈を組み合わせて、コードコンピレッドフォームと非依存性bytecode.2)

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

SublimeText3 英語版

推奨: Win バージョン、コードプロンプトをサポート!

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

Safe Exam Browser

Safe Exam Browser は、オンライン試験を安全に受験するための安全なブラウザ環境です。このソフトウェアは、あらゆるコンピュータを安全なワークステーションに変えます。あらゆるユーティリティへのアクセスを制御し、学生が無許可のリソースを使用するのを防ぎます。

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません

SublimeText3 中国語版

中国語版、とても使いやすい