ホームページ >ウェブフロントエンド >jsチュートリアル >ハグ顔 AI モデルを API として使用する方法

ハグ顔 AI モデルを API として使用する方法

- DDDオリジナル

- 2024-11-16 05:21:031078ブラウズ

このガイドでは、Meta LLaMA-3.2-3B-Instruct を例として、Hugging Face モデルを API として使用する方法を説明します。このモデルはチャットベースのオートコンプリート用に設計されており、会話型 AI タスクを効果的に処理できます。 API を設定して始めましょう!

ステップ 1: ハグフェイスのモデルを選択する

- Hugging Face Models に移動し、Meta LLaMA-3.2-3B-Instruct または実験したい他のモデルを検索します。

- モデルのページにアクセスしたら、推論 API をサポートしていることを確認します。これにより、モデルを API エンドポイントとして使用できるようになります。

ステップ 2: API トークンを作成する

Hugging Face のモデル API にアクセスするには、API トークンが必要です。

- Hugging Face アカウントにログインし、設定 > に移動します。 アクセストークン.

新しいトークンを選択して、読み取りトークンを作成します。これにより、リソースを変更または管理する権限がなくても、推論のために API を呼び出すことができます。

API 認証に必要となるため、トークンを安全に保存してください。

ステップ 3: モデルに推論 API を使用する

Hugging Face は、事前トレーニングされたモデルにアクセスするための サーバーレス推論 API を提供します。このサービスは、無料ユーザーにはレート制限があり、プロ アカウントには拡張された割り当てが適用されます。

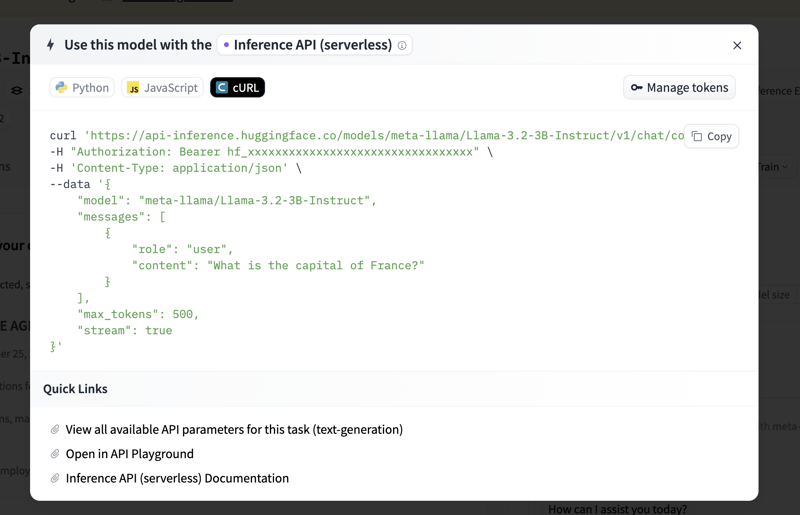

Meta LLaMA-3.2-3B-Instruct モデル ページで、Inference API タブをクリックします。このタブには、コード例と追加の API 使用法情報が表示されます。

開始するためのサンプル コードが見つかります。モデルの API を呼び出すための基本的な Python スクリプトを設定する方法は次のとおりです。

ステップ 4: レート制限の処理とプロ アカウントの利点

無料アカウントの場合、API レート制限が適用され、これを超えるとリクエストがスロットルされる可能性があります。 API を広範囲に使用する予定がある場合、またはより迅速な応答が必要な場合は、プロ アカウント を検討してください。詳細については、Hugging Face の価格ページをご覧ください。

まとめ

これらの手順に従うことで、Meta LLaMA-3.2-3B-Instruct またはその他のハグ フェイス モデルを API 経由でチャットのオートコンプリートや会話型 AI などのタスクに使用できます。このセットアップは柔軟性が高く、実験目的でも運用目的でも、AI 機能をアプリケーションに直接統合できます。

これで、Hugging Face の強力なモデルを探索して構築する準備が整いました!

以上がハグ顔 AI モデルを API として使用する方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。