ホームページ >テクノロジー周辺機器 >AI >ICML 2024 | グラデーションチェックポイント設定が遅すぎますか? LowMemoryBP は、ビデオ メモリの速度を低下させたり節約したりすることなく、バック プロパゲーション ビデオ メモリの効率を大幅に向上させます。

ICML 2024 | グラデーションチェックポイント設定が遅すぎますか? LowMemoryBP は、ビデオ メモリの速度を低下させたり節約したりすることなく、バック プロパゲーション ビデオ メモリの効率を大幅に向上させます。

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBオリジナル

- 2024-07-18 01:39:51770ブラウズ

AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。提出電子メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

この論文の筆頭著者は、南開大学統計データサイエンス学部修士課程2年生のYang Yuchen氏とその指導教員です。南開大学統計データサイエンス学部の徐軍准教授です。 Xu Jun 教授のチームの研究の焦点は、コンピューター ビジョン、生成 AI、効率的な機械学習であり、主要な会議や雑誌に多くの論文を発表しており、Google Scholar で 4,700 件以上引用されています。

大規模な Transformer モデルがさまざまな分野で徐々に統一されたアーキテクチャになってきたため、微調整は、事前トレーニングされた大規模なモデルを下流のタスクに適用するための重要な手段となっています。しかし、モデルのサイズは日々増大するため、微調整に必要なビデオメモリも徐々に増加し、微調整用のビデオメモリをいかに効率的に削減するかが重要な課題となっています。以前は、Transformer モデルを微調整する場合、グラフィックス メモリのオーバーヘッドを節約するために、勾配チェックポイント (アクティベーション再計算とも呼ばれます) を使用して、トレーニング速度を犠牲にしてバックプロパゲーション (BP) プロセスに必要な時間を短縮するのが一般的なアプローチでした。ビデオメモリの使用を有効にします。

最近、南開大学統計・データサイエンス学部のシュー・ジュン教師のチームがICML 2024で発表した論文「近似およびメモリ共有バックプロパゲーションによるメモリオーバーヘッドの微調整の削減」では、バックプロパゲーションを変更することで次のことを提案しました( BP) プロセスでは、計算量を増やすことなく、ピーク時のアクティベーション メモリ使用量が大幅に削減されます。

論文: 近似およびメモリ共有バックプロパゲーションによる微調整メモリオーバーヘッドの削減

論文リンク: https://arxiv.org/abs/2406.16282

プロジェクトリンク: https:/ / /github.com/yyyyychen/LowMemoryBP

この記事では、近似逆伝播 (About-BP) とメモリ共有逆伝播 (MS-BP) という 2 つの逆伝播改善戦略を提案しています。おおよその BP と MS-BP はそれぞれ、バックプロパゲーションにおけるメモリ効率を向上させる 2 つのソリューションを表しており、総称して LowMemoryBP と呼ぶことができます。理論的な意味でも実践的な意味でも、この記事はより効率的なバックプロパゲーション トレーニングのための画期的なガイダンスを提供します。

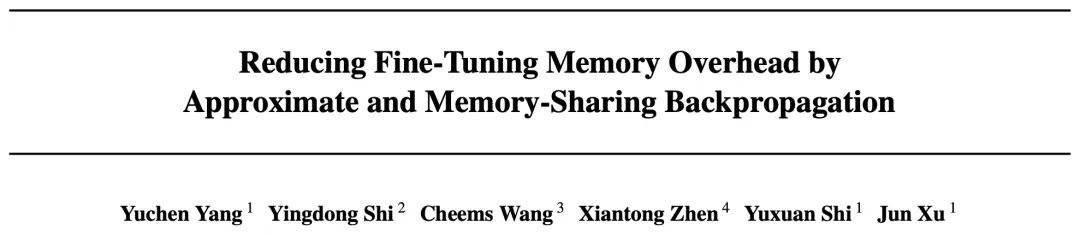

理論的なメモリ分析では、LowMemoryBP は活性化関数と正規化層からの活性化メモリの使用量を大幅に削減できます。ViT と LLaMA を例に挙げると、ViT を微調整すると活性化メモリを 39.47% 削減でき、LLaMA を微調整すると活性化を次のように削減できます。ビデオメモリは29.19%。

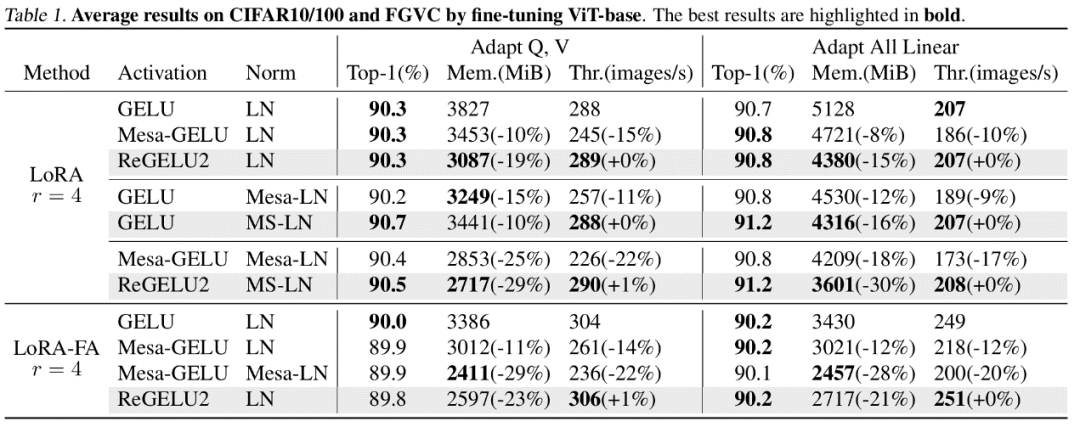

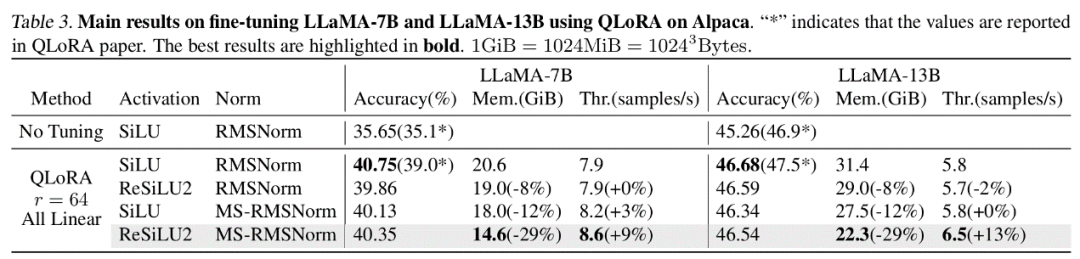

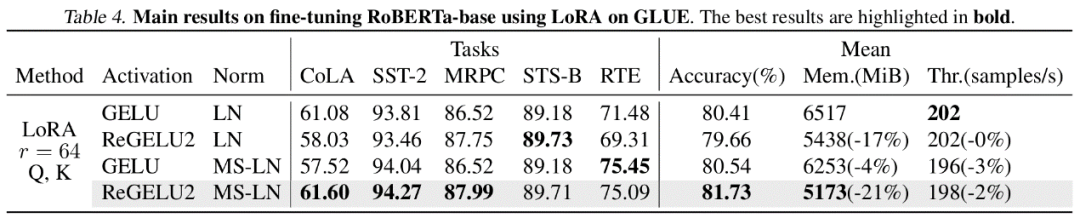

実際の実験では、LowMemoryBP は、ViT、LLaMA、RoBERTa、BERT、Swin を含む Transformer モデル微調整のピーク メモリ使用量を効果的に 20%~30% 削減でき、トレーニング スループットと損失は増加しません。テストの精度。

About-BP

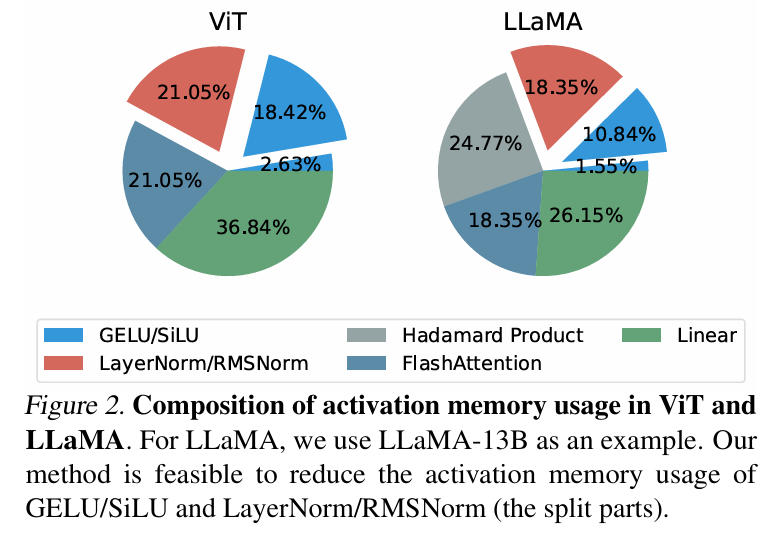

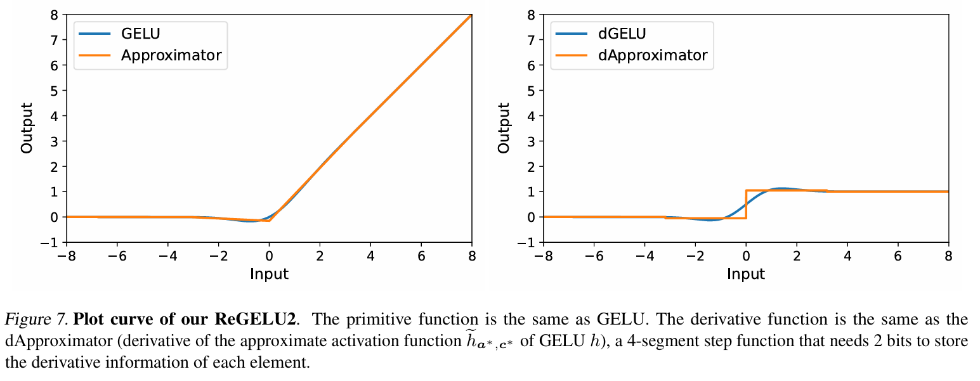

従来の逆伝播トレーニングでは、活性化関数の勾配の逆伝播は、Transformer モデルで一般的に使用される GELU 関数と SiLU 関数の導関数に厳密に対応します。これは、入力が必要であることを意味します。 be 特徴テンソルはアクティブ ビデオ メモリに完全に保存されます。この記事の著者は、一連のバックプロパゲーション近似理論、つまり近似 BP 理論を提案しました。この理論に基づいて、著者は区分線形関数を使用して活性化関数を近似し、GELU/SiLU 勾配の逆伝播を区分線形関数の導関数 (ステップ関数) に置き換えます。このアプローチにより、ReGELU2 と ReSiLU2 という 2 つの非対称メモリ効率の高い活性化関数が得られます。このタイプのアクティベーション関数は、リバース パスバックに 4 段階のステップ関数を使用するため、アクティベーション ストレージでは 2 ビット データ型のみを使用する必要があります。

MS-BP

BP ネットワークの各層は通常、バックプロパゲーション計算のために入力テンソルを活性化メモリに保存します。著者は、特定の層のバックプロパゲーションを出力依存形式に書き換えることができれば、この層と後続の層が同じ活性化テンソルを共有できるため、活性化ストレージの冗長性が削減されると指摘しています。

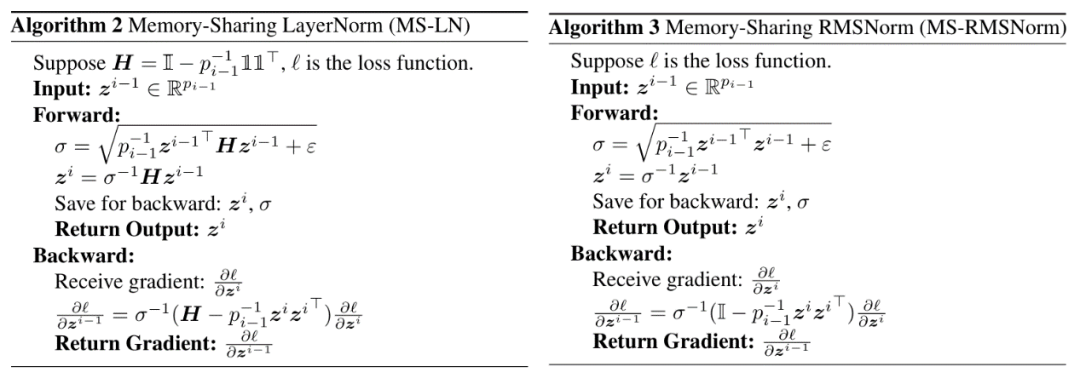

この記事では、Transformer モデルで一般的に使用される LayerNorm と RMSNorm は、アフィン パラメーターを後者の線形層にマージした後、MS-BP 戦略の要件を十分に満たすことができると指摘しています。再設計された MS-LayerNorm および MS-RMSNorm は、独立したアクティブ グラフィックス メモリを生成しなくなりました。

実験結果

著者は、コンピュータービジョンと自然言語処理の分野におけるいくつかの代表的なモデルに対して微調整実験を実施しました。このうち、ViT、LLaMA、RoBERTa の微調整実験では、論文で提案された方法により、トレーニング効果とトレーニング速度を損なうことなく、ピーク時のメモリ使用量がそれぞれ 27%、29%、21% 削減されました。比較の Mesa (8 ビット アクティベーション圧縮トレーニング法) ではトレーニング速度が約 20% 低下しますが、この記事で提案されている LowMemoryBP 法ではトレーニング速度が完全に維持されることに注意してください。

結論と意義

この記事で提案されている2つの血圧改善戦略、おおよその血圧とMS-BPは、どちらもトレーニング効果とトレーニングを維持しながらビデオメモリの活性化を達成します。大幅な節約。これは、BP 原則に基づいた最適化が非常に有望なメモリ節約ソリューションであることを意味します。さらに、この記事で提案されている近似 BP 理論は、従来のニューラル ネットワークの最適化フレームワークを打ち破り、不対導関数を使用するための理論的な実現可能性を提供します。その派生した ReGELU2 および ReSiLU2 は、このアプローチの重要な実用的価値を示しています。

アルゴリズムの詳細を理解するには、論文またはコードを読んでください。関連モジュールは LowMemoryBP プロジェクトの github リポジトリでオープンソース化されています。

以上がICML 2024 | グラデーションチェックポイント設定が遅すぎますか? LowMemoryBP は、ビデオ メモリの速度を低下させたり節約したりすることなく、バック プロパゲーション ビデオ メモリの効率を大幅に向上させます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。