AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。送信メール: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

この記事の著者は、上海交通大学、清華大学、ケンブリッジ大学、上海人工知能研究所の出身です。筆頭著者のChen Zheは、上海交通大学の博士課程の学生で、上海交通大学人工知能学部のWang Yu教授に師事しています。責任著者は、清華大学電子工学部の Wang Yu 教授 (ホームページ: https://yuwangsjtu.github.io/) と Zhang Chao 教授 (ホームページ: https://mi.eng.cam.ac.uk) です。 /~cz277)。

- ペーパーリンク: https://arxiv.org/abs/2403.14168

- プロジェクトホームページ: https://jack-zc8.github.io/M3AV-dataset-page/

- 論文タイトル: M3AV: マルチモーダル、マルチジャンル、多目的オーディオビジュアル学術講義データセット

オープンソースの学術講義の録音は、学術知識を共有する一般的に人気のある方法ですオンラインメソッド。これらのビデオには、話者の声、顔の表情、体の動き、スライド内のテキストと画像、対応する紙のテキスト情報など、豊富なマルチモーダル情報が含まれています。現在、マルチモーダルなコンテンツ認識と理解タスクを同時にサポートできるデータセットは非常に少数です。これは、高品質の人によるアノテーションが不足していることも一因です。

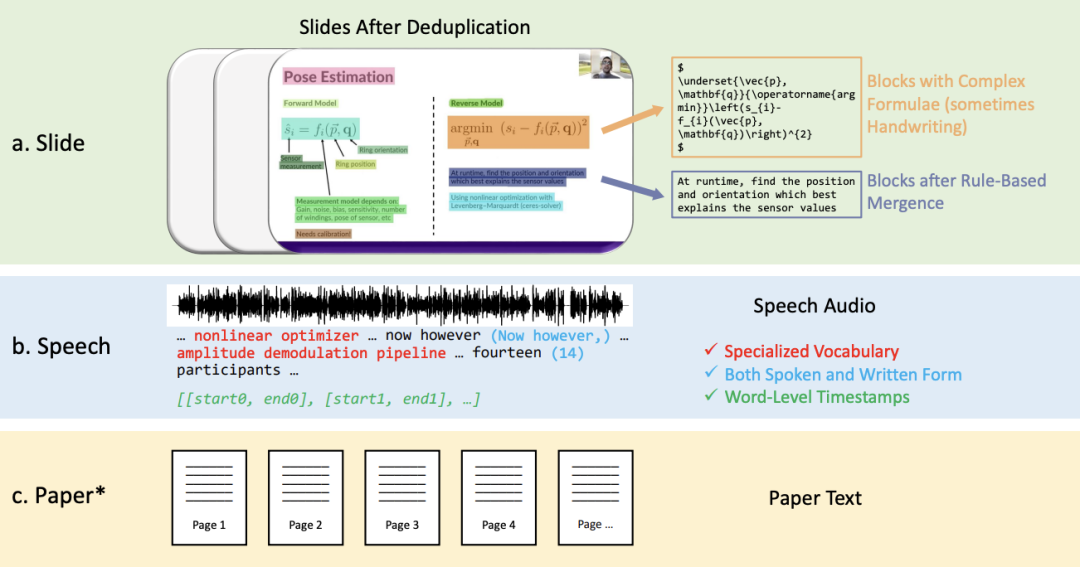

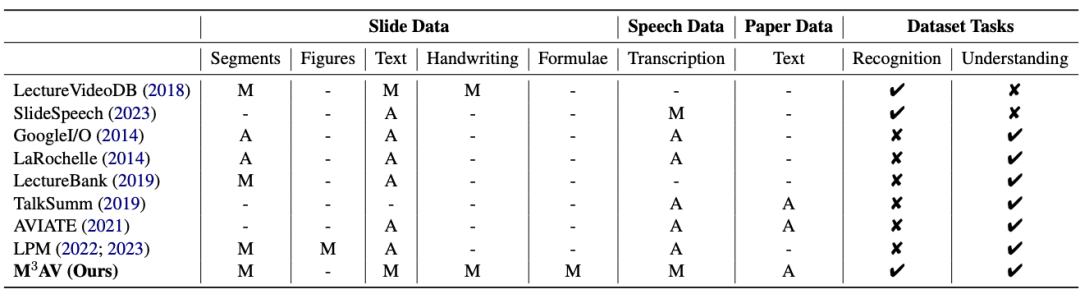

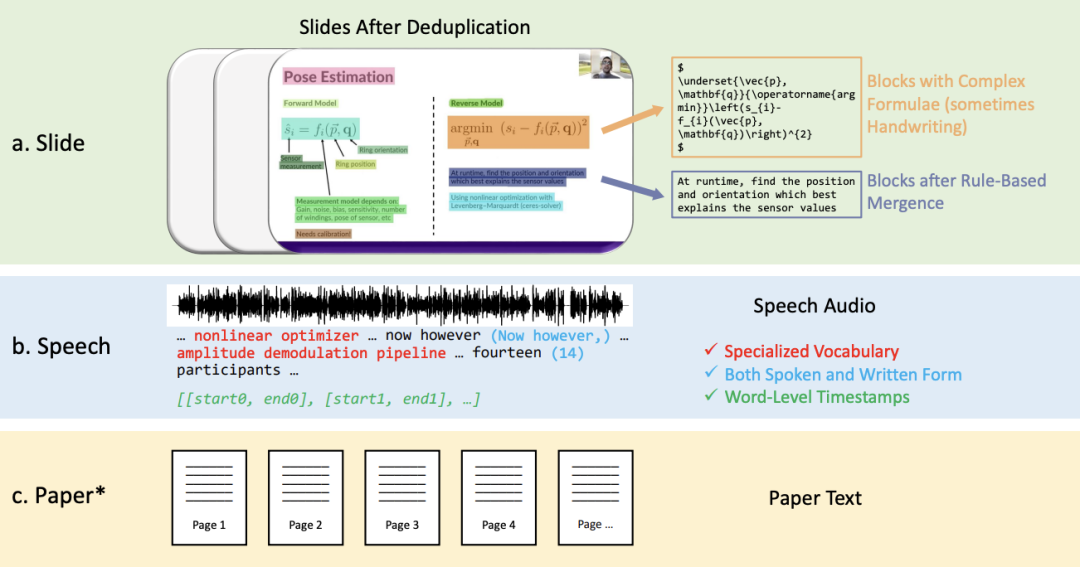

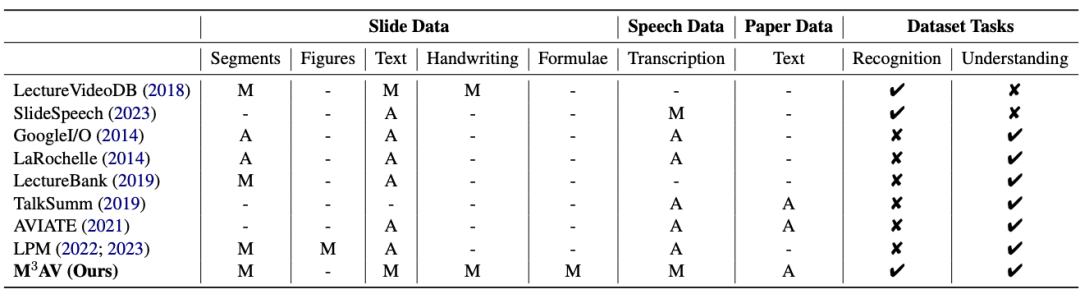

この研究は、新しいマルチモーダル、マルチタイプ、多目的視聴覚学術音声データセット (M3AV) を提案します。これには、コンピューター サイエンス、数学、医療、および科学をカバーする 5 つのソースからのほぼ 367 時間のビデオが含まれています。生物学的なトピック。高品質の人による注釈、特に価値の高い名前付きエンティティを備えたデータセットは、さまざまな視聴覚認識および理解タスクに使用できます。文脈に応じた音声認識、音声合成、スライドとスクリプトの生成タスクに関する評価では、M3AV が多様性に富んでいるため、困難なデータセットになっていることがわかりました。この作品はACL 2024本会議に採択されました。 M3AV データセットは主に次の部分で構成されます: 1. 複雑なブロックを含むスライド、それらは空間的位置に従って配置されます。関係はマージされます。 2. 特別な語彙と単語レベルのタイムスタンプを含む、話し言葉と書き言葉の音声文字起こしテキスト。 以下の表からわかるように、M3AV データセットには手動で注釈が付けられたスライド、音声、紙のリソースが最も多く含まれているため、マルチモーダルコンテンツ認識タスクをサポートするだけでなく、高度な学術タスクもサポートします知識 タスク を理解します。

同時に、M3AV データセットはあらゆる面で他の学術データセットよりも内容が豊富で、アクセス可能なリソースでもあります。

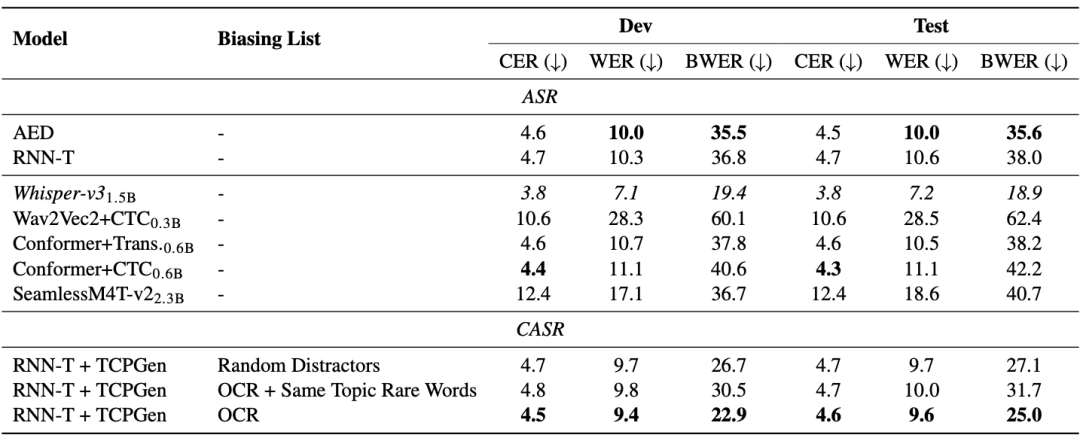

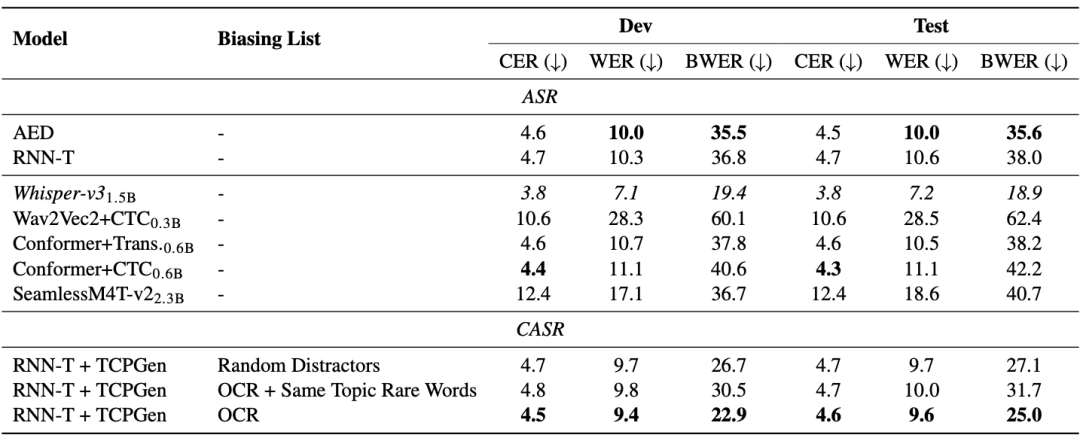

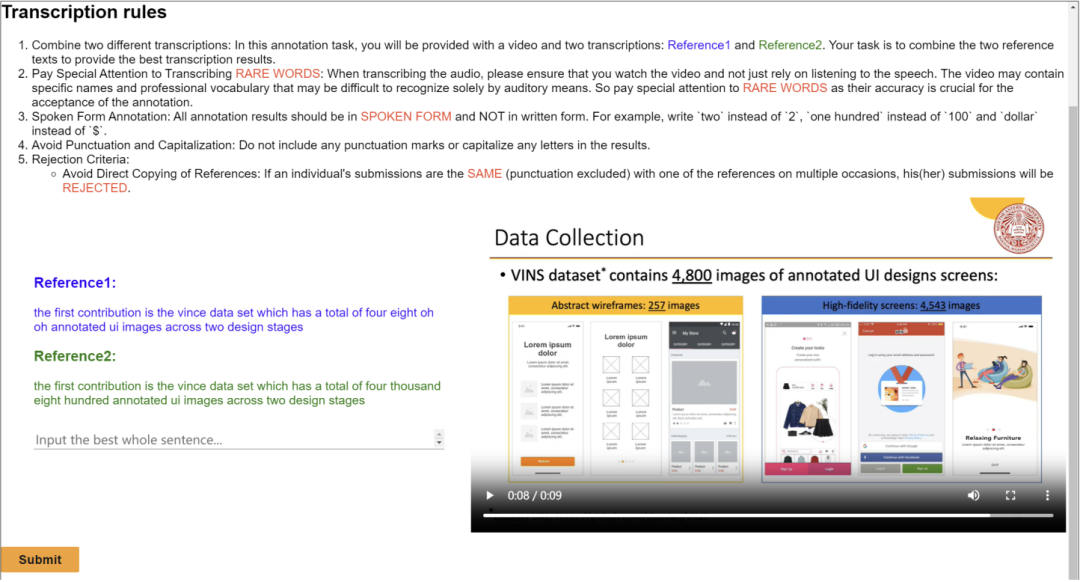

M3AV データセットは、マルチモーダルな知覚と理解における 3 つのタスク、すなわち、コンテキストベースの音声認識、自発的なスタイルの音声合成、およびスライドとスクリプトの生成で設計されています。 一般的なエンドツーエンド モデルには、まれな単語の認識に問題があります。以下の表の AED モデルと RNN-T モデルからわかるように、レアワード誤り率 (BWER) は総ワード誤り率 (WER) と比較して 2 倍以上増加しています。 TCPGen を使用したコンテキストベースの音声認識に OCR 情報を活用することにより、RNN-T モデルは、開発セットとテスト セットでそれぞれ BWER の 37.8% と 34.2% の相対的な削減を達成しました。

M3AV データセットは、マルチモーダルな知覚と理解における 3 つのタスク、すなわち、コンテキストベースの音声認識、自発的なスタイルの音声合成、およびスライドとスクリプトの生成で設計されています。 一般的なエンドツーエンド モデルには、まれな単語の認識に問題があります。以下の表の AED モデルと RNN-T モデルからわかるように、レアワード誤り率 (BWER) は総ワード誤り率 (WER) と比較して 2 倍以上増加しています。 TCPGen を使用したコンテキストベースの音声認識に OCR 情報を活用することにより、RNN-T モデルは、開発セットとテスト セットでそれぞれ BWER の 37.8% と 34.2% の相対的な削減を達成しました。

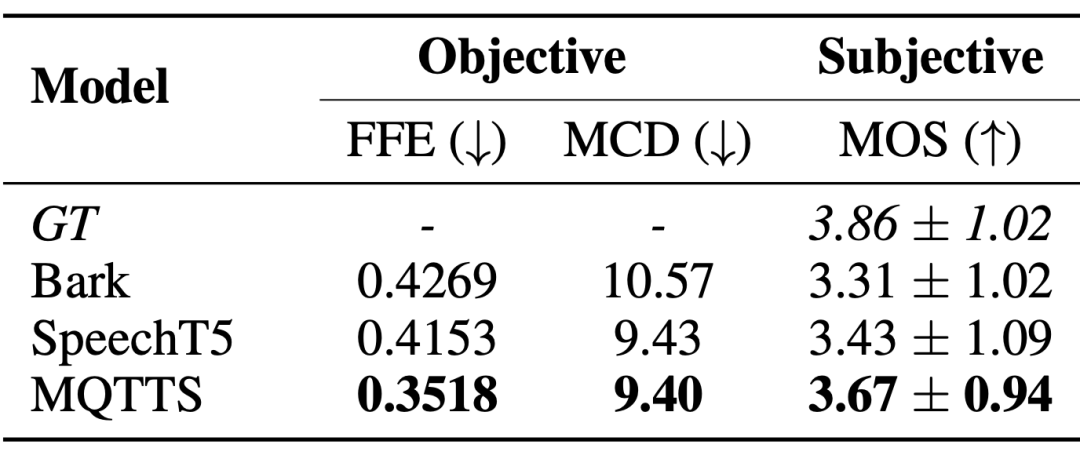

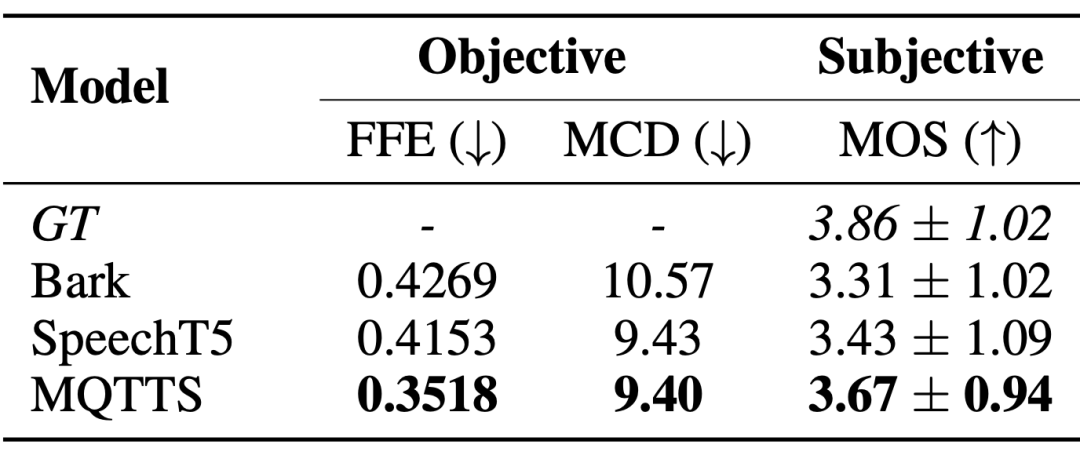

自発的スタイルの音声合成システムでは、自然な会話パターンに近い音声を生成するために、実際のシナリオでの音声データが緊急に必要です。論文の著者は、実験モデルとして MQTTS を導入し、さまざまな事前トレーニング済みモデルと比較して、MQTTS が最良の評価指標を備えていることを発見しました。これは、M3AV データセット内の実際の音声が AI システムを駆動して、より自然な音声をシミュレートできることを示しています。

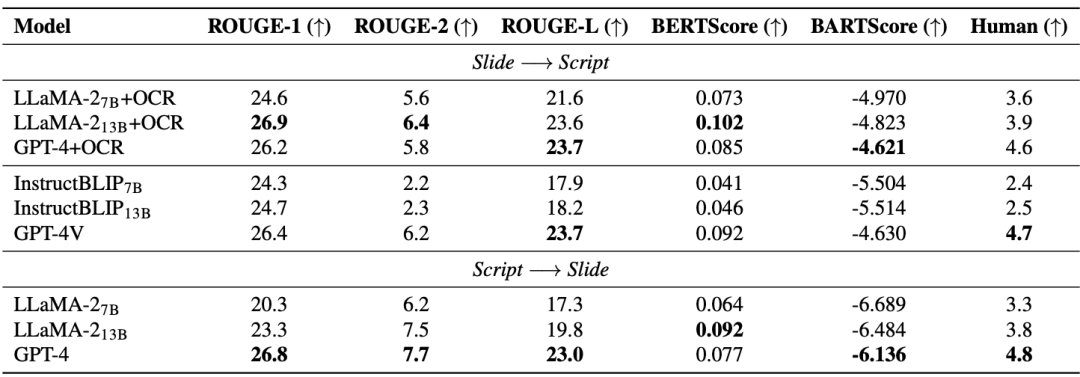

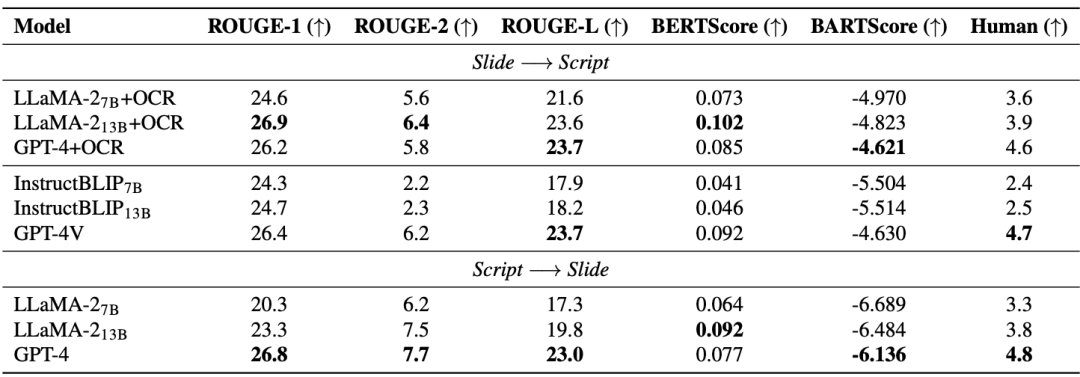

スライドとスクリプトの生成 (SSG) タスクは、AI モデルが高度な学術知識を理解し、再構築できるように設計されており、それによって研究者が更新を迅速に処理できるようになります。学術資料を反復して学術研究を効果的に実施します。 以下の表からわかるように、オープンソース モデル (LLaMA-2、InstructBLIP) のパフォーマンス向上は、7B から 13B に増加する場合に限定され、クローズド ソース モデル (GPT-4 および GPT-4V) に遅れをとっています。 )。したがって、モデルのサイズを増やすことに加えて、高品質のマルチモーダル事前トレーニング データも必要であると論文の著者は考えています。特に、高度なマルチモーダル大規模モデル (GPT-4V) は、複数のシングルモーダル モデルで構成されるカスケード モデルよりも優れたパフォーマンスを示しています。

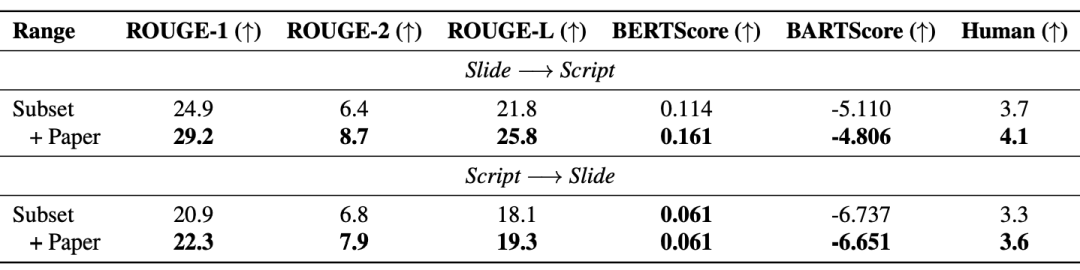

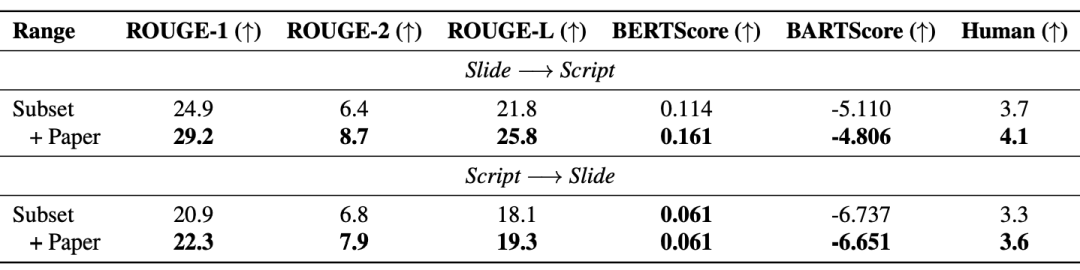

さらに、検索拡張生成 (RAG) により、モデルのパフォーマンスが効果的に向上します。以下の表は、導入された論文テキストによって、生成されたスライドとスクリプトの品質も向上することを示しています。

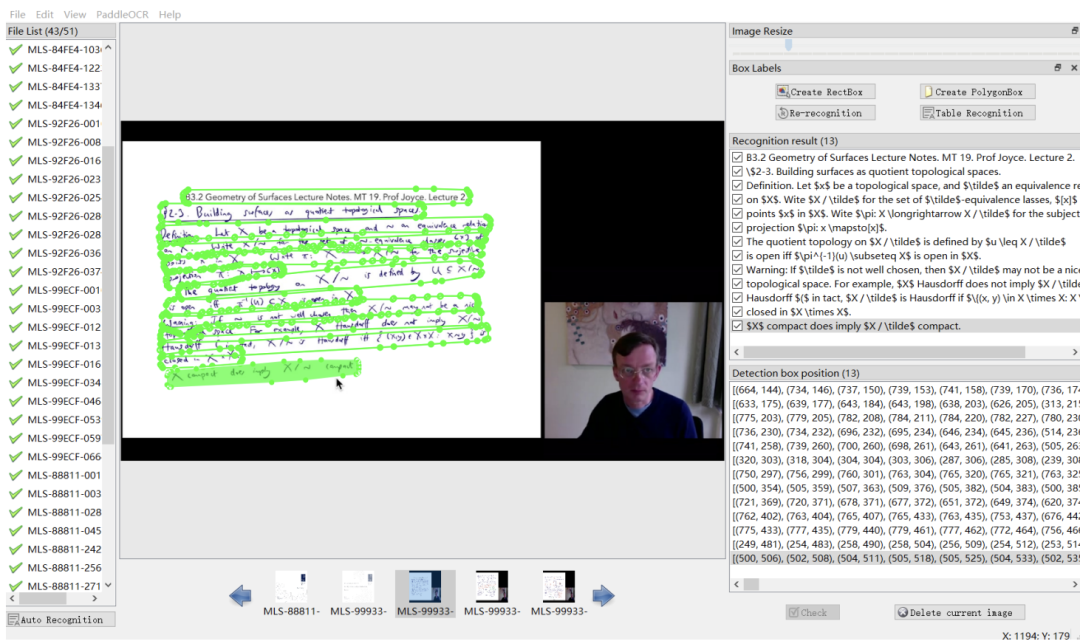

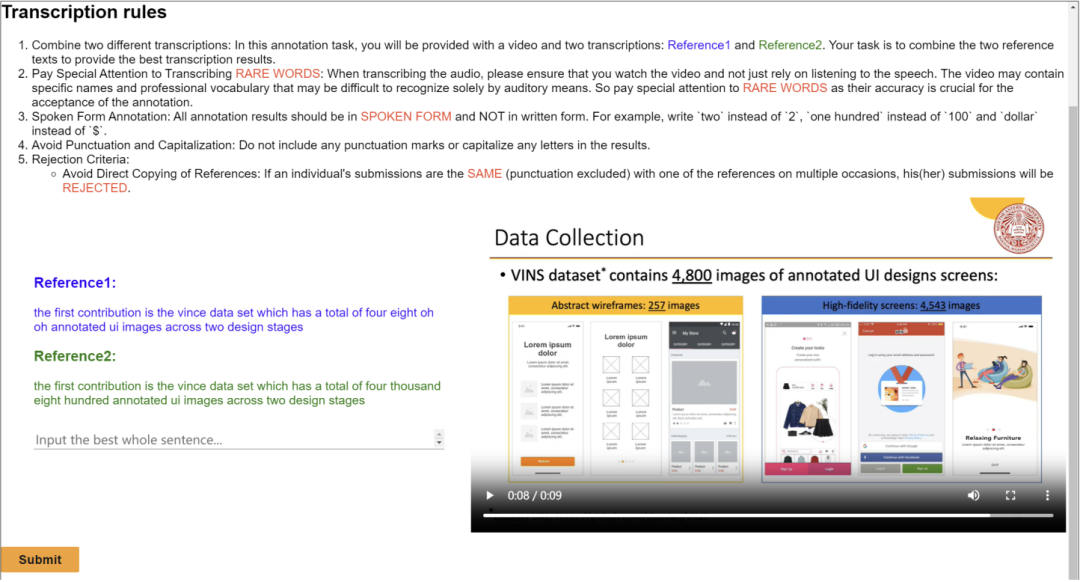

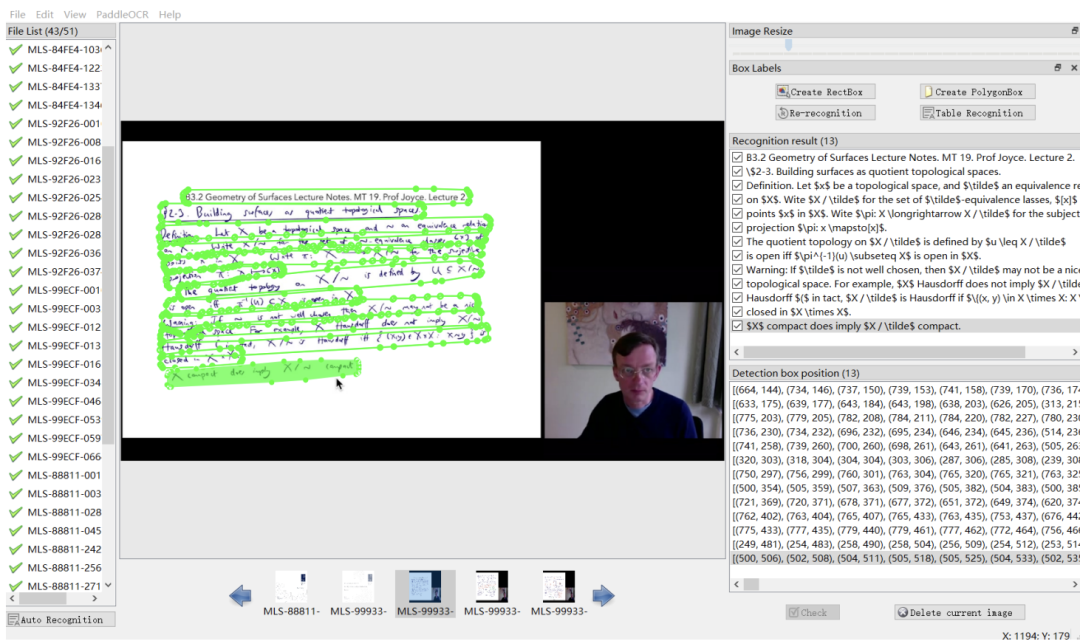

この作品は、複数の学術分野をカバーするマルチモーダル、マルチタイプ、多目的視聴覚データセット (M3AV) をリリースします。このデータセットには、人間が注釈を付けた音声文字起こし、スライド、追加の抽出エッセイ テキストが含まれており、マルチモーダル コンテンツを認識し、学術的知識を理解する AI モデルの能力を評価するための基礎を提供します。論文の著者は作成プロセスを詳細に説明し、データセットに対してさまざまな分析を行っています。さらに、ベンチマークを構築し、データセットに関して複数の実験を実施しました。最終的に、論文の著者らは、学術講義ビデオの認識と理解において、既存のモデルにはまだ改善の余地があることを発見しました。 部分的なアノテーションインターフェイス

以上がACL 2024 | 学術視聴覚研究をリードする上海交通大学、清華大学、ケンブリッジ大学、上海 AILAB が共同で学術視聴覚データセット M3AV をリリースの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。