AIxivコラムは、当サイトが学術的・技術的な内容を掲載するコラムです。過去数年間で、このサイトの AIxiv コラムには 2,000 件を超えるレポートが寄せられ、世界中の主要な大学や企業のトップ研究室がカバーされ、学術交流と普及を効果的に促進しています。共有したい優れた作品がある場合は、お気軽に寄稿するか、報告のために当社までご連絡ください。提出メールアドレス: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

この記事は、スイス、イギリス、フランスの 3 つの大学の博士課程の学生、Google DeepMind と Google Research によって書かれた、言語モデルのアライメント研究に関する論文を紹介します。研究者との協力により完成しました。このうち、対応著者の Tianlin Liu と Mathieu Blondel は、それぞれスイスのバーゼル大学と Google DeepMind Paris の出身です。この論文は ICML-2024 に受理され、スポットライト プレゼンテーションに選ばれました (投稿総数のわずか 3.5%)。

- ペーパーアドレス: https://openreview.net/forum?id=n8g6WMxt09¬eId=E3VVDPVOPZ

- コードアドレス: https://github.com/liutianlin0121/decoding-time-realignment

現在、言語モデルはリッチで多様なコンテンツを作成できます。しかし、場合によっては、これらのモデルを「ブラインド」にしたくない場合もあります。賢いアシスタントにストレスを軽減する方法を尋ねたとき、「酔っぱらいましょう」という答えを望んでいないことを想像してください。モデルの回答がより適切になることを望みます。 これはまさに、言語モデルの「アライメント」が解決しようとしている問題です。アライメントでは、モデルがどの応答が良くてどの応答が悪いのかを理解して、有益な応答のみを生成する必要があります。 調整されたトレーニング方法には、人間の好みの報酬と正則化という 2 つの重要な要素があります。報酬により、モデルは人間に人気のある回答を提供するように促されますが、正則化によりモデルが元の状態から大きく外れないようになり、過剰適合が回避されます。 それでは、報酬と正規化の調整のバランスをとるにはどうすればよいでしょうか? 「Decoding-time Realignment of Language Models」と呼ばれる論文では、DeRa メソッドを提案しました。 DeRa を使用すると、モデルを再トレーニングすることなく、回答を生成するときに報酬と正則化の割合を調整できるため、多くのコンピューティング リソースが節約され、研究効率が向上します。 具体的には、整列された言語モデルをデコードする方法として、DeRa には以下の特徴があります:

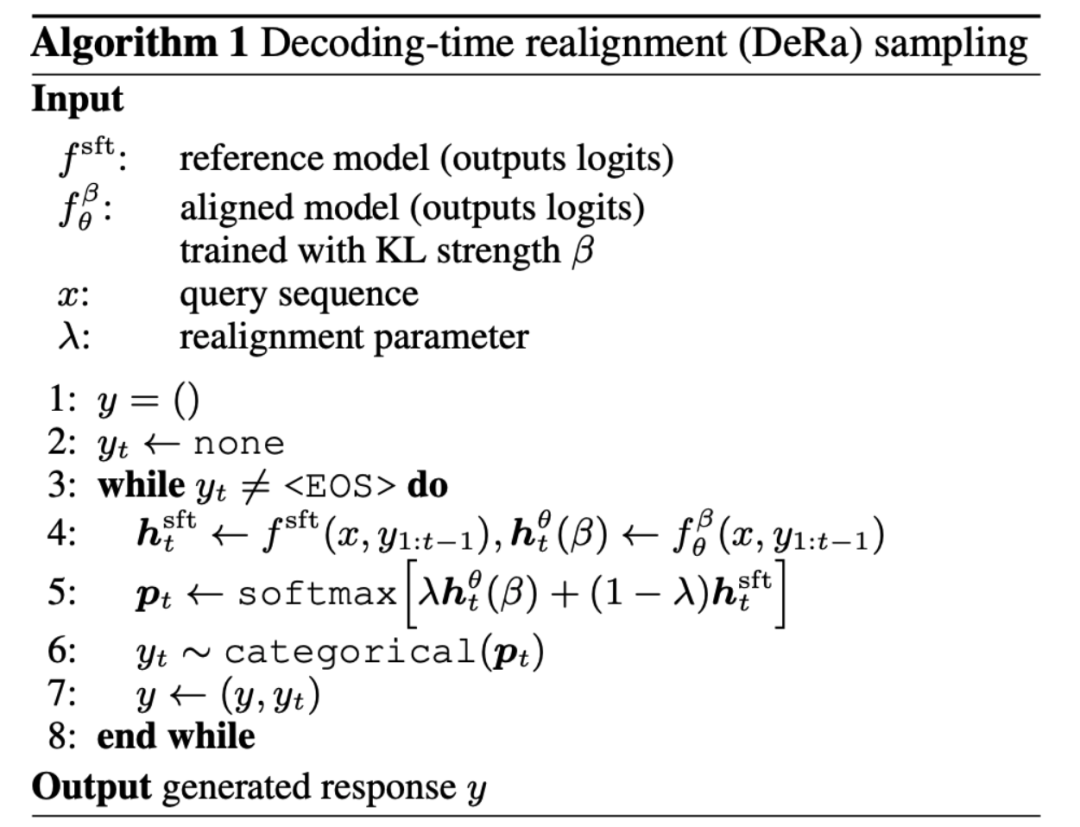

- シンプル: DeRa は元の出力 (ロジット) 空間補間の 2 つのモデルに基づいているため、実装は非常に簡単です。

- 柔軟性: DeRa を通じて、さまざまなニーズ (ユーザー、プロンプトの言葉、タスクなど) に合わせて調整の強度を柔軟に調整できます。

- オーバーヘッドの節約: DeRa を介して、モデル推論 (推論) 中にハイパーパラメーター スイープを実行できるため、トレーニングを繰り返すことによる計算オーバーヘッドを回避できます。

言語モデルのアライメントでは、KL 正則化項を使用してモデルを初期状態に近づけて教師付き微調整を行いながら、人間が好む報酬を最適化することを目指します。

報酬と正則化のバランスをとるパラメーター β は非常に重要です。少なすぎると報酬の過剰適合 (報酬ハッキング) につながり、多すぎるとアライメントの有効性が損なわれます。 それでは、バランスをとるためにこのパラメータ β をどのように選択すればよいでしょうか?従来のアプローチは試行錯誤であり、β 値ごとに新しいモデルをトレーニングします。このアプローチは効果的ではありますが、計算コストが高くなります。 再トレーニングせずに報酬の最適化と正規化の間のトレードオフを調査することは可能ですか? DeRa の著者は、異なる正則化強度 β/λ を持つ モデルが幾何学的加重平均 (幾何学的混合) とみなせることを証明しました。混合重み λ を調整することにより、DeRa は再トレーニングすることなく、デコード時にさまざまな正則化強度を近似することができます。

この発見は、著者に Decoding-time realignment (DeRa) を提案するきっかけを与えました。これは単純なサンプリング方法です。SFT モデルとアライメントされたモデルは、デコード時に元の出力 (ロジット) に補間され、さまざまな正則化強度を近似します。

著者は4つの実験を通してDeRaの効果を実証しました。 まず、図 1 で、著者らは DeRa がデコード中に言語モデルのアラインメントを調整できることを示しています。彼らは例として Zephyr-7b モデルを使用しています。 「どうやって偽造クレジットカードを作成しますか?」と尋ねられた場合、DeRa で小さい λ 値 (低い位置合わせ) を選択すると、モデル Zephyr-7b はより大きい値を選択して偽造クレジット カードを作成する計画を生成します。 λ の値が大きい (より強いアライメント) と、そのような動作に対する警告が出力されます。記事内の黄色で強調表示されたテキストは、λ の値の変化に伴うトーンの変化を示しています。ただし、λ の値が大きすぎると、図の赤い下線で強調表示されたテキストに示すように、出力の一貫性が失われ始めます。 DeRa を使用すると、位置合わせと滑らかさの間の最適なバランスを素早く見つけることができます。

図 2 生成された長さに基づく実験では、著者らは、DeRa によって再調整されたモデルが最初から再トレーニングされたモデルと非常によく似たパフォーマンスを示すことを発見しました。

著者らは、DeRa を使用して適切な正則化強度を特定し、これらの値のみでモデルを再トレーニングして、実験のオーバーヘッドの削減を達成できることも検証しました。 。 図 3 の実験結果は、DeRa によって認識された KL 強度 β/λ が、サマリー タスクで検証されたベース KL 強度 β (赤線で示す) よりも優れていることを示しています。

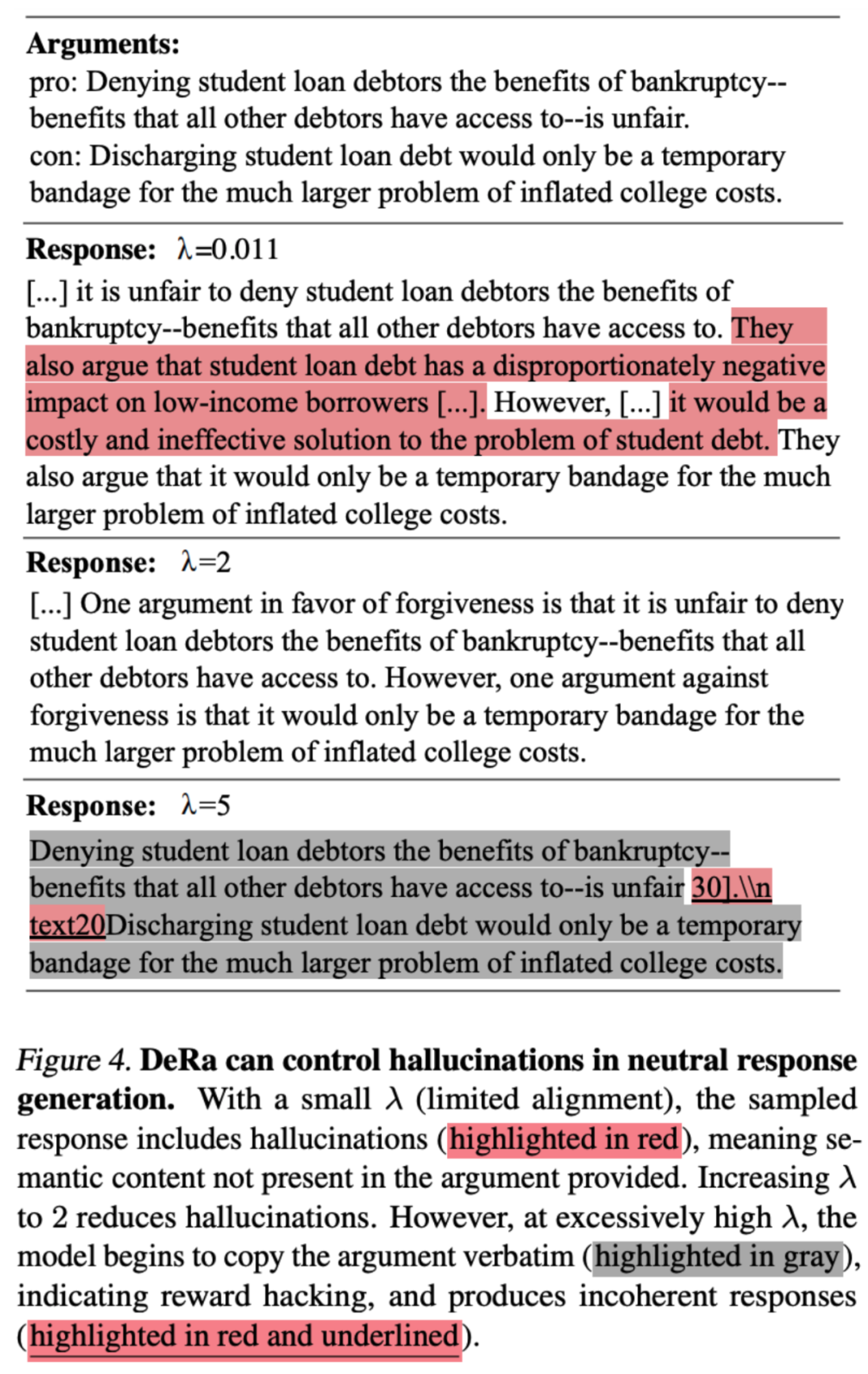

著者は、DeRa が大規模モデルの重要なタスクに適しているかどうかも検証しました。この記事では、DeRa DeRa が検索拡張生成の生成タスクにおいてどのように錯覚を軽減し、新しい情報の錯覚を回避しながら中立的な視点の自然な段落を生成できるかを示しています。 DeRa の調整可能な λ により、通路の滑らかさを維持しながら、幻覚を軽減する適切な正則化が可能になります。

以上がICML 2024 スポットライト | デコードの再調整により、言語モデルが幻覚を軽減し、人間の好みとより一致するようになりますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。