ホームページ >テクノロジー周辺機器 >AI >Google Gemini 1.5 テクニカル レポート: 数学オリンピックの問題を簡単に証明、Flash バージョンは GPT-4 Turbo より 5 倍高速

Google Gemini 1.5 テクニカル レポート: 数学オリンピックの問題を簡単に証明、Flash バージョンは GPT-4 Turbo より 5 倍高速

- PHPzオリジナル

- 2024-06-13 13:52:271161ブラウズ

今年 2 月、Google はマルチモーダル大型モデル Gemini1.5 を発表しました。これは、エンジニアリングとインフラストラクチャの最適化、MoE アーキテクチャ、その他の戦略を通じてパフォーマンスと速度を大幅に向上させました。より長いコンテキスト、より強力な推論機能、およびクロスモーダル コンテンツのより適切な処理が可能になります。

今週金曜日、Google DeepMind は Gemini 1.5 の技術レポートを正式にリリースしました。このレポートには、Flash バージョンとその他の最近のアップグレードが含まれています。このドキュメントは 153 ページあります。

技術レポートのリンク: https://storage.googleapis.com/deepmind-media/gemini/gemini_v1_5_report.pdf

このレポートでは、Google は Gemini 1.5 シリーズ モデルを紹介します。これは、計算効率の高い次世代のマルチモーダル大規模モデルを表しており、複数の長い文書や何時間ものビデオなど、何百万ものトークン コンテキストからきめ細かい情報を呼び出して推論することができます。 Gemini 1.5 シリーズ モデルは複数の言語と視覚的推論機能を備えており、自然言語処理とコンピューター ビジョンの分野で広く使用されています。このモデルは、テキストから重要な情報を抽出して推論を実行できるほか、複数の長い文書を包括的に分析することができます。さらに、大量のビジュアル データの処理をサポートし、数時間で大量のビジュアル データを処理できます

このシリーズには 2 つの新しいモデルが含まれています:

- ほとんどの機能とベンチマークを備えた更新された Gemini 1.5 Pro 2 月

- Gemini 1.5 Flash のバージョン。パフォーマンスの低下を最小限に抑え、効率性を重視して設計された、より軽量なバージョンです。

今週の Google I/O カンファレンスで言及された Flash バージョンに関して、レポートでは、Gemini 1.5 Flash は Gemini 1.5 Pro と同じ 2M+ コンテキストとマルチモーダル機能を備えた Transformer デコーダー モデルであると述べられています。テンソル プロセッシング ユニット (TPU) を効率的に利用し、モデル サービング レイテンシが低くなります。たとえば、Gemini 1.5 Flash は、アテンションとフィードフォワード コンポーネントを並行して計算でき、さらに大規模なネットワーク オンライン抽出機能を備えた Gemini 1.5 Pro モデルでもあります。品質を向上させるために、高次の前処理手法を使用してトレーニングされます。

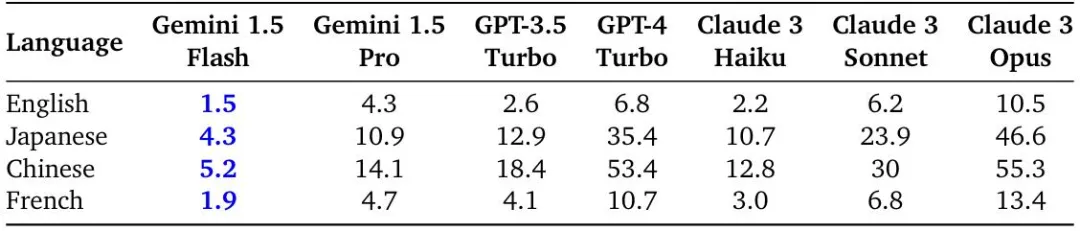

このレポートは、Gemini 1.5 と Vertex AI Streaming API から取得した英語、中国語、日本語、フランス語のクエリの出力文字あたりの平均時間を評価します。

英語、中国語、日本語、フランス語の応答の出力文字あたりの時間 (ms) は、10,000 文字の入力で、Gemini 1.5 Flash は、テストされたすべての言語の中で最速の世代を達成しました。

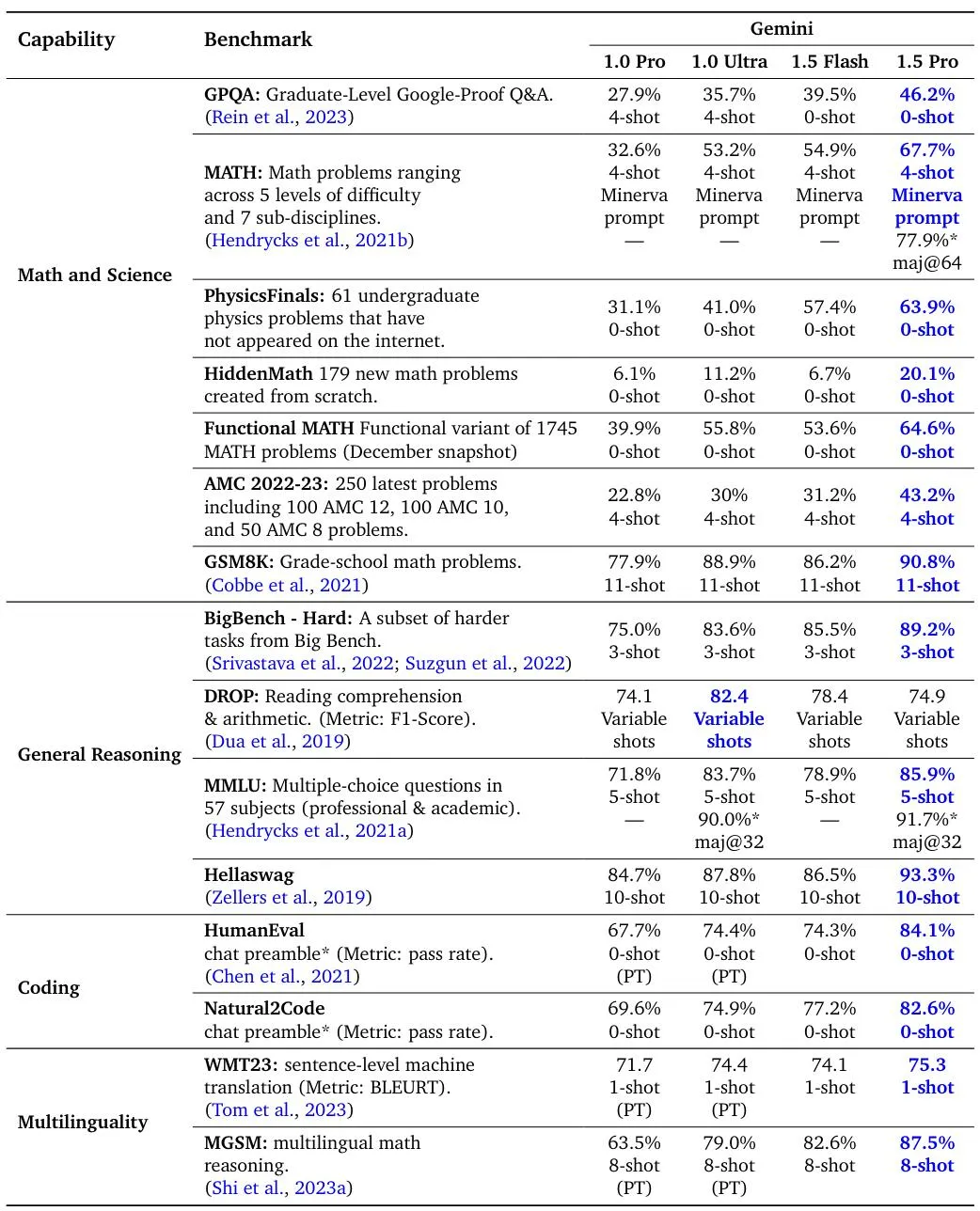

標準コーディング、多言語、数学、科学、推論ベンチマークにおける Gemini 1.5 Pro、1.5 Flash、および Gemini 1.0 モデルの評価結果。 1.5 Pro および 1.5 Flash のすべての数値は、コマンド調整後に取得されます。

ビデオ理解ベンチマークにおける Gemini 1.5 Pro と Gemini 1.0 Pro および Ultra の比較。

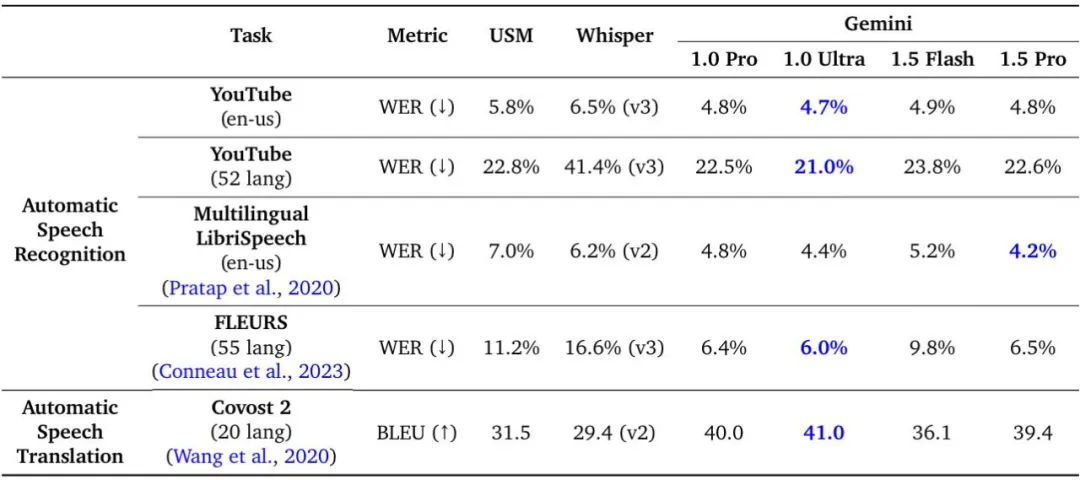

音声理解タスクにおける Gemini 1.5 Pro と USM、Whisper、Gemini 1.0 Pro、および Gemini 1.0 Ultra の比較。

Gemini 1.5 モデルは、クロスモーダルな長いコンテキストの取得タスクでほぼ完璧なリコールを達成し、長いドキュメントの QA、長いビデオの QA、および長いコンテキストの ASR の最適なレベルを向上させ、Gemini 1.0 Ultra が提供するものと同等またはそれを超えています。幅広いベンチマークにわたって最先端のパフォーマンスを実現します。さらにGoogleは、今年5月の時点でGemini 1.5のパフォーマンスが2月に比べて大幅に向上しているとも述べた。

複数のベンチマークにおける Gemini 1.5 Pro (5 月) と初期リリース (2 月) の比較。最新の Gemini 1.5 Pro では、オーディオと翻訳のパフォーマンスはそのままに、推論、エンコード、ビジョン、ビデオのベンチマークすべてにわたって改善が行われています。 FLEURS の場合、スコアが低いほど優れていることに注意してください。

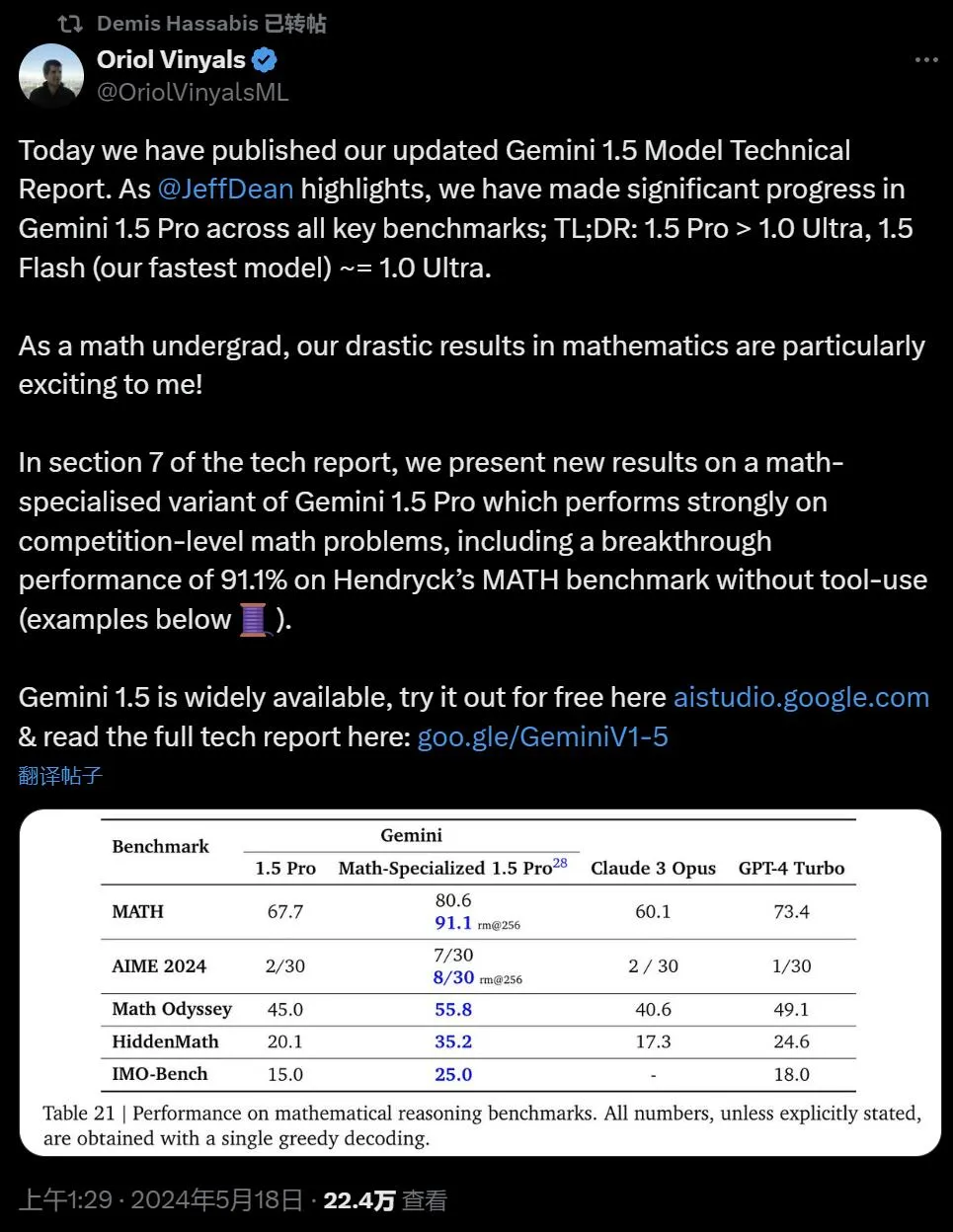

Google DeepMind の副社長で Gemini プロジェクトの共同リーダーである Oriol Vinyals は、Gemini 1.5 Pro > 1.0 Ultra、1.5 Flash (現時点で最速のモデル) ~= 1.0 Ultra であると結論付けました。

Gemini 1.5 のロングコンテキスト機能の限界を研究することで、次のトークンの予測とほぼ完璧な取得 (>99%) が継続的に改善されていることがわかります。 Claude 3.0 (200k) や GPT-4 Turbo (128k) などの既存のモデルを世代が飛び越えます。

レポートの第 7 章では、Google は Gemini 1.5 Pro の数学強化バージョンのベンチマークを紹介しています。このベンチマークは、ツールを使用せずに Hendryck の MATH ベンチマークなど、競技レベルの数学の問題で優れたパフォーマンスを達成しました。 91.1%。

以下は、以前のモデルでは明らかに解決できなかったアジア太平洋数学オリンピック (APMO) の問題を解決するモデルの例です。 Oriol Vinyals 氏は、この答えは (計算ではなく) 証明であり、要点を絞った解決策であり、「美しい」ため、素晴らしいと述べています。

最後に、Google は、Gemini 1.5 などの大規模モデルの実世界のユースケースを強調しています。Gemini 1.5 は、専門家と協力してタスクを完了し、目標を達成し、10 の異なる職種にわたって 26 ~ 75% の時間を節約します。

この最先端の大規模言語モデルは、いくつかの驚くべき新機能も示しています。パプアニューギニア西部で200人未満が話す言語であるカラマン語の文法書を与えると、モデルは人間が同じ内容から学習するのと同じレベルで英語をカラマン語に翻訳することを学習できた。

以上がGoogle Gemini 1.5 テクニカル レポート: 数学オリンピックの問題を簡単に証明、Flash バージョンは GPT-4 Turbo より 5 倍高速の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。