史上最简单的数据抽取 做为一名全职DBA,在之前的工作中,常会收到这样的需求,需要我配合开发定时的从几张目标表取出他们需要的数据,并存放到临时表中,开发们再从临时表中取出数据展现给前端页面。 收到这样的需求,我觉得应该考虑以下几点: (1)目标表有

史上最简单的数据抽取

做为一名全职DBA,在之前的工作中,常会收到这样的需求,需要我配合开发定时的从几张目标表取出他们需要的数据,并存放到临时表中,开发们再从临时表中取出数据展现给前端页面。

收到这样的需求,我觉得应该考虑以下几点:

(1)目标表有哪几张,它们的关联关系如何,这决定了我如何取数据

(2)定时抽取,意味着要周期性的提取数据,此抽取周期是多少?每次抽取数据的频率是多久?

(3)周期性的抽取数据,那么临时表的命名要有规则,通过就是"临时表名_日期时间",这样命名方便开发前端取数

(4)周期性的抽取数据,那么临时表的保留及清理也要考虑一下,防止表空间使用率过高

(5)如果每一次抽取数据消耗的时间比较长,那么要有1个监控的手段,方便查看本次抽取数据的进度

(6)数据抽取的过程中,如果本次抽取数据时发现有问题,那么你抽数的存储过程要可以复用。

也就是说,当前你第2次执行抽数的存储过程时,本次操作之前抽取出的脏数据要清空掉。

那么什么是数据抽取?

最简单的解释就是,从原始数据中抽取出感兴趣数据的过程。

针对上面我总结出的6点,咱们开始模拟一套最简单的数据抽取案例。

(一)、表结构及字段说明

(二)、模拟业务需求

(1)、从emp和dept表中抽取出:emp.empno、emp.ename、emp.job、emp.deptno、dept.dname、dept.loc、sysdate字段,构造产生临时表:T_EMP_DEPT (2)、emp和dept表的关联关系:emp表的deptno字段 参照引用 dept表的deptno字段 (3)、开发人员每天13点会查询使用当天产生的临时表 (4)、每次产生的临时表,保留周期是30天,超过30天的临时表可以被清理掉

(三)、给出解决方案

(1)、从emp和dept表关联查询出需要的字段,关联字段是deptno,并创建临时表:T_EMP_DEPT (2)、每天抽取一次,我们在每天13点之前把临时表创建好就可以了 (3)、临时表的命名规则:T_EMP_DEPT_yyyymmdd(取当前系统的年月日) (4)、抽取数据的存储过程中,加入逻辑判断,取当前系统时间,并将30天前的临时表清除(先truncate,再drop) (5)、单独写1个存储过程及表,用来保存每次抽取数据的进度情况,方便我们监控抽取数据的进度 (6)、在抽取数据的存储过程中,每次都要先truncate临时表、drop临时表,然后再进行本次的数据抽取。实现数据抽取的复用

既然全想清楚了,那么我们就开始操练起来吧

1、创建日志表(存储抽取进度)

2、创建监控进度的存储过程

3、创建抽取数据的存储过程

CREATE OR REPLACE PROCEDURE prc_emp_dept authid current_user is

table_name_1 varchar2(100); --临时表名

table_flag number; --标识临时表是否存在 0:不存在 1:存在

create_sql varchar2(5000);--创建临时表的SQL语句

insert_sql varchar2(5000);--Insert操作SQL语句

date_30 varchar2(20); --数据过期的时间 30天以前

date_cur varchar2(20); --当前日期

log_detail varchar2(4000); --日志明细参数

begin

date_cur := to_char(sysdate, 'yyyymmdd'); --当前日期

date_30 := to_char(sysdate - 30, 'yyyymmdd'); --30天以前的日期

table_flag := 0; --初始状态0,目标不存在

table_name_1 := 'T_EMP_DEPT'||date_cur;

---如果临时表存在先清空、再干掉(实现功能复用)

execute immediate 'select count(*) from user_tables

where table_name='''||table_name_1|| '''' into table_flag;

if table_flag = 1 then

execute immediate 'truncate table '||table_name_1;

execute immediate 'drop table '||table_name_1;

--日志明细信息

log_detail := '删除临时表的时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','00',log_detail);

end if;

---创建中间表T_EMP_DEPTyyyymmdd

create_sql :='create table '|| table_name_1 || ' nologging as

select

e.EMPNO ,

e.ENAME ,

e.JOB ,

e.MGR ,

e.HIREDATE,

e.SAL ,

e.COMM ,

e.DEPTNO ,

d.DNAME ,

d.LOC ,

sysdate as current_time

from emp e,dept d where e.deptno=d.deptno';

execute immediate create_sql;

--日志明细信息

log_detail := '中间表创建完毕时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','01',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第1次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','02',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第2次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','03',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第3次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','04',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第4次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','05',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第5次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','06',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第6次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','07',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第7次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','08',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第8次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','09',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第9次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','10',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第10次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','11',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第11次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','12',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第12次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','13',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第13次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','14',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第14次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','15',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第15次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','16',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第16次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','17',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第17次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','18',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第18次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','19',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第19次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','20',log_detail);

insert_sql :='insert into '|| table_name_1 ||' select * from '|| table_name_1;

execute immediate insert_sql;

commit;

--日志明细信息

log_detail := '第20次往中间表插入数据完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','21',log_detail);

P_INSERT_LOG(sysdate,'prc_emp_dept','22','抽取数据部分结束了!');

---删除30天以前的临时表

execute immediate 'select count(*) from user_TABLES

where table_name=''T_EMP_DEPT'||date_30 || '''' into table_flag;

if table_flag = 1 then --找到了30天前的表

execute immediate ' truncate table T_EMP_DEPT' ||date_30;

execute immediate ' drop table T_EMP_DEPT' ||date_30;

log_detail := '删除30天前临时表完成时间:' ||to_char(sysdate, 'yyyy-mm-dd hh24:mi:ss');

P_INSERT_LOG(sysdate,'prc_emp_dept','23',log_detail);

end if;

end prc_emp_dept;

/4、使用sys用户显示授权给scott,防止dbms_job调用存储过程时报没有权限

5、查看监控日志表(新表什么也没有)

6、手工执行抽取数据的存储过程

7、查看监控日志表(记录得比较详细)

朋友们,咱们的数据抽取功能、监控抽取进度、业务的需求咱们基本就全完成了。

现在还差1项就是把抽取数据的存储过程设置成定时任务,然后周期性的执行。

常用的定时任务有2种:

a.crontab (操作系统层面的)

b.dbms_job (oracle自带的)

将咱们的数据抽取存储过程加入到定时任务,让它自己周期性的执行就可以了。

8、我使用的是dbms_job,详细如下图

好了,朋友们至此,本套史上最简单的数据自动抽取文章就结束了!

此篇文章中涵盖了以下知识点:

1、SQL多表联合查询

2、关于业务的分析及思考

3、数据的自动抽取

4、数据抽取的进度监控

5、定时任务

6、表的管理

结束语:

相信大家已经发现了,本次文章中使用到的操作用户是scott,咱们oracle中基础练习的用户。

本篇文章是我上课的一个小案例,我的学生们反应不错,他们说接受起来比较容易。

所以我就把这个小案例移植到了51的博客上,分享给更多需要的朋友们!

其实每个人都有拖延症,都会害怕去尝试新鲜事物,所以我想说本篇文章:

送给想做数据抽取的朋友们、

送给对数据处理感兴趣的朋友们、

送给想学习oracle开发方向的朋友们、

送给想和做不同步的朋友们、

送给想学习的朋友们

附:本篇文章中的代码,全部手工测试过没有问题。如果朋友们在操作过程中发现报错,请好好检查一下代码。

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM

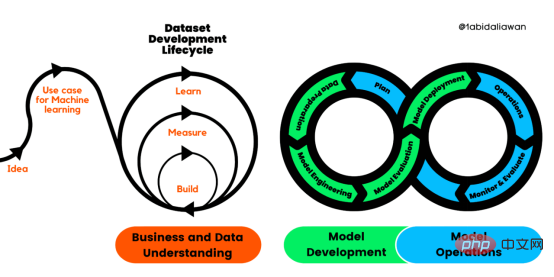

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM译者 | 布加迪审校 | 孙淑娟目前,没有用于构建和管理机器学习(ML)应用程序的标准实践。机器学习项目组织得不好,缺乏可重复性,而且从长远来看容易彻底失败。因此,我们需要一套流程来帮助自己在整个机器学习生命周期中保持质量、可持续性、稳健性和成本管理。图1. 机器学习开发生命周期流程使用质量保证方法开发机器学习应用程序的跨行业标准流程(CRISP-ML(Q))是CRISP-DM的升级版,以确保机器学习产品的质量。CRISP-ML(Q)有六个单独的阶段:1. 业务和数据理解2. 数据准备3. 模型

人工智能的环境成本和承诺Apr 08, 2023 pm 04:31 PM

人工智能的环境成本和承诺Apr 08, 2023 pm 04:31 PM人工智能(AI)在流行文化和政治分析中经常以两种极端的形式出现。它要么代表着人类智慧与科技实力相结合的未来主义乌托邦的关键,要么是迈向反乌托邦式机器崛起的第一步。学者、企业家、甚至活动家在应用人工智能应对气候变化时都采用了同样的二元思维。科技行业对人工智能在创建一个新的技术乌托邦中所扮演的角色的单一关注,掩盖了人工智能可能加剧环境退化的方式,通常是直接伤害边缘人群的方式。为了在应对气候变化的过程中充分利用人工智能技术,同时承认其大量消耗能源,引领人工智能潮流的科技公司需要探索人工智能对环境影响的

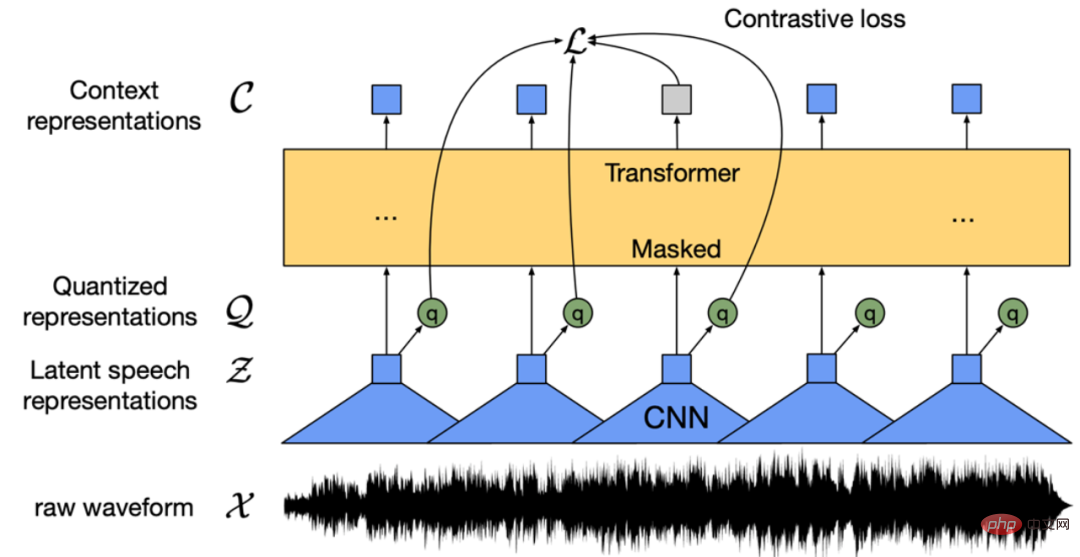

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PM

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PMWav2vec 2.0 [1],HuBERT [2] 和 WavLM [3] 等语音预训练模型,通过在多达上万小时的无标注语音数据(如 Libri-light )上的自监督学习,显著提升了自动语音识别(Automatic Speech Recognition, ASR),语音合成(Text-to-speech, TTS)和语音转换(Voice Conversation,VC)等语音下游任务的性能。然而这些模型都没有公开的中文版本,不便于应用在中文语音研究场景。 WenetSpeech [4] 是

条形统计图用什么呈现数据Jan 20, 2021 pm 03:31 PM

条形统计图用什么呈现数据Jan 20, 2021 pm 03:31 PM条形统计图用“直条”呈现数据。条形统计图是用一个单位长度表示一定的数量,根据数量的多少画成长短不同的直条,然后把这些直条按一定的顺序排列起来;从条形统计图中很容易看出各种数量的多少。条形统计图分为:单式条形统计图和复式条形统计图,前者只表示1个项目的数据,后者可以同时表示多个项目的数据。

自动驾驶车道线检测分类的虚拟-真实域适应方法Apr 08, 2023 pm 02:31 PM

自动驾驶车道线检测分类的虚拟-真实域适应方法Apr 08, 2023 pm 02:31 PMarXiv论文“Sim-to-Real Domain Adaptation for Lane Detection and Classification in Autonomous Driving“,2022年5月,加拿大滑铁卢大学的工作。虽然自主驾驶的监督检测和分类框架需要大型标注数据集,但光照真实模拟环境生成的合成数据推动的无监督域适应(UDA,Unsupervised Domain Adaptation)方法则是低成本、耗时更少的解决方案。本文提出对抗性鉴别和生成(adversarial d

数据通信中的信道传输速率单位是bps,它表示什么Jan 18, 2021 pm 02:58 PM

数据通信中的信道传输速率单位是bps,它表示什么Jan 18, 2021 pm 02:58 PM数据通信中的信道传输速率单位是bps,它表示“位/秒”或“比特/秒”,即数据传输速率在数值上等于每秒钟传输构成数据代码的二进制比特数,也称“比特率”。比特率表示单位时间内传送比特的数目,用于衡量数字信息的传送速度;根据每帧图像存储时所占的比特数和传输比特率,可以计算数字图像信息传输的速度。

数据分析方法有哪几种Dec 15, 2020 am 09:48 AM

数据分析方法有哪几种Dec 15, 2020 am 09:48 AM数据分析方法有4种,分别是:1、趋势分析,趋势分析一般用于核心指标的长期跟踪;2、象限分析,可依据数据的不同,将各个比较主体划分到四个象限中;3、对比分析,分为横向对比和纵向对比;4、交叉分析,主要作用就是从多个维度细分数据。

聊一聊Python 实现数据的序列化操作Apr 12, 2023 am 09:31 AM

聊一聊Python 实现数据的序列化操作Apr 12, 2023 am 09:31 AM在日常开发中,对数据进行序列化和反序列化是常见的数据操作,Python提供了两个模块方便开发者实现数据的序列化操作,即 json 模块和 pickle 模块。这两个模块主要区别如下:json 是一个文本序列化格式,而 pickle 是一个二进制序列化格式;json 是我们可以直观阅读的,而 pickle 不可以;json 是可互操作的,在 Python 系统之外广泛使用,而 pickle 则是 Python 专用的;默认情况下,json 只能表示 Python 内置类型的子集,不能表示自定义的

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

メモ帳++7.3.1

使いやすく無料のコードエディター

SecLists

SecLists は、セキュリティ テスターの究極の相棒です。これは、セキュリティ評価中に頻繁に使用されるさまざまな種類のリストを 1 か所にまとめたものです。 SecLists は、セキュリティ テスターが必要とする可能性のあるすべてのリストを便利に提供することで、セキュリティ テストをより効率的かつ生産的にするのに役立ちます。リストの種類には、ユーザー名、パスワード、URL、ファジング ペイロード、機密データ パターン、Web シェルなどが含まれます。テスターはこのリポジトリを新しいテスト マシンにプルするだけで、必要なあらゆる種類のリストにアクセスできるようになります。

ZendStudio 13.5.1 Mac

強力な PHP 統合開発環境

EditPlus 中国語クラック版

サイズが小さく、構文の強調表示、コード プロンプト機能はサポートされていません