Maison >Périphériques technologiques >Industrie informatique >Alibaba Cloud a annoncé le lancement de son modèle EMO auto-développé sur l'application Tongyi, qui utilise des photos et de l'audio pour générer des vidéos de chant.

Alibaba Cloud a annoncé le lancement de son modèle EMO auto-développé sur l'application Tongyi, qui utilise des photos et de l'audio pour générer des vidéos de chant.

- 王林avant

- 2024-04-26 08:00:381097parcourir

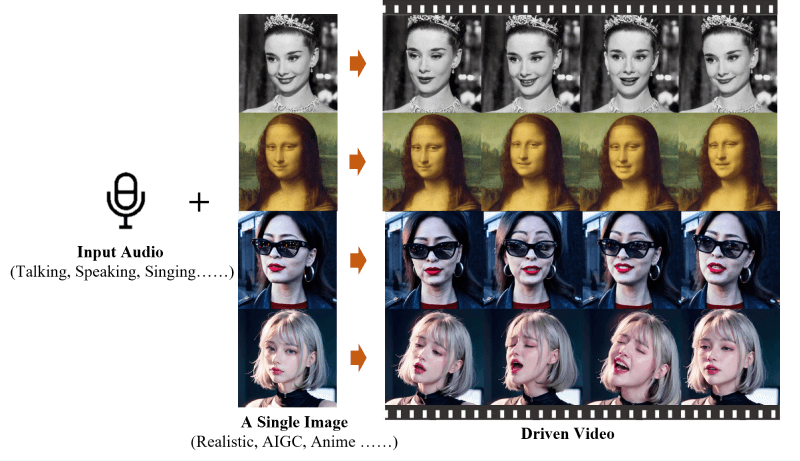

"Nouvelles de ce site le 25 avril, EMO (Emote Portrait Alive) est un cadre développé par l'Alibaba Group Intelligent Computing Research Institute, un système de génération de vidéo de portrait IA piloté par audio qui peut saisir une seule image de référence et un son vocal, générer des vidéos avec des expressions faciales expressives et diverses postures de tête. »

Alibaba Cloud a annoncé aujourd'hui qu'EMO, un modèle d'IA développé par le laboratoire, est officiellement lancé sur l'application générale et est ouvert gratuitement à tous les utilisateurs. Avec cette fonction, les utilisateurs peuvent choisir un modèle parmi des chansons, des mèmes chauds et des émoticônes, puis télécharger une photo de portrait pour permettre à EMO de synthétiser une vidéo chantée.

Selon l'introduction, l'application Tongyi a lancé plus de 80 modèles EMO dans le premier lot, y compris les chansons populaires "Shangchunshan", "Wild Wolf Disco", etc., ainsi que les mèmes chauds d'Internet. "Bobo Chicken" et "Backhand", "Draw", etc., mais l'audio personnalisé n'est pas disponible actuellement.

Ce site est rattaché au site officiel de l'EMO :

Page d'accueil officielle du projet : https://humanaigc.github.io/emote-portrait-alive/

Article de recherche arXiv : https:/ /arxiv.org/abs/2402.17485

GitHub:https://github.com/HumanAIGC/EMO(Modèle et code source open source)

Principales fonctionnalités de EMO

Générer des vidéos avec EMO Audio : EMO est capable de générer des vidéos directement à partir de l'audio d'entrée, comme des dialogues ou des chansons, sans s'appuyer sur des clips vidéo préenregistrés ou des modèles faciaux 3D.

Très expressives et réalistes : les vidéos générées par EMO sont très expressives, capables de capturer et de reproduire les nuances des expressions faciales humaines, y compris des micro-expressions subtiles et des mouvements de tête qui correspondent au rythme de l'audio.

Transition d'image transparente : EMO garantit que la transition entre les images vidéo est naturelle et fluide, évitant les problèmes de distorsion faciale ou de gigue inter-image, améliorant ainsi la qualité globale de la vidéo.

Préservation de l'identité : grâce au module FrameEncoding, EMO est capable de maintenir la cohérence de l'identité du personnage pendant le processus de génération vidéo, garantissant que l'apparence du personnage est cohérente avec l'image de référence d'entrée.

Mécanisme de contrôle stable : EMO adopte des mécanismes de contrôle stables tels que le contrôleur de vitesse et le contrôleur de zone faciale pour améliorer la stabilité pendant la génération vidéo et éviter des problèmes tels que les crashs vidéo.

Durée vidéo flexible : EMO peut générer des vidéos de n'importe quelle longueur en fonction de la longueur de l'audio d'entrée, offrant aux utilisateurs un espace créatif flexible.

Cross-langue et cross-style : l'ensemble de données de formation d'EMO couvre une variété de langues et de styles, y compris le chinois et l'anglais, ainsi que les styles réalisme, anime et 3D, ce qui permet à EMO de s'adapter à différentes cultures et styles artistiques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment vérifier l'adresse de l'entrepôt distant dans Git

- Comment convertir des branches dans git

- [Compilation et partage] Les 15 meilleurs projets open source front-end d'Alibaba, voyez lesquels vous avez utilisés !

- Le projet du parc du siège social d'Alibaba à Pékin avance sans problème : il devrait être achevé en octobre et livré d'ici fin décembre.