Maison >Périphériques technologiques >IA >Six façons rapides de découvrir le nouveau Llama 3 !

Six façons rapides de découvrir le nouveau Llama 3 !

- 王林avant

- 2024-04-19 12:16:01863parcourir

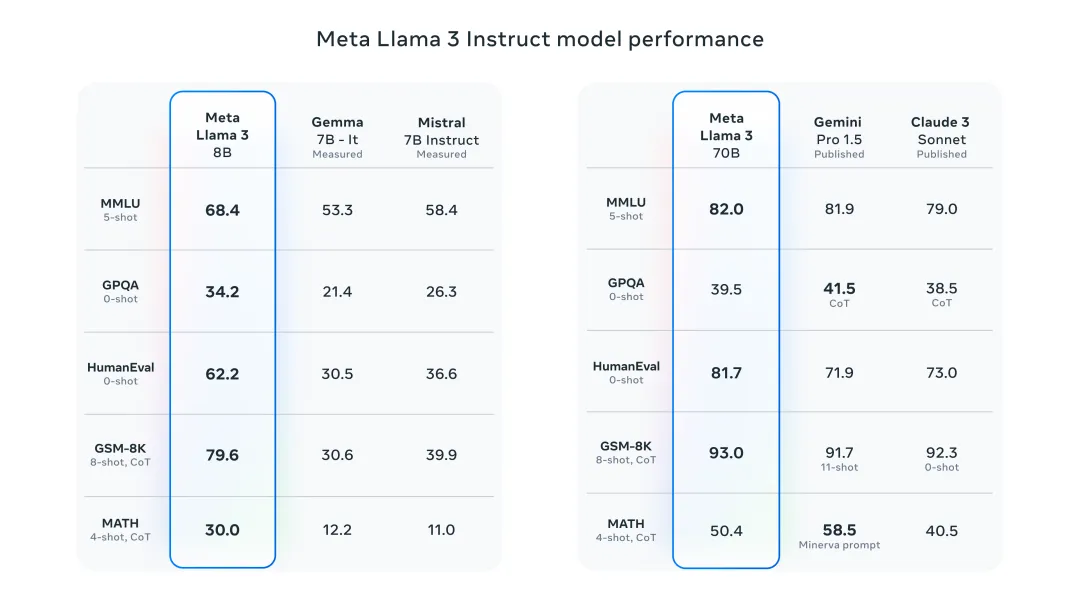

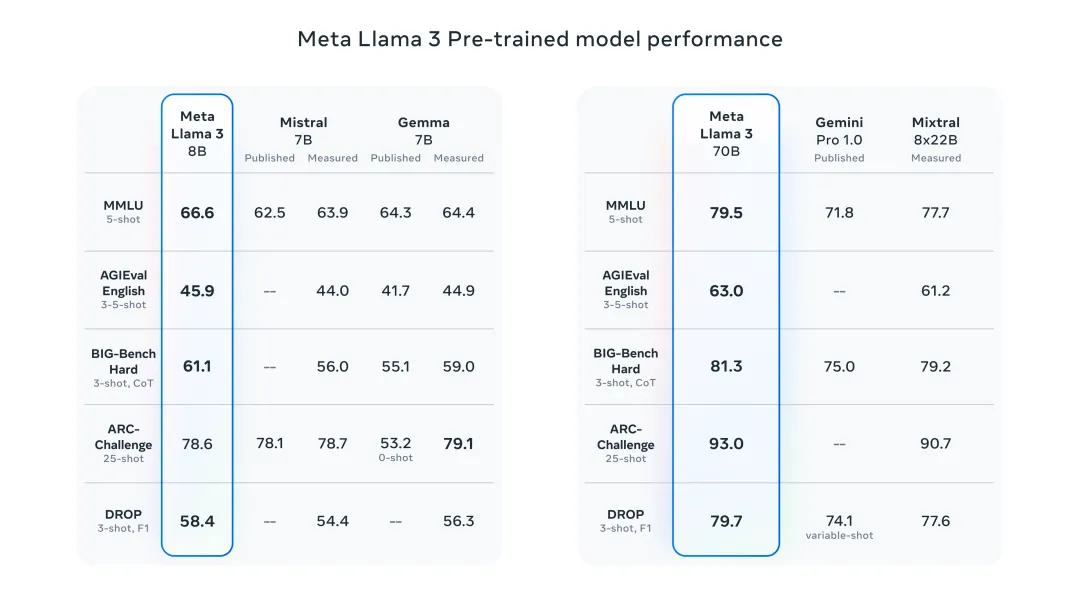

La nuit dernière, Meta a publié les modèles Llama 3 8B et 70B. Les modèles réglés par commande Llama 3 sont affinés et optimisés pour les cas d'utilisation de conversation/chat, surpassant de nombreux modèles de chat open source existants dans les benchmarks courants. Par exemple, Gemma 7B et Mistral 7B.

Le modèle Llama+3 a amélioré les données et l'échelle, atteignant de nouveaux sommets. Il a été formé sur plus de 15 000 jetons de données sur deux clusters GPU 24 000 personnalisés récemment publiés par Meta. Cet ensemble de données de formation est 7 fois plus grand que Llama 2 et contient 4 fois plus de code. Cela porte les capacités du modèle Llama au plus haut niveau actuel, prenant en charge des longueurs de texte supérieures à 8 Ko, soit deux fois celle de Llama 2.

Ci-dessous, je vais vous présenter 6 façons de découvrir rapidement le nouveau Llama 3 !

Découvrez Llama 3 en ligne

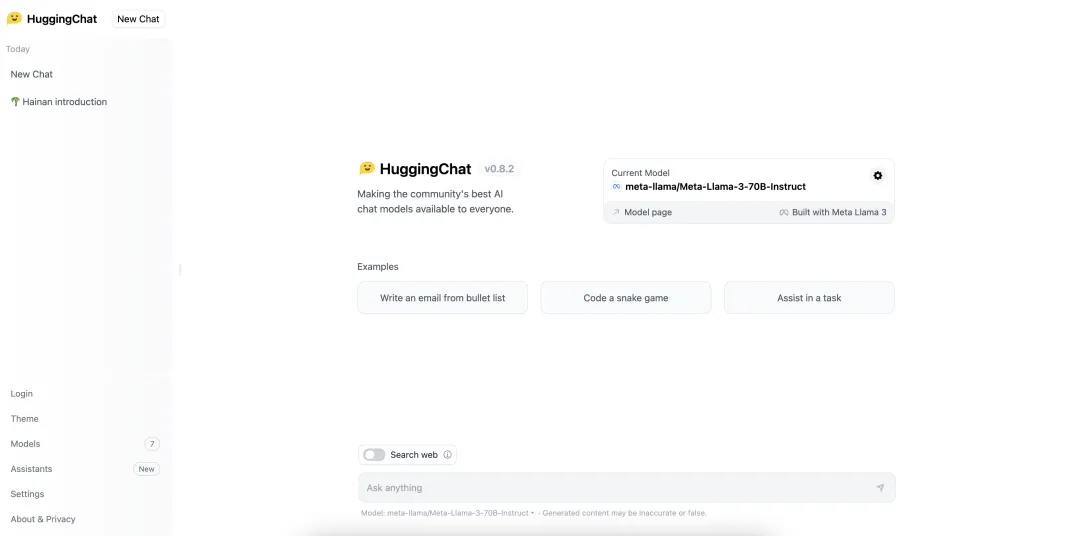

HuggingChat

llama2.ai

https: //www.llama2.ai/

Découvrez Llama 3 localement

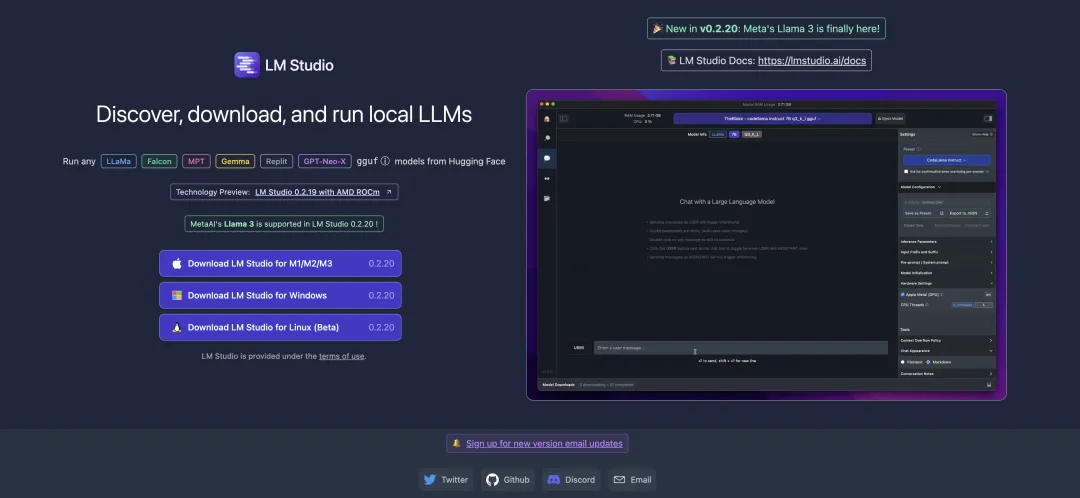

LM Studio

https://lmstudio.ai/

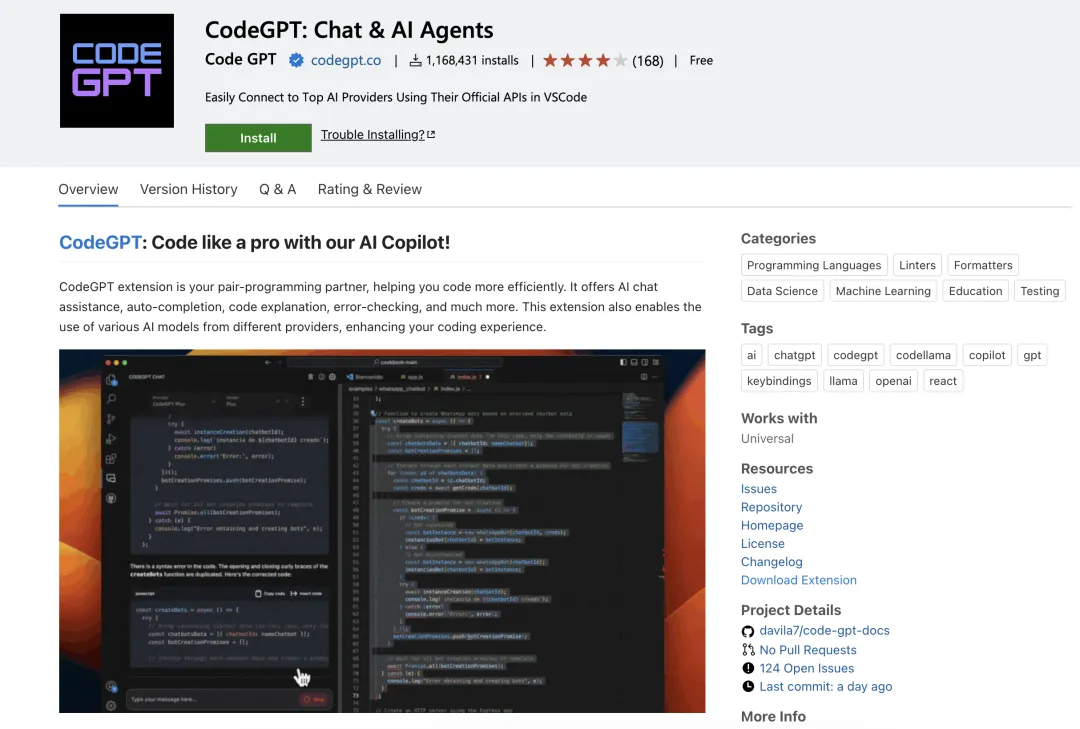

CodeGPT

https ://marketplace.visualstudio.com/items?itemName=DanielSanMedium.dscodegpt&ssr=false

Avant d'utiliser CodeGPT, n'oubliez pas d'utiliser Ollama pour extraire le modèle correspondant. Par exemple, pour extraire le modèle llama3:8b : ollama pull llama3:8b. Si vous n'avez pas installé ollama localement, vous pouvez lire "Déployer un grand modèle de langage local en quelques minutes seulement !"

Ollama

Exécuter le modèle Llama 3 8B :

ollama run llama3

Exécuter le modèle Llama 3 70B :

ollama run llama3:70b

Ouvrir WebUI et Ollama

https://pinokio.computer/item ?uri=https://github.com/cocktailpeanutlabs/open-webui.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!