Maison >Périphériques technologiques >IA >Après 11 jours d'open source, Musk publie à nouveau Grok-1.5, le code 128K bat GPT-4 !

Après 11 jours d'open source, Musk publie à nouveau Grok-1.5, le code 128K bat GPT-4 !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-03-30 08:01:25932parcourir

Grok-1 a été officiellement annoncé comme open source depuis seulement un demi-mois, et le Grok-1.5 nouvellement mis à niveau est publié.

Tout à l'heure, Musk xAI a officiellement annoncé que le contexte 128K Grok-1.5 avait considérablement amélioré ses capacités de raisonnement.

Et, il sera bientôt en ligne.

Il y a 11 jours, les poids et l'architecture du modèle Grok-1 étaient open source, montrant les progrès réalisés par Xai avant novembre dernier.

Grok-1 possède 314 milliards de paramètres, soit 4 fois plus grand que Llama 2, et utilise une architecture MoE. 2 des 8 experts sont des experts actifs.

Introduction à Xai, c'est-à-dire que depuis lors, l'équipe a amélioré les capacités de raisonnement et de résolution de problèmes du dernier modèle Grok-1.5.

L'ancien responsable des relations avec les développeurs chez OpenAI a déclaré que leur rythme et leur sentiment d'urgence peuvent être vus à partir du calendrier de la version majeure de xAI. Passionnant!

Contexte de 128K, les capacités de raisonnement mathématique de Grok-1.5 ont grimpé en flèche

Selon l'introduction officielle, Grok-1.5 a amélioré les capacités de raisonnement, avec une longueur de contexte de 128K.

L'une des améliorations les plus significatives de Grok-1.5 est ses performances dans les tâches de codage et liées aux mathématiques.

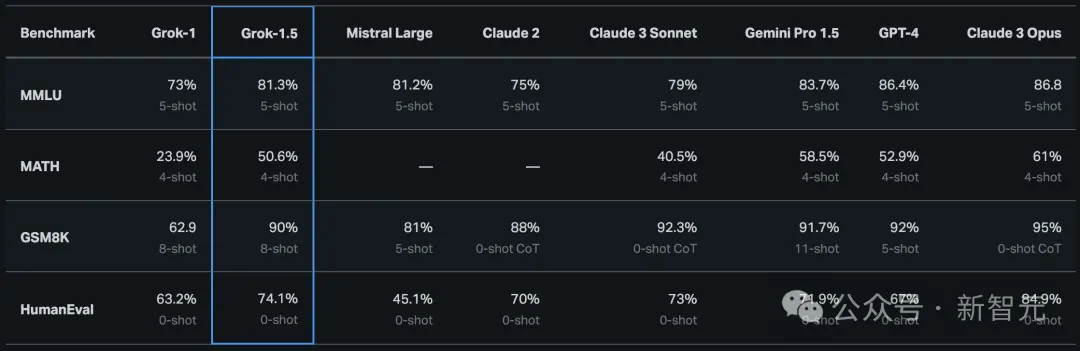

Dans le test, Grok-1.5 a obtenu un score de 50,6% au benchmark mathématique et de 90% au benchmark GSM8K. Ces deux benchmarks mathématiques couvrent divers problèmes de compétition de l'école primaire au lycée.

De plus, Grok-1.5 a obtenu un score élevé de 74,1 % dans le benchmark HumanEval qui évalue les capacités de génération de code et de résolution de problèmes.

Sur l'image ci-dessous, par rapport à Grok-1, on peut voir que les capacités mathématiques de Grok-1.5 ont été grandement améliorées, de 62,9 % à 90 sur GSM8K et de 23,9 % à 50,6 % sur MATH.

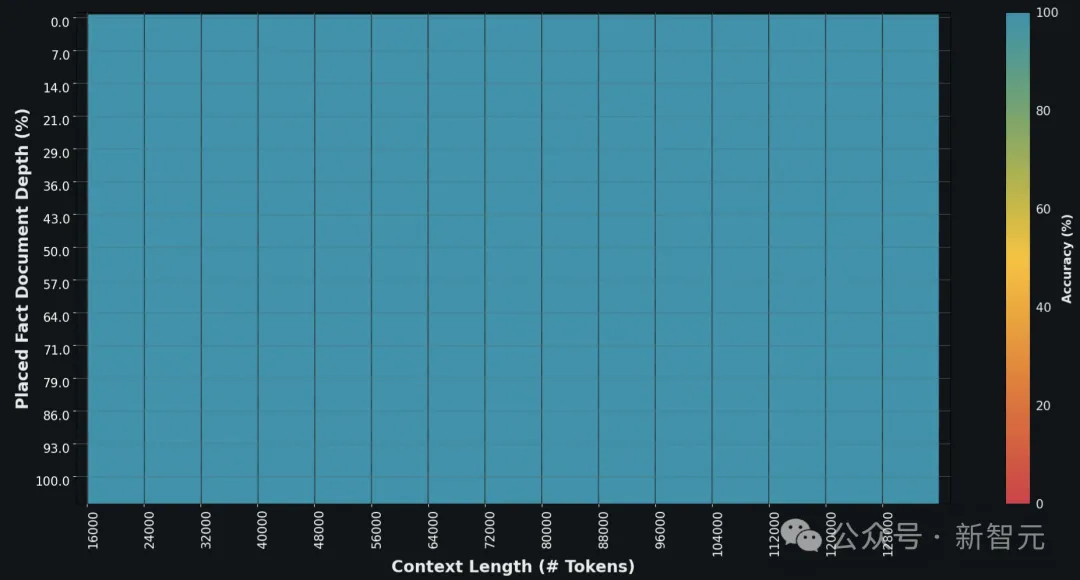

Compréhension du contexte long de 128 Ko, étendue 16 fois

Une autre nouvelle fonctionnalité de Grok-1.5 est la possibilité de gérer du texte allant jusqu'à 128 000 jetons dans sa fenêtre contextuelle.

Cela augmente la capacité de mémoire de Grok à 16 fois la longueur du contexte précédent, lui permettant d'exploiter les informations de documents plus longs.

De plus, le nouveau modèle peut gérer des invites plus longues et plus complexes tout en conservant sa capacité à suivre les instructions à mesure que sa fenêtre contextuelle s'agrandit.

Dans l'évaluation Needle In A Haystack (NIAH), Grok-1.5 a démontré de fortes capacités de récupération, récupérant du texte intégré dans un contexte d'une longueur allant jusqu'à 128 Ko et a obtenu des résultats de récupération parfaits.

Infrastructure Grok-1.5

Grok-1.5 est construit sur un framework de formation distribué personnalisé basé sur JAX, Rust et Kubernetes.

Cette pile de formation permet aux équipes xAI de créer des idées à grande échelle et de former de nouvelles architectures avec un investissement minimal.

Un défi majeur dans la formation LLM sur de grands clusters informatiques est de maximiser la fiabilité et la disponibilité des tâches de formation.

L'orchestrateur de formation personnalisé de xAI garantit que les nœuds problématiques sont automatiquement détectés et supprimés des tâches de formation.

Dans le même temps, ils ont également optimisé les points de contrôle, le chargement des données et le redémarrage des tâches de formation pour minimiser les temps d'arrêt en cas de panne.

xAI a déclaré que Grok-1.5 sera bientôt disponible pour les premiers testeurs pour aider à améliorer le modèle.

Le blog a également présenté en avant-première plusieurs nouvelles fonctionnalités que Grok-1.5 lancera dans les prochains jours.

Enfin, xAI a publié les informations de recrutement comme toujours.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment vlookup fait correspondre deux colonnes de données

- Quelles sont les raisons et les solutions à l'échec de la connexion à la base de données ?

- Comment utiliser vlookup d'Excel pour faire correspondre plusieurs colonnes de données à la fois

- Quelles sont les étapes pour se connecter à la base de données à l'aide de jdbc ?

- Entraîner une version chinoise de ChatGPT n'est pas si difficile : vous pouvez le faire avec l'open source Alpaca-LoRA+RTX 4090 sans A100