Maison >Périphériques technologiques >IA >Estimation de la profondeur SOTA ! Fusion adaptative de la profondeur monoculaire et surround pour la conduite autonome

Estimation de la profondeur SOTA ! Fusion adaptative de la profondeur monoculaire et surround pour la conduite autonome

- PHPzavant

- 2024-03-23 13:06:021415parcourir

Écrit avant et compréhension personnelle

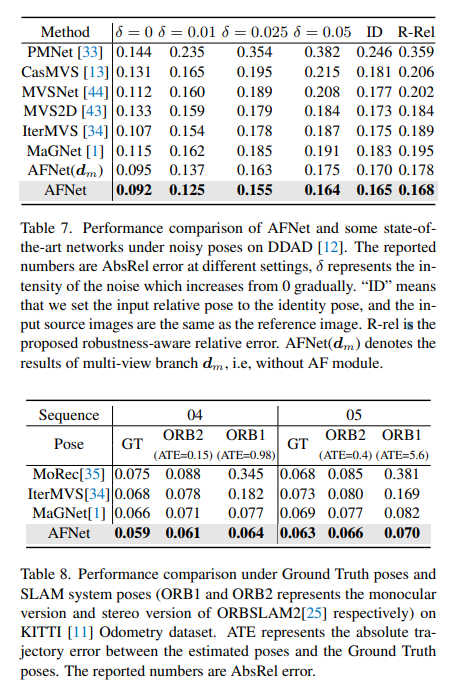

L'estimation de la profondeur multi-vues a atteint des performances élevées dans divers tests de référence. Cependant, presque tous les systèmes multi-vues actuels reposent sur une pose de caméra idéale donnée, qui n'est pas disponible dans de nombreux scénarios du monde réel, comme la conduite autonome. Ce travail propose un nouveau test de robustesse pour évaluer les systèmes d'estimation de profondeur dans divers paramètres de pose bruyante. Étonnamment, il s’avère que les méthodes actuelles d’estimation de la profondeur à vues multiples ou les méthodes de fusion à vues uniques et multi-vues échouent lorsque des paramètres de pose bruyants sont donnés. Pour relever ce défi, nous proposons ici AFNet, un système d'estimation de profondeur fusionnée à vue unique et multi-vue qui intègre de manière adaptative des résultats multi-vues et à vue unique de haute confiance pour obtenir une estimation de profondeur robuste et précise. Le module de fusion adaptative effectue une fusion en sélectionnant dynamiquement des régions à confiance élevée entre les deux branches sur la base de la carte de confiance des parcelles. Par conséquent, face à des scènes sans texture, à un calibrage imprécis, à des objets dynamiques et à d’autres conditions dégradées ou difficiles, le système a tendance à choisir la branche la plus fiable. Lors des tests de robustesse, la méthode surpasse les méthodes multi-vues et de fusion de pointe. De plus, des performances de pointe sont obtenues sur des tests de référence exigeants (KITTI et DDAD).

Lien du papier : https://arxiv.org/pdf/2403.07535.pdf

Nom du papier : Fusion adaptative de la profondeur à vue unique et multi-vue pour la conduite autonome

Arrière-plan de champ

L'estimation de la profondeur de l'image a toujours été un défi dans le domaine de la vision par ordinateur avec une large gamme d'applications. Pour les systèmes de conduite autonome basés sur la vision, la perception de la profondeur est essentielle, car elle permet de comprendre les objets sur la route et de créer des cartes 3D de l'environnement. Avec l'application des réseaux de neurones profonds à divers problèmes visuels, les méthodes basées sur les réseaux de neurones convolutifs (CNN) sont devenues la norme dans les tâches d'estimation de la profondeur.

Selon le format d'entrée, il est principalement divisé en estimation de profondeur multi-vues et estimation de profondeur en vue unique. L'hypothèse derrière les méthodes multi-vues pour estimer la profondeur est que, étant donné la profondeur correcte, le calibrage de la caméra et la pose de la caméra, les pixels des vues devraient être similaires. Ils s’appuient sur la géométrie épipolaire pour trianguler des mesures de profondeur de haute qualité. Cependant, la précision et la robustesse des méthodes multi-vues dépendent fortement de la configuration géométrique de la caméra et de la correspondance correspondante entre les vues. Premièrement, la caméra doit effectuer une translation suffisante pour permettre la triangulation. Dans un scénario de conduite autonome, le véhicule autonome peut s'arrêter à un feu de circulation ou tourner sans avancer, ce qui peut entraîner l'échec de la triangulation. De plus, les méthodes multi-vues souffrent des problèmes de cibles dynamiques et de zones sans texture, qui prédominent dans les scénarios de conduite autonome. Un autre problème est l’optimisation de l’attitude SLAM sur les véhicules en mouvement. Dans les méthodes SLAM existantes, le bruit est inévitable, sans parler des situations difficiles et inévitables. Par exemple, un robot ou une voiture autonome peut être déployé pendant des années sans recalibrage, ce qui entraîne des poses bruyantes. En revanche, étant donné que les méthodes à vue unique reposent sur la compréhension sémantique de la scène et des signaux de projection en perspective, elles sont plus robustes aux régions sans texture et aux objets dynamiques et ne reposent pas sur la pose de la caméra. Cependant, en raison de l’ambiguïté de l’échelle, ses performances sont encore loin derrière les méthodes multi-vues. Ici, nous avons tendance à examiner si les avantages de ces deux méthodes peuvent être bien combinés pour une estimation robuste et précise de la profondeur de la vidéo monoculaire dans des scénarios de conduite autonome.

Structure du réseau AFNet

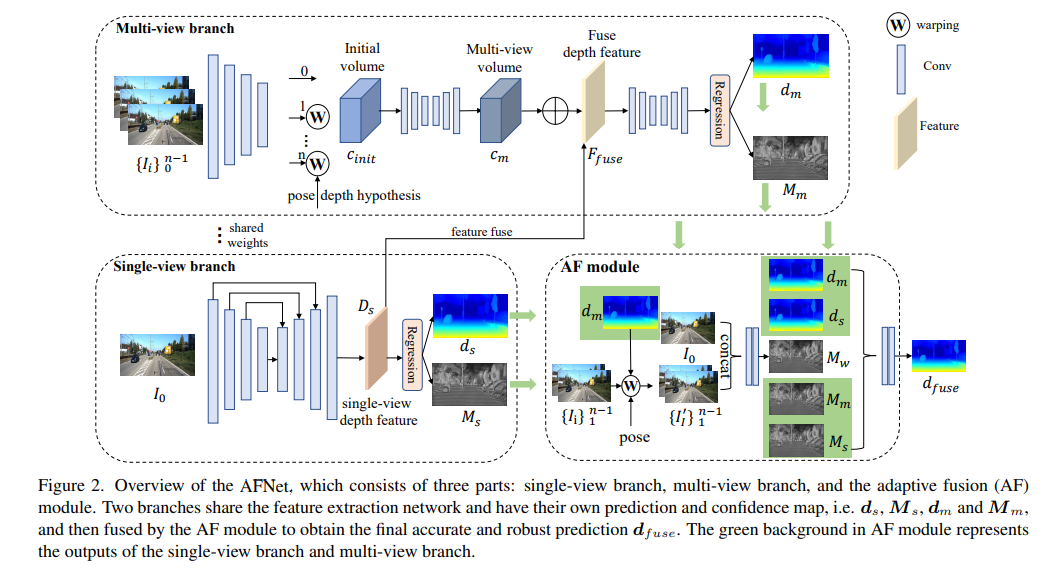

La structure AFNet est présentée ci-dessous. Elle se compose de trois parties : une branche à vue unique, une branche à vues multiples et un module de fusion adaptative (AF). Les deux branches partagent le réseau d'extraction de caractéristiques et ont leurs propres cartes de prédiction et de confiance, c'est-à-dire , , et , et sont ensuite fusionnées par le module AF pour obtenir la prédiction finale précise et robuste. Le fond vert dans le module AF représente l'unique. -branche vue et La sortie de la branche multi-vue.

Fonction de perte :

Modules de profondeur mono-vue et multi-vues

Afin de fusionner les fonctionnalités du backbone et d'obtenir les fonctionnalités profondes Ds, AFNet construit un décodeur multi-échelle. Dans ce processus, une opération softmax est effectuée sur les 256 premiers canaux de Ds pour obtenir le volume de probabilité de profondeur Ps. Le dernier canal de la fonction de profondeur est utilisé comme carte de confiance de profondeur à vue unique Ms. Enfin, la profondeur d'une vue unique est calculée grâce à une pondération douce.

Branche multi-vues

La branche multi-vue partage l'épine dorsale avec la branche à vue unique pour extraire les caractéristiques de l'image de référence et de l'image source. Nous adoptons la déconvolution pour déconvoluer les caractéristiques basse résolution en quart de résolution et les combinons avec les caractéristiques quart initiales utilisées pour construire le volume de coût. Un volume de caractéristiques est formé en enveloppant les caractéristiques sources dans un plan hypothétique suivi par la caméra de référence. Pour une correspondance robuste qui ne nécessite pas trop d'informations, la dimension de canal de la fonctionnalité est conservée dans le calcul et un volume de coût 4D est construit, puis le nombre de canaux est réduit à 1 via deux couches convolutives 3D.

La méthode d'échantillonnage de l'hypothèse de profondeur est cohérente avec la branche à vue unique, mais le nombre d'échantillons n'est que de 128, puis régularisé à l'aide d'un réseau de sabliers 2D empilé pour obtenir le volume final de coût multi-vue. Afin de compléter les riches informations sémantiques des fonctionnalités à vue unique et les détails perdus en raison de la régularisation des coûts, une structure résiduelle est utilisée pour combiner les fonctionnalités de profondeur à vue unique Ds et le volume de coût pour obtenir des fonctionnalités de profondeur fusionnées comme suit :

Module de fusion adaptatif

Afin d'obtenir la prédiction finale précise et robuste, le module AF est conçu pour sélectionner de manière adaptative la profondeur la plus précise entre les deux branches comme sortie finale, comme le montre la figure 2. La cartographie de fusion est réalisée à travers trois confiances, dont deux sont les cartes de confiance Ms et Mm générées respectivement par les deux branches. La plus critique est la carte de confiance Mw générée par Forward Wrap pour déterminer si la prédiction de la branche multi-vues est correcte. fiable. .

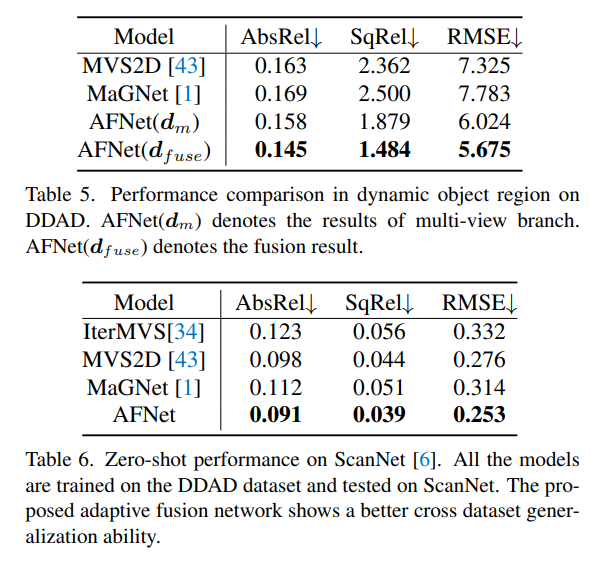

Résultats expérimentaux

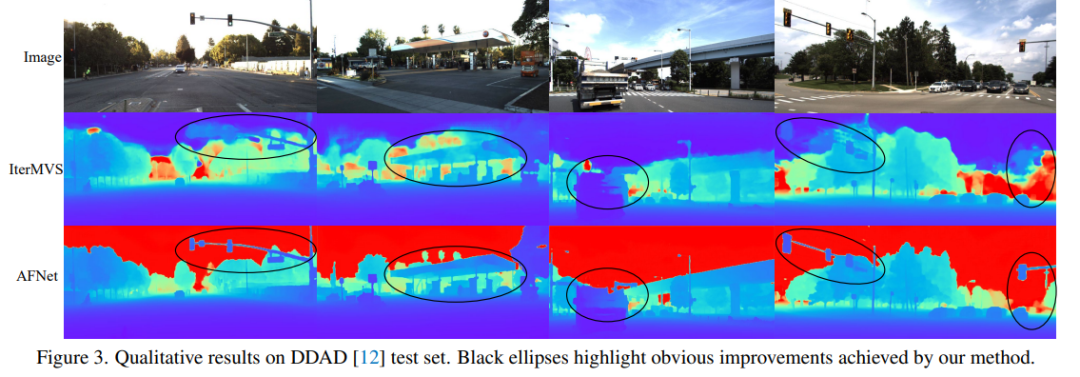

DDAD (Dense Depth for Autonomous Driving) est une nouvelle référence de conduite autonome pour l'estimation de la profondeur dense dans des conditions urbaines difficiles et diverses. Il est capturé par 6 caméras synchronisées et contient une profondeur de sol précise (champ de vision complet de 360 degrés) générée par un lidar haute densité. Il contient 12 650 échantillons d’apprentissage et 3 950 échantillons de validation dans une seule vue de caméra avec une résolution de 1 936 × 1 216. Toutes les données de 6 caméras sont utilisées pour la formation et les tests. L'ensemble de données KITTI fournit des images stéréoscopiques de scènes extérieures tournées sur des véhicules en mouvement et des scans laser 3D correspondants, avec une résolution d'environ 1241 × 376.

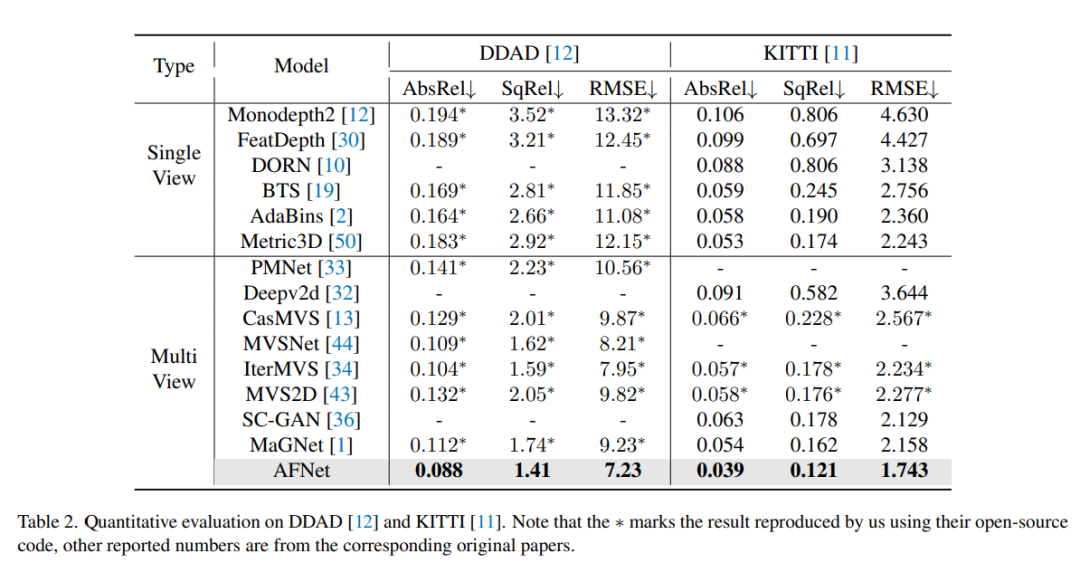

Comparaison des résultats d'évaluation sur DDAD et KITTI. Notez que * marque les résultats répliqués à l'aide de leur code open source, les autres chiffres rapportés proviennent des articles originaux correspondants.

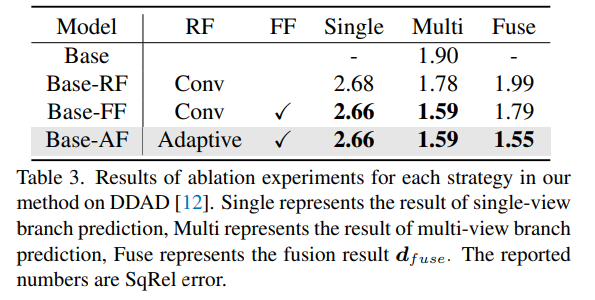

Résultats expérimentaux d'ablation pour chaque stratégie de la méthode sur DDAD. Single représente le résultat de la prédiction de branchement à vue unique, Multi- représente le résultat de la prédiction de branchement à vues multiples et Fuse représente le résultat de la fusion dfuse.

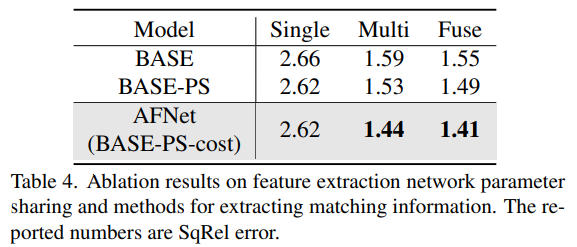

Une méthode pour partager les paramètres du réseau et extraire les informations correspondantes pour l'extraction des caractéristiques des résultats d'ablation.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Que comprend un système logiciel informatique ?

- Quelles sont les caractéristiques du système ?

- Interprétation complète de la technologie d'évaluation des risques de sécurité des réseaux d'entreprise

- Comment utiliser les outils de test de concurrence en Java pour évaluer les capacités de concurrence d'un système ?

- Méthodes et principes directeurs pour l'évaluation de la sécurité PHP