Maison >Périphériques technologiques >IA >DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

- PHPzavant

- 2024-03-21 17:21:09735parcourir

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment passer efficacement de la vue en perspective (PV) à l'espace de vue à vol d'oiseau (BEV). Fonctionnalités de transformation, Cette transformation est implémentée via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention pour la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente la complexité du calcul et du déploiement.

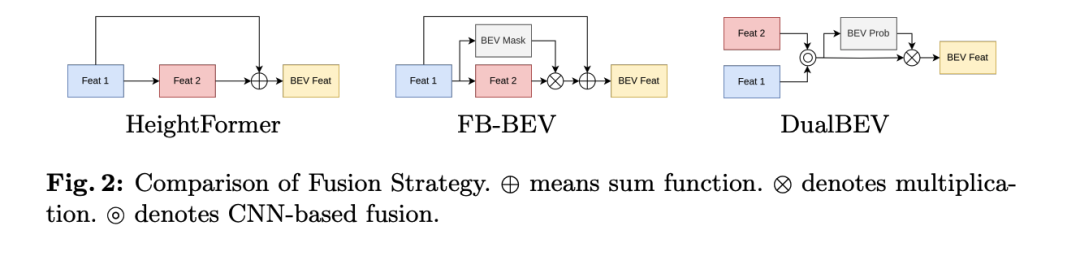

L'article souligne que les méthodes existantes telles que HeightFormer et FB-BEV tentent de combiner ces deux stratégies VT, mais ces méthodes adoptent généralement une stratégie en deux étapes. En raison des différentes transformations de fonctionnalités du double VT, elles le sont. limité par les performances initiales des fonctionnalités, ce qui entrave l'intégration transparente entre les deux VT. De plus, ces méthodes sont encore confrontées à des défis pour parvenir à un déploiement en temps réel de la conduite autonome.

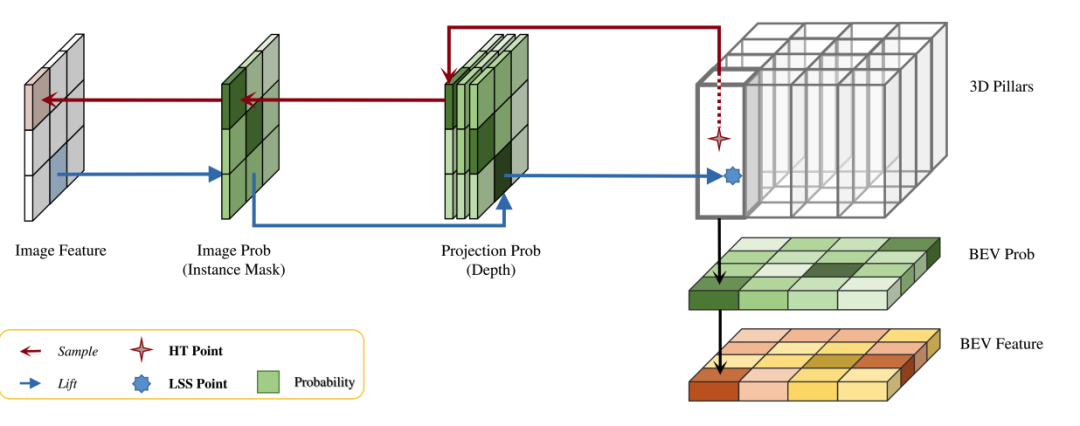

En réponse à ces problèmes, l'article propose une méthode de conversion de caractéristiques unifiée, adaptée à la conversion visuelle 2D en 3D et 3D en 2D, et évalue la correspondance entre les caractéristiques 3D et 2D à travers trois mesures de probabilité : probabilité BEV, probabilité de projection et image. probabilité. Cette nouvelle méthode vise à atténuer l'impact des zones vides dans la grille BEV sur la construction des fonctionnalités, à distinguer les correspondances multiples et à exclure les fonctionnalités d'arrière-plan pendant le processus de conversion des fonctionnalités.

En appliquant cette transformation de caractéristiques unifiée, l'article explore une nouvelle méthode de transformation visuelle 3D en 2D utilisant des réseaux de neurones convolutifs (CNN) et introduit une méthode appelée HeightTrans. En plus de démontrer ses performances supérieures, il démontre également le potentiel d’accélération grâce au précalcul, ce qui le rend adapté aux applications de conduite autonome en temps réel. Dans le même temps, en intégrant cette transformation de fonctionnalités, le processus LSS traditionnel est amélioré, démontrant son universalité pour les détecteurs actuels.

Combinant HeightTrans et Prob-LSS, l'article présente DualBEV, une méthode innovante qui considère et fusionne les correspondances du BEV et des vues en perspective en une seule étape, éliminant ainsi la dépendance aux caractéristiques initiales. De plus, un puissant module de fusion de fonctionnalités BEV, appelé module de fusion à double fonctionnalité (DFF), est proposé pour aider à affiner davantage la prédiction de probabilité BEV en utilisant le module d'attention de canal et le module d'attention spatiale. DualBEV suit le principe « entrée étendue, sortie stricte » et comprend et représente la distribution de probabilité de la scène en utilisant une correspondance probabiliste précise à double vue.

Les principales contributions de l'article sont les suivantes :

- révèle la similitude intrinsèque entre la transformation visuelle 3D en 2D et 2D en 3D, et propose une méthode de transformation de caractéristiques unifiée qui est précise à la fois dans les vues BEV et en perspective. Établir une relation correspondante réduit considérablement l’écart entre les deux stratégies.

- Proposition d'une nouvelle méthode de conversion visuelle 3D en 2D basée sur CNN, HeightTrans, qui établit de manière efficace et efficiente une correspondance 3D-2D précise grâce à un échantillonnage probabiliste et un pré-calcul de table de recherche.

- DFF est introduit pour la fusion de fonctionnalités à double vue. Cette stratégie de fusion capture les informations des régions proches et lointaines en une seule étape, générant ainsi des fonctionnalités BEV complètes.

- Leur framework efficace DualBEV atteint 55,2 % de mAP et 63,4 % de NDS sur l'ensemble de test nuScenes, même sans utiliser Transformer, soulignant l'importance de capturer une correspondance précise à double vue pour la transformation de vue.

Grâce à ces innovations, l'article propose une nouvelle stratégie pour surmonter les limites des méthodes existantes et parvenir à une détection d'objets plus efficace et plus précise dans des scénarios d'application en temps réel tels que la conduite autonome.

Explication détaillée de DualBEV

La méthode proposée dans cet article vise à résoudre le problème de détection d'objets BEV (vue à vol d'oiseau) dans la conduite autonome grâce à un cadre de conversion de fonctionnalités unifié, DualBEV. Vous trouverez ci-dessous le contenu principal de la section Méthodes, décrivant ses différentes sous-sections et ses principales innovations.

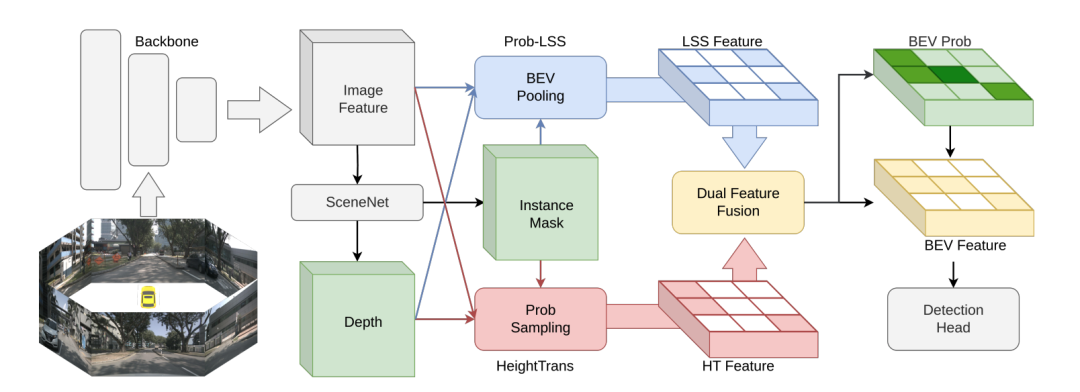

Présentation de DualBEV

Le flux de traitement de DualBEV commence à partir des caractéristiques de l'image obtenues à partir de plusieurs caméras, puis utilise SceneNet pour générer des masques d'instance et des cartes de profondeur Ensuite, extrayez via le module HeightTrans et Prob-LSS. fonctionnalités de pipeline et de transformation, et enfin ces fonctionnalités sont fusionnées et utilisées pour prédire la distribution de probabilité de l'espace BEV afin d'obtenir les fonctionnalités BEV finales pour les tâches ultérieures.

HeightTrans

HeightTrans est basé sur le principe de conversion visuelle 3D en 2D, en sélectionnant des positions 3D et en les projetant dans l'espace image, et en évaluant ces correspondances 3D-2D. Cette méthode échantillonne d'abord un ensemble de points 3D dans une carte BEV prédéfinie, puis examine et filtre soigneusement ces correspondances pour générer des caractéristiques BEV. HeightTrans améliore l'attention portée aux petits objets et résout le problème trompeur causé par les pixels d'arrière-plan en adoptant une stratégie d'échantillonnage multi-résolution et une méthode d'échantillonnage probabiliste. De plus, le problème de la grille BEV vierge est résolu en introduisant la probabilité BEV . Le module HeightTrans est l'une des technologies clés proposées dans l'article, se concentrant sur le traitement et la transformation des caractéristiques via la transformation visuelle (VT) 3D en 2D. Il est basé sur la sélection d'emplacements 3D à partir d'une carte prédéfinie Bird's Eye View (BEV) et la projection de ces emplacements dans l'espace image, évaluant ainsi la correspondance entre la 3D et la 2D. Ce qui suit est une introduction détaillée au fonctionnement de HeightTrans :

BEV Height

La méthode HeightTrans adopte une stratégie d'échantillonnage multi-résolution lors du traitement de la hauteur, couvrant toute la plage de hauteur (de -5 mètres à 3 mètres), dans le zone d'intérêt La résolution dans la ROI (définie entre -2 mètres et 2 mètres) est de 0,5 mètre et la résolution en dehors de cette plage est de 1,0 mètre. Cette stratégie permet de se concentrer davantage sur les petits objets qui peuvent manquer dans un échantillonnage à résolution plus grossière.

Prob-Sampling

HeightTrans adopte les étapes suivantes dans l'échantillonnage probabiliste :

- Définir des points d'échantillonnage 3D : prédéfinir un ensemble de points d'échantillonnage 3D, chaque point est déterminé par sa position dans l'espace 3D Définition.

- Projection dans l'espace 2D : à l'aide de la matrice de paramètres extrinsèques et de la matrice de paramètres intrinsèques de la caméra, projetez le point 3D vers un point dans l'espace image 2D , où représente la profondeur du point.

- Échantillonnage de caractéristiques : utilisez un échantillonneur de grille bilinéaire pour échantillonner les caractéristiques de l'image à la position de projection :

- Utilisez un masque d'instance : Afin d'éviter que la position de projection ne tombe sur les pixels d'arrière-plan, utilisez SceneNet pour générer un masque d'instance pour représenter la probabilité de l'image et l'appliquer aux caractéristiques de l'image afin de réduire l'impact des informations trompeuses :

- Gérer plusieurs correspondances : Utiliser un échantillonneur de grille trilinéaire dans la carte de profondeur évalue le situation dans laquelle plusieurs points 3D correspondent à la même position 2D, c'est-à-dire la probabilité de projection :

- Introduction de la probabilité BEV : Afin de résoudre le problème selon lequel les cellules vides de la grille BEV ne fournissent pas d'informations utiles, le La probabilité BEV est introduite Représente la probabilité d'occupation de la grille BEV, où est la position dans l'espace BEV :

accélère

en précalculant l'index des points 3D dans l'espace BEV et en fixant l'index des caractéristiques de l'image et l'index de la carte de profondeur pendant l'inférence, HeightTrans peut accélérer le processus de conversion visuelle. La fonctionnalité finale HeightTrans étend le pipeline LSS (Lift, Splat, Shoot) traditionnel en prédisant les probabilités de profondeur pour chaque pixel avec

Prob-LSS

Prob-LSS prédéfini pour chaque maillage BEV. Il est projeté dans l'espace BEV. Cette méthode intègre en outre les probabilités BEV pour créer des fonctionnalités LSS via la formule suivante :

Cela permet de mieux gérer l'incertitude dans l'estimation en profondeur, réduisant ainsi les informations redondantes dans l'espace BEV.

Dual Feature Fusion (DFF)

Le module DFF est conçu pour fusionner les fonctionnalités de HeightTrans et Prob-LSS et prédire efficacement la probabilité BEV. En combinant le module d'attention de canal et le ProbNet à attention spatiale augmentée, DFF est capable d'optimiser la sélection de caractéristiques et la prédiction de probabilité BEV pour améliorer la représentation des objets proches et distants. Cette stratégie de fusion prend en compte la complémentarité des caractéristiques des deux flux tout en améliorant la précision de la probabilité BEV en calculant l'attention locale et globale.

En bref, le framework DualBEV proposé dans cet article permet une évaluation et une conversion efficaces de la correspondance entre les fonctionnalités 3D et 2D en combinant HeightTrans et Prob-LSS, ainsi qu'un module innovant de fusion de fonctionnalités doubles. Cela comble non seulement le fossé entre les stratégies de conversion 2D vers 3D et 3D vers 2D, mais accélère également le processus de conversion des caractéristiques grâce au pré-calcul et à la mesure de probabilité, ce qui le rend adapté aux applications de conduite autonome en temps réel.

La clé de cette méthode est la correspondance précise et la fusion efficace des caractéristiques sous différents angles de vue, permettant ainsi d'obtenir d'excellentes performances dans la détection d'objets BEV.

Expériences

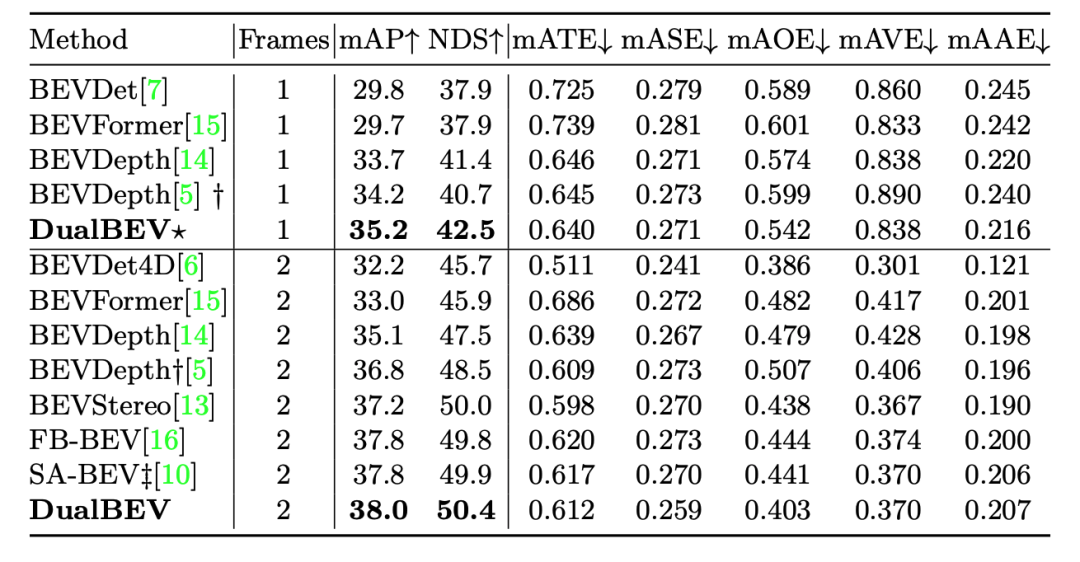

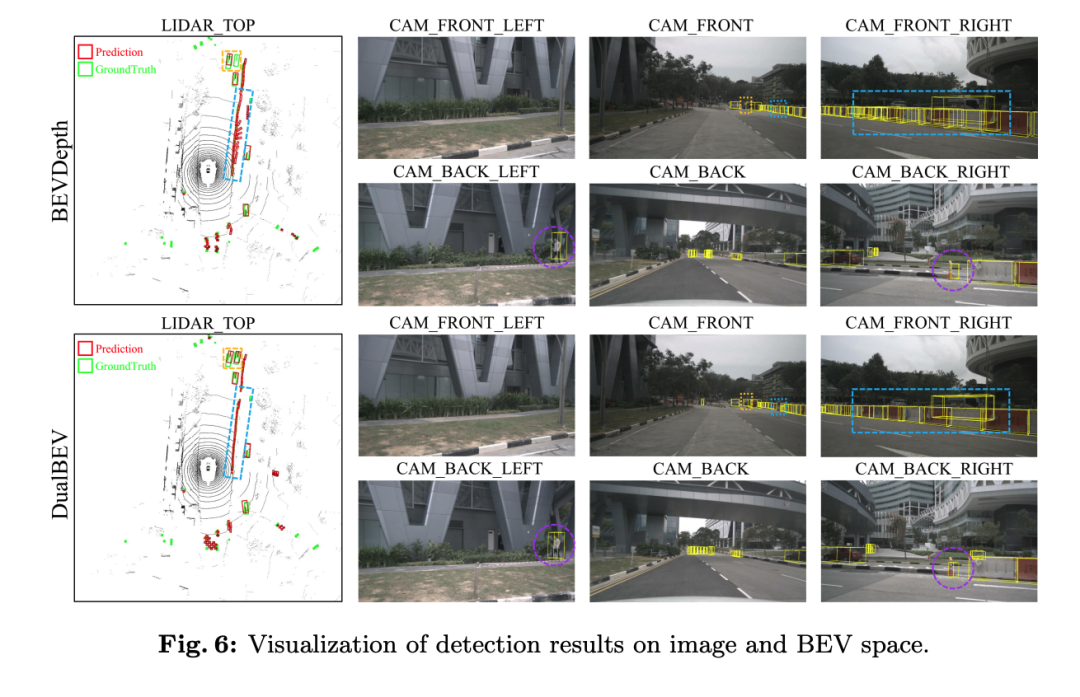

La variante de la méthode DualBEV (DualBEV* avec un astérisque) a donné de meilleurs résultats dans les conditions d'entrée d'une seule image, atteignant 35,2 % de mAP et 42,5 % de NDS, ce qui montre qu'elle est précise. Elle dépasse d'autres méthodes en termes de précision et de performances globales. Surtout sur mAOE, DualBEV* atteint un score de 0,542, ce qui est le meilleur parmi les méthodes à image unique. Cependant, ses performances sur mATE et mASE ne sont pas significativement meilleures que celles des autres méthodes.

Lorsque le nombre de trames d'entrée est augmenté à deux trames, les performances de DualBEV sont encore améliorées, avec mAP atteignant 38,0 % et NDS atteignant 50,4 %. Il s'agit du NDS le plus élevé parmi toutes les méthodes répertoriées, indiquant que DualBEV est plus complet lors du traitement. des entrées plus complexes. Parmi les méthodes multi-trames, elle présente également de solides performances dans mATE, mASE et mAAE, en particulier une amélioration significative de mAOE, montrant son avantage dans l'estimation des directions des objets.

Il peut être analysé à partir de ces résultats que DualBEV et ses variantes fonctionnent bien sur plusieurs indicateurs de performance importants, en particulier dans le cadre multi-trame, indiquant qu'il a une bonne précision et une bonne robustesse pour les tâches de détection d'objets BEV. En outre, ces résultats soulignent également l’importance d’utiliser des données multi-cadres pour améliorer les performances globales et la précision de l’estimation du modèle.

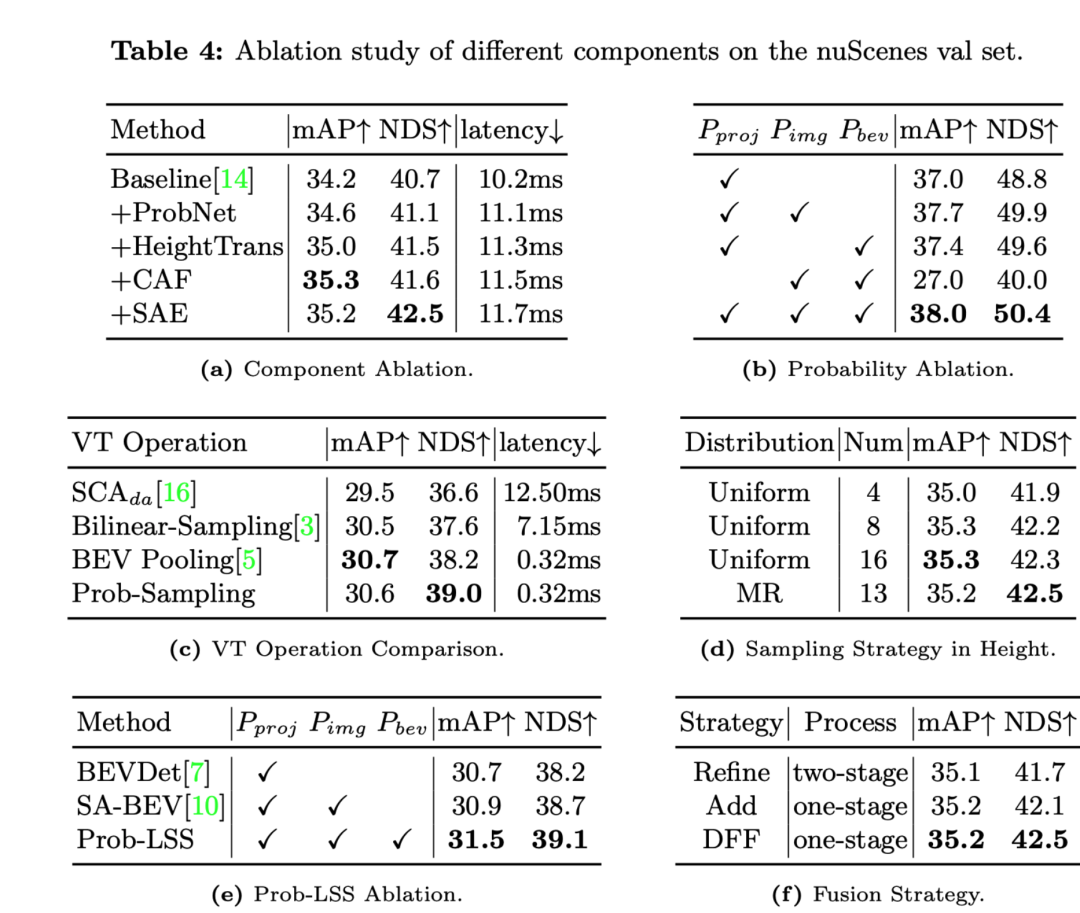

Ce qui suit est une analyse des résultats de chaque expérience d'ablation :

- L'ajout de composants tels que ProbNet, HeightTrans, CAF (Channel Attention Fusion), SAE (Spatial Attention Enhanced), etc. a progressivement amélioré les performances de la ligne de base.

- L'ajout de HeightTrans améliore considérablement mAP et NDS, ce qui montre que l'introduction d'informations sur la hauteur dans la transformation visuelle est efficace.

- CAF améliore encore mAP, mais augmente légèrement la latence.

- L'introduction de SAE a augmenté le NDS jusqu'à un maximum de 42,5 % et a également amélioré le mAP, indiquant que le mécanisme d'attention spatiale a effectivement amélioré les performances du modèle.

- Différentes mesures de probabilité (probabilité de projection , probabilité d'image , probabilité BEV ) sont progressivement ajoutées aux expériences comparatives.

- Le modèle a obtenu les mAP et NDS les plus élevés lorsque les trois probabilités ont été utilisées simultanément, ce qui indique que la combinaison de ces probabilités est essentielle aux performances du modèle.

- Prob-Sampling a un NDS plus élevé (39,0 %) que les autres opérations VT avec un délai similaire (0,32 ms), ce qui souligne la supériorité des performances de l'échantillonnage probabiliste.

- La stratégie d'échantillonnage multi-résolution (MR) peut obtenir des performances similaires ou meilleures que la stratégie d'échantillonnage uniforme en utilisant le même nombre de points d'échantillonnage.

- En ajoutant la probabilité de projection, la probabilité d'image et la probabilité BEV au processus LSS, Prob-LSS surpasse les autres variantes LSS, améliorant mAP et NDS, montrant l'efficacité de la combinaison de ces probabilités.

- Par rapport à la stratégie Refine en plusieurs étapes, la stratégie Add en une seule étape et le module DFF peuvent atteindre un NDS plus élevé, et DFF présente également une légère amélioration du mAP, ce qui montre que DFF est une stratégie de fusion en une seule étape. bénéfique en termes d’efficacité et de performance.

Les expériences d'ablation montrent que les composants et les stratégies tels que HeightTrans, les mesures probabilistes, Prob-Sampling et DFF sont cruciaux pour améliorer les performances du modèle. De plus, l’utilisation d’une stratégie d’échantillonnage multi-résolution sur les informations de hauteur prouve également son efficacité. Ces résultats soutiennent l'argument des auteurs selon lequel chacune des techniques présentées dans la section méthodes contribue positivement aux performances du modèle.

Discussion

Cet article démontre les performances de sa méthode à travers une série d'expériences d'ablation. Il ressort des résultats expérimentaux que le cadre DualBEV proposé dans l'article et ses différents composants ont un impact positif sur l'amélioration de la précision de la détection d'objets en vue à vol d'oiseau (BEV).

La méthode du document introduit progressivement les modules ProbNet, HeightTrans, CAF (Channel Attention Fusion) et SAE (Spatial Attention Enhanced) dans le modèle de base, montrant des améliorations significatives des indicateurs mAP et NDS. joue un rôle important dans l’architecture globale. Surtout après l'introduction du SAE, le score NDS a augmenté jusqu'au point le plus élevé de 42,5 %, tandis que le délai n'a augmenté que légèrement, ce qui montre que la méthode atteint un bon équilibre entre précision et délai.

Les résultats expérimentaux d'ablation probabiliste ont en outre confirmé l'importance de la probabilité de projection, de la probabilité d'image et de la probabilité BEV dans l'amélioration des performances de détection. Lorsque ces probabilités sont introduites une par une, les scores mAP et NDS du système s'améliorent régulièrement, démontrant l'importance d'intégrer ces mesures probabilistes dans la tâche de détection d'objets BEV.

Dans la comparaison des opérations de transformation visuelle (VT), la méthode Prob-Sampling proposée par l'article montre une latence plus faible et un score NDS plus élevé par rapport à d'autres opérations telles que SCAda et Bilinear-Sampling, ce qui met l'accent sur ses performances en termes d'efficacité et d'avantages en termes de performances. . De plus, pour différentes stratégies d'échantillonnage à hauteur, l'adoption d'une stratégie multi-résolution (MR) au lieu d'un échantillonnage uniforme peut encore améliorer le score NDS, ce qui démontre l'importance de prendre en compte les informations à différentes hauteurs de la scène pour améliorer les performances de détection.

De plus, pour différentes stratégies de fusion de fonctionnalités, l'article montre que la méthode DFF peut toujours maintenir des scores NDS élevés tout en simplifiant le modèle, ce qui signifie que la fusion de fonctionnalités à double flux dans un flux de traitement en une étape est efficace.

Cependant, bien que la méthode proposée dans l'article fonctionne bien à bien des égards, chaque amélioration entraînera également une augmentation de la complexité du système et du coût de calcul. Par exemple, chaque fois qu'un nouveau composant est introduit (tel que ProbNet, HeightTrans, etc.), la latence du système augmentera. Bien que l'augmentation de la latence soit subtile, cela se produit dans les applications ayant des exigences en temps réel ou à faible latence. peut devenir une considération. De plus, même si les mesures probabilistes contribuent à l’amélioration des performances, elles nécessitent également des ressources informatiques supplémentaires pour estimer ces probabilités, ce qui peut entraîner une consommation de ressources plus élevée.

La méthode DualBEV proposée dans l'article a obtenu des résultats remarquables en améliorant la précision et les performances globales de la détection d'objets BEV, notamment en combinant les dernières avancées en matière d'apprentissage profond avec la technologie de transformation visuelle. Cependant, ces avancées se font au prix d’une latence de calcul et d’une consommation de ressources légèrement accrues, et les applications pratiques doivent peser ces facteurs au cas par cas.

Conclusion

Cette méthode fonctionne bien dans la tâche de détection d'objets BEV, améliorant considérablement la précision et les performances globales. En introduisant l'échantillonnage probabiliste, la transformation de la hauteur, le mécanisme d'attention et le réseau d'augmentation de l'attention spatiale, DualBEV améliore avec succès plusieurs indicateurs de performance clés, en particulier la précision de la vue à vol d'oiseau (BEV) et la compréhension de la scène. Les résultats expérimentaux montrent que la méthode décrite dans l'article est particulièrement efficace pour traiter des scènes et des données complexes sous différentes perspectives, ce qui est crucial pour la conduite autonome et d'autres applications de surveillance en temps réel.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!