Maison >Tutoriel matériel >Examen du matériel >Entraînez votre chien robot en temps réel avec Vision Pro ! Le projet open source d'un doctorant du MIT est populaire

Entraînez votre chien robot en temps réel avec Vision Pro ! Le projet open source d'un doctorant du MIT est populaire

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-03-12 21:40:02787parcourir

Vision Pro a un autre nouveau gameplay très intéressant, cette fois il est lié à l'intelligence incarnée ~

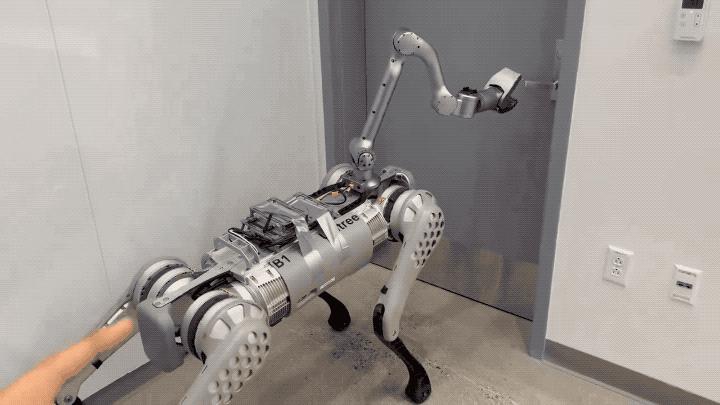

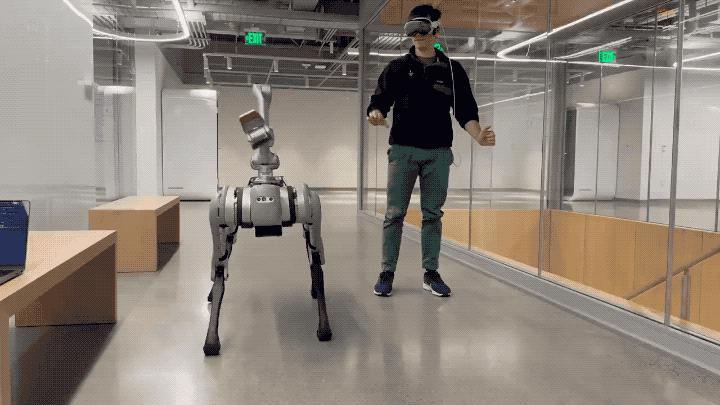

Juste comme ça, le gars du MIT a utilisé la fonction de suivi des mains de Vision Pro pour réussir à contrôler en temps réel le chien robot.

Non seulement les actions telles que l'ouverture d'une porte peuvent être précises, mais il n'y a également presque aucun retard.

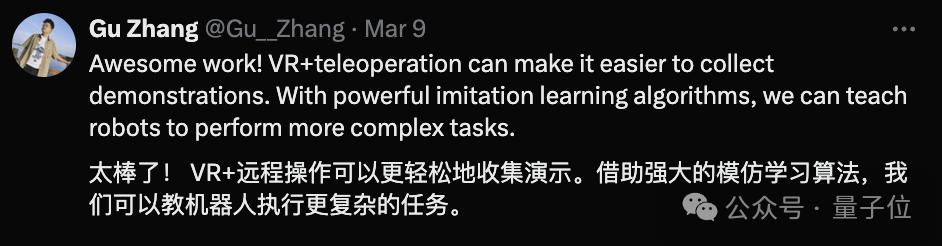

Dès la sortie de la démo, non seulement les internautes ont fait l'éloge de Goose Girl, mais divers chercheurs en intelligence incarnée étaient également enthousiasmés.

Par exemple, ce futur doctorant de l'Université Tsinghua :

Certaines personnes prédisent avec audace : C'est ainsi que nous interagirons avec la prochaine génération de machines.

Regardons de plus près l'application développée par l'auteur - Tracking Steamer.

Regardons de plus près l'application développée par l'auteur - Tracking Steamer.

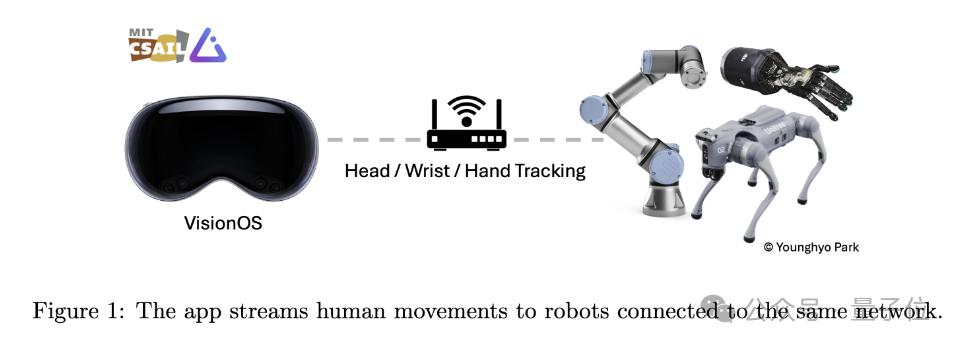

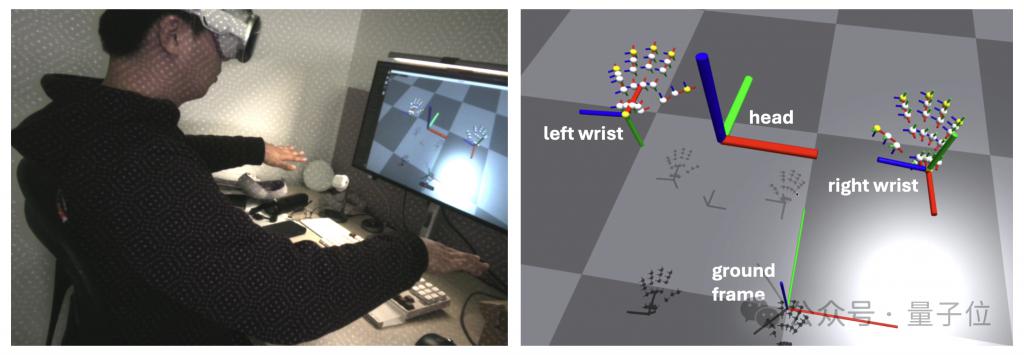

Comme son nom l'indique, cette application est conçue pour utiliser Vision Pro pour suivre les mouvements humains et transmettre ces données de mouvement à d'autres appareils robotiques sous le même WiFi en temps réel.

La partie suivi de mouvement s'appuie principalement sur la bibliothèque ARKit d'Apple.

Le suivi de la tête appelle queryDeviceAnchor. Les utilisateurs peuvent réinitialiser le cadre principal à sa position actuelle en appuyant longuement sur la couronne numérique.

En termes de communication réseau, cette application utilise gRPC comme protocole de communication réseau pour diffuser des données. Cela permet d'abonner des données à davantage d'appareils, notamment des appareils Linux, Mac et Windows.

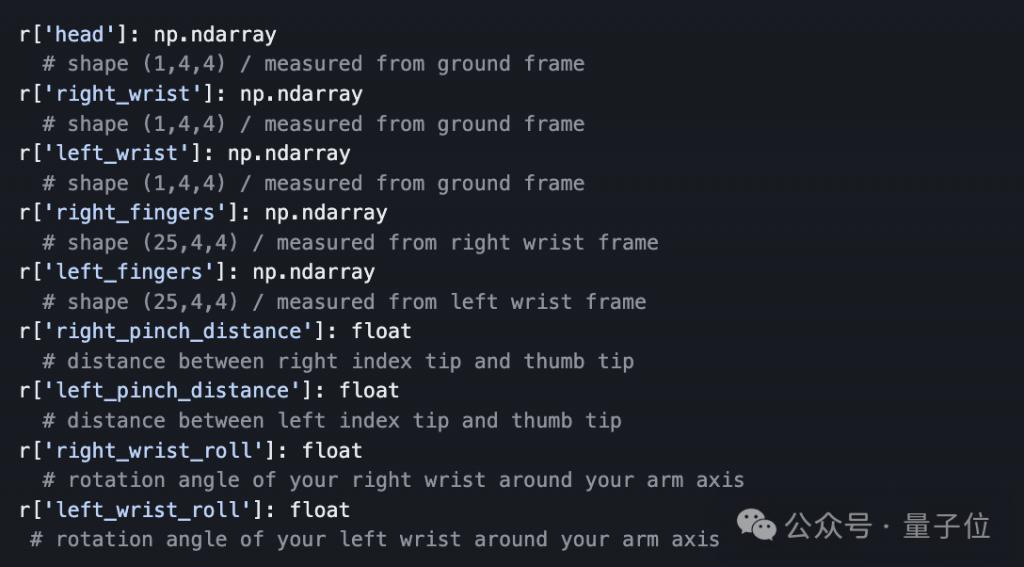

De plus, afin de faciliter la transmission des données, l'auteur a également préparé une API Python qui permet aux développeurs de s'abonner et de recevoir des données de suivi diffusées depuis Vision Pro par programmation.

Comme de nombreux professionnels l'ont souligné, que les mouvements du chien robot soient ou non toujours contrôlés par des humains, en fait, par rapport au « contrôle » lui-même, combiné à l'algorithme d'apprentissage par imitation, les humains sont plus capables de ce processus. Comme un entraîneur de robot.

Vision Pro fournit une méthode d'interaction intuitive et simple en suivant les mouvements de l'utilisateur, permettant aux non-professionnels de fournir des données d'entraînement précises pour les robots.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quelle est la différence entre Mac et Windows

- Comment désinstaller un logiciel sur Mac

- Ayez de la vision ! Huawei a enregistré la marque Vision Pro il y a quatre ans : Apple AR doit changer de nom en Chine

- Nouvelles fonctionnalités révélées : la version bêta d'Apple VisionOS lance le 'mode voyage'

- Comment supprimer des caractères dans Meitu Xiuxiu