Maison >Périphériques technologiques >Industrie informatique >Bibliothèque d'accélération NPU open source Intel, processeur Core Ultra AI PC peut exécuter de grands modèles de langage légers

Bibliothèque d'accélération NPU open source Intel, processeur Core Ultra AI PC peut exécuter de grands modèles de langage légers

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-03-05 11:13:021611parcourir

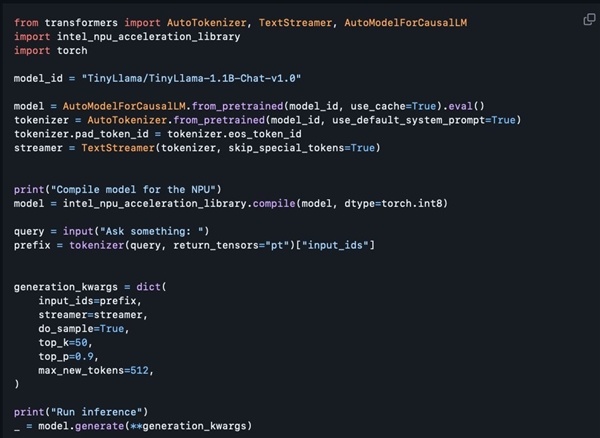

Selon les informations du 4 mars, Intel a récemment publié sa bibliothèque d'accélération NPU sur GitHub. Cette décision permet aux PC IA équipés de processeurs Core Ultra d'exécuter plus facilement des modèles de langage légers à grande échelle tels que TinyLlama et Gemma-2b.

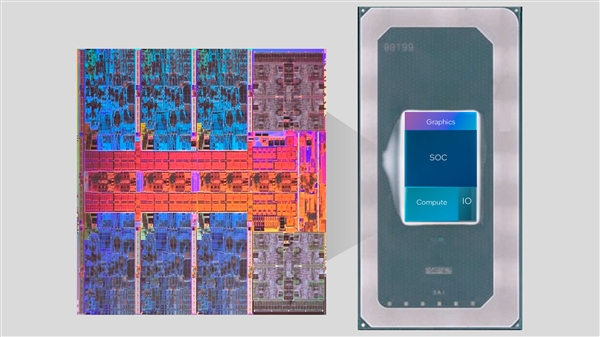

La série Core Ultra intègre pour la première fois le moteur NPU AI. Ce moteur peut gérer certaines tâches d'inférence d'IA légères et fonctionner avec le CPU et le GPU pour répondre aux exigences de diverses applications d'IA.

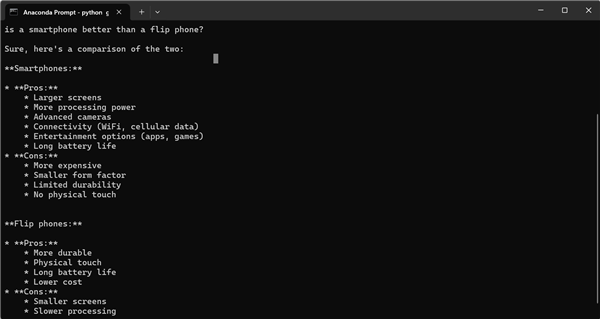

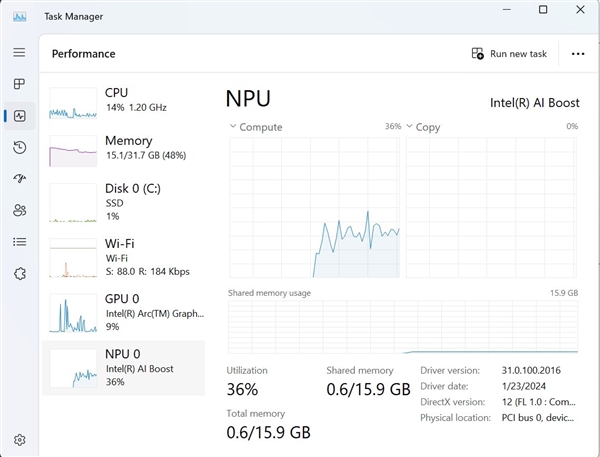

Il est entendu que bien que la bibliothèque d'accélération NPU publiée cette fois soit principalement préparée pour les développeurs, les utilisateurs ayant une certaine expérience en programmation peuvent également essayer de l'utiliser. Tony Mongkolsmai, architecte logiciel chez Intel, a montré comment exécuter un chatbot IA basé sur le grand modèle TinyLlama à 1,1 milliard de paramètres sur un ordinateur portable MSI Monarch 14 AI Evo, capable de mener des conversations simples. Dans le même temps, le Gestionnaire des tâches de Windows affiche également les appels valides vers le NPU.

Cependant, la bibliothèque d'accélération NPU open source actuelle présente encore quelques lacunes en termes de fonctionnalités. Elle prend en charge la quantification 8 bits et la précision FP16, mais ne prend pas encore en charge les fonctions avancées telles que la quantification 4 bits, la précision BF16 et la précision NPU. /GPU hybride, et la documentation technique pertinente n'a pas encore été fournie. Cependant, Intel a promis d'étendre progressivement ses fonctions à l'avenir, ce qui devrait doubler les fonctions existantes, ce qui apportera sans aucun doute plus de commodité et de possibilités aux développeurs d'IA.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Étapes pour créer un projet javaWeb à l'aide d'IntelliJ IDEA sur Mac

- Introduction graphique à l'utilisation de Debug dans Intellij IDEA

- La différence entre Intel Core i7-8700 et 8700K

- Nouveau correctif Intel TSX pour les files d'attente du noyau Linux, forçant la désactivation du 'mode développement' TSX

- Qu'est-ce qu'Intel TXT ?