Maison >Périphériques technologiques >IA >Explication détaillée de l'indicateur de score F1 pour l'évaluation de l'apprentissage automatique

Explication détaillée de l'indicateur de score F1 pour l'évaluation de l'apprentissage automatique

- PHPzavant

- 2024-01-23 17:06:051953parcourir

La métrique de précision est une mesure du nombre de fois où le modèle a correctement prédit sur l'ensemble de l'ensemble de données. Cependant, cette métrique n’est fiable que si l’ensemble de données est équilibré en classes. Autrement dit, il existe le même nombre d’échantillons pour chaque catégorie de l’ensemble de données. Cependant, les ensembles de données du monde réel sont souvent gravement déséquilibrés, ce qui rend les mesures de précision impossibles à réaliser. Pour résoudre ce problème, le score F1 a été introduit en tant que mesure d'évaluation de l'apprentissage automatique plus complète et plus complète. Le score F1 combine la précision et le rappel du modèle et permet de mieux évaluer l'exactitude du modèle. La précision fait référence au nombre d'échantillons prédits comme positifs par le modèle qui sont de vrais positifs, tandis que le rappel fait référence au nombre de vrais positifs que le modèle peut prédire correctement. La formule de calcul du score F1 est : 2* (taux de précision * taux de rappel) / (taux de précision + taux de rappel). En considérant globalement la précision et le rappel, le score F1 peut évaluer plus précisément les performances du modèle, en particulier dans le

Concept de score F1

Le score F1 est étroitement lié à la matrice de confusion, qui est utilisée pour évaluer la précision du classificateur. Des métriques telles que la précision et le rappel. En combinant précision et rappel, le score F1 fournit une évaluation de la performance globale du modèle.

La précision mesure combien de prédictions « positives » faites par un modèle sont correctes.

Le rappel mesure combien d'échantillons positifs présents dans l'ensemble de données sont correctement reconnus par le modèle.

La précision et le rappel offrent une relation de compromis, dans laquelle l'amélioration d'une mesure se fait au détriment de l'autre. Une précision plus élevée signifie un classificateur plus strict qui mettra en doute les échantillons positifs réels dans l'ensemble de données, réduisant ainsi le taux de rappel. D'un autre côté, un rappel plus élevé nécessite un classificateur détendu qui permet à tout échantillon similaire à la classe positive de passer à travers, ce qui classera à tort certains échantillons négatifs dans les cas limites en tant que « classe positive » et réduira ainsi la précision. Idéalement, nous aimerions maximiser les métriques de précision et de rappel pour obtenir un classificateur parfait.

Le score F1 combine précision et rappel en utilisant leur moyenne harmonique, maximiser le score F1 signifie maximiser la précision et le rappel simultanément.

Comment calculer le score F1 ?

Pour comprendre le calcul du score F1, vous devez d'abord comprendre la matrice de confusion. Nous avons mentionné ci-dessus que le score F1 est défini en termes de précision et de rappel. Sa formule est la suivante :

Précision

Le score F1 est calculé comme la moyenne harmonique des scores de précision et de rappel, comme indiqué ci-dessous. Il varie de 0 à 100 %, un score F1 plus élevé indiquant une meilleure qualité du classificateur.

Pour calculer le score F1 pour un ensemble de données multi-classes, une technique individuelle est utilisée pour calculer les scores individuels pour chaque classe de l'ensemble de données. Prenez la moyenne harmonique de la précision de classe et des valeurs de rappel. Le score net F1 est ensuite calculé à l’aide de différentes techniques de moyenne.

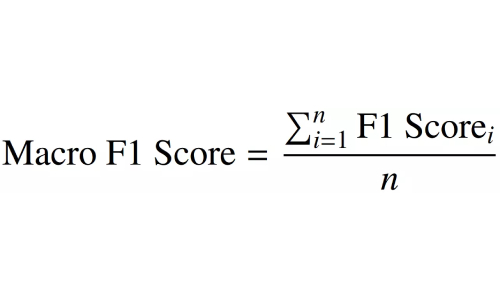

Score macro-moyen F1

Le score micro-moyen F1 est un indicateur significatif pour la distribution de données multi-classes. Il utilise les valeurs « nettes » TP, FP et FN pour calculer l'indicateur.

Net TP fait référence à la somme des scores TP de classe de l'ensemble de données, qui est calculée en décomposant la matrice de confusion en une matrice un contre tous correspondant à chaque classe.

Sample Weighted F1 Score

Le score Fβ est une version générique du score F1. Il calcule la moyenne harmonique, tout comme le score F1, mais donne la priorité à la précision ou au rappel. "β" représente le coefficient de pondération, qui est un hyperparamètre défini par l'utilisateur et toujours supérieur à 0.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Qu'est-ce que l'intelligence artificielle, l'apprentissage automatique et l'apprentissage profond ?

- Les dix principaux concepts et technologies du machine learning en 2023

- Cas d'utilisation et applications des grilles de données dans l'IoT, l'intelligence artificielle et l'apprentissage automatique

- Apprentissage automatique pour la blockchain : les avancées les plus importantes et ce que vous devez savoir

- Comment utiliser le module scikit-learn pour l'apprentissage automatique dans Python 3.x