Maison >Périphériques technologiques >IA >Comprendre l'entropie croisée : quelle est son importance correspondante ?

Comprendre l'entropie croisée : quelle est son importance correspondante ?

- 王林avant

- 2024-01-23 09:54:091356parcourir

L'entropie quantifie l'incertitude d'un événement. En science des données, l'entropie croisée et la divergence KL sont liées à des distributions de probabilité discrètes et sont utilisées pour mesurer la similitude de deux distributions. Dans l'apprentissage automatique, la perte d'entropie croisée est utilisée pour évaluer la proximité d'une distribution prédite par rapport à la distribution réelle.

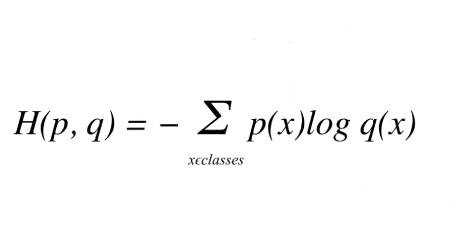

Étant donné la vraie distribution t et la distribution prédite p, l'entropie croisée entre elles est donnée par l'équation suivante :

où p(x) est la vraie distribution de probabilité (one-hot) et q(x) est Prédire la distribution de probabilité.

Cependant, dans le monde réel, la différence entre les valeurs prédites et réelles est appelée divergence car elles s'écartent de la valeur réelle. L'entropie croisée est une mesure combinée de l'entropie et de la divergence KL.

Voyons maintenant comment l'entropie croisée s'intègre dans le paradigme des réseaux neuronaux profonds à l'aide d'un exemple de classification.

Chaque cas de classification a une étiquette de classe connue avec une probabilité de 1,0 et les étiquettes restantes avec une probabilité de 0. Le modèle détermine la probabilité de chaque nom de catégorie en fonction du cas. L'entropie croisée peut être utilisée pour comparer les voies neuronales avec différentes étiquettes.

Comparez chaque probabilité de classe prédite à la sortie souhaitée de 0 ou 1. Le score/perte calculé pénalise la probabilité en fonction de l'éloignement de la valeur attendue. La pénalité est logarithmique, produisant des scores plus élevés pour les différences significatives proches de 1 et des scores plus faibles pour les petites différences proches de 0.

En utilisant la perte d'entropie croisée lors de l'ajustement des poids du modèle pendant l'entraînement, l'objectif est de minimiser la perte - plus la perte est petite, meilleur est le modèle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Explication détaillée de l'exploration du machine learning avec Python et Scikit-Learn

- Résumé des points de connaissances importants liés aux modèles de régression d'apprentissage automatique

- Bases de l'intelligence artificielle : introduction aux algorithmes courants dans l'apprentissage automatique

- Quelles sont les applications du machine learning ?