Maison >Périphériques technologiques >IA >Introduction à SqueezeNet et ses caractéristiques

Introduction à SqueezeNet et ses caractéristiques

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-01-22 19:15:161841parcourir

SqueezeNet est un algorithme petit et précis qui établit un bon équilibre entre haute précision et faible complexité, ce qui le rend idéal pour les systèmes mobiles et embarqués aux ressources limitées.

En 2016, des chercheurs de DeepScale, de l'Université de Californie, Berkeley et de l'Université de Stanford ont proposé un réseau neuronal convolutionnel (CNN) compact et efficace - SqueezeNet. Ces dernières années, les chercheurs ont apporté plusieurs améliorations à SqueezeNet, notamment SqueezeNet v1.1 et SqueezeNet v2.0. Les améliorations apportées aux deux versions augmentent non seulement la précision, mais réduisent également les coûts de calcul. SqueezeNet v1.1 améliore la précision de 1,4 % sur l'ensemble de données ImageNet, tandis que SqueezeNet v2.0 améliore la précision de 1,8 %. Dans le même temps, le nombre de paramètres dans ces deux versions est réduit de 2,4 fois. Cela signifie que SqueezeNet peut réduire la complexité des modèles et les besoins en ressources informatiques tout en conservant une grande précision. Grâce à sa conception compacte et à son fonctionnement efficace, SqueezeNet présente de grands avantages dans les scénarios avec des ressources informatiques limitées. Cela rend SqueezeNet idéal pour appliquer l’apprentissage profond aux appareils de pointe et aux systèmes embarqués. Grâce à une amélioration et une optimisation continues, SqueezeNet fournit une solution réalisable pour des tâches efficaces de classification d'images et de détection d'objets.

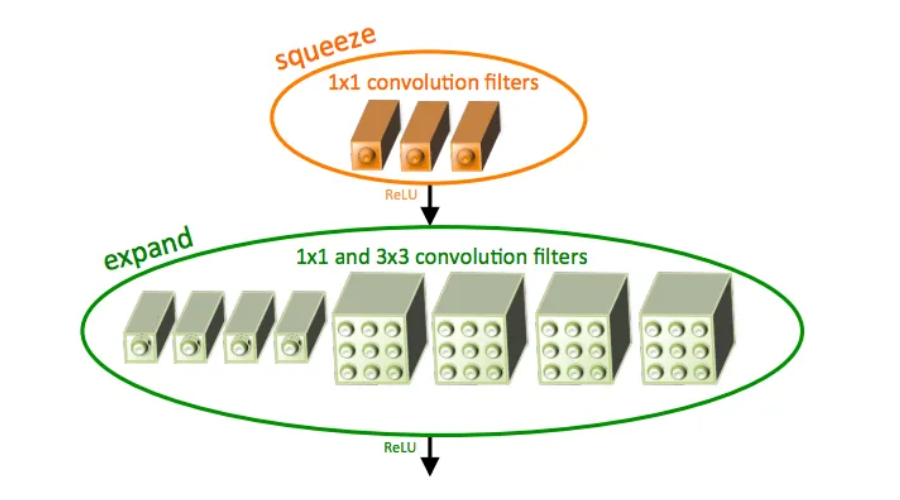

SqueezeNet utilise le module fire, un type spécial de couche convolutive qui intègre des filtres 1x1 et 3x3, réduisant efficacement le nombre de paramètres tout en maintenant une grande précision, ce qui le rend idéal pour les appareils aux ressources limitées. Il est capable d'obtenir des résultats très précis en utilisant seulement une fraction des ressources informatiques requises par les autres CNN.

Un avantage majeur de SqueezeNet est qu'il établit un équilibre entre précision et ressources informatiques. Par rapport à AlexNet, le nombre de paramètres de SqueezeNet est réduit de 50 fois et les exigences d'opérations en virgule flottante par seconde (FLOPS) sont réduites de 10 fois. Par conséquent, il est capable de fonctionner sur des appareils de pointe dotés de ressources informatiques limitées, tels que les téléphones mobiles et les appareils IoT. Cette efficacité rend SqueezeNet idéal pour l'apprentissage en profondeur dans des environnements aux ressources limitées.

SqueezeNet utilise une méthode appelée compression de canal, qui est l'une des principales innovations de cette technologie. En réduisant le nombre de canaux dans les couches convolutives du modèle, SqueezeNet réduit le coût de calcul du réseau tout en conservant la précision. En plus d'autres méthodes telles que les modules Fire et la compression profonde, SqueezeNet utilise également la compression de canal pour améliorer l'efficacité. Cette méthode peut réduire le nombre de paramètres du modèle en supprimant les canaux redondants, réduisant ainsi la quantité de calcul et améliorant la vitesse d'exécution du modèle. Cette méthode de compression de canaux réduit efficacement le coût de calcul du réseau tout en maintenant la précision du modèle, faisant de SqueezeNet un modèle de réseau neuronal léger et efficace.

SqueezeNet, contrairement à CNN traditionnel, ne nécessite pas beaucoup de puissance de calcul et peut être utilisé avec des extracteurs de fonctionnalités dans d'autres pipelines d'apprentissage automatique. Cela permet à d'autres modèles de bénéficier des fonctionnalités apprises par SqueezeNet, ce qui se traduit par des performances supérieures sur les appareils mobiles.

SqueezeNet est reconnu pour son innovation architecturale et son amélioration éprouvée des performances, et a été largement adopté par d'autres architectures CNN.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- algorithme de réseau neuronal artificiel

- Qu'est-ce qu'un algorithme de réseau de neurones artificiels ?

- Comment implémenter un algorithme de réseau neuronal artificiel en PHP

- Intelligence artificielle : Introduction à la connaissance des scénarios d'application des réseaux de neurones artificiels

- Comment écrire des algorithmes de réseaux de neurones artificiels en Python ?