Maison >Périphériques technologiques >IA >HuggingFace : Deux alpagas sont assemblés après avoir retiré leur tête et leur queue

HuggingFace : Deux alpagas sont assemblés après avoir retiré leur tête et leur queue

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2024-01-15 21:09:051381parcourir

La liste de classement des grands modèles open source HuggingFace a de nouveau été éliminée.

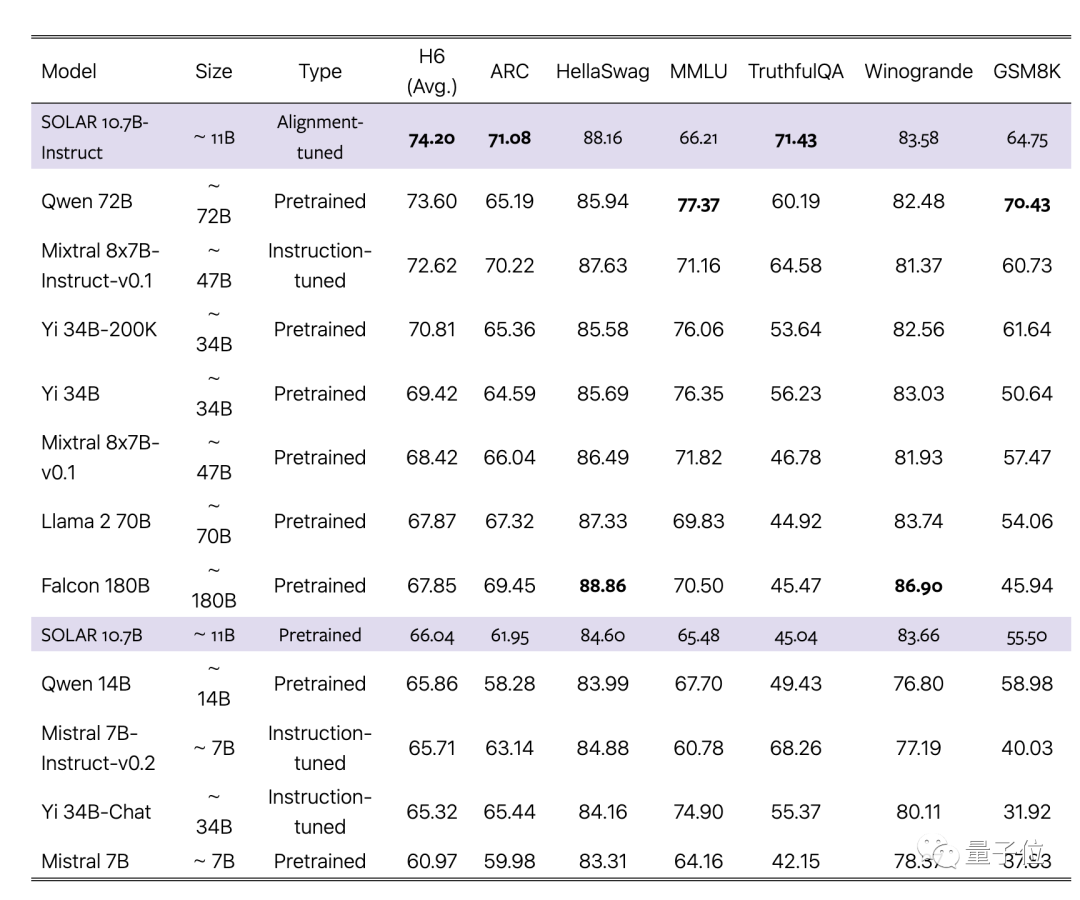

La première rangée est occupée exclusivement par la version peaufinée SOLAR 10.7B, évinçant les différentes versions peaufinées Mixtral 8x7B d'il y a quelques semaines.

Quelle est l'origine du grand modèle SOLAIRE ?

Un article connexe vient d'être téléchargé sur ArXiv, par la société coréenne Upstage AI, en utilisant une nouvelle méthode d'expansion de grand modèle augmentation de la profondeur (DUS).

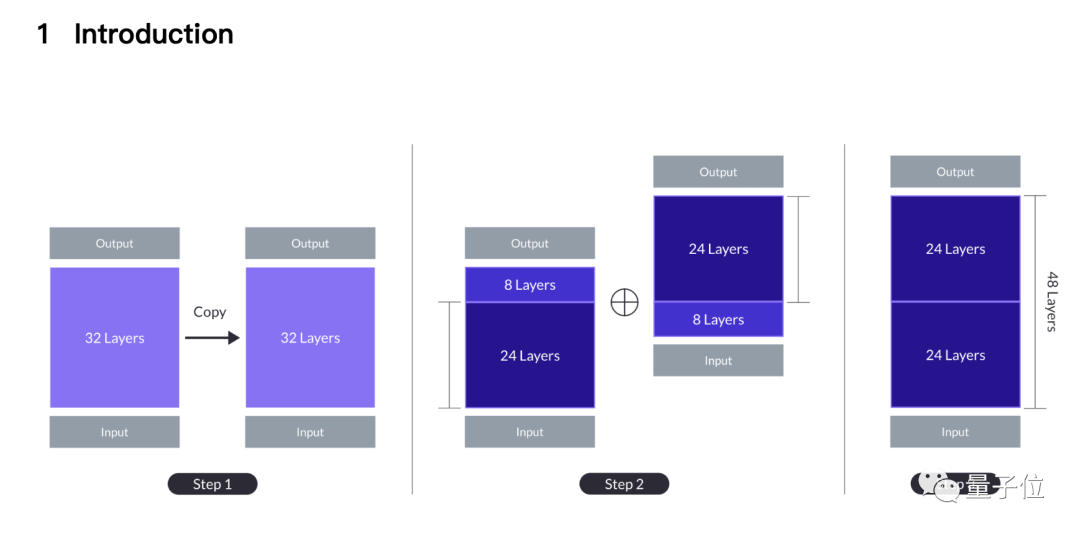

Pour faire simple, deux alpagas 7B sont pincés ainsi que leur queue, l'un est coupé les 8 premières couches, et l'autre est coupé les 8 dernières couches.

Les deux 24 couches restantes sont cousues ensemble La 24ème couche du premier modèle est épissée avec la 9ème couche du deuxième modèle, et devient finalement un nouveau grand modèle 10,7B à 48 couches.

Le document affirme que la nouvelle méthode surpasse les méthodes d'extension traditionnelles telles que le MoE et peut utiliser exactement la même infrastructure que le grand modèle de base.

Il n'est pas nécessaire de modules supplémentaires tels que les réseaux fermés, le cadre de formation est optimisé pour MoE et il n'est pas nécessaire de personnaliser les noyaux CUDA pour une inférence rapide. Il peut être intégré de manière transparente aux méthodes existantes tout en conservant l'efficacité.

L'équipe a choisi le Mistral 7B, le grand modèle unique le plus résistant du 7B, comme matériau de base, et a utilisé de nouvelles méthodes pour l'assembler afin de surpasser la version originale et la version MoE.

Dans le même temps, la version Instruct alignée surpasse également la version MoE Instruct correspondante.

Réaliser la couture jusqu'au bout

Pourquoi cette méthode d'épissage ? L'introduction dans l'article vient d'une intuition.

Commencez par la méthode d'expansion la plus simple, qui consiste à répéter deux fois le grand modèle de base à 32 couches pour en faire 64 couches.

L'avantage est qu'il n'y a pas d'hétérogénéité, toutes les couches sont du grand modèle de base, mais les couches 32 et 33 (identique à la couche 1) ont des " couches plus grandes au niveau des coutures Distance” (distance des couches ).

Des recherches antérieures ont montré que différentes couches de Transformer font des choses différentes. Par exemple, les couches plus profondes sont plus efficaces pour traiter des concepts plus abstraits.

L'équipe estime qu'une distance excessive entre les couches peut entraver la capacité du modèle à utiliser efficacement les poids pré-entraînés.

Une solution potentielle est de sacrifier la couche intermédiaire, réduisant ainsi la différence au niveau des coutures, et c'est là qu'est née la méthode DHS.

Sur la base du compromis entre performances et taille du modèle, l'équipe a choisi de supprimer 8 couches de chaque modèle, et les coutures sont passées de 32 couches à la couche 1 à 24 couches à la couche 9.

Les performances du modèle simplement épissé seront toujours inférieures à celles du modèle de base d'origine au début, mais il peut récupérer rapidement après un pré-entraînement continu.

Dans la phase de mise au point des instructions, en plus d'utiliser des ensembles de données open source, nous avons également créé des ensembles de données mathématiquement améliorés et utilisé DPO dans la phase d'alignement.

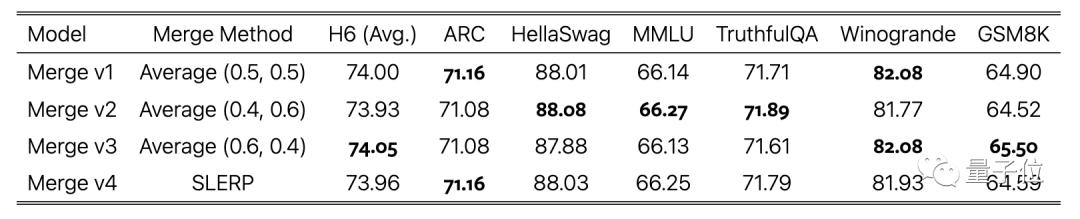

La dernière étape consiste à pondérer la moyenne des versions de modèles entraînées à l'aide de différents ensembles de données, ce qui constitue également l'achèvement de l'assemblage.

Certains internautes ont remis en question la possibilité d'une fuite de données de test. L'équipe

a également pris cela en considération et a spécifiquement rapporté les résultats des tests de pollution des données dans l'annexe du document, qui ont montré un faible niveau.

Enfin, le modèle de base SOLAR 10.7B et le modèle affiné sont open source sous la licence Apache 2.0.

Les internautes qui l'ont essayé ont signalé qu'il fonctionnait bien dans l'extraction de données à partir de données au format JSON.

Adresse papier : https://arxiv.org/abs/2312.15166

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quels sont les modèles logiques couramment utilisés dans les bases de données ?

- Quels sont les quatre modèles courants de développement de logiciels ?

- Comment l'IA déplace-t-elle les graphiques ?

- Quels sont les modèles courants de développement de logiciels ?

- Quelle est la différence entre Apple Mac Air et Pro