Maison >Périphériques technologiques >IA >Nouvelle solution BEV LV Fusion : Lift-Attend-Splat au-delà de BEVFusion

Nouvelle solution BEV LV Fusion : Lift-Attend-Splat au-delà de BEVFusion

- PHPzavant

- 2024-01-13 22:45:07765parcourir

Papier : Méthode Lift-Attend-Splat pour la caméra à vue d'oiseau et la fusion lidar utilisant la technologie Transformer

Veuillez cliquer sur le lien pour afficher le fichier : https://arxiv.org/pdf/2312.14919.pdf

Pour des raisons de sécurité- applications critiques telles que la conduite autonome Il est crucial de combiner des modalités de capteurs complémentaires. Les méthodes récentes de fusion caméra-lidar de conduite autonome utilisent l'estimation de la profondeur monoculaire pour améliorer la perception, mais il s'agit d'une tâche difficile par rapport à l'utilisation directe des informations de profondeur du lidar. Notre étude révèle que cette approche n’exploite pas pleinement les informations de profondeur et démontre qu’améliorer naïvement l’estimation de la profondeur n’améliore pas les performances de détection d’objets. Étonnamment, la suppression complète de l'estimation de la profondeur ne dégrade pas les performances de détection d'objets

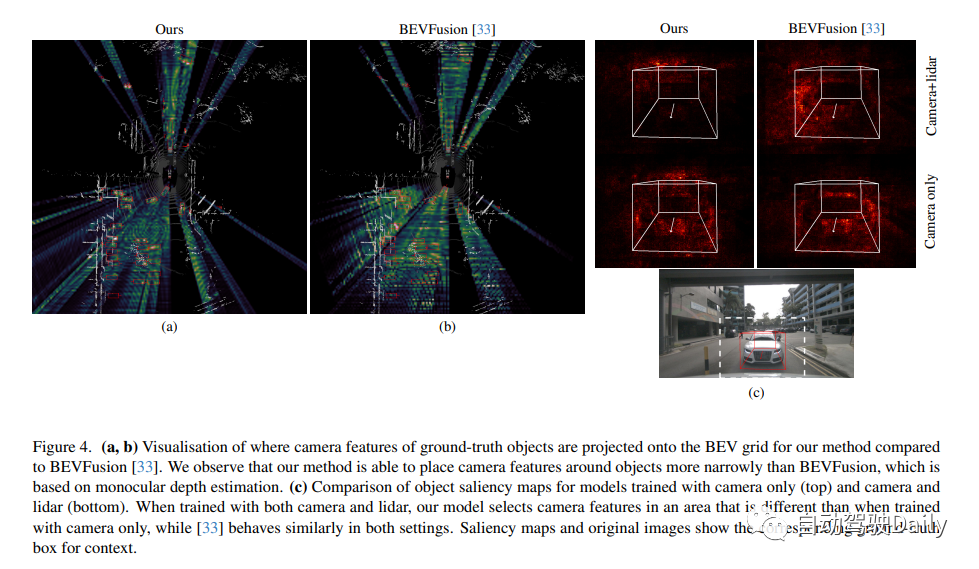

Cela suggère que le recours à la profondeur monoculaire peut être un goulot d'étranglement architectural inutile lors de la fusion caméra-lidar. Cette étude propose une nouvelle méthode de fusion qui contourne complètement l’estimation de profondeur monoculaire et utilise à la place un mécanisme d’attention simple pour sélectionner et fusionner les fonctionnalités de caméra et de lidar dans une grille BEV. Les résultats montrent que le modèle proposé est capable d'ajuster son utilisation des fonctionnalités de la caméra en fonction de la disponibilité des fonctionnalités lidar et a de meilleures performances de détection 3D sur l'ensemble de données nuScenes que les modèles de base basés sur l'estimation de la profondeur monoculaire

Introduction à cette étude Une nouvelle caméra -La méthode de fusion lidar appelée "Lift Attented Splat" a été développée. Cette méthode évite l’estimation de la profondeur monoculaire et utilise à la place un simple transformateur pour sélectionner et fusionner les fonctionnalités de caméra et de lidar dans BEV. Les expériences prouvent que par rapport aux méthodes basées sur l'estimation de la profondeur monoculaire, cette méthode de recherche peut mieux utiliser les caméras et améliorer les performances de détection des objets. Les apports de cette étude sont les suivants :

- La méthode de fusion caméra-lidar basée sur le paradigme Lift Splat n'exploite pas la profondeur comme prévu. En particulier, nous montrons qu’ils fonctionnent aussi bien, voire mieux, si la prédiction monoculaire de la profondeur est complètement supprimée.

- Cet article présente une nouvelle méthode de fusion caméra-lidar qui utilise un mécanisme d'attention simple pour fusionner les fonctionnalités de la caméra et du lidar dans un BEV pur. L'article démontre qu'il peut mieux utiliser les caméras et améliorer les performances de détection 3D par rapport aux modèles basés sur le paradigme Lift Splat.

Introduction à la structure principale

La précision de la prédiction de la profondeur est généralement faible. Des analyses qualitatives et quantitatives peuvent être effectuées en comparant la qualité de profondeur prédite par BEVFusion avec des cartes de profondeur lidar en utilisant l'erreur relative absolue (Abs.Rel.) et l'erreur quadratique moyenne (RMSE). Comme le montre la figure 1, la prédiction de profondeur ne reflète pas avec précision la structure de la scène et est significativement différente de la carte de profondeur lidar, ce qui indique que la profondeur monoculaire n'est pas pleinement utilisée comme prévu. L’étude a également révélé que l’amélioration de la prédiction de la profondeur n’améliore pas les performances de détection des objets ! La suppression complète de la prédiction de profondeur n'a aucun impact sur les performances de détection d'objets

Nous proposons une méthode de fusion caméra-lidar qui contourne complètement l'estimation de profondeur monoculaire et utilise à la place un simple transformateur pour fusionner dans une vue à vol d'oiseau les fonctionnalités de la caméra et du lidar. Cependant, en raison du grand nombre de fonctionnalités de caméra et de lidar et de la nature quadratique de l’attention, l’architecture du transformateur est difficile à appliquer simplement au problème de fusion caméra-lidar. Lors de la projection des éléments de la caméra dans BEV, la géométrie du problème peut être utilisée pour limiter considérablement la portée de l'attention, puisque les éléments de la caméra ne doivent contribuer qu'à la position le long de leurs rayons correspondants. Nous appliquons cette idée au cas de la fusion caméra-lidar et introduisons une méthode de fusion simple qui utilise l'attention croisée entre les colonnes du plan de la caméra et les rayons polaires de la grille lidar BEV ! Au lieu de prédire la profondeur monoculaire, l'attention croisée apprend quelles caractéristiques de la caméra sont les plus saillantes dans le contexte fourni par les caractéristiques lidar le long de leurs rayons

Notre modèle a une architecture globale similaire aux méthodes basées sur le paradigme Lift Splat, en plus de projeter les caractéristiques de la caméra. en BEV. Comme le montre la figure ci-dessous, il se compose d'une caméra et d'une structure lidar, d'un module qui génère indépendamment chaque fonctionnalité modale, d'un module de projection et de fusion qui intègre les fonctionnalités de la caméra dans le BEV et les fusionne avec le lidar, et d'une tête de détection. Lors de la détection de cible, le résultat final du modèle correspond aux attributs de la cible dans la scène, y compris les informations de position, de dimension, de direction, de vitesse et de classification, représentés sous la forme d'un cadre de délimitation 3D

Lift Attented Splat camera lidar fusion l'architecture est présentée ci-dessous. (À gauche) Architecture globale : les fonctionnalités de la caméra et du backbone lidar sont fusionnées avant d'être transmises à la tête de détection. (encadré) La géométrie de notre projection 3D : l'étape « Lift » intègre les caractéristiques lidar BEV dans l'horizon projeté en utilisant un échantillonnage bilinéaire pour soulever les caractéristiques lidar le long de la direction z. L'étape « splat » correspond à la transformation inverse, car elle utilise un échantillonnage bilinéaire pour projeter les caractéristiques de l'horizon projeté vers la grille BEV, toujours dans la direction z ! À droite se trouvent les détails du module projet.

Résultats expérimentaux

Lien original : https://mp.weixin.qq.com/s/D7xgvrp8633S2SeUfCRFXQ

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quelles sont les couches du modèle de référence TCP/IP ?

- Qu'est-ce qu'un modèle de développement logiciel et quels sont les modèles de développement logiciels courants ?

- Quelle unité représente la mémoire dans le modèle informatique de von Neumann ?

- Le routage est la fonction principale de quelle couche dans le modèle osi

- Comment développer la conduite autonome et l'Internet des véhicules en PHP ?