Maison >Périphériques technologiques >IA >Partage de brevets Microsoft pour une transition transparente entre la 2D et la 3D dans les réunions à distance Metaverse

Partage de brevets Microsoft pour une transition transparente entre la 2D et la 3D dans les réunions à distance Metaverse

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-12-27 10:54:271296parcourir

(Nwe le 26 décembre 2023) Le développement des réunions à distance favorise la vulgarisation du Metaverse. Cependant, les applications de réunion en ligne actuelles sont confrontées à un problème majeur lors de l'utilisation de méta-environnements, à savoir que tous les participants n'utilisent pas le même type d'appareil. Par exemple, certains utilisateurs utilisent des PC pour fonctionner, tandis que d'autres utilisent des casques de réalité virtuelle

Les utilisateurs d'ordinateurs de bureau sont parfois désavantagés car ils ne peuvent pas naviguer ou interagir avec tous les utilisateurs dans l'environnement virtuel. Bien qu'un ordinateur fournisse une vue 2D d'un environnement 3D, l'ordinateur est limité dans la manière dont il reçoit les gestes d'entrée de l'utilisateur pour naviguer ou interagir avec l'environnement 3D.

Du point de vue actuel, bien que la technologie se développe rapidement, l'expérience des utilisateurs de casques VR et des utilisateurs de PC n'est pas la même. De plus, qu'il s'agisse de passer d'un casque VR à un appareil de bureau ou vice versa, les systèmes existants ne permettent pas une transition transparente lors d'événements tels que des fêtes ou des réunions d'entreprise

Une méthode de transition transparente associée est détaillée dans une demande de brevet Microsoft intitulée "Rendu des transitions 2D et 3D dans les sessions de communication engagées par l'utilisateur"

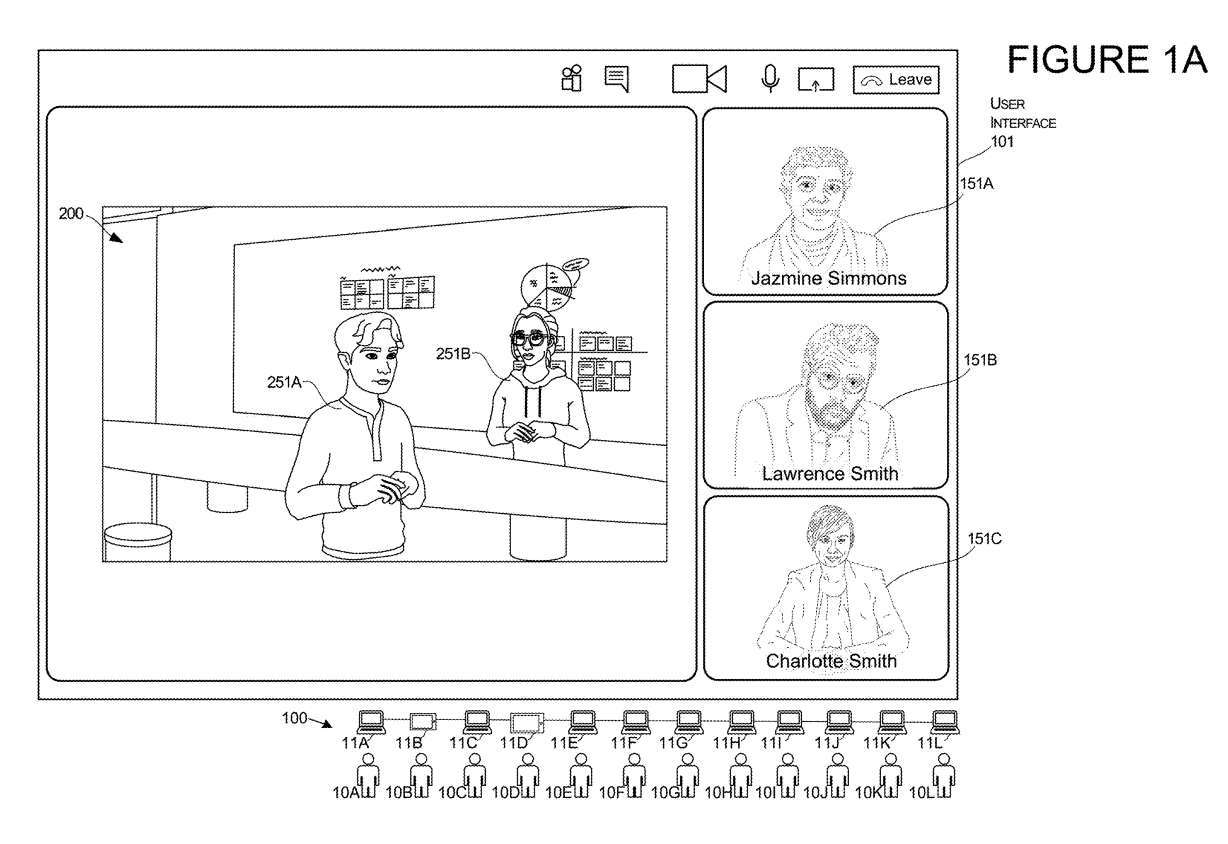

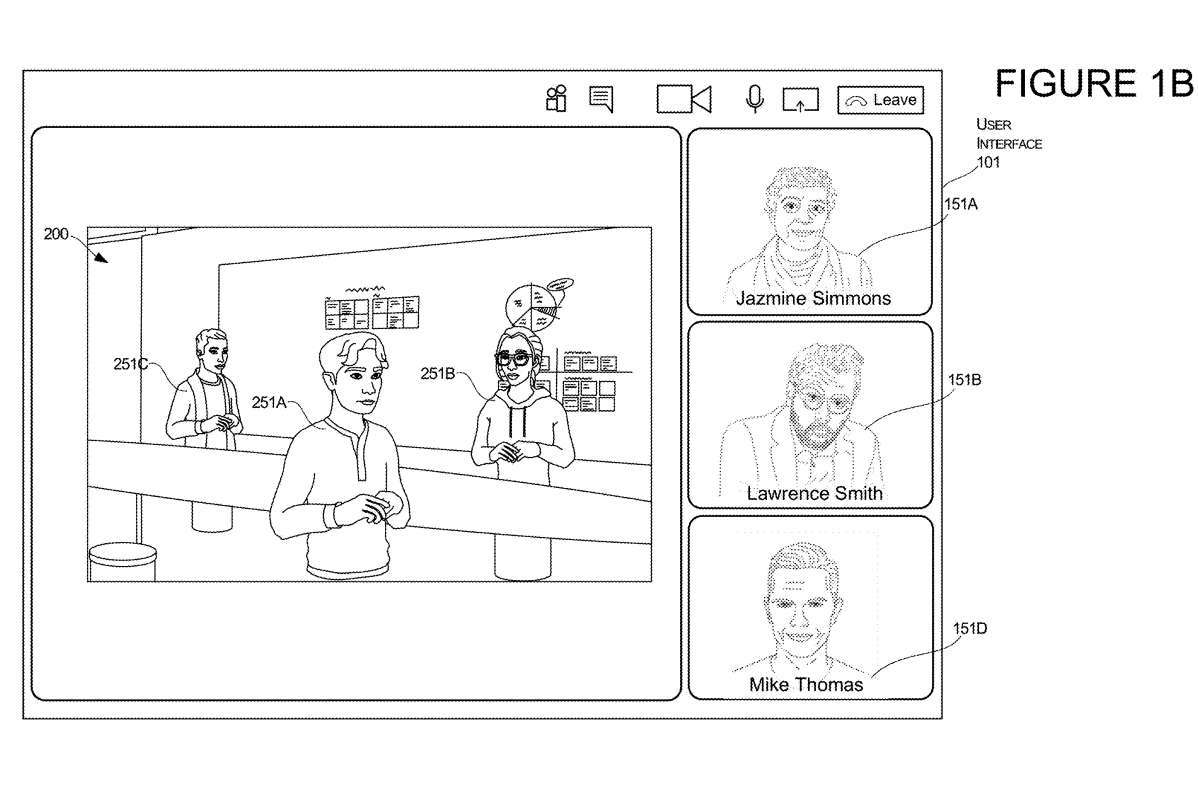

Les figures 1A et 1B illustrent la transition d'un agencement d'interface utilisateur de l'affichage d'une image bidimensionnelle de l'utilisateur à la présentation d'une représentation tridimensionnelle de l'utilisateur pendant que l'utilisateur est engagé dans une session de communication.

La session de communication peut être gérée par un système 100 composé de plusieurs ordinateurs 11, chaque ordinateur 11 correspondant à une pluralité d'utilisateurs 10. Dans cet exemple, la présentation du troisième utilisateur 10C subira une conversion du mode 2D au mode 3D.

Pour lancer une transition, le système peut recevoir une entrée pour provoquer une transition d'affichage du rendu d'image 2D d'un utilisateur spécifique. Dans cet exemple, l'entrée identifie le troisième utilisateur 10C. Cette entrée peut également fournir l'autorisation de permettre au système d'accéder au modèle 3D définissant l'emplacement et l'orientation du troisième utilisateur 10C. Ces positions et directions peuvent inclure des vecteurs et des coordonnées représentés dans l'environnement 3D 200, appelé ici environnement virtuel 200

En réponse à la réception d'une entrée, un ou plusieurs ordinateurs du système 100 peuvent apporter des modifications à l'interface utilisateur 101 pour supprimer le rendu de l'image 151C pour l'utilisateur 10C comme le montre la figure 1A et pour ajouter l'utilisateur comme le montre la figure 1B. La représentation 3D de le 10C est le rendu du 251C. La présentation de la représentation 3D 251C de l'utilisateur 10C peut être positionnée et orientée dans l'environnement 3D en fonction des coordonnées et/ou des vecteurs définis dans le modèle 3D.

Dans cet exemple, le rendu de l'image 2D de l'utilisateur 10C a été supprimé et peut ensuite être remplacé par un autre rendu. Par exemple, le rendu d'image 2D du troisième utilisateur 10C représenté sur la figure 1A est remplacé dans l'interface utilisateur par une autre image 2D d'un autre utilisateur, le quatrième utilisateur 10D représenté sur la figure 1B.

Cette transformation permet aux utilisateurs d'interagir avec les appareils informatiques de différentes manières. Par exemple, dans cet exemple, si l'utilisateur 10C souhaite passer du streaming vidéo en direct dans une session de communication à un autre mode de fonctionnement permettant à l'utilisateur d'interagir avec d'autres utilisateurs dans un environnement 3D, le système fera passer l'utilisateur d'un mode Switch vers un autre mode, lui permettant d'interagir avec du contenu général, des documents, des feuilles de calcul et des diapositives, vers un mode qui lui permet d'interagir avec des objets 3D

Cette transition lors des sessions de communication permet aux utilisateurs sélectionnés d'utiliser des outils d'édition adaptés aux différents types de contenus dans chaque environnement. Par exemple, si une personne dans un flux vidéo souhaite quitter le mode 2D en utilisant des images 2D présentées à l'utilisateur et entrer dans un environnement 3D pour montrer à d'autres utilisateurs comment déplacer des objets dans des emplacements spécifiques ou façonner des objets 3D spécifiques, alors une fois que l'utilisateur est En effectuant le changement, ils peuvent le faire plus facilement.

Les utilisateurs peuvent effectuer cette conversion à l'aide d'un ordinateur de bureau sans utiliser aucun type de casque XR. Cette transformation utilisant le bureau permet à l'utilisateur d'utiliser l'ordinateur de bureau pour entrer dans un mode d'interaction 3D avec l'environnement informatique 3D, qui peut être plus adapté à l'édition ou à la visualisation de certains types de contenu.

Microsoft a souligné que l'un des avantages techniques est que le système peut permettre aux utilisateurs de basculer entre le mode 3D et le mode 2D de la session de communication, quel que soit le matériel avec lequel ils interagissent.

La technologie mentionnée dans l'invention est également applicable aux visiocasques. Dans de tels modes de réalisation, l'utilisateur peut continuer à utiliser un seul dispositif informatique, tel qu'un visiocasque, tout en faisant passer le modèle interactif d'un environnement informatique 3D à un environnement informatique 2D. Par conséquent, un utilisateur peut se lancer dans un environnement informatique 3D et être représenté par une présentation de la représentation 3D 251C, telle que la représentation représentée sur la figure 1B.

Ensuite, en réponse à une ou plusieurs entrées, telles qu'un utilisateur commençant à modifier du contenu avec un type de fichier spécifique, ou en fonction d'une entrée indiquant l'intention d'effectuer une transformation de l'interface utilisateur, le système peut transformer l'interface utilisateur pour supprimer le rendu de l'interface utilisateur. Représentation 3D 251C, comme le montre la figure 1B, et Une représentation de l'image 2D 151C de l'utilisateur est générée, telle que la représentation montrée sur la figure 1A. Cela permet aux utilisateurs de passer à un environnement 2D sans réellement utiliser un appareil de bureau utilisant un écran plat et un clavier.

Les figures 2A et 2B illustrent un autre exemple de transition d'une interface utilisateur d'un affichage avec une image bidimensionnelle de l'utilisateur à une présentation d'une représentation tridimensionnelle de l'utilisateur lorsque l'utilisateur est engagé dans une session de communication.

Dans cet exemple, l'interface utilisateur 201 est une présentation d'un environnement 3D basé sur un modèle 3D. L'interface utilisateur 201 commence par un rendu 3D de la représentation 251A du premier utilisateur 10A et un rendu 3D de la représentation 251B du deuxième utilisateur 10B. Chaque rendu 3D représenté a une position et une orientation déterminées par les propriétés de l'objet virtuel stockées dans le modèle 3D

L'environnement 3D comprend également un objet virtuel 275 sous la forme d'un téléviseur virtuel à écran plat monté sur le mur de l'environnement virtuel. L'objet virtuel 275 possède une surface d'affichage qui affiche une interface utilisateur virtuelle qui affiche un rendu 2D 151C du troisième utilisateur 10C et un rendu 2D 151D du quatrième utilisateur 10D.

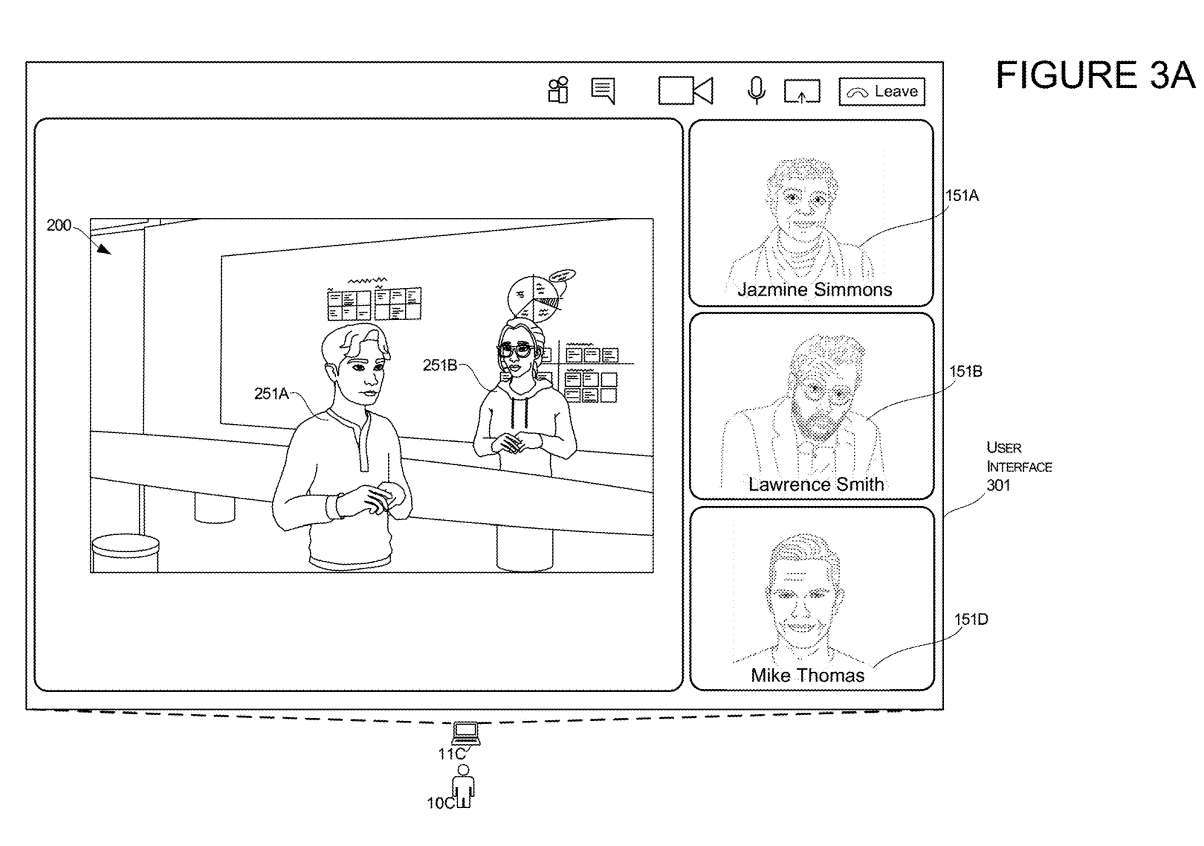

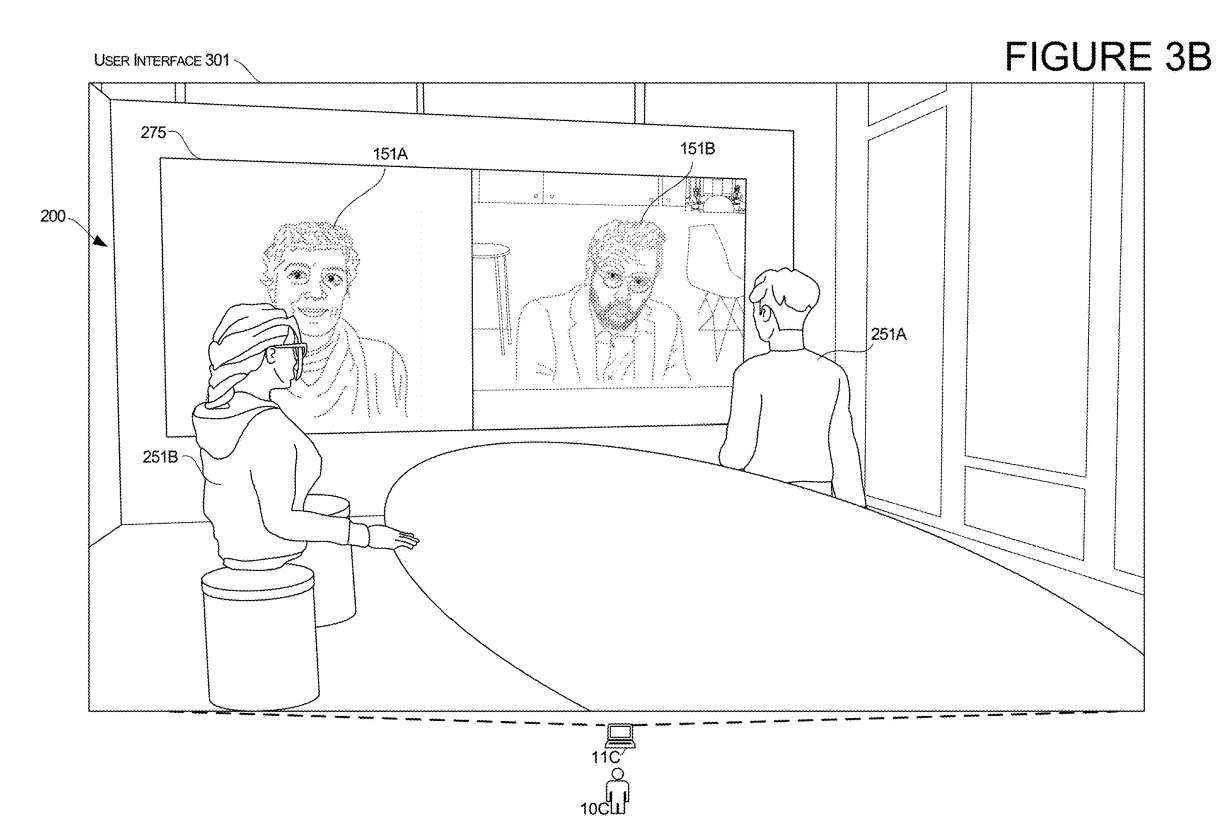

Les figures 3A et 3B illustrent un autre aspect de la conversion d'utilisateurs tiers. Dans cet exemple, la présentation du troisième utilisateur 10C subit une conversion du mode 2D vers le mode 3D.

Comme le montre la figure 3A, l'interface utilisateur 301 affiche d'abord les images bidimensionnelles de Jessamine, Lawrence et Mike, qui sont affichées sous forme de rendus des images 151A, 151B et 151D respectivement. L'interface utilisateur comprend simultanément une présentation de l'environnement 3D 200 avec deux représentations 3D 251A et 251B d'autres utilisateurs.

En réponse aux données d'entrée décrites dans cet article, le système effectue des transformations. Lors de la transition du troisième utilisateur, le troisième ordinateur 11C du troisième utilisateur 10C passe de l'interface utilisateur représentée sur la figure 3A à l'interface utilisateur représentée sur la figure 3B.

Après la conversion, l'ordinateur 11C de Charlotte affiche l'interface utilisateur modifiée 301, comme le montre la figure 3B. Le système conservera l'état de chaque utilisateur, tout comme la représentation tridimensionnelle des deux utilisateurs 251A et 251B illustrée sur la figure 3A, et maintiendra également la représentation tridimensionnelle de 251A et 251B illustrée sur la figure 3B

Également illustré sur la figure 3B, l'interface utilisateur modifiée 301 comprend un objet virtuel 275, dans ce cas un dispositif d'affichage virtuel, qui affiche un rendu 2D de l'autre utilisateur initialement affiché sous forme d'image 2D, comme dans la figure 3A Jessamine et Lawrence. .

Cette interface utilisateur 301 modifiée affiche désormais la perspective de Charlotte comme si elle s'était téléportée d'un environnement 2D vers un environnement 3D. Semblable aux autres exemples, dans cette téléportation, le système peut déterminer la position et la direction de l'Avatar Charlotte en fonction d'un ou plusieurs facteurs.

Dans un exemple comme celui-ci, Charlotte pourrait utiliser un appareil, tel qu'un PC. Ensuite, en réponse à une ou plusieurs entrées décrites ici, le système peut passer de l'interface utilisateur de la figure 3A à l'interface utilisateur de la figure 3B tout en continuant à utiliser l'ordinateur de bureau. Cet exemple de transition peut être réalisé même sans utiliser un casque traditionnellement utilisé pour visualiser des rendus 3D.

Dans un autre exemple, la transition pourrait impliquer Charlotte commençant par l'interface utilisateur de la figure 3B, puis passant à l'interface utilisateur de la figure 3A. Dans cet exemple, Charlotte peut utiliser un appareil distinct, tel qu'un visiocasque. Elle navigue d'abord dans l'environnement 3D représenté sur la figure 3B, puis en réagissant à une ou plusieurs entrées décrites dans cet article, le système peut passer de l'interface utilisateur de la figure 3B à l'interface utilisateur de la figure 3A et continuer à utiliser le casque. Cet exemple de conversion est possible même sans utiliser un ordinateur traditionnellement utilisé pour visualiser des images 2D

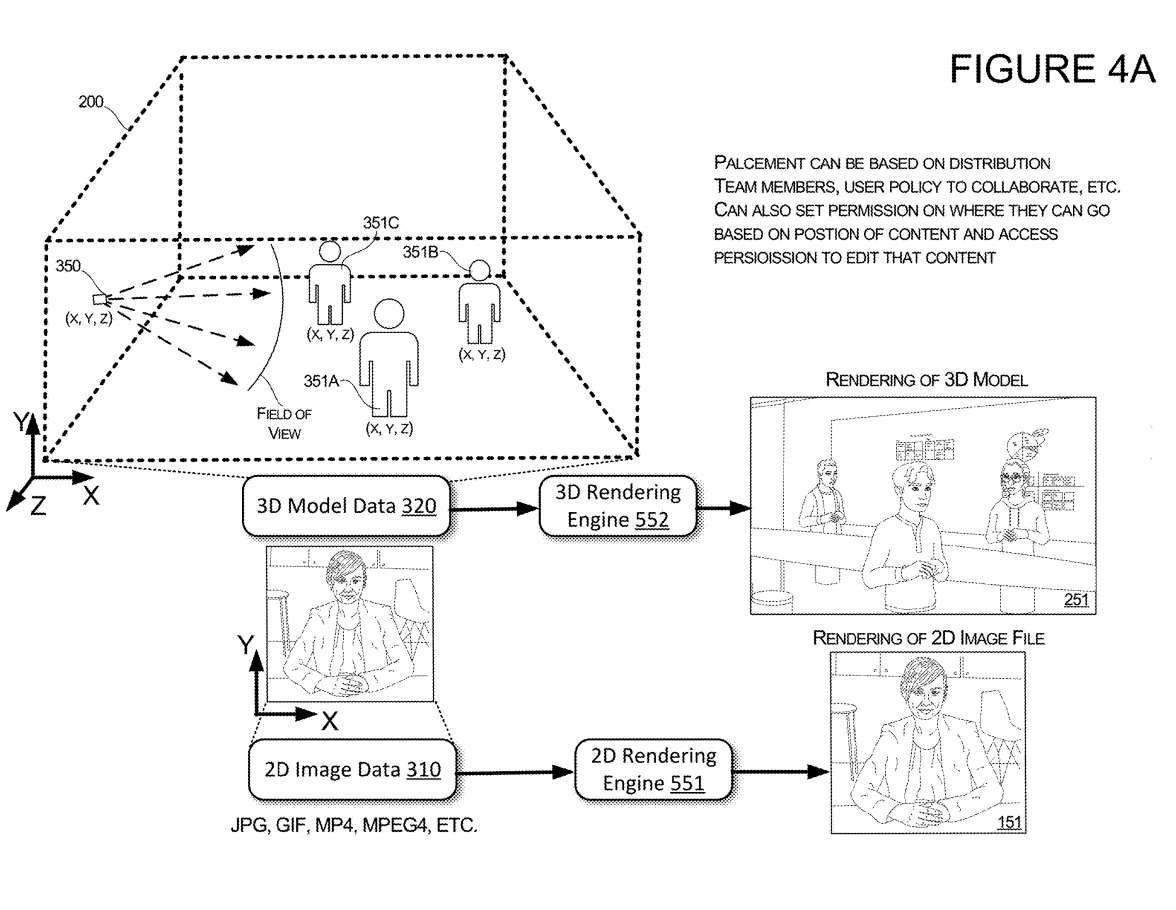

La figure 4A illustre d'autres fonctionnalités des transitions de l'interface utilisateur. Lors de la réception d'une entrée qui amène l'interface utilisateur à passer d'une présentation d'une image 2D de l'utilisateur 1OC à une présentation d'une représentation 3D de l'utilisateur 1OC, le système peut déterminer la position et l'orientation de la représentation 3D de l'utilisateur 1OC.

Par exemple, si un modèle commence avec seulement deux objets virtuels 351A et 351B représentant les utilisateurs dans l'environnement virtuel 200, alors le système peut déterminer la position et la direction de l'objet virtuel 351C nouvellement ajouté représentant l'utilisateur. Dans cet exemple, lorsque l'entrée indique un utilisateur particulier, tel qu'un troisième utilisateur 10C, le système peut déterminer l'emplacement de l'objet virtuel 351C représentant le troisième utilisateur 10C sur la base de l'emplacement d'autres utilisateurs dans l'environnement virtuel 200 et/ou de l'emplacement de l'utilisateur partagé. contenu. Localisation et direction

Dans un exemple illustratif, si le système détermine que l'objet virtuel 351C représentant le troisième utilisateur 10C doit être ajouté à l'environnement virtuel 200, le système peut positionner l'objet virtuel 351C de telle manière que l'objet virtuel 351C apparaisse à l'utilisateur. L'avatar est en train de visualiser contenu partagé avec l'utilisateur 10C.

Dans un autre exemple, si le système détermine que l'objet virtuel 351C représentant un troisième utilisateur 10C doit être ajouté à l'environnement virtuel 200, le système peut positionner l'objet virtuel 351C de manière à ce qu'il apparaisse comme l'avatar de l'utilisateur parlant à l'utilisateur. 10C

Dans un mode de réalisation, le placement de chaque objet virtuel 351 peut être basé sur une répartition parmi les membres de l'équipe, des groupes d'utilisateurs et/ou des politiques établies par des utilisateurs individuels ou des groupes d'utilisateurs. Par exemple, si une personne fait partie d'une équipe d'entreprise, lorsque l'une d'entre elles est identifiée en entrée dans l'interface utilisateur de transformation, son avatar correspondant sera positionné à une distance seuil des autres membres de l'équipe.

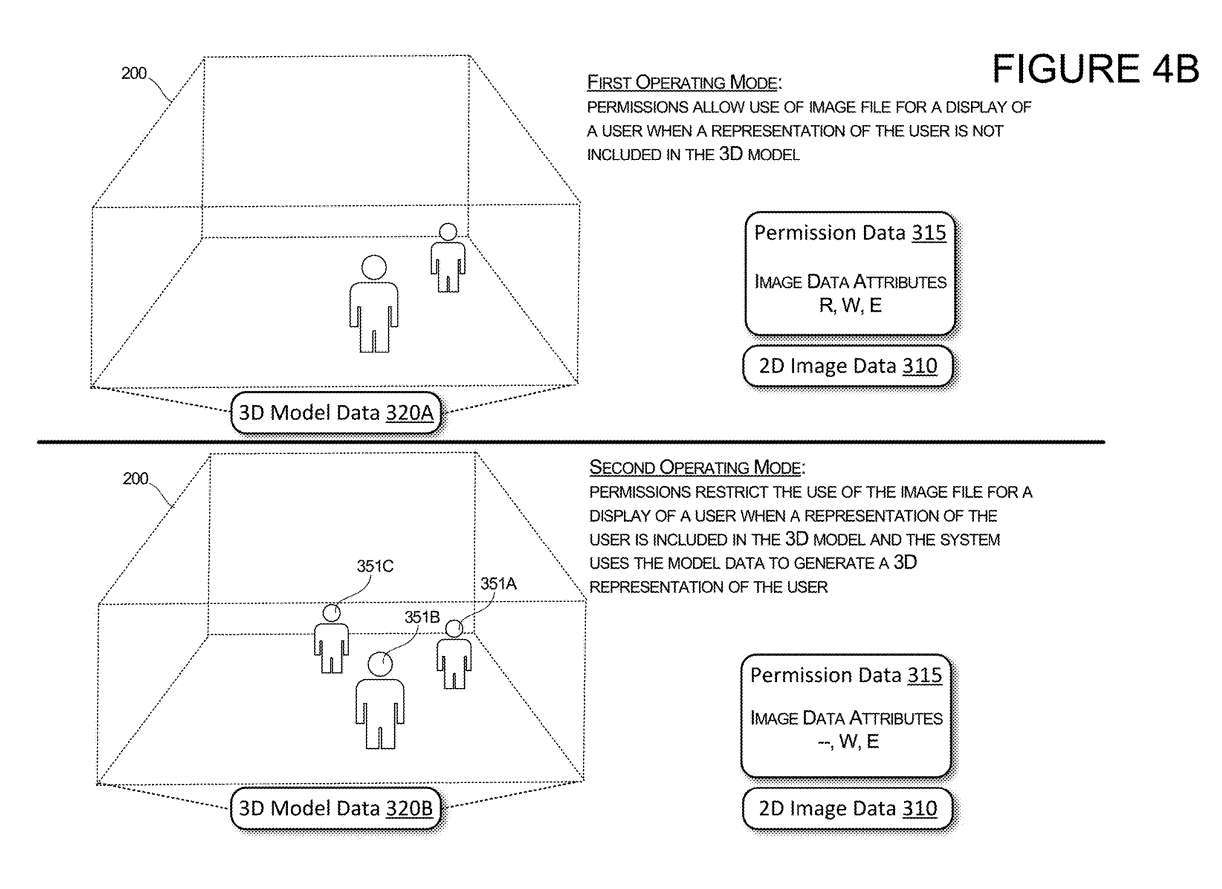

La figure 4B illustre les deux modes de fonctionnement du système et comment chaque mode de fonctionnement modifie les autorisations des individus participant à une session de communication. Dans un premier mode de fonctionnement en partie supérieure de la figure 4B, lorsqu'une représentation de l'utilisateur n'est pas incluse dans le modèle 3D, des autorisations peuvent permettre au système d'utiliser un fichier image pour afficher une image 2D de l'utilisateur.

Dans ce cas, les données du modèle 3D sont dans le premier état 320A, où l'utilisateur sélectionné n'a aucun objet virtuel représentant l'utilisateur dans l'environnement 3D 200. Lorsque le modèle 3D est dans cet état, l'utilisateur sélectionné n'a aucun objet virtuel représentant cet utilisateur dans l'environnement 3D et les données d'autorisation 315 associées à l'utilisateur sont configurées pour permettre au système et à d'autres utilisateurs d'accéder aux données d'image 310 de l'utilisateur. Cela signifie que le système et le client de chaque utilisateur distant peuvent utiliser les données d'image 310 pour générer la présentation de cet utilisateur, ou que le système peut éditer les données d'image 310.

Lorsque le système détecte que les données du modèle 3D sont dans le deuxième état, par exemple, les données du modèle 320B contiennent un objet virtuel 351C représentant l'utilisateur sélectionné, le système modifiera les autorisations pour limiter l'utilisation des données d'image par l'utilisateur spécifique. utilisateur. Comme le montre la figure, le système modifiera les données d'autorisation 315 pour empêcher le système de lire les données d'image 310 pour afficher l'image 2D de l'utilisateur spécifique. Dans ce mode de fonctionnement, les autorisations sont configurées pour restreindre l'accès aux données d'image à tous les utilisateurs, empêchant ainsi tous les clients d'accéder ou d'afficher des fichiers d'images 2D

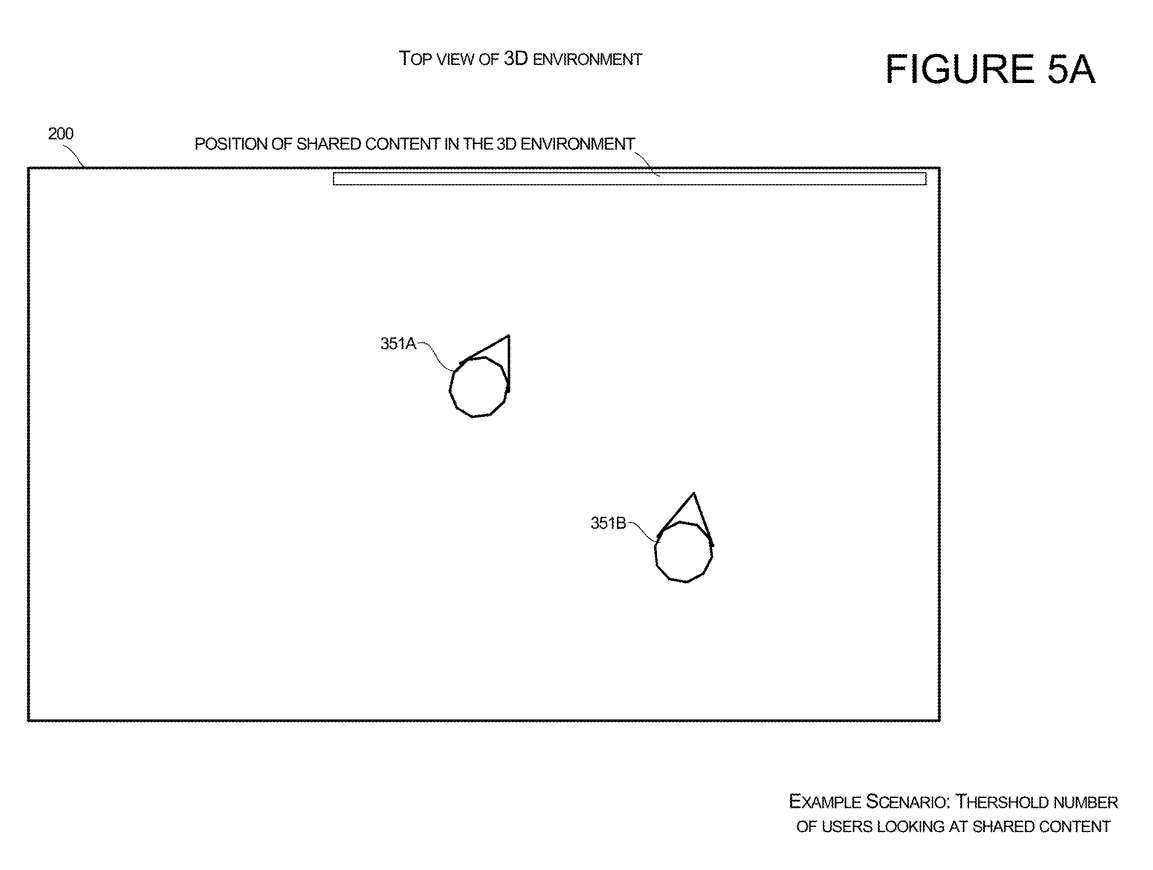

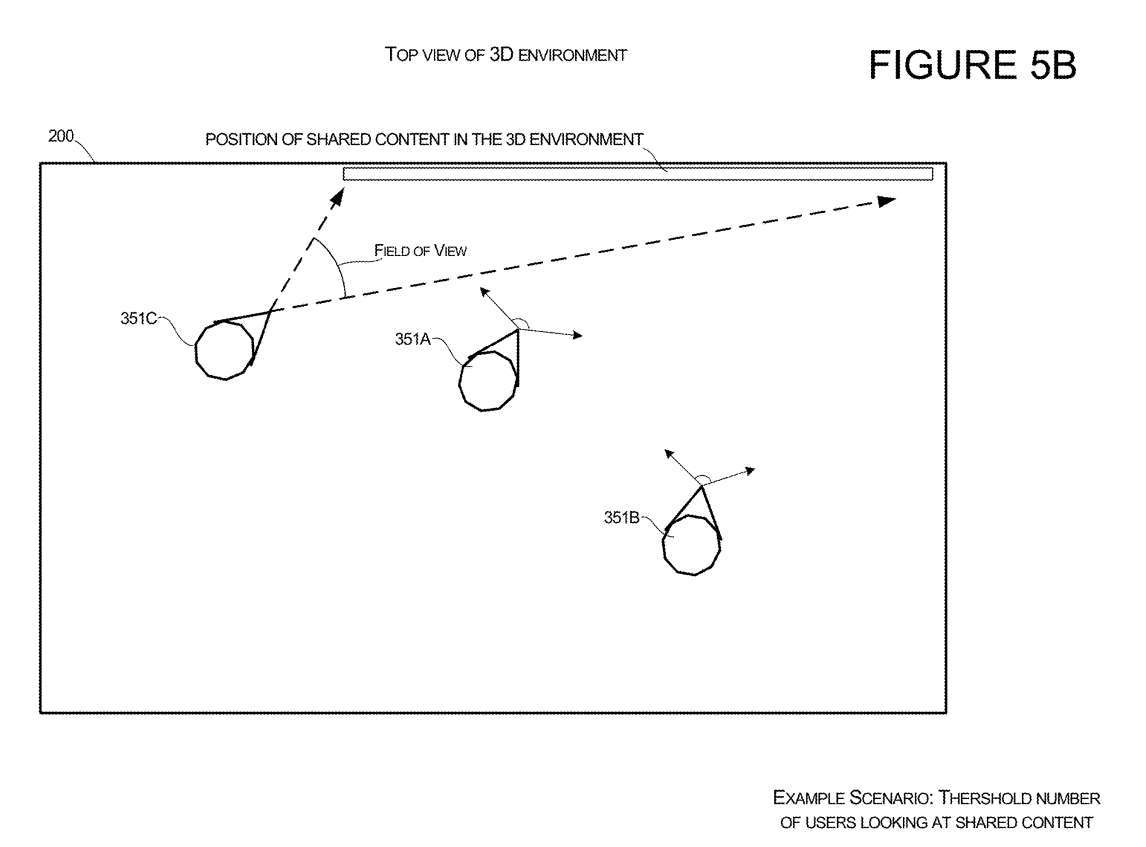

Les figures 5A et 5B illustrent les caractéristiques d'un système configuré pour localiser la représentation d'un utilisateur dans un environnement 3D 200 par rapport à un contenu partagé.

L'orientation de l'avatar pour un premier utilisateur 351A et un deuxième utilisateur 351B est illustrée sur la figure 5A pour un scénario de visualisation de contenu partagé dans un environnement 3D. Le contenu qu'ils partagent peut être affiché sur des objets virtuels, tels que des écrans virtuels. Lorsque le système détecte qu'un certain nombre d'utilisateurs consultent du contenu partagé, le système génère des instructions vers l'environnement 3D pour le troisième utilisateur avec Avatar

Un exemple de la fonctionnalitéest présenté à la figure 5B. Dans cet exemple, l'avatar du troisième utilisateur 351C est ajouté à l'environnement virtuel. L'avatar du troisième utilisateur 351C pointe vers le contenu partagé en réponse au système détectant que l'autre utilisateur a partagé le contenu dans son champ de vision. Le système peut également déterminer la géométrie du champ de vision de chaque personne et déterminer la position de l'avatar du troisième utilisateur afin que l'avatar du troisième utilisateur ne bloque pas le champ de vision des autres utilisateurs.

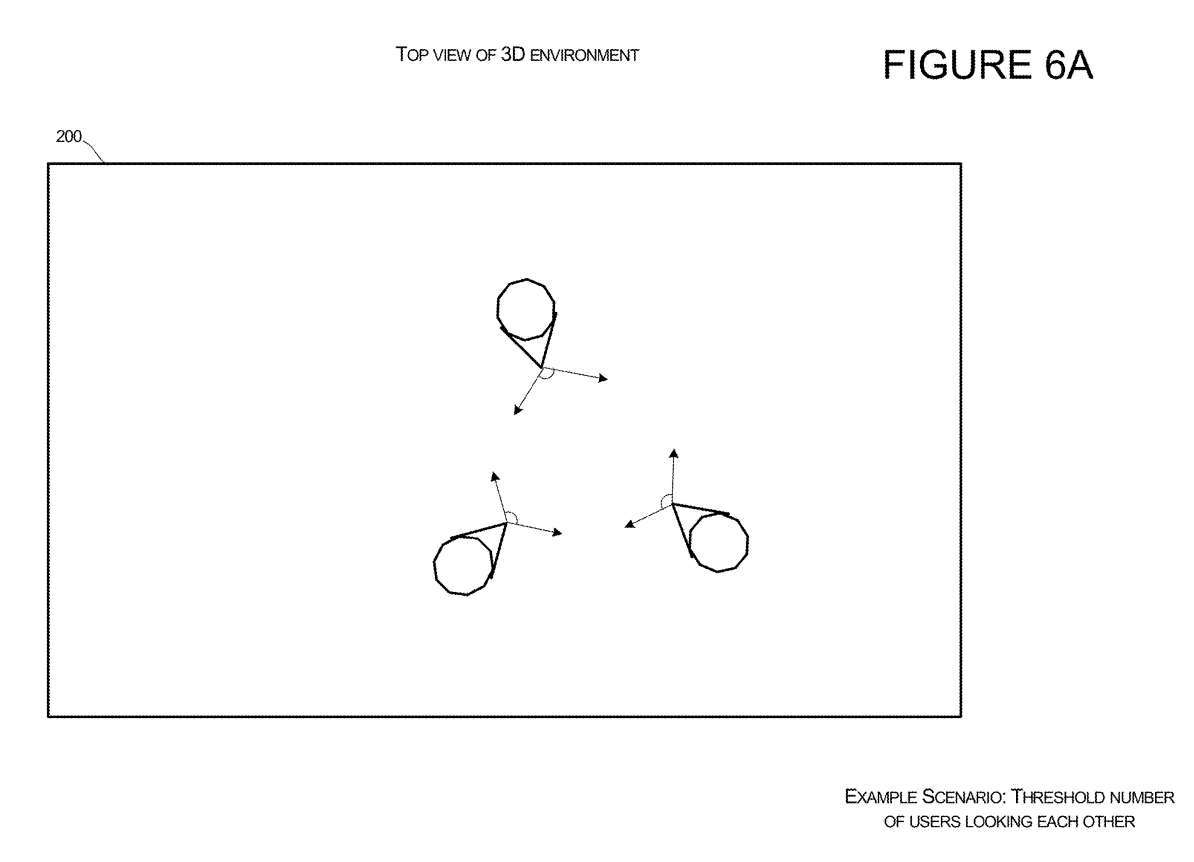

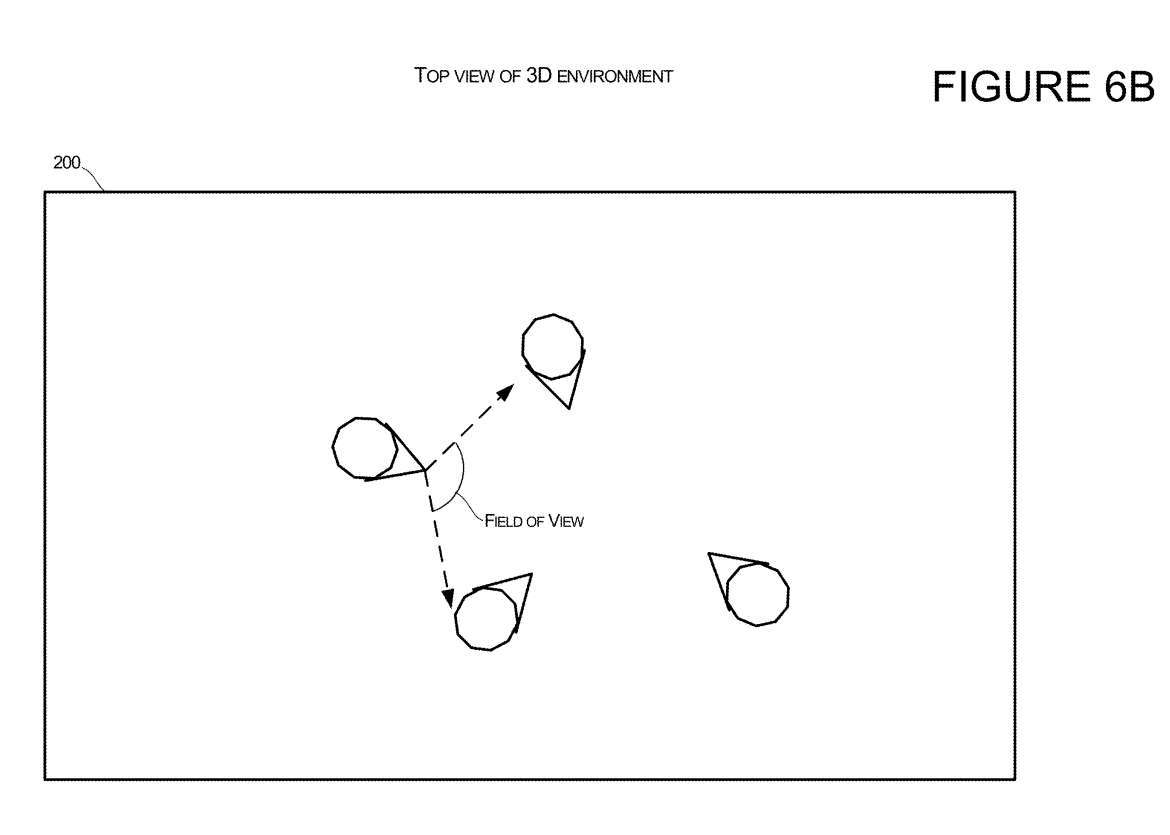

Les figures 6A et 6B illustrent des configurations configurées pour être positionnées par rapport à d'autres utilisateurs dans un environnement 3D 200. La figure 6A illustre un scénario dans lequel les avatars d'un premier utilisateur et d'un second utilisateur sont orientés de telle sorte que les utilisateurs se regardent dans l'environnement virtuel.

Dans une équipe spécifique ou un groupe prédéterminé, lorsque le système détermine qu'un certain nombre de personnes se regardent, le système peut positionner l'Avatar du troisième utilisateur entrant dans l'environnement de manière à ce que la position de l'Avatar soit tournée vers les autres utilisateurs. La figure 6A montre plusieurs avatars avec au moins trois utilisateurs avec d'autres membres du groupe dans le champ de vision. Lorsque le système détermine qu'un certain nombre seuil de personnages virtuels ont d'autres membres du groupe dans le champ de vision, comme le montre la figure 6B, le système peut permettre à de nouveaux membres du groupe de rejoindre l'environnement virtuel avec un emplacement et une orientation qui permettent à l'utilisateur de voir les autres membres du groupe.

Brevets associés : Brevet Microsoft | Transitions 2D et 3D pour les rendus des utilisateurs participant à des sessions de communication

La demande de brevet Microsoft intitulée « Transitions 2D et 3D pour les rendus des utilisateurs participant à des sessions de communication » a été initialement soumise en mai 2022 et a été récemment publiée par l'Office américain des brevets et des marques.

Il est à noter que, de manière générale, après examen d'une demande de brevet américain, elle sera automatiquement publiée 18 mois à compter de la date de dépôt ou de la date de priorité, ou elle sera publiée dans les 18 mois à compter de la date de dépôt à la demande du demandeur. Notez que la publication d'une demande de brevet ne signifie pas que le brevet est approuvé. Après le dépôt d’une demande de brevet, l’USPTO exige un véritable examen, qui peut prendre de 1 à 3 ans.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment résoudre le problème selon lequel l'ordinateur ne peut pas ouvrir la page Web et affiche le code d'erreur dns_probe_possible ?

- Comment utiliser le développement C++

- Quel logiciel est Microsoft OneDrive ?

- a2270 est la génération d'ipad

- Le Forum d'innovation et de développement du métaverse numérique du delta du fleuve Yangtze et la première journée du métaverse du delta du fleuve Yangtze se sont tenus avec succès dans l'oasis du delta du fleuve Yangtze Zhigu·Zhaoxiang.