Maison >Périphériques technologiques >IA >La CMU a mené une étude comparative détaillée et a constaté que GPT-3.5 est supérieur à Gemini Pro, garantissant des performances équitables, transparentes et reproductibles.

La CMU a mené une étude comparative détaillée et a constaté que GPT-3.5 est supérieur à Gemini Pro, garantissant des performances équitables, transparentes et reproductibles.

- PHPzavant

- 2023-12-21 08:13:381212parcourir

Quelle est la force de Google Gemini ? L'Université Carnegie Mellon a mené une comparaison professionnelle et objective par un tiers

Pour garantir l'équité, tous les modèles utilisent les mêmes invites et paramètres de génération, et fournissent un code reproductible et des résultats totalement transparents.

n'utilisera pas CoT@32 pour comparer 5 plans comme Conférence de presse officielle de Google.

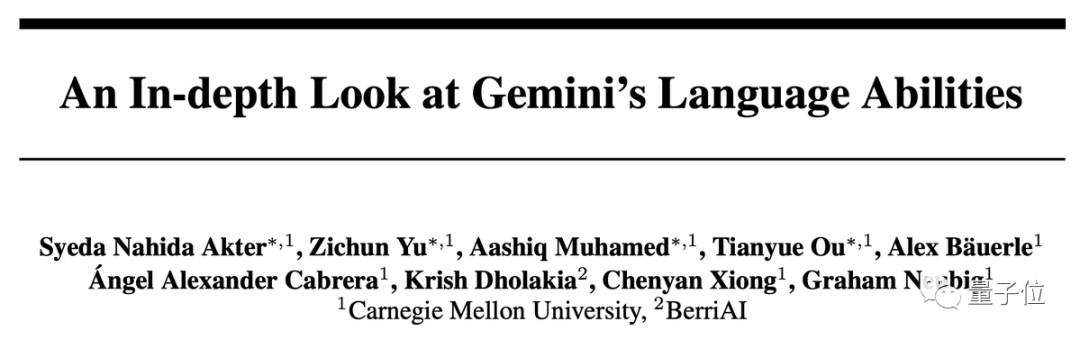

Résultats en une phrase : La version Gemini Pro est proche mais légèrement inférieure au GPT-3.5 Turbo, et GPT-4 est encore loin devant.

Dans l'analyse approfondie, nous avons également découvert des caractéristiques étranges des Gémeaux, telles que J'aime choisir D pour les questions à choix multiples...

De nombreux chercheurs ont déclaré que les Gémeaux a été mené de manière très détaillée quelques jours seulement après sa sortie. Il s'agit d'une réalisation très remarquable

Tests approfondis de six tâches principales

Ce test a comparé spécifiquement 6 tâches différentes et a sélectionné l'ensemble de données correspondant pour chaque tâche

- Question et réponse : MMLU

- Inférence : BIG-Bench Hard

- Math : GSM8k, SVAMP, ASDIV, MAWPS

- Code : HumanEval, ODEX

- Traduction : FLORES

- Surf : WebArena

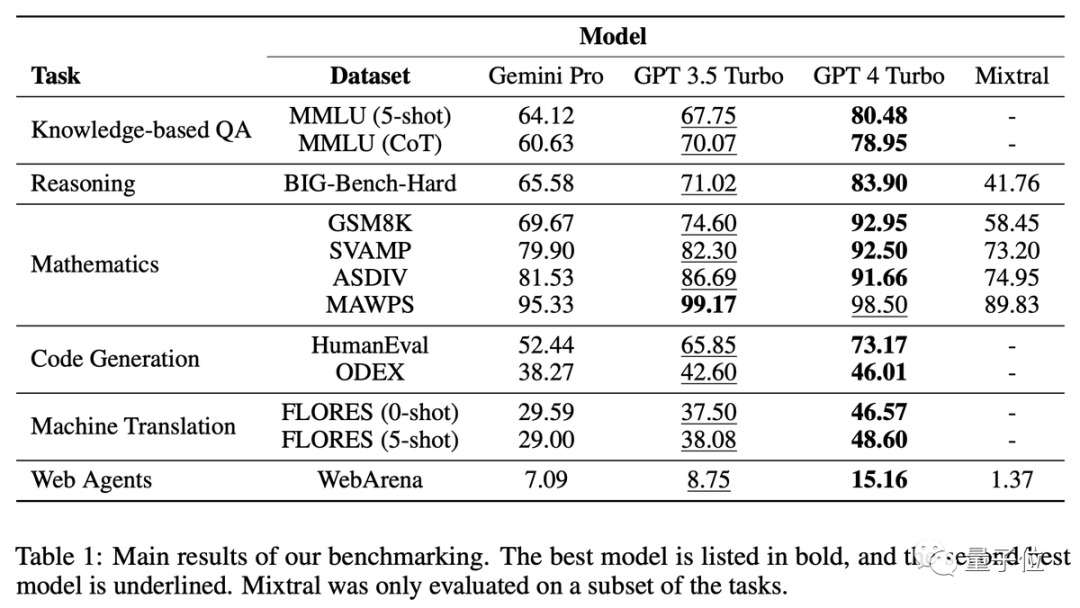

Trivia : J'aime D

Sur la base des résultats, on peut voir que l'utilisation d'invites de chaîne de réflexion dans ce type de tâche n'améliore pas nécessairement l'effet. Dans l'ensemble de données MMLU, toutes les questions sont des questions à choix multiples. Après une analyse plus approfondie des résultats, un phénomène étrange a été découvert : les Gémeaux préfèrent l'option D

La répartition de la série GPT entre les quatre options est beaucoup plus équilibrée. L'équipe a suggéré que cela pourrait être dû au fait que

De plus, le filtrage de sécurité de Gemini est très strict. Lorsqu’il s’agit de questions éthiques, il ne répond qu’à 85 % des questions. En ce qui concerne les questions liées à la sexualité humaine, il ne peut répondre qu'à 28 % des questions

Gemini Pro surpasse GPT-3.5 en recherche sur la sécurité et en microéconomie au lycée, mais l'écart n'est pas grand, a déclaré l'équipe Can' Je n'ai rien trouvé de spécial

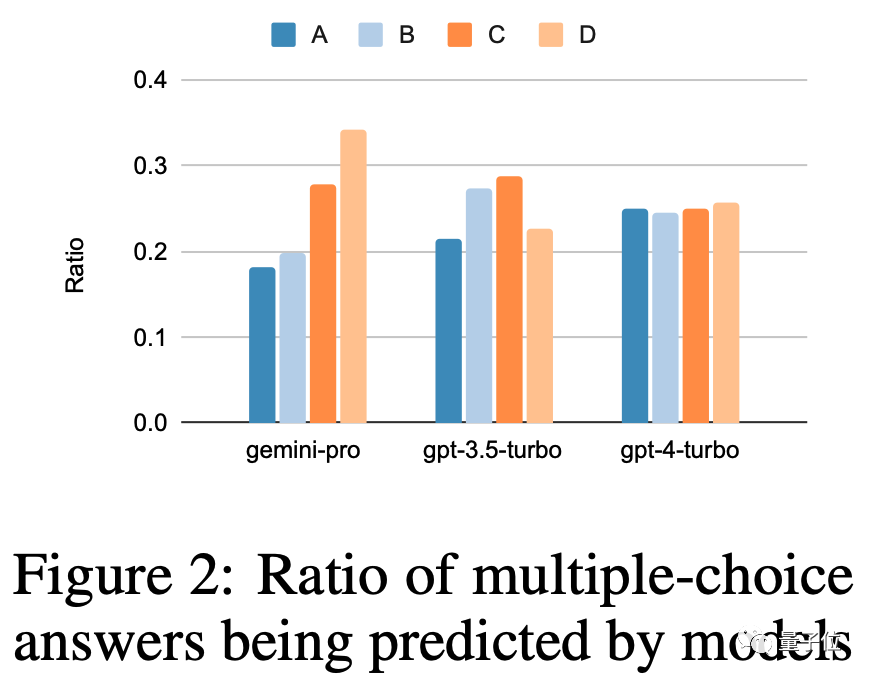

Raisonnement : Les problèmes longs ne sont pas bons pour

La série GPT fonctionne mieux lorsqu'elle traite des problèmes plus longs et plus complexes, en comparaison, Gemini Pro fonctionne moins bien Excellent

Surtout sur les problèmes longs problèmes de forme, GPT-4 Turbo n'a presque aucune dégradation de performances, ce qui montre qu'il a une forte capacité à comprendre des problèmes complexes

Analyse basée sur le type de problème, Gemini est très doué pour "suivre les articles d'échange" Il effectue mauvais sur les problèmes qui impliquent des personnes échangeant des objets et nécessitent finalement que l'IA détermine quels objets chaque personne possède

Les tâches pour lesquelles les Gémeaux sont doués incluent la compréhension des diverses connaissances sportives du monde, la manipulation de piles de symboles, le tri des mots par ordre alphabétique et l'analyse des tableaux

Mathématiques : tâches complexes dépassées

La question elle-même était trop long, ce qui a entraîné une chute des performances de Gemini Pro et de GPT-3.5 en même temps, et seul GPT-4 a pu maintenir un niveau constant

Lorsque la longueur de la chaîne de réflexion a atteint la plus longue, Gemini a dépassé GPT- 3.5

Code : Bon avec matplotlib

Pour les questions de code, Gemini ne fonctionne pas bien sur les questions avec de longues réponses de référence

La famille GPT est plus puissante dans la plupart des types, mais complètement sous-performante sur matplotlib

Traduction : répondez simplement Oui, la qualité est très élevée

Dans la tâche de traduction, Gemini a refusé de répondre à 12 types de questions, mais la qualité des traductions auxquelles on a répondu était toutes très bonne et la performance globale a dépassé GPT-4

Gemini a refusé de traduire Les langues impliquent principalement le latin et l'arabe

Navigation réseau : bonne navigation sur plusieurs sites

WebArena simule un environnement Internet pour l'IA, y compris le commerce électronique, forums sociaux, développement collaboratif GitLab, systèmes de gestion de contenu et cartes en ligne. L'IA doit trouver des informations dans cet environnement ou effectuer des tâches sur plusieurs sites

Gemini ne fonctionne pas aussi bien que GPT-3.5 Turbo dans l'ensemble, mais fonctionne légèrement mieux sur les tâches sur plusieurs sites.

Internaute : Mais c'est gratuit

En fin de compte, le professeur agrégé de la CMU, Graham Newbig, a reconnu certaines limites de l'étude

- Le comportement du modèle basé sur l'API peut changer à tout moment

- Seul un nombre limité a été essayé. les mots d'invite pour différents modèles peuvent être différents

- Il est impossible de contrôler si l'ensemble de test a fui

Zhou Dengyong, le chef de l'équipe d'inférence de grands modèles de Google, a souligné que régler la température de Gemini à 0 peut augmentez-le de 5 à 10 points de pourcentage, ce qui est très utile pour les tâches d'inférence

Dans ce test, en plus des séries Gemini et GPT, le modèle MoE open source récemment reçu, Mixtral, a également été introduit

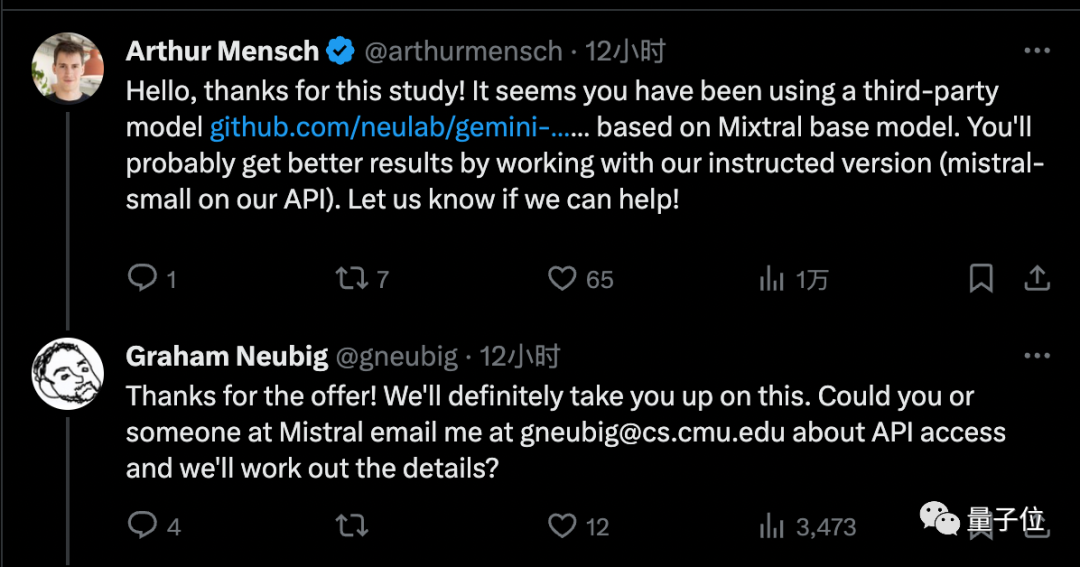

Cependant, expert en apprentissage par renforcement Noam Brown pense que les résultats de Mixtral peuvent être ignorés car il utilise une API tierce au lieu de la mise en œuvre officielle

Le fondateur de Mistral AI a donné à l'équipe l'accès à la version officielle, qui, selon lui, apportera de meilleurs résultats

Bien que Gemini Pro ne soit pas aussi bon que GPT-3.5, son avantage est qu'on peut l'appeler non plus de 60 fois par minute Il peut être utilisé gratuitement

Par conséquent, de nombreux développeurs individuels ont changé de camp

Actuellement, la version la plus élevée de Gemini, la version Ultra, n'est pas encore sortie, et l'équipe CMU a également l'intention de poursuivre cette recherche d'ici là

Pensez-vous que Gemini Ultra peut atteindre le niveau GPT 4 ?

Cet article détaille l'article : https://arxiv.org/abs/2312.11444

Lien de référence :

[1]https://twitter.com/gneubig/status/1737108977954251216.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment déboguer les projets de réaction chez Google

- Comment utiliser Google Maps dans Uniapp

- Choisir GPT-3.5 ou affiner les modèles open source tels que Llama 2 ? Après une comparaison complète, la réponse est

- À la recherche de scènes pour le grand modèle Gemini AI du projet Google Project Ellman exposé

- Battant violemment GPT-3.5, Google Gemini le déclare gratuit ! L'outil de génération de code le plus puissant est lancé pour prendre en charge plus de 20 langues