Maison >Périphériques technologiques >IA >Les directives OpenAI permettent aux conseils d'administration d'empêcher les PDG de publier de nouveaux modèles pour se prémunir contre les risques liés à l'IA.

Les directives OpenAI permettent aux conseils d'administration d'empêcher les PDG de publier de nouveaux modèles pour se prémunir contre les risques liés à l'IA.

- PHPzavant

- 2023-12-19 11:32:081304parcourir

Afin d'éviter les risques énormes que l'intelligence artificielle (IA) peut entraîner, OpenAI a décidé de donner au conseil d'administration plus de pouvoir pour superviser les questions de sécurité et exercer une surveillance stricte sur le PDG Sam Altman, qui vient de remporter une bataille interne le mois dernier

OpenAI a publié lundi 18 décembre EST une série de lignes directrices visant à suivre, évaluer, prédire et prévenir les risques catastrophiques posés par des modèles d'intelligence artificielle (IA) de plus en plus puissants. OpenAI définit le « risque catastrophique » comme tout risque pouvant entraîner des pertes économiques de plusieurs centaines de milliards de dollars, ou des blessures graves ou la mort de plusieurs personnes

Le guide de 27 pages, connu sous le nom de « Readiness Framework », indique que même si la haute direction d'une entreprise, y compris le PDG ou une personne désignée par la direction, estime qu'un modèle d'IA à publier est sûr, le conseil d'administration de l'entreprise a le pouvoir de choisir de reporter la sortie de ce modèle. Cela signifie que même si le PDG d'OpenAI est responsable des décisions quotidiennes, le conseil d'administration sera conscient des risques constatés et aura le pouvoir de veto sur les décisions du PDG

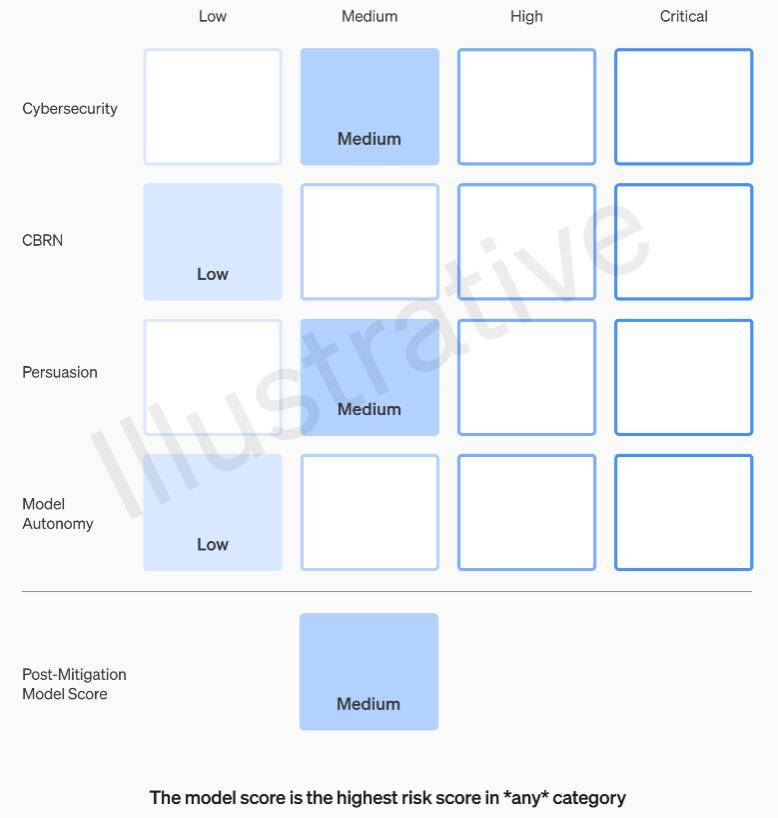

Le cadre de préparation d'OpenAI recommande d'utiliser une approche matricielle pour documenter le niveau de risque posé par les modèles d'IA de pointe dans plusieurs catégories, en plus des dispositions relatives à la direction de l'entreprise et à l'autorité du conseil d'administration. Ces risques incluent des acteurs malveillants utilisant des modèles d'IA pour créer des logiciels malveillants, lancer des attaques d'ingénierie sociale ou diffuser des informations nuisibles sur les armes nucléaires ou biologiques

Plus précisément, OpenAI fixe des seuils de risque en quatre catégories : cybersécurité, CBRN (menaces chimiques, biologiques, radiologiques, nucléaires), persuasion et autonomie du modèle. Avant et après la mise en œuvre de mesures d'atténuation des risques, OpenAI classe chaque risque en quatre niveaux : faible, moyen, élevé ou grave

OpenAI stipule que seuls les modèles d'IA classés « moyen » ou inférieurs après atténuation des risques peuvent être déployés, et seuls les modèles classés « élevé » ou inférieurs après atténuation des risques peuvent continuer à être développés si le risque ne peut pas être réduit en dessous du niveau grave. niveau, l’entreprise arrêtera de développer le modèle. OpenAI prendra également des mesures de sécurité supplémentaires pour les modèles évalués comme à haut risque ou à risque grave jusqu'à ce que le risque soit atténué

OpenAI divise les gestionnaires de problèmes de sécurité en trois équipes. L'équipe des systèmes de sécurité se concentre sur l'atténuation et la gestion des risques posés par les produits actuels tels que GPT-4. L’équipe de Super Alignement s’inquiète des problèmes qui pourraient survenir lorsque les futurs systèmes dépasseraient les capacités humaines. De plus, il existe une nouvelle équipe appelée Prepare, dirigée par Aleksander Madry, professeur au Département de génie électrique et d'informatique (EECS) du Massachusetts Institute of Technology (MIT)

Une nouvelle équipe évaluera le développement et la mise en œuvre de modèles robustes. Ils seront spécifiquement chargés de superviser les efforts techniques et les structures opérationnelles liées aux décisions de sécurité. Ils dirigeront le travail technique, examineront les limites des capacités des modèles de pointe et réaliseront des évaluations et des rapports de synthèse

Madry a déclaré que son équipe évaluerait régulièrement le niveau de risque des modèles d'intelligence artificielle les plus avancés d'OpenAI qui n'ont pas encore été publiés et soumettrait des rapports mensuels au groupe consultatif de sécurité interne (SAG) d'OpenAI. SAG analysera le travail de l'équipe de Madry et fournira des recommandations au PDG Altman et au conseil d'administration de l'entreprise

Selon le document d'orientation publié lundi, Altman et ses dirigeants peuvent décider de publier ou non un nouveau système d'IA basé sur ces rapports, mais le conseil d'administration conserve le pouvoir d'annuler leur décision

Actuellement, l’équipe de Madry ne compte que quatre personnes, mais il travaille dur pour recruter davantage de membres. Il est prévu que les membres de l'équipe atteindront 15 à 20 personnes, ce qui est similaire à l'équipe de sécurité et à l'équipe d'hyper-alignement existantes

Madry espère que d'autres sociétés d'IA évalueront les risques de leurs modèles de la même manière et pense que cela pourrait devenir un modèle de réglementation

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI