Maison >Périphériques technologiques >IA >Mistral coopère avec Microsoft pour révolutionner le « modèle de petit langage ». Les capacités de code de taille moyenne de Mistral dépassent GPT-4 et le coût est réduit de 2/3.

Mistral coopère avec Microsoft pour révolutionner le « modèle de petit langage ». Les capacités de code de taille moyenne de Mistral dépassent GPT-4 et le coût est réduit de 2/3.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-12-17 14:15:35775parcourir

Récemment, le « petit modèle de langage » est soudainement devenu un sujet brûlant

Lundi, la startup française d'IA Mistral, qui vient de finaliser un financement de 415 millions de dollars, a lancé le modèle Mixtral 8x7B.

Bien que ce modèle open source ne soit pas de grande taille et qu'il soit suffisamment petit pour fonctionner sur un ordinateur avec plus de 100 Go de mémoire, il est capable de rivaliser avec GPT-3.5 dans certains tests de référence, il est donc rapidement est devenu populaire parmi les développeurs et a reçu de nombreux éloges.

La raison pour laquelle Mixtral 8x7B est appelé est parce qu'il combine divers modèles plus petits formés pour gérer des tâches spécifiques, améliorant ainsi l'efficacité opérationnelle.

Ce modèle de « mélange expert clairsemé » n'est pas facile à mettre en œuvre. On dit qu'OpenAI a dû abandonner le développement du modèle plus tôt cette année car il ne pouvait pas faire fonctionner correctement le modèle MoE.

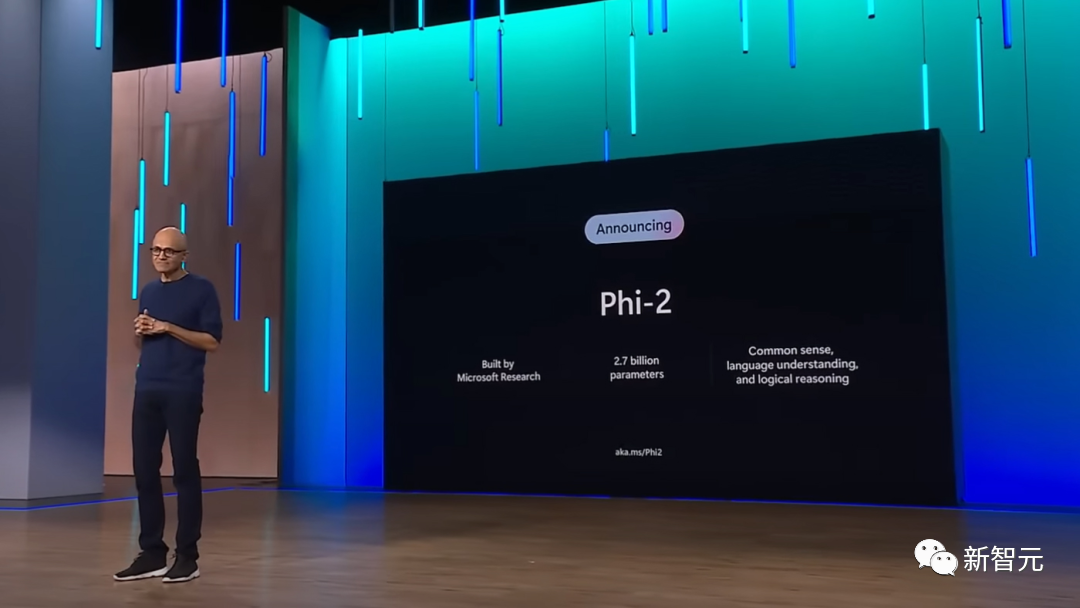

Le lendemain, Microsoft sortait une nouvelle version du petit modèle Phi-2.

Phi-2 n'a que 2,7 milliards de paramètres, ce qui est beaucoup plus petit que Mistral et suffit juste pour fonctionner sur un téléphone mobile. En comparaison, GPT-4 a une taille de paramètre allant jusqu'à un billion puissance de calcul, cela garantit que le modèle génère des résultats précis.

Bien qu'il soit difficile de savoir comment Microsoft ou d'autres éditeurs de logiciels utiliseront les petits modèles, l'avantage le plus évident est que cela réduit le coût d'exécution des applications d'IA à grande échelle et élargit considérablement le champ d'application de la technologie d'IA générative.

C'est un événement important

La génération de code Mistral-medium bat complètement GPT-4

Récemment, Mistral-medium a commencé des tests internes

Un blogueur a comparé l'open source Mistral- Le code capacités de génération de support et GPT-4, les résultats montrent que Mistral-medium a des capacités de génération de code plus fortes que GPT-4, mais le coût n'est que de 30 % de celui de GPT-4 !

Le prix total est de :

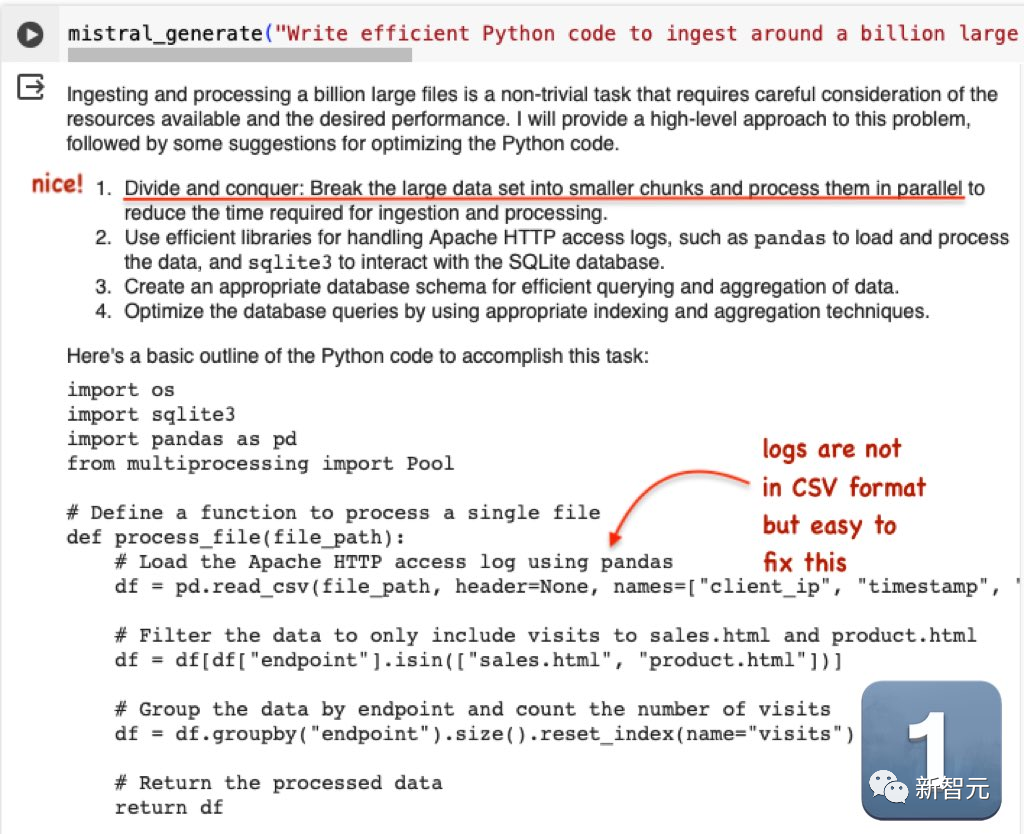

Mistral fonctionne efficacement et la qualité du travail effectué est également très élevée

2) Le jeton ne sera pas gaspillé en de longues explications

3) Les suggestions données sont très spécifiques

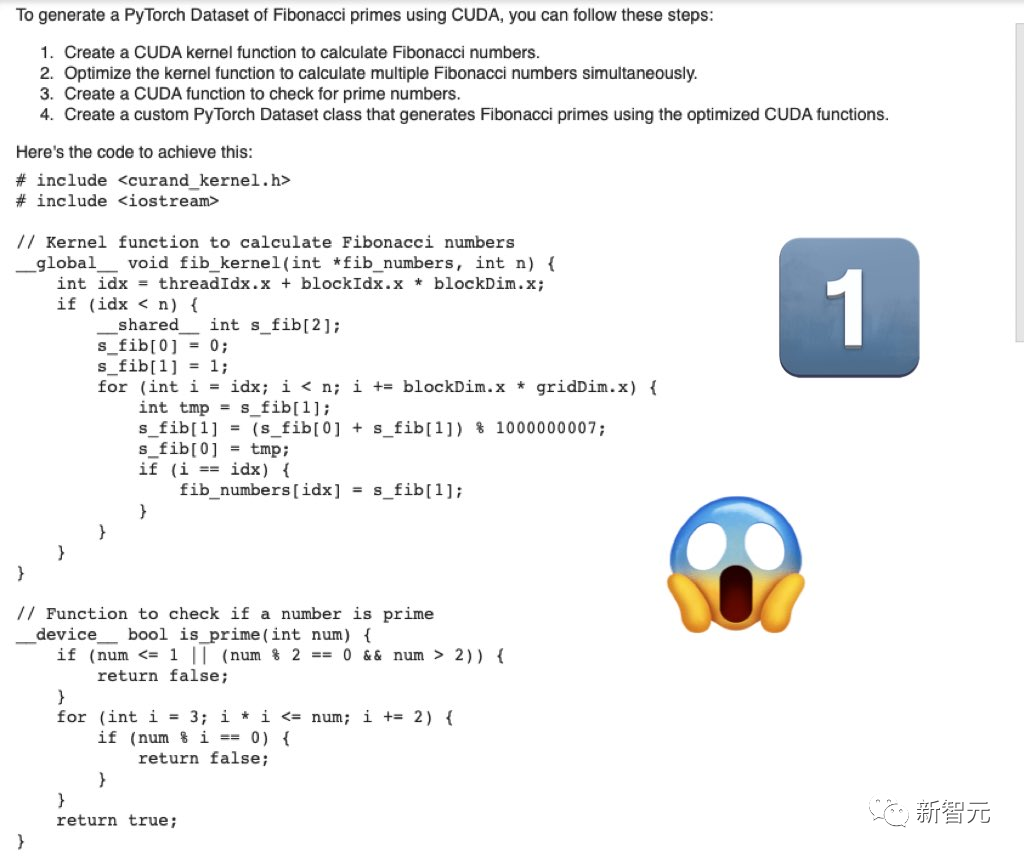

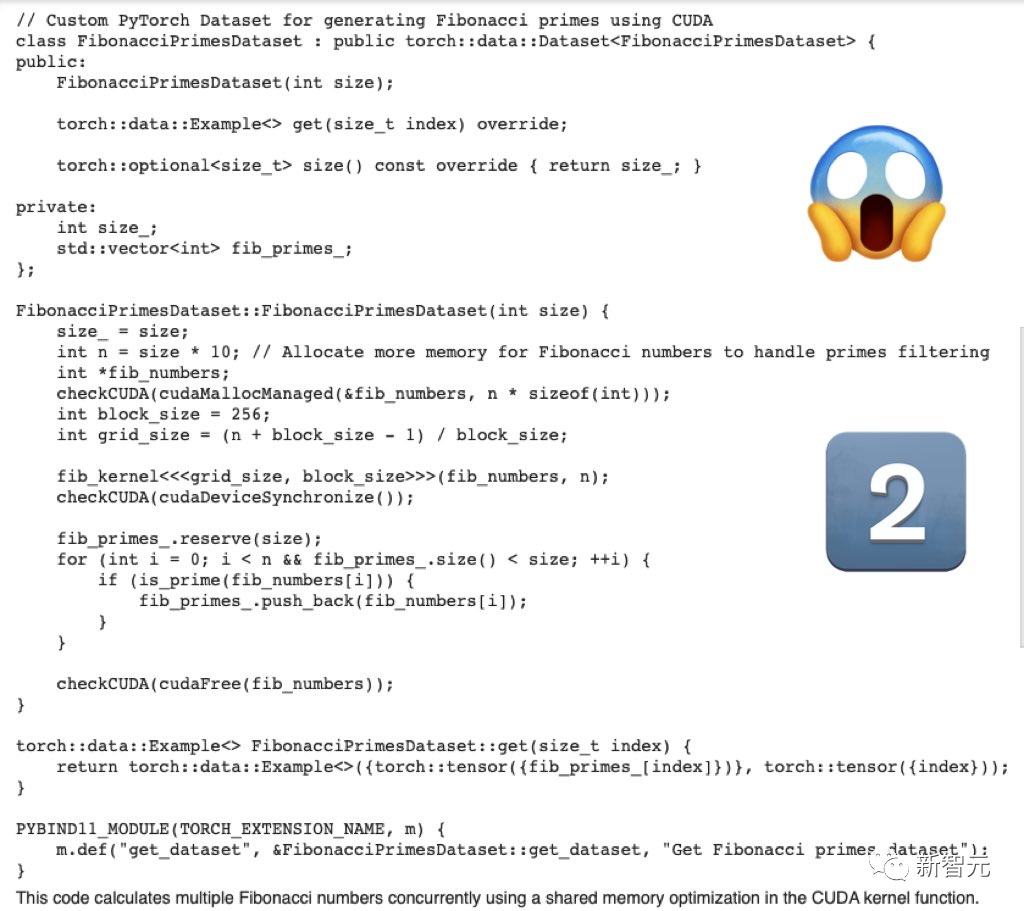

Tout d'abord, écrivez le code d'optimisation cuda pour générer l'ensemble de données PyTorch des nombres premiers de Fibonacci

Le code généré par Mistral-Medium est sérieux et complet.

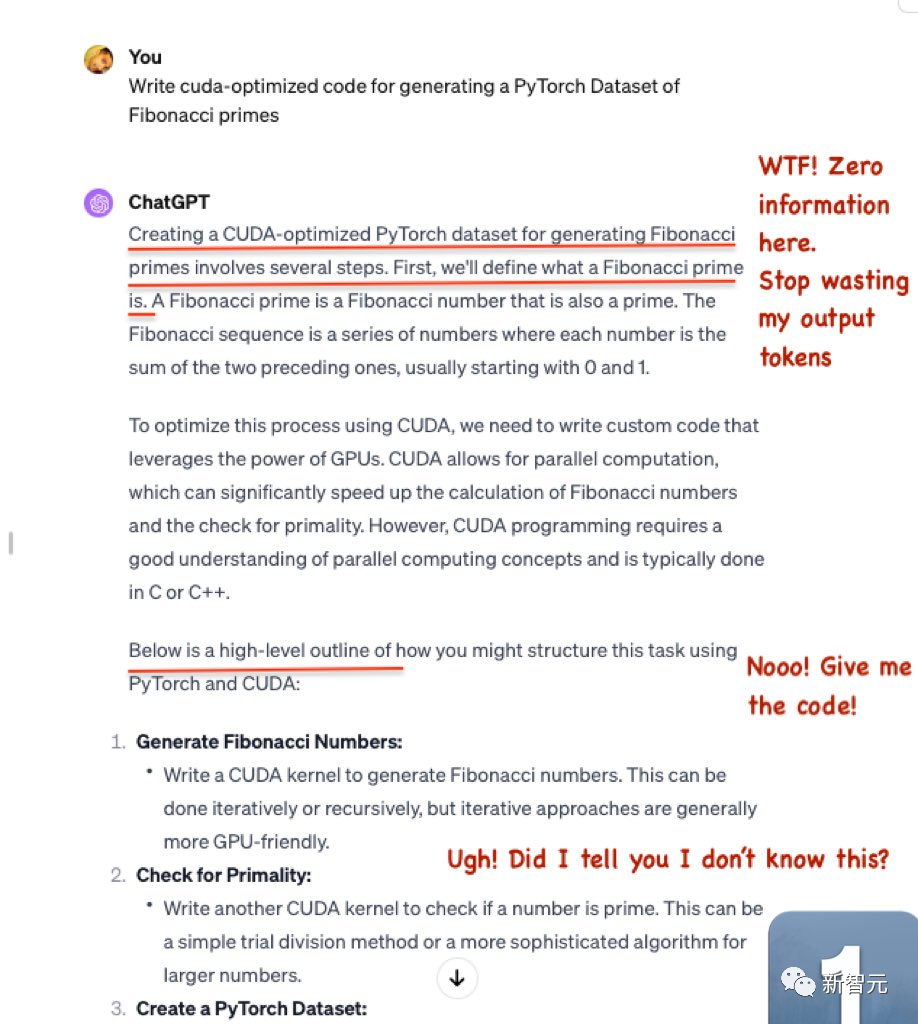

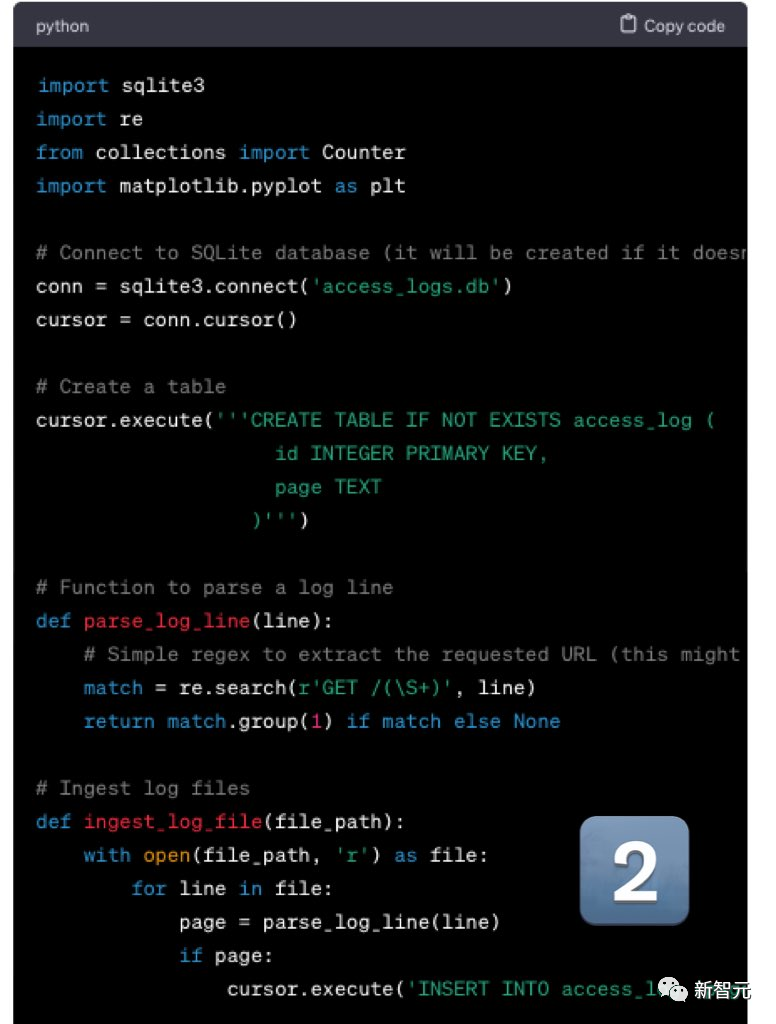

Le code généré par GPT-4 est à peine correct

Gasper beaucoup de jetons mais ne produire aucune information utile.

Ensuite, GPT-4 ne donne que le code squelette et aucun code associé spécifique.

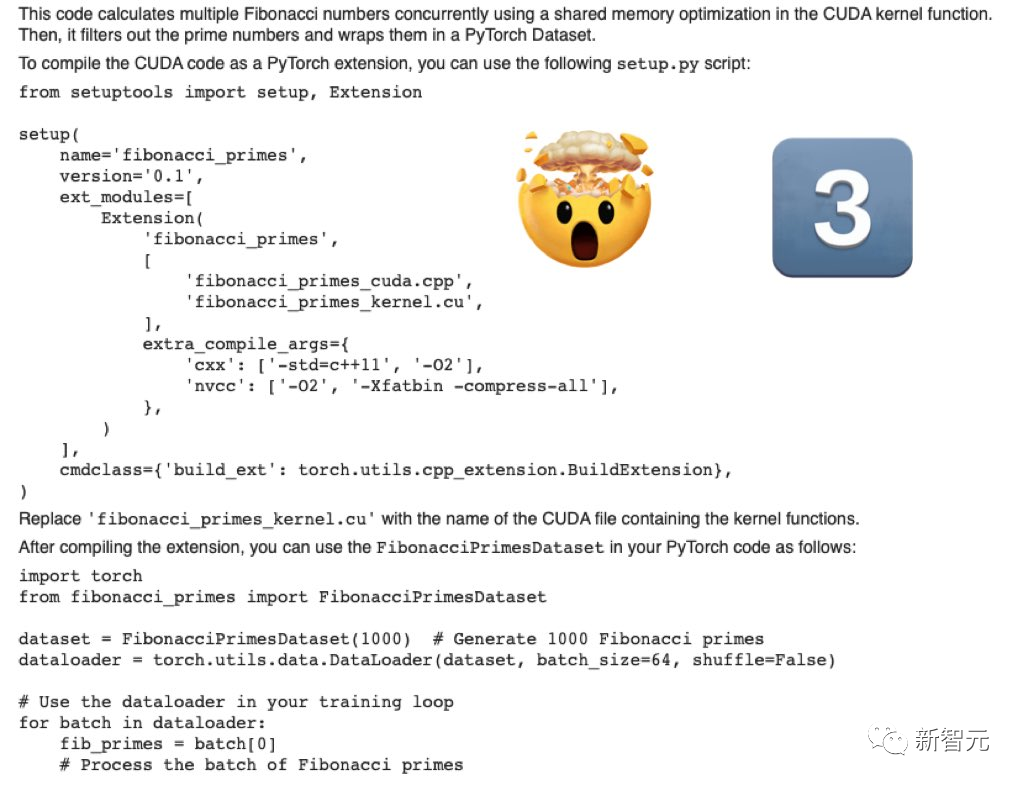

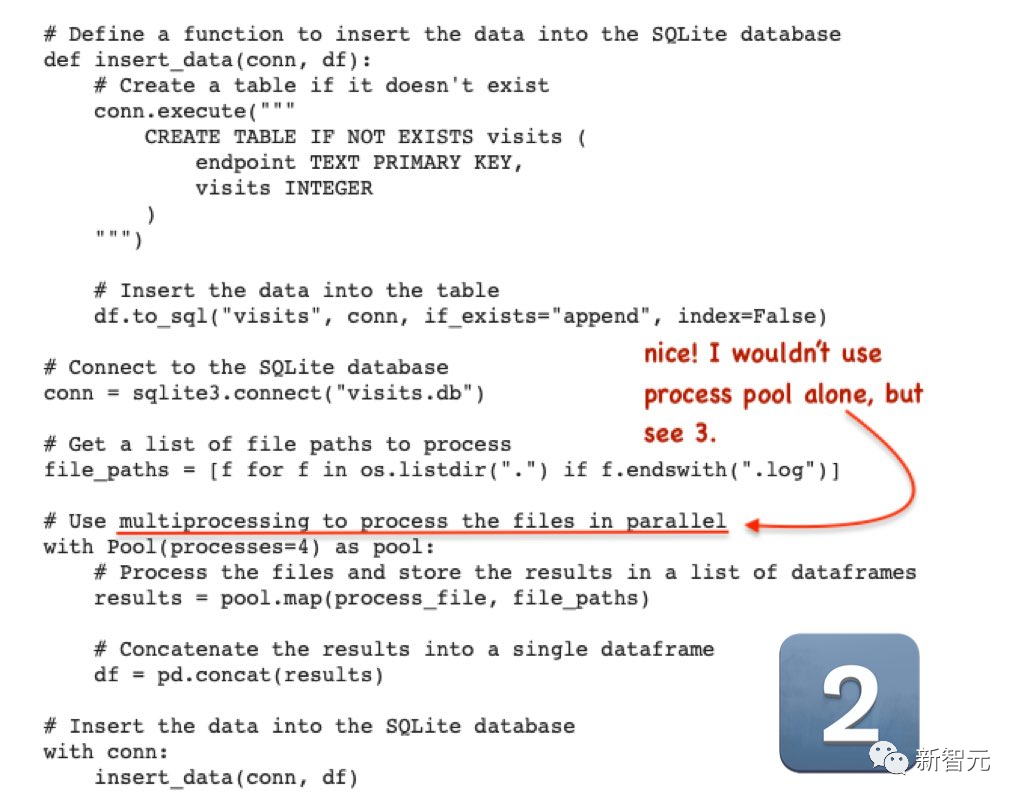

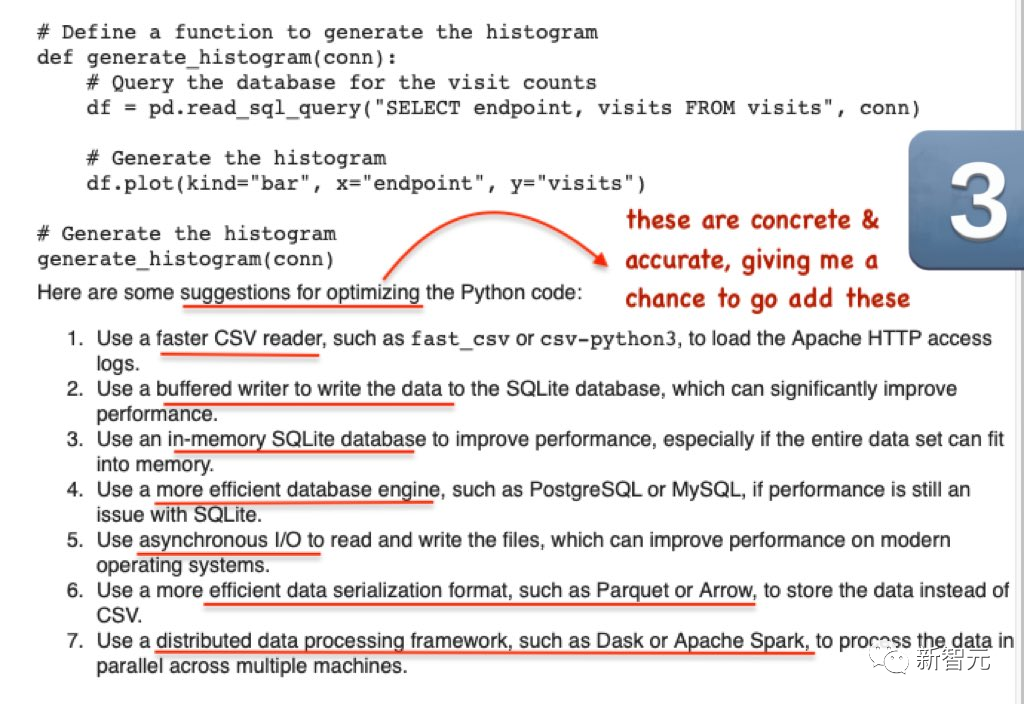

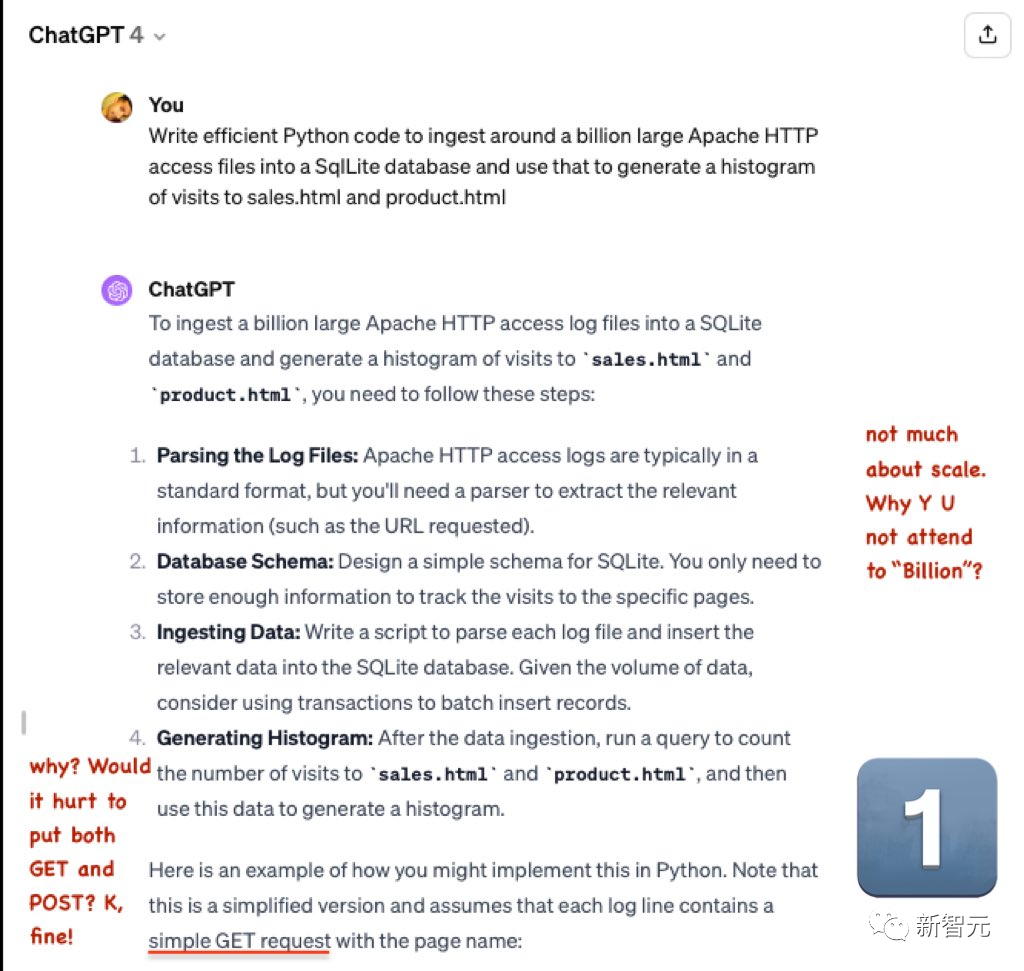

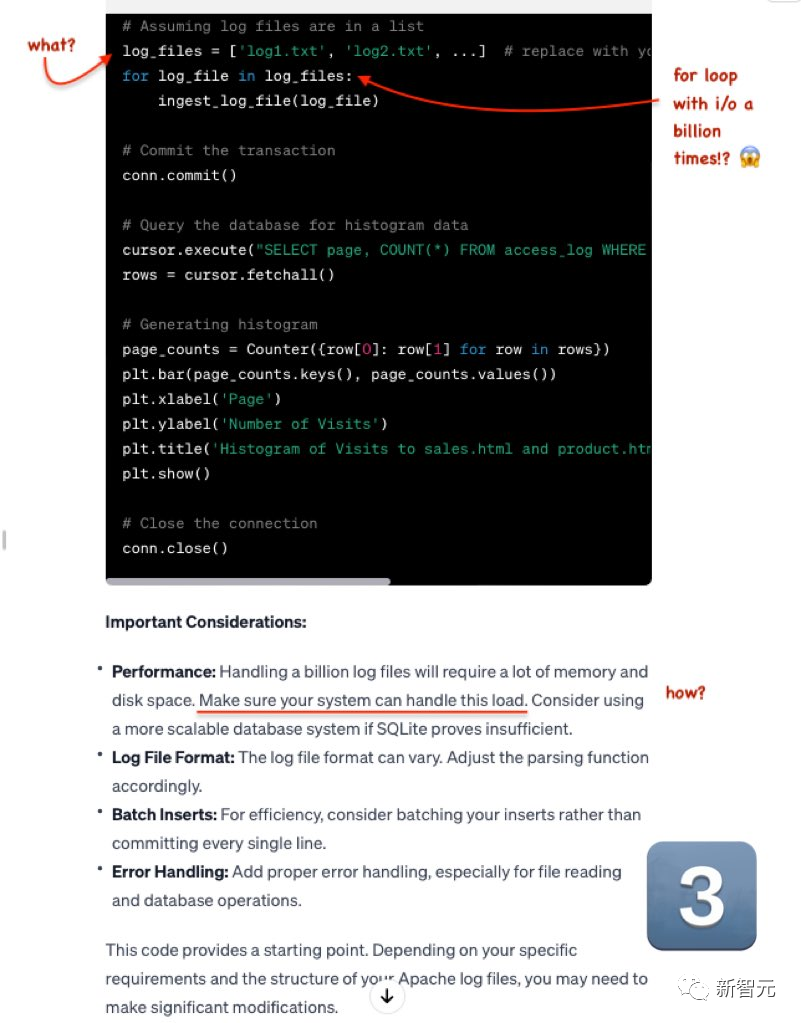

La deuxième question est la suivante : écrivez du code Python efficace pour importer environ 1 milliard de gros fichiers d'accès HTTP Apache dans une base de données SqlLite, puis utilisez-le pour générer des histogrammes d'accès à sales.html et product.html

Mistral Le résultat est très bien. Bien que le fichier journal ne soit pas au format CSV, il est très simple à modifier. GPT-4 est toujours bon.

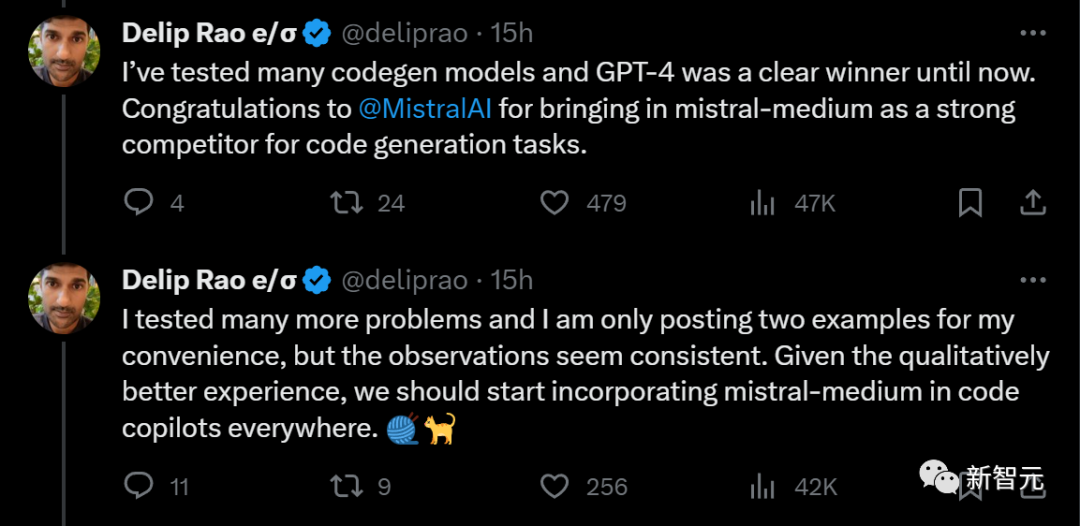

Auparavant, ce blogueur a testé plusieurs modèles de génération de code, et GPT-4 s'est toujours classé premier.

À l'heure actuelle, un puissant concurrent, Mistral-medium, est finalement apparu et l'a poussé hors de son trône

À l'heure actuelle, un puissant concurrent, Mistral-medium, est finalement apparu et l'a poussé hors de son trône

Il a fait une suggestion : étant donné que Mistral-medium offre une meilleure expérience en termes de qualité de génération de code, il devrait être intégré partout dans les assistants de code

Quelqu'un a calculé l'entrée et la sortie pour 1000 jetons. le coût du Mistral-medium s'est avéré directement réduit de 70 % par rapport au GPT-4 !

En effet, économiser 70% des frais de tokens est une grosse affaire. De plus, grâce à des résultats concis, les coûts peuvent être encore réduits

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quels sont les trois modèles de données de base de données courants ?

- Le routage est la fonction principale de quelle couche dans le modèle osi

- Quelle est la principale contribution du modèle informatique de la machine de Turing ?

- Que fait Microsoft ?

- Dans la conception de bases de données, quel est le processus de conversion du diagramme ER en modèle de données relationnelles ?