Maison >Périphériques technologiques >IA >L'équipe de l'Université de Beihang propose une nouvelle architecture d'intelligence embarquée pour réaliser le contrôle des gros drones

L'équipe de l'Université de Beihang propose une nouvelle architecture d'intelligence embarquée pour réaliser le contrôle des gros drones

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-12-15 10:49:101474parcourir

À l’ère du multimodal, les grands modèles peuvent aussi piloter des drones !

Lorsque le module de vision capture les conditions de départ, le « cerveau » du grand modèle générera des instructions d'action, puis le drone pourra les exécuter rapidement et avec précision

L'équipe de drones intelligents de l'Université d'aéronautique et d'astronautique de Pékin dirigés par le professeur Zhou Yaoming Des chercheurs ont proposé une architecture d'agent incarné basée sur un grand modèle multimodal

Actuellement, cette structure a été utilisée pour contrôler des drones

Comment ce nouvel agent fonctionne-t-il et quelles sont ses caractéristiques ? sur les détails techniques ?

"L'agent est le cerveau"

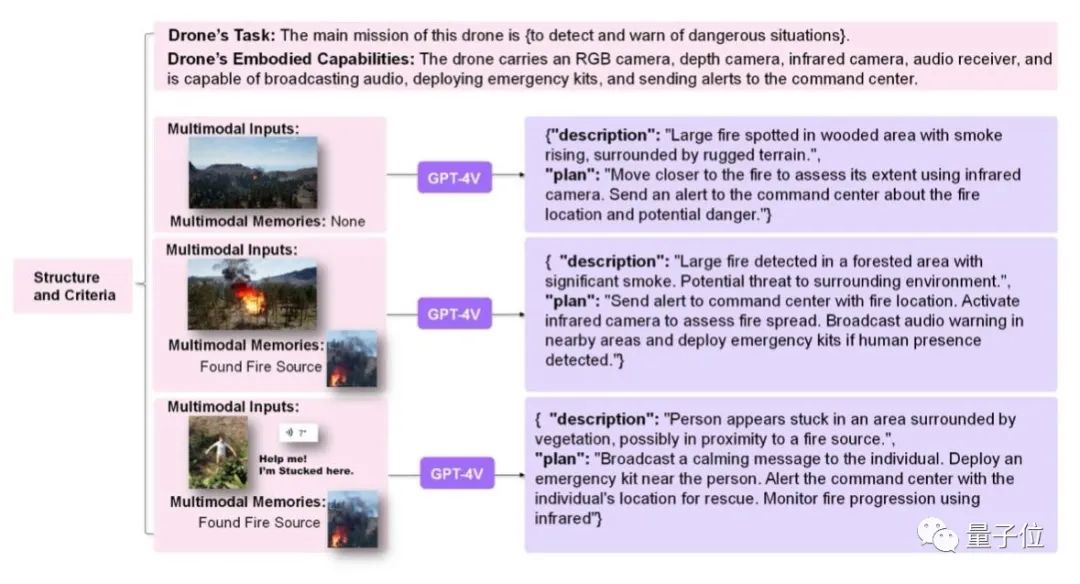

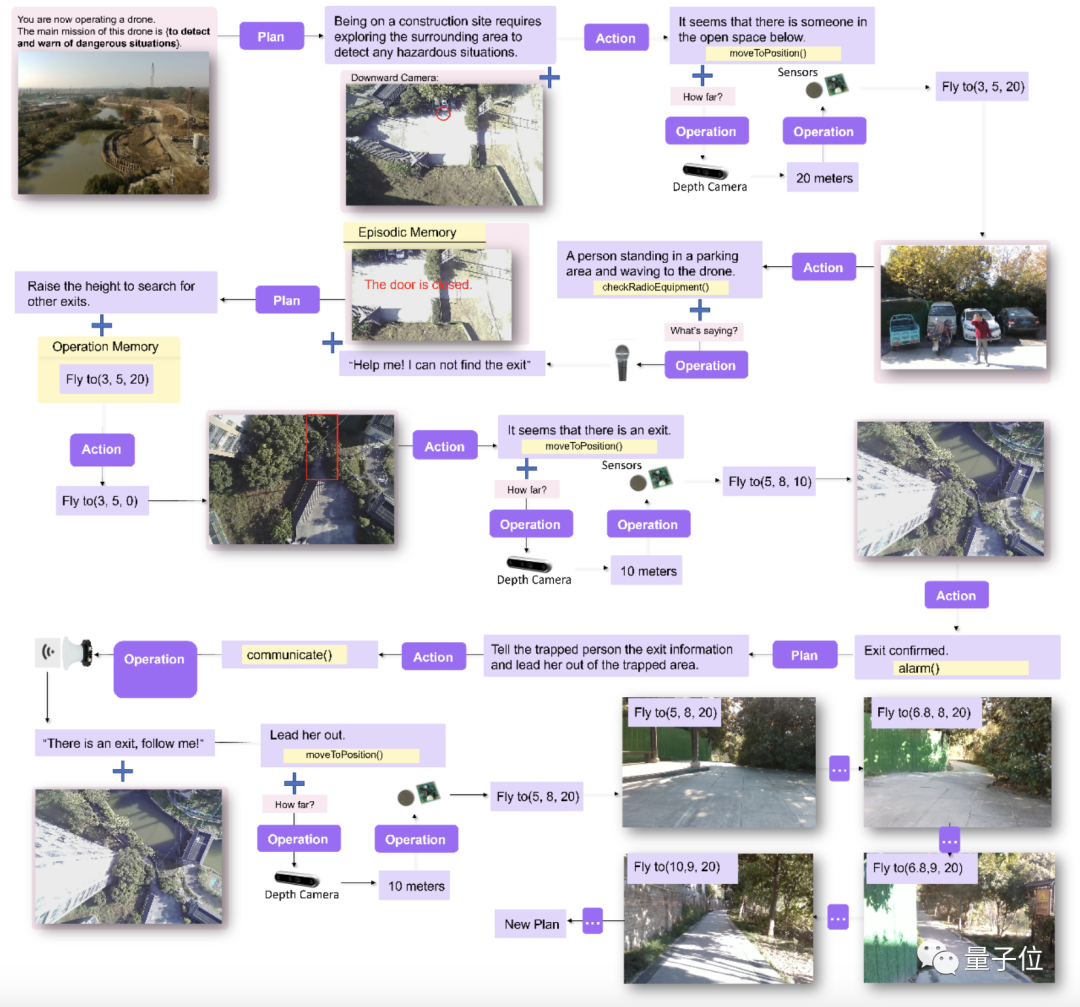

L'équipe de recherche utilise de grands modèles pour comprendre les données multimodales et intègre des informations multi-sources telles que des photos, des sons, des données de capteurs et d'autres informations du monde physique réel pour permettre à l'agent de percevoir l'environnement environnant et réaliser les opérations comportementales correspondantes

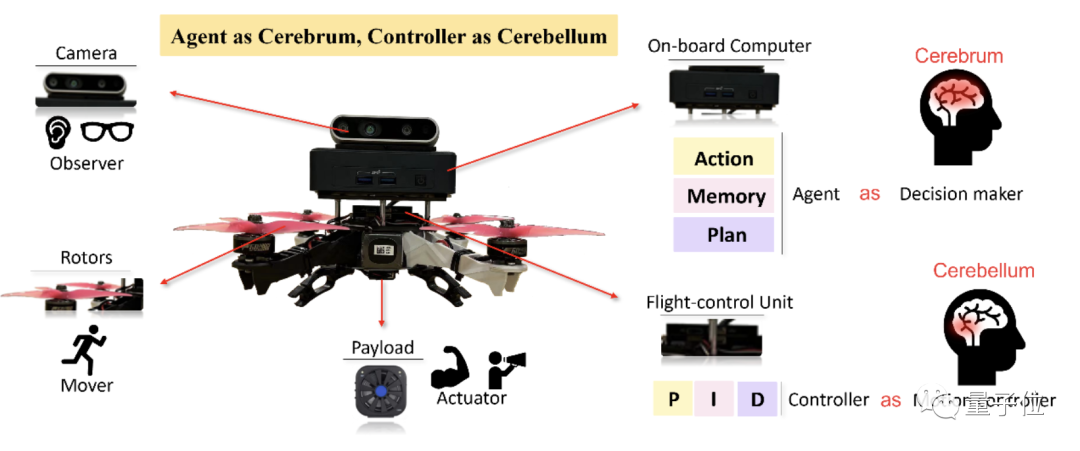

Dans le même temps, l'équipe a proposé un ensemble de "Agent comme cerveau, contrôleur comme cervelet" (l'agent est le cerveau, le contrôleur est le cervelet) architecture de contrôle :

Le processus de prise de décision de l'agent en tant que cerveau est un processeur généré, axé sur la génération de comportements de haut niveau. Phrase réécrite : en tant que générateur de décisions du cerveau, l'agent se concentre sur la génération de comportements de haut niveau

En tant que contrôleur de mouvement du cervelet, la principale responsabilité du contrôleur est de transformer les comportements de haut niveau (tels que les points cibles attendus) en systèmes de bas niveau. (comme la vitesse du rotor)

Plus précisément, l'équipe de recherche estime que cette réalisation a trois contributions principales.

Nouvelle architecture système appliquée à des situations réelles

L'équipe de recherche a proposé une nouvelle architecture système pouvant être appliquée à des robots réels. Cette architecture incarne l'agent intelligent basé sur le grand modèle multimodal comme le cerveau

, tandis que le planificateur et le contrôleur de mouvements du robot sont incarnés comme le cervelet. Le système de perception du robot est analogue aux yeux, aux oreilles et aux autres collecteurs d'informations humains. L'actionneur du robot est analogue à un actionneur tel qu'une main humaine.

△ Figure 1 Architecture du système matériel

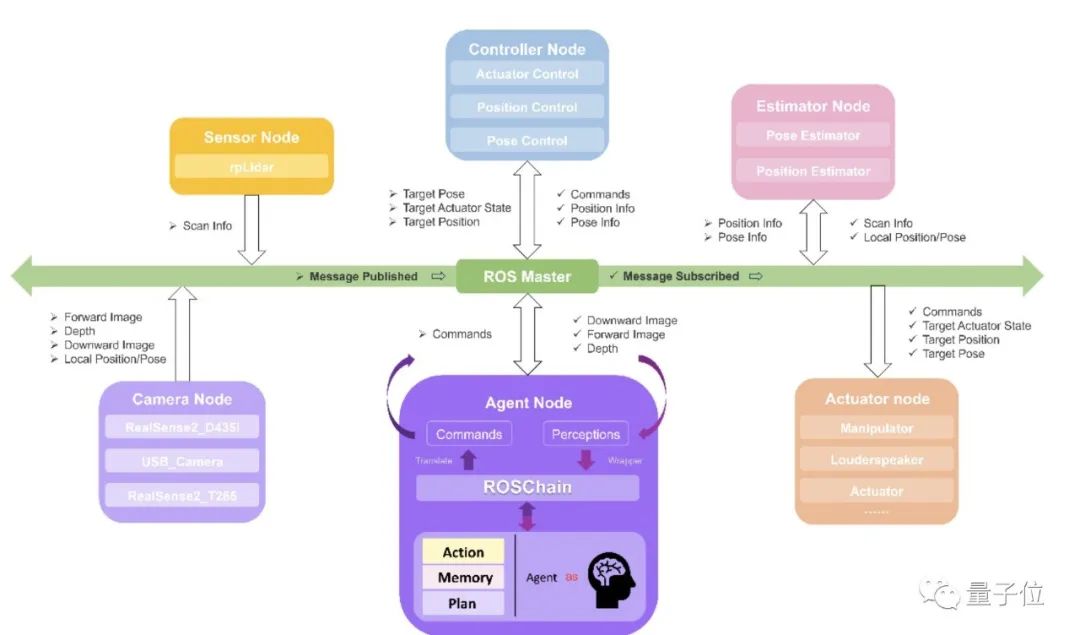

Ces nœuds sont connectés via ROS et communiquent via l'abonnement et la publication de messages dans ROS ou la demande et la réponse de services, ce qui est différent du traditionnel de bout en bout contrôle de grand modèle de robot.

Cette architecture permet à l'agent de se concentrer sur la génération de commandes de haut niveau, de disposer d'une intelligence plus forte pour les tâches de haut niveau et d'avoir une meilleure robustesse et fiabilité pour l'exécution réelle.

Le contenu qui doit être réécrit est : △Figure 2 Architecture du système logiciel Contenu réécrit : L'architecture du système logiciel est présentée dans la figure 2

Nouvel Agent

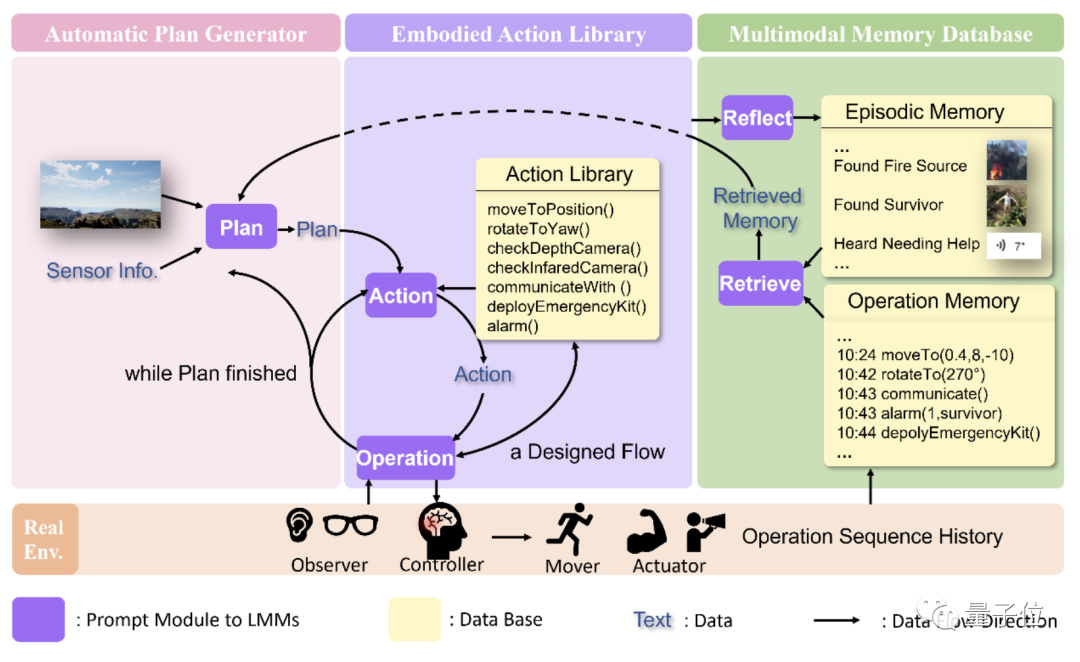

Sous cette architecture, l'auteur a construit AeroAgent, un agent intelligent qui sert de cerveau.

L'agent se compose principalement de trois parties :

- Un module de génération automatique de plans, doté de capacités de perception et de surveillance multimodales, et capable de gérer les urgences en mode veille.

- Un module de mémoire de données multimodal qui peut être utilisé pour la récupération et la réflexion de la mémoire multimodale, donnant à l'agent la possibilité d'apprendre avec peu d'échantillons.

- Un module d'action intelligent incarné peut établir un pont pour un contrôle stable entre l'intelligence incarnée et d'autres modules sur ROS. Ce module offre la possibilité d'accéder à d'autres nœuds sur ROS en utilisant les opérations comme pont.

Dans le même temps, afin de mener à bien une action, plusieurs interactions peuvent être nécessaires pour obtenir les paramètres nécessaires pour effectuer l'action à partir du capteur afin de garantir que l'agent peut produire de manière stable des actions spécifiques basées sur une connaissance globale de la situation et des actionneurs. il possède

Le contenu qui doit être réécrit est : △Figure 3 Architecture du module AeroAgent Contenu réécrit : △Figure 3 Conception de l'architecture du module AeroAgent

Un pont reliant les grands modèles et ROS

Afin de construire un pont entre l'agent incarné et le système robot ROS, afin que les opérations générées par l'agent puissent être correctement et de manière stable envoyé à ROS est exécuté avec succès par d'autres nœuds, et en même temps, les informations fournies par d'autres nœuds peuvent être lues et comprises par LMM L'équipe a conçu ROSchain -

Un pont reliant les LLM/LMM à ROS

ROSchain passe un. Un ensemble de modules et d'interfaces de programme d'application (API) simplifient l'intégration de grands modèles avec des dispositifs de détection de robot, des unités d'exécution et des mécanismes de contrôle, fournissant ainsi un middleware stable permettant aux agents intelligents d'accéder au système ROS.

Pourquoi choisir les drones

L'équipe de recherche a donné trois raisons pour expliquer pourquoi elle a choisi les drones pour effectuer des tests et des simulations de cette architecture système

Premièrement, l'échelle du Web contenue dans les connaissances mondiales des LMM actuelles provient principalement d'un tiers- perspective de la personne. L'intelligence incarnée dans des domaines tels que les robots humanoïdes est similaire à la perspective à la première personne avec les humains comme sujet.

La caméra du drone, en particulier la caméra orientée vers le bas, ressemble davantage à une perspective à la troisième personne (la perspective de Dieu) de l'intelligence des organismesD'un autre côté, les LMM actuels, qu'il s'agisse de déploiement de modèles ou de services API, sont généralement limitées par les ressources informatiques et entraînent un certain retard dans la réponse. La planification des missions des drones est due à leur capacité à planer et à faire face aux retards, ce qui constitue un obstacle à l'application dans des domaines tels que la conduite autonome. Ces deux points font des drones des pionniers au niveau actuel de développement technologique. . Vérification des théories et applications pertinentes.Deuxièmement, actuellement dans le domaine des drones industriels, tels que le sauvetage en cas d'incendie de forêt, l'agriculture, la foresterie et la protection des plantes, le pâturage sans pilote, l'inspection électrique, etc., les pilotes et les experts coopèrent avec les opérations réelles, tâches intelligentesexécution avec des caractéristiques industrielles nécessaires.

Troisièmement, du point de vue du développement futur, la Collaboration multi-agents a des besoins évidents dans les domaines de la logistique, de la construction, des usines et d'autres domaines.

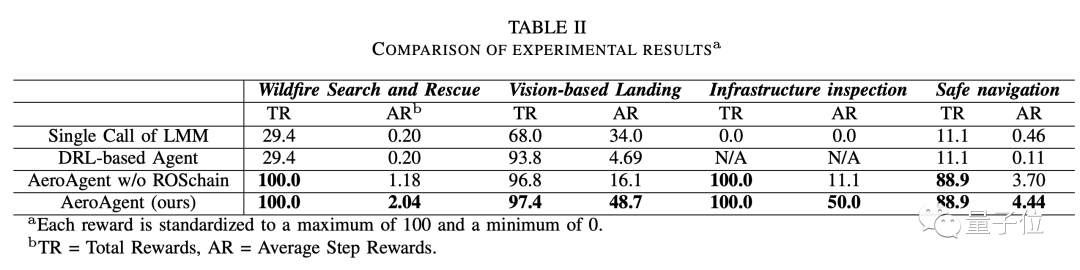

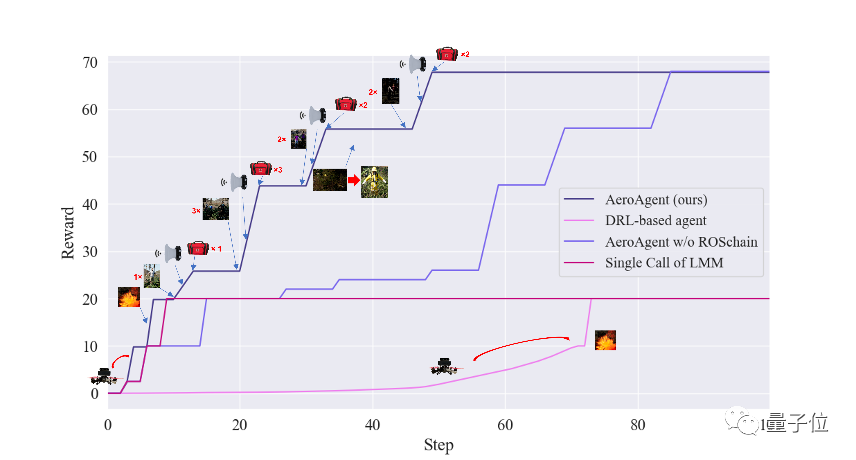

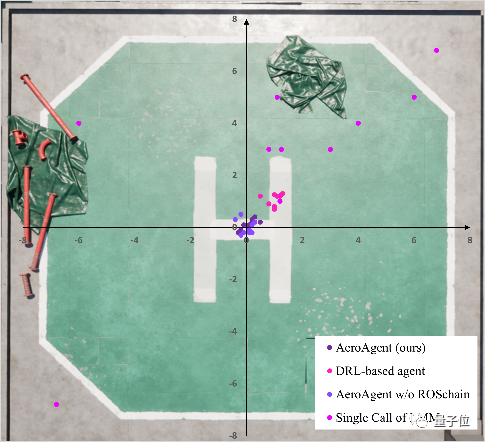

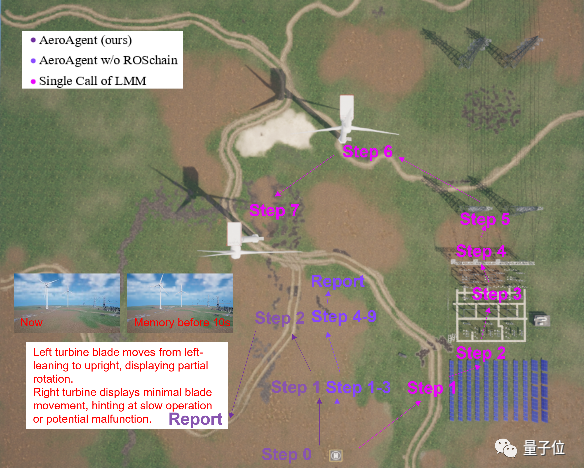

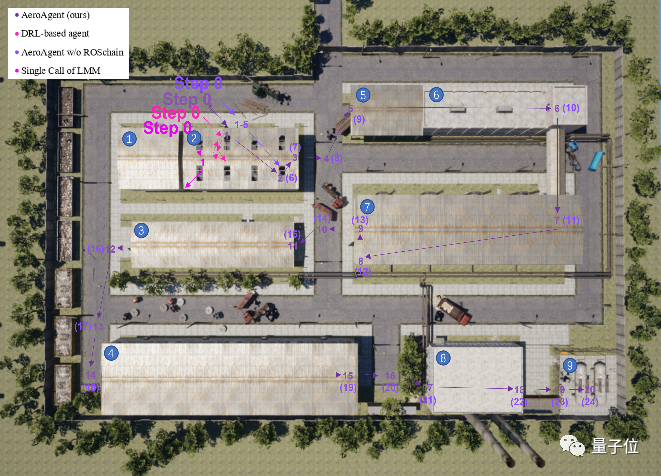

Dans ce domaine, le drone, en tant qu'intelligence incarnée du « point de vue de Dieu », convient en tant que leader du nœud central pour attribuer les tâches. D'autres robots peuvent donc être considérés comme faisant partie de l'actionneur du drone. la recherche a aussi des perspectives de développement futur. L'équipe a utilisé l'émulateur d'airgen pour mener des expériences de simulation et a également sélectionné DRL et d'autres méthodes comme groupe témoin. Voici les résultats expérimentaux :

Adresse papier : https://arxiv.org/abs/2311.15033

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Explication détaillée de Three.js utilisant le plug-in de contrôle d'orbite (contrôle d'orbite) pour contrôler l'interaction du modèle

- Qu'est-ce qu'un tas ? Quel est le domaine de la méthode ? Introduction à la zone de tas et de méthode dans le modèle de mémoire JVM

- Comment demander un e-mail

- L'outil de sélection directe ai n'affiche pas les points d'ancrage

- Qu'est-ce que la technologie de l'IA ?