Maison >Périphériques technologiques >IA >Les grands modèles open source doivent surpasser les sources fermées - LeCun révèle le tableau des tendances de l'IA pour 2024

Les grands modèles open source doivent surpasser les sources fermées - LeCun révèle le tableau des tendances de l'IA pour 2024

- PHPzavant

- 2023-12-15 10:23:55991parcourir

2023 touche à sa fin. Au cours de la dernière année, divers grands modèles ont été lancés. Alors que des géants de la technologie tels qu'OpenAI et Google sont en concurrence, un autre « pouvoir » émerge tranquillement : l'open source.

Le modèle open source a toujours été beaucoup remis en question. Sont-ils aussi performants que les modèles propriétaires ? Peut-il égaler les performances des modèles propriétaires ? Jusqu’à présent, nous avons pu dire que nous n’en sommes que quelque peu proches. Néanmoins, le modèle open source nous apportera toujours des performances empiriques, ce qui nous fait le regarder avec admiration.

La montée en puissance des modèles open source change les règles du jeu. La série LLaMA de Meta, par exemple, gagne en popularité en raison de son itération rapide, de sa personnalisation et de sa confidentialité. Ces modèles sont rapidement développés par la communauté, créant un puissant défi aux modèles propriétaires et capables de changer le paysage concurrentiel des grandes entreprises technologiques.

Mais avant, la plupart des idées des gens venaient simplement de « sentiments ». Ce matin, Yann LeCun, scientifique en chef de l'IA de Meta et lauréat du prix Turing, a soudainement déploré : "Les modèles d'intelligence artificielle open source sont en passe de surpasser les modèles propriétaires

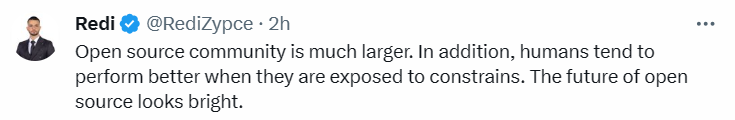

Ceci est financé par Ark Investment (le tableau de tendances produit." par l’équipe ARK Invest est considéré comme pouvant prédire le développement de l’intelligence artificielle en 2024. Il montre la croissance des communautés open source par rapport aux modèles propriétaires en matière d'intelligence artificielle générative

À mesure que des entreprises comme OpenAI et Google deviennent de plus en plus fermées, elles exposent de moins en moins fréquemment des informations sur leurs derniers modèles. En conséquence, la communauté open source et son bailleur de fonds Meta commencent à intervenir pour démocratiser l'IA générative, posant peut-être un défi aux modèles commerciaux des modèles propriétaires

Diverses IA sont présentées dans ce nuage de points. Le pourcentage de performance du modèle. Les modèles propriétaires sont affichés en bleu et les modèles open source en noir. Nous pouvons voir les performances de différents modèles d'IA tels que GPT-3, Chinchilla 70B (Google), PaLM (Google), GPT-4 (OpenAI) et Llama65B (Meta) à différents moments.

Lorsque Meta a initialement publié LLaMA, le nombre de paramètres variait de 7 milliards à 65 milliards. Les performances de ces modèles sont excellentes : le modèle Llama avec 13 milliards de paramètres peut surpasser GPT-3 (175 milliards de paramètres) « sur la plupart des benchmarks » et peut fonctionner sur un seul GPU V100 tandis que le plus grand 65 milliards de paramètres du modèle Llama ; sont comparables aux Chinchilla-70B et PaLM-540B de Google.

Falcon-40B s'est hissé au sommet du classement OpenLLM de Huggingface dès sa sortie, changeant la scène dans laquelle Llama se démarque.

Llama 2 est open source, provoquant une fois de plus de grands changements dans le paysage des grands modèles. Par rapport à Llama 1, Llama 2 dispose de 40 % de données d'entraînement en plus, double la longueur du contexte et adopte un mécanisme d'attention aux requêtes groupées.

Récemment, l'univers des grands modèles open source a gagné un nouveau membre poids lourd : le modèle Yi. Il peut gérer 400 000 caractères chinois à la fois, et le chinois et l'anglais dominent la liste. Le Yi-34B est également devenu le seul modèle national à figurer jusqu'à présent en tête du classement des modèles open source Hugging Face.

Selon le nuage de points, les performances du modèle open source continuent de rattraper celles du modèle propriétaire. Cela signifie que dans un avenir proche, le modèle open source devrait égaler, voire dépasser, le modèle propriétaire en termes de performances.

Mistral 8x7B a suscité les éloges des chercheurs avec sa méthode de publication la plus simple et ses performances puissantes le week-end dernier. "Le grand modèle fermé a pris fin."

Certains internautes ont commencé à souhaiter que "2024 devienne l'année de l'intelligence artificielle open source" et estiment que "nous approchons d'un moment critique". point. Compte tenu des projets actuels de la communauté open source. Avec la vitesse de développement, nous prévoyons d'atteindre le niveau de GPT-4 dans les 12 prochains mois. "

Ensuite, nous attendrons de voir si l'avenir du le modèle open source navigue en douceur et quel type de performances il montrera

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!