Maison >Périphériques technologiques >IA >Amazon s'efforce de défendre son statut de cloud, met à niveau ses puces d'IA auto-développées, lance le robot de chat Q et est le premier à utiliser la super puce de nouvelle génération de Nvidia

Amazon s'efforce de défendre son statut de cloud, met à niveau ses puces d'IA auto-développées, lance le robot de chat Q et est le premier à utiliser la super puce de nouvelle génération de Nvidia

- 王林avant

- 2023-11-29 08:37:481299parcourir

Amazon met tout en œuvre pour défendre son leadership dans le cloud computing. D'une part, ils ont mis à niveau leurs propres puces cloud et ont lancé la version Amazon de GPT, un chatbot d'intelligence artificielle, d'autre part, ils ont également approfondi leur coopération avec NVIDIA, lancé de nouveaux services basés sur les puces NVIDIA et les ont développés conjointement avec NVIDIA ; Supercalculateur

Dave Brown, vice-président d'AWS, a déclaré qu'en concentrant la conception de puces auto-développées sur des charges de travail réelles qui sont importantes pour les clients, AWS peut leur fournir l'infrastructure cloud la plus avancée. Le Graviton 4 lancé cette fois-ci est la puce de quatrième génération d'ici cinq ans. À mesure que l'intérêt des gens pour l'IA générative augmente, la puce d'IA de deuxième génération Trainium 2 aidera les clients à s'entraîner plus rapidement, à moindre coût et avec un modèle d'apprentissage automatique plus efficace.

Les performances informatiques de Graviton4 sont améliorées jusqu'à 30% par rapport à la génération précédente

Le mardi 28 novembre, heure de l'Est, la société de cloud computing d'Amazon, AWS, a annoncé le lancement d'une nouvelle génération de puces AWS auto-développées. Parmi eux, les performances informatiques de la puce à usage général Graviton4 sont jusqu'à 30 % supérieures à celles de la génération précédente Graviton3, le cœur est augmenté de 50 % et la bande passante mémoire est augmentée de 75 %, offrant ainsi les performances de coût les plus élevées et utilisation de l'énergie sur le service d'hébergement de serveur cloud Amazon Effet Amazon Elastic Compute Cloud (EC2).

Graviton4 améliore la sécurité en cryptant entièrement toutes les interfaces matérielles physiques à haut débit. AWS a déclaré que Graviton4 serait disponible sur les instances Amazon EC2 R8g à mémoire optimisée pour aider les clients à améliorer l'exécution des bases de données hautes performances, du cache en mémoire et des charges de travail d'analyse Big Data. Les instances R8g offrent des tailles d'instance plus grandes avec jusqu'à trois fois plus de processeurs virtuels et trois fois plus de mémoire que les instances R7g de la génération précédente

Dans les prochains mois, nous prévoyons de lancer des ordinateurs équipés de Graitons4. AWS indique qu'au cours des cinq années écoulées depuis le lancement du projet Garviton, plus de 2 millions de processeurs Garviton ont été produits et les 100 premiers utilisateurs d'AWS EC2 ont choisi d'utiliser Graviton

Trainium2 est quatre fois plus rapide et peut entraîner des modèles avec des milliards de paramètres

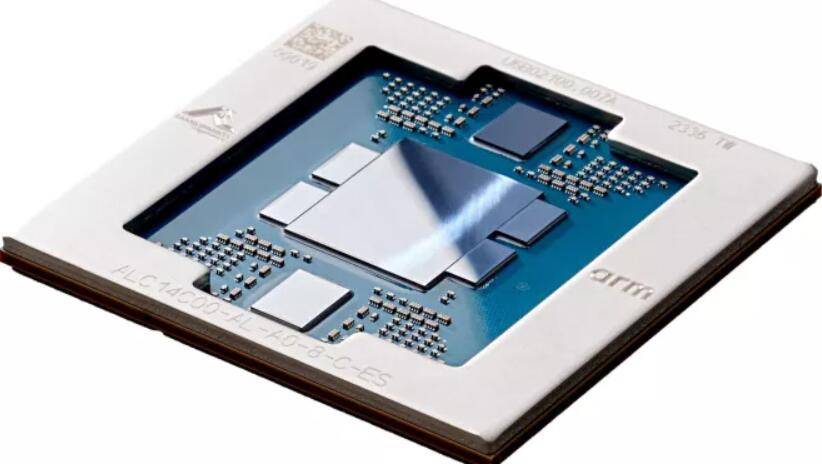

AWS a lancé une puce IA de nouvelle génération appelée Trainium2, qui est quatre fois plus rapide que la génération précédente Trainium1. Trainium2 peut déployer jusqu'à 100 000 puces dans EC2 UltraCluster, permettant aux utilisateurs de former des modèles de base (PM) et des modèles de langage étendus (LLM) avec des milliards de paramètres en peu de temps. Par rapport à la génération précédente, la consommation d’énergie de Trainium2 a été doublée

Trainium2 sera utilisé sur les instances Amazon EC2 Trn2, chacune contenant 16 puces Trainium. Les instances Trn2 sont conçues pour aider les clients à faire évoluer le nombre d'applications de puces dans EC2 UltraCluster de nouvelle génération jusqu'à 100 000 puces Trainium2 et à fournir jusqu'à 65 Exach de puissance de calcul via une connectivité réseau à l'échelle du pétaoctet via AWS Elastic Fabrication Adapters (EFA)

Selon AWS, Trainium2 sera utilisé pour prendre en charge de nouveaux services à partir de l'année prochaine

Le premier client majeur, DGX Cloud, utilise la version améliorée du Grace Hopper GH200 NVL32, ce GPU pilote le supercalculateur IA le plus rapide

Lors de la conférence annuelle re:Invent, AWS et NVIDIA ont annoncé mardi une coopération stratégique élargie pour fournir une infrastructure, des logiciels et des services de pointe afin de promouvoir l'innovation en matière d'IA générative des clients. Cette coopération implique non seulement des puces auto-développées, mais inclut également une coopération dans d'autres domaines

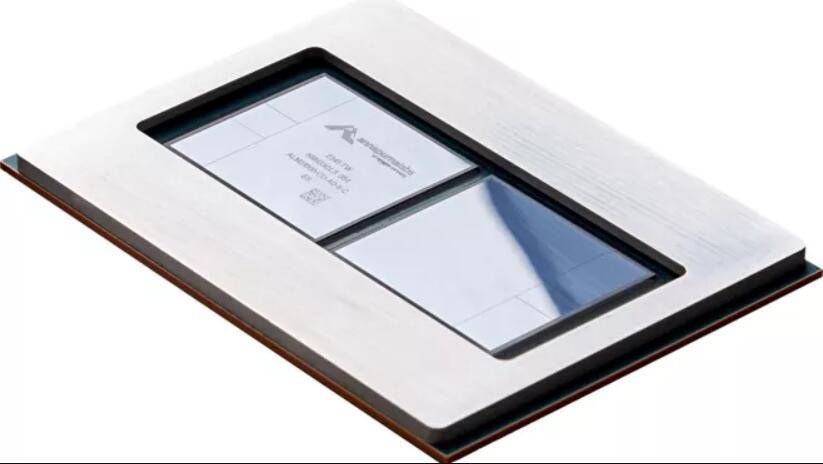

AWS deviendra le premier fournisseur de services cloud à utiliser la nouvelle super puce NVIDIA H200 Grace Hopper à technologie multi-nœuds NVLink dans le cloud. En d'autres termes, AWS deviendra le premier client important de la version mise à niveau de Grace Hopper

.La plate-forme multi-nœuds H200 NVL32 de NVIDIA utilise 32 puces Grace Hopper avec la technologie NVLink et NVSwitch dans une seule instance. La plate-forme sera utilisée sur les instances Amazon EC2 connectées à Amazon Network EFA et est alimentée par une virtualisation avancée (AWS Nitro System) et des clusters ultra-évolutifs (Amazon EC2 UltraClusters), permettant aux clients communs d'Amazon et de Nvidia d'étendre les déploiements aux milliers conçus. Puce H200

NVIDIA et AWS collaboreront pour héberger la formation IA en tant que service DGX Cloud de NVIDIA sur AWS. Ce sera le premier cloud DGX à intégrer le GH200 NVL32, offrant aux développeurs une instance unique avec une mémoire partagée maximale. Le DGX Cloud d'AWS améliorera les capacités de formation de l'IA générative de pointe et des grands modèles de langage avec plus de 1 000 milliards de paramètres

NVIDIA et AWS collaborent sur un projet appelé Ceiba pour concevoir le supercalculateur IA alimenté par GPU le plus rapide au monde. Alimenté par le GH200 NVL32 et la technologie d'interconnexion d'Amazon EFA, cet ordinateur est un système massif. Il est équipé de 16 384 super puces GH200 et dispose de 65 exaflops de puissance de traitement IA. NVIDIA prévoit de l'utiliser pour piloter la prochaine vague d'innovation en matière d'IA générative

La version préliminaire d'Amazon Q, le robot client d'entreprise, est désormais en ligne et peut aider les développeurs à développer des applications sur AWS

En plus de fournir des puces et des services cloud, AWS a également publié une version préliminaire d'un chatbot IA appelé Amazon Q. Amazon Q est un nouveau type d'assistant numérique qui utilise la technologie d'IA générative pour fonctionner en fonction des besoins commerciaux des entreprises clientes. Il aide les entreprises clientes à rechercher des informations, à écrire du code et à examiner les indicateurs commerciaux

Q a reçu une formation sur le code et la documentation au sein d'AWS, qui peuvent être utilisées par les développeurs dans le cloud AWS.

Les développeurs peuvent utiliser Q pour créer des applications sur AWS, rechercher les meilleures pratiques, corriger les erreurs et obtenir de l'aide pour rédiger de nouvelles fonctionnalités pour leurs applications. Les utilisateurs peuvent interagir avec Q via des questions-réponses conversationnelles pour acquérir de nouvelles connaissances, rechercher les meilleures pratiques et comprendre comment créer des applications sur AWS sans quitter la console AWS

Amazon ajoutera Q aux programmes destinés aux logiciels d'intelligence d'entreprise, aux travailleurs des centres d'appels et à la gestion logistique. AWS indique que les clients peuvent personnaliser Q en fonction des données de l'entreprise ou des profils personnels

Les questions et réponses conversationnelles sont actuellement disponibles en avant-première dans toutes les régions d'entreprise fournies par AWS

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Quel type de puce IA est nécessaire pour intégrer un grand modèle dans un appareil photo ? La réponse d'Aixin Yuanzhi est AX650N

- Tutoriel sur la mise en œuvre de la fonction de recherche de produits via l'API PHP Amazon

- Promouvoir les données inclusives et l'IA : Amazon Cloud Technology organise la conférence Generative AI Builders

- Les initiés de NVIDIA ont confirmé : le marché chinois lancera trois puces IA personnalisées pour la Chine le 16 novembre