Maison >Périphériques technologiques >IA >NVIDIA dévoile une nouvelle version de TensorRT-LLM : capacité d'inférence multipliée par 5, adaptée au fonctionnement local sur les cartes graphiques de plus de 8 Go et prenant en charge l'API Chat d'OpenAI

NVIDIA dévoile une nouvelle version de TensorRT-LLM : capacité d'inférence multipliée par 5, adaptée au fonctionnement local sur les cartes graphiques de plus de 8 Go et prenant en charge l'API Chat d'OpenAI

- 王林avant

- 2023-11-17 15:06:451186parcourir

Actualités du 16 novembre, la conférence Microsoft Ignite 2023 a débuté aujourd'hui. Les dirigeants de NVIDIA ont assisté à la conférence et ont annoncé une mise à jour de TensorRT-LLM, ajout de la prise en charge de l'API OpenAI Chat.

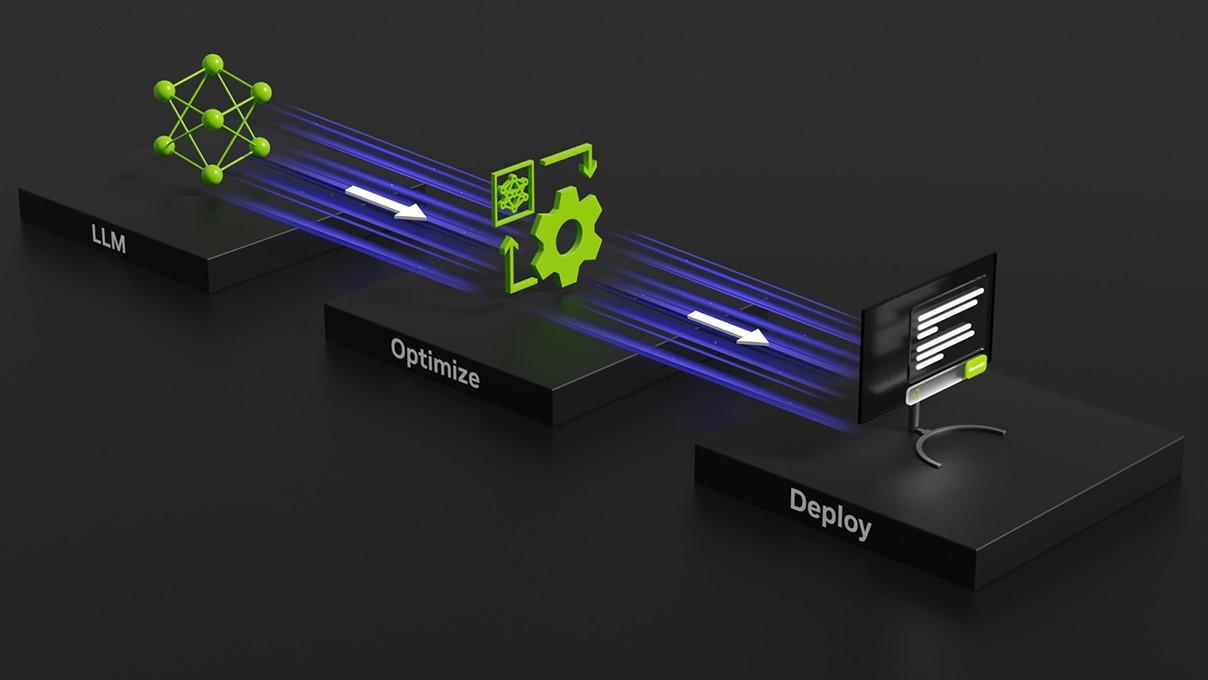

NVIDIA a publié la bibliothèque open source Tensor RT-LLM en octobre de cette année, dans le but de prendre en charge les centres de données et les PC Windows. La plus grande caractéristique de cette bibliothèque open source est que lorsque le PC Windows est équipé du GPU GeForce RTX de NVIDIA, TensorRT-LLM peut augmenter de quatre fois la vitesse d'exécution de LLM sur un PC Windows, comme l'a annoncé NVIDIA lors de la conférence Ignite 2023 aujourd'hui. , ajoutez la prise en charge de l'API Chat d'OpenAI et améliorez les fonctions DirectML pour améliorer les performances des modèles d'IA tels que Llama 2 et Stable Diffusion.

TensorRT-LLM peut être réalisé localement à l'aide de AI Workbench de NVIDIA. Les développeurs peuvent tirer parti de cette boîte à outils unifiée et facile à utiliser pour créer, tester et personnaliser rapidement des modèles d'IA génératifs et des LLM pré-entraînés sur un PC ou un poste de travail. NVIDIA a également lancé une page d'inscription à accès anticipé pour cela

NVIDIA publiera la mise à jour de la version TensorRT-LLM 0.6.0 plus tard ce mois-ci, qui augmentera les performances d'inférence de 5 fois et prendra en charge d'autres LLM grand public tels que Mistral 7B et Nemotron. 3 8B .

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Que signifie le courrier électronique ?

- Quelle est la différence entre raid 0 1 5 10

- 'Microsoft Teams Premium améliore la fonctionnalité GPT avec OpenAI'

- Battez à nouveau OpenAI ! Google lance un modèle universel de 2 milliards de paramètres pour reconnaître et traduire automatiquement plus de 100 langues

- Les programmeurs sont en danger ! On dit qu'OpenAI recrute des troupes d'externalisation dans le monde entier et forme étape par étape les agriculteurs de code ChatGPT.