Maison >Périphériques technologiques >IA >Nvidia lance la puce AI H200 : les performances grimpent de 90 %, la vitesse d'inférence de Llama 2 double

Nvidia lance la puce AI H200 : les performances grimpent de 90 %, la vitesse d'inférence de Llama 2 double

- 王林avant

- 2023-11-14 12:09:541051parcourir

DoNews a rapporté le 14 novembre que NVIDIA a lancé la prochaine génération de puces de supercalculateurs d'intelligence artificielle le 13, heure de Pékin. Ces puces joueront un rôle important dans l'apprentissage profond et les grands modèles de langage (LLM), tels que le GPT-4 d'OpenAI.

La nouvelle génération de puces a fait des progrès significatifs par rapport à la génération précédente et sera largement utilisée dans les centres de données et les superordinateurs pour gérer des tâches complexes telles que la prévision météorologique et climatique, la recherche et le développement de médicaments et l'informatique quantique

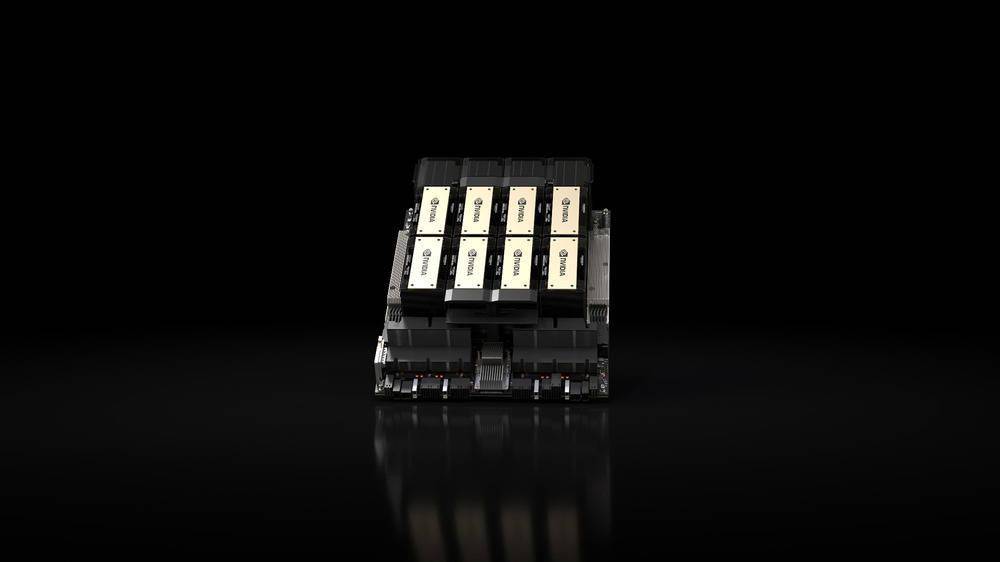

Le produit clé lancé est le GPU HGX H200 basé sur l'architecture "Hopper" de Nvidia, qui est le successeur du GPU H100 et est la première puce de la société à utiliser la mémoire HBM3e. La mémoire HBM3e a une vitesse plus rapide et une plus grande capacité, elle est donc très adaptée aux grandes applications de modèles de langage

NVIDIA a déclaré : « Grâce à la technologie HBM3e, la vitesse de la mémoire du NVIDIA H200 atteint 4,8 To par seconde, la capacité est de 141 Go, soit près du double de celle de l'A100, et la bande passante a également augmenté de 2,4 fois. »

Dans le domaine de l'intelligence artificielle, NVIDIA affirme que la vitesse d'inférence du HGX H200 sur Llama 2 (70 milliards de paramètres LLM) est deux fois plus rapide que celle du H100. HGX H200 sera disponible en configurations 4 et 8 voies, compatibles avec le logiciel et le matériel du système H100Il sera disponible dans tous les types de centres de données (sur site, cloud, cloud hybride et edge) et déployé par Amazon Web Services, Google Cloud, Microsoft Azure et Oracle Cloud Infrastructure, et sera disponible au deuxième trimestre 2024.

Un autre produit clé lancé par NVIDIA cette fois-ci est la « superpuce » GH200 Grace Hopper, qui combine le GPU HGX H200 et le processeur NVIDIA Grace basé sur Arm via l'interconnexion NVLink-C2C de la société. Conçu pour les superordinateurs, il permet aux « scientifiques et chercheurs ». pour résoudre les problèmes les plus difficiles au monde en accélérant les applications complexes d'IA et de HPC qui exécutent des téraoctets de données.

Le GH200 sera utilisé dans « plus de 40 supercalculateurs d'IA dans des centres de recherche, des fabricants de systèmes et des fournisseurs de cloud du monde entier », notamment Dell, Eviden, Hewlett Packard Enterprise (HPE), Lenovo, QCT et Supermicro.

Notamment, le supercalculateur Cray EX2500 de HPE comportera un GH200 à quatre voies, évolutif vers des dizaines de milliers de nœuds de superpuce Grace Hopper

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI