Maison >Périphériques technologiques >IA >L'Université de Stanford publie l'indice de transparence du modèle de base de l'IA, Llama 2 se classe premier mais 'échoue'

L'Université de Stanford publie l'indice de transparence du modèle de base de l'IA, Llama 2 se classe premier mais 'échoue'

- WBOYavant

- 2023-10-21 08:17:01835parcourir

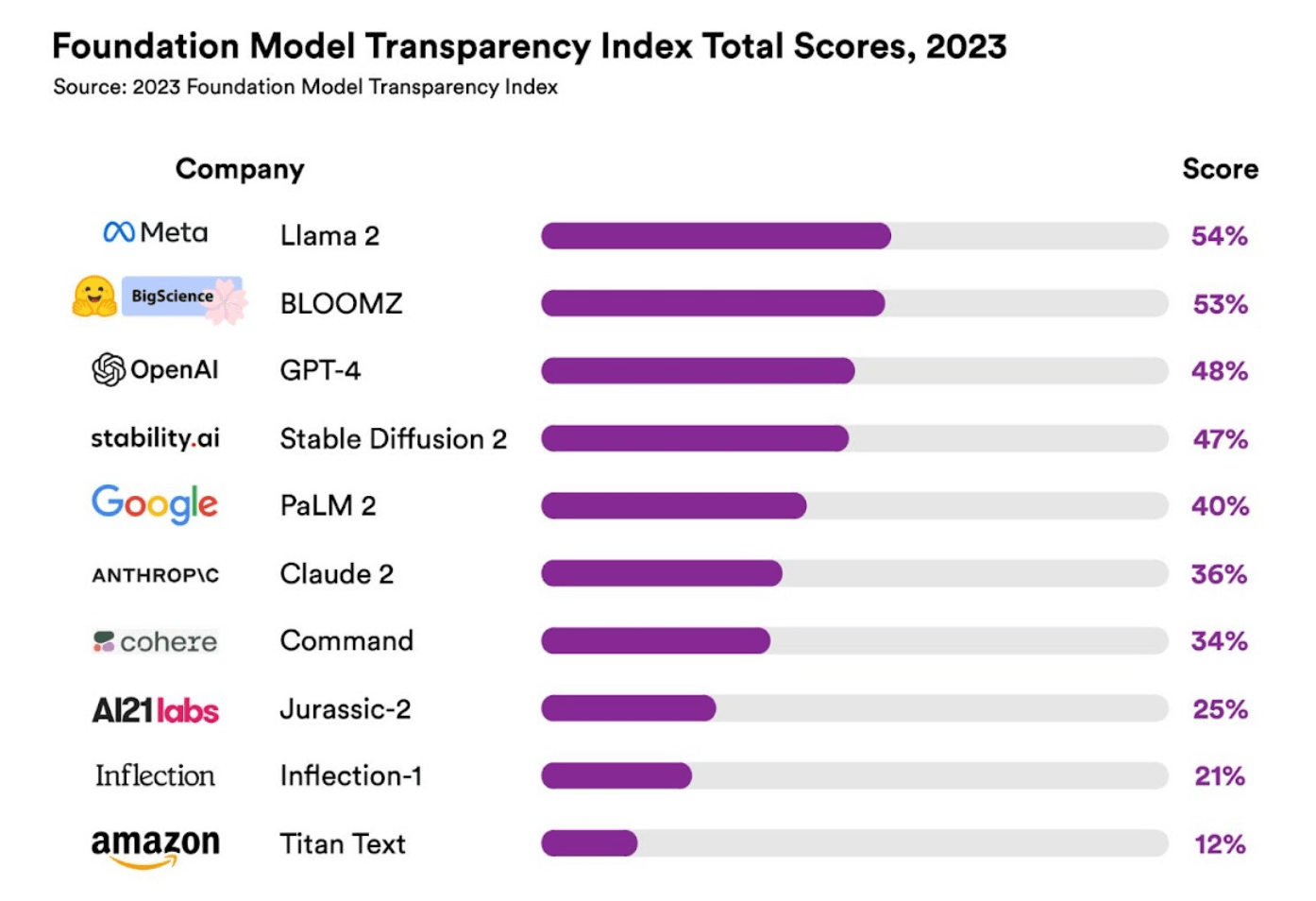

IT House News le 20 octobre, l'Université de Stanford a récemment publié l'« indice de transparence » du modèle de base de l'IA. L'indice d'affichage le plus élevé est le Lama 2 de Meta, mais la « transparence » associée n'est que de 54 %. le marché Presque tous les modèles d'IA sur Internet « manquent de transparence ».

Il est rapporté que cette recherche a été dirigée par Rishi Bommasani, directeur du HAI Center for Basic Model Research (CRFM), et a étudié les 10 modèles de base les plus populaires à l'étranger :

- Lama 2 de Meta,

- BloomZ par BigScience,

- GPT-4 d'OpenAI,

- Diffusion stable de Stability AI,

- Claude de PBC Anthropique,

- PaLM 2 de Google,

- Commandement de Cohere,

- Jurassic-2,

par AI21 Labs- Inflexion d'Inflection AI,

- Titan par Amazon.

Rishi Bommasani estime que le « manque de transparence » a toujours été un problème auquel l'industrie de l'IA est confrontée. En termes d'« indicateurs de transparence » de modèles spécifiques, IT House a constaté que le contenu de l'évaluation pertinent tourne principalement autour des « droits d'auteur des ensembles de données de formation des modèles ». ", "données utilisées pour entraîner le modèle" "Ressources informatiques", "Crédibilité du contenu généré par le modèle", "Capacités propres du modèle", "Risque que le modèle soit incité à générer du contenu préjudiciable", "Confidentialité des utilisateurs en utilisant le modèle", etc., totalisant 100 articles.

L'enquête finale a montré que Lama 2 de Meta était en tête de liste avec 54 % de transparence, tandis que GPT-4 d'OpenAI n'avait que 48 % de transparence et que PaLM 2 de Google se classait cinquième avec 40 %.

▲ Source de l'image Université de Stanford

Parmi les indicateurs spécifiques, celui avec le « meilleur » score parmi les dix premiers modèles est « Bases du modèle ». Ce contenu d'évaluation comprend principalement « si le modèle, l'échelle et l'architecture du modèle sont introduits avec précision lors de la formation du modèle ». , avec une transparence moyenne de 63%. Le moins performant est Impact, qui évalue principalement si le modèle de base « récupèrera les informations utilisateur pour évaluation », avec une transparence moyenne de seulement 11 %.

Percy Liang, directeur du CRFM, a déclaré que la « transparence » du modèle de base commerciale est très importante pour promouvoir la législation sur l'IA, ainsi que les industries et les universités connexes.

Rishi Bommasani a déclaré que la moindre transparence des modèles rend plus difficile pour les entreprises de savoir si elles peuvent s'appuyer en toute sécurité sur des modèles pertinents, et pour les chercheurs de s'appuyer sur ces modèles pour leurs recherches.

Rishi Bommasani estime finalement que les dix modèles de base ci-dessus « échouent » en termes de transparence. Bien que Meta's Llama 2 ait le score le plus élevé, il ne peut pas répondre aux besoins du monde extérieur « La transparence du modèle doit atteindre au moins 82. % pour être reconnu par le monde extérieur."

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI