Maison >Périphériques technologiques >IA >Grande version, « science semblable au cerveau » ou la solution optimale au problème de la consommation d'énergie de calcul et de la longueur du contexte du grand modèle de langage de l'intelligence artificielle !

Grande version, « science semblable au cerveau » ou la solution optimale au problème de la consommation d'énergie de calcul et de la longueur du contexte du grand modèle de langage de l'intelligence artificielle !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-10-20 17:25:03902parcourir

Dans un grand événement de science-fiction et de science, la science-fiction apparaît soudainement dans la réalité.

Récemment, au Shenzhen Advanced Institute, la Fondation pour l'éducation technologique de l'Université de Shenzhen et le Science and Fantasy Growth Fund ont organisé un événement basé sur l'émergence de la science-fiction et de l'IA. Une équipe de Shenzhen appelée Luxi Technology a rendu public pour la première fois son grand modèle de langage d'intelligence artificielle --- NLM (Neuromorphic Generative Pre-trained Language Model), un grand modèle de langage qui n'est pas basé sur Transformer.

Différent de nombreux grands modèles nationaux et étrangers, cette équipe prend comme noyau la science et l'intelligence cérébrales, tout en intégrant les caractéristiques des réseaux neuronaux récurrents et en développant de grands modèles de langage inspirés des caractéristiques informatiques efficaces du cerveau. .

Ce qui est encore plus étonnant, c'est que la consommation de puissance de calcul de ce modèle avec le même niveau de paramètres est 1/22 de l'architecture Transformer ; sur la question de la longueur du contexte, NLM a également donné une réponse parfaite : la fenêtre de longueur du contexte peut atteindre un nombre illimité. la croissance, qu'il s'agisse de la limite de 2k de LLM open source ou d'autres limites de longueur de contexte de 32k ou 100k, ne sont pas un problème.

Qu’est-ce que l’informatique inspirée du cerveau ?

L'informatique de type cérébral est un modèle informatique qui imite la structure et la fonction du cerveau humain. Il simule les connexions du réseau neuronal du cerveau humain en termes d'architecture, de principes de conception et de méthodes de traitement de l'information. Ce type de calcul va au-delà de la simple tentative de simuler les caractéristiques de surface des réseaux de neurones biologiques, mais approfondit la façon de simuler la construction de base des réseaux de neurones biologiques, c'est-à-dire le traitement et le stockage des informations de séquence via des interconnexions à grande échelle de neurones et de synapses. .

Contrairement aux algorithmes traditionnels basés sur des règles, l'informatique inspirée du cerveau s'appuie sur un grand nombre de réseaux neuronaux interconnectés pour apprendre et extraire des informations de manière autonome, tout comme le cerveau humain. Cette approche permet aux systèmes informatiques d’apprendre de l’expérience, de s’adapter à de nouvelles situations, de comprendre des modèles complexes et de prendre des décisions et des prédictions avancées.

En raison de leur haut degré d'adaptabilité et de leurs capacités de traitement parallèle, les systèmes informatiques inspirés du cerveau ont fait preuve d'une efficacité et d'une précision extrêmement élevées dans le traitement du Big Data, la reconnaissance d'images et de la parole, le traitement du langage naturel et d'autres domaines. Non seulement ces systèmes peuvent traiter rapidement des informations complexes et changeantes, mais leur consommation d'énergie et leurs ressources informatiques sont bien inférieures à celles des architectures informatiques traditionnelles, car elles ne nécessitent pas de préprogrammation ni de saisie de données approfondies.

De manière générale, l’informatique inspirée du cerveau ouvre un nouveau paradigme informatique. Il transcende les réseaux de neurones artificiels traditionnels et évolue vers des systèmes intelligents avancés capables de s’auto-apprendre, de s’auto-organiser et même d’avoir un certain degré de conscience de soi.

L'avancement des grands modèles inspirés du cerveau

Lors de l'événement, le Dr Zhou Peng de l'équipe de Lu Xi a expliqué en détail le mécanisme de mise en œuvre du grand modèle de type cerveau.

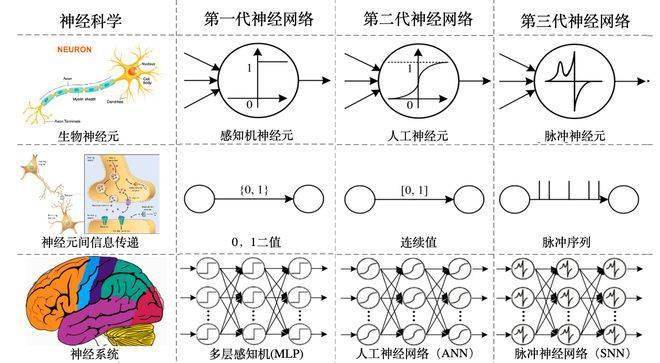

En tant que modèle de réseau neuronal de nouvelle génération, également connu sous le nom de réseau neuronal de type cerveau, il comble les lacunes des deux générations précédentes de réseaux neuronaux.

-Le réseau neuronal de première génération (également connu sous le nom de : perceptron multicouche MLP), qui transmet les signaux 0 et 1, ne peut pas gérer des tâches trop complexes et ne nécessite pas beaucoup de puissance de calcul.

-Le réseau neuronal de deuxième génération, également connu sous le nom de réseau neuronal artificiel, modifie le signal de transmission en un intervalle continu de [0-1], ce qui est suffisamment complexe, mais la surcharge de puissance de calcul a également grimpé en flèche.

- La troisième génération de réseaux neuronaux, également connus sous le nom de réseaux neuronaux de type cerveau, transforme les signaux en séquences d'impulsions, ce qui non seulement est suffisamment complexe, mais rend également le coût de la puissance de calcul contrôlable. Cette séquence d'impulsions est obtenue en imitant la dynamique des structures neuronales. Dans le même temps, la séquence signifie le temps, et le réseau neuronal de troisième génération peut intégrer et produire efficacement les informations temporelles dans les informations.

-Par rapport aux deux générations précédentes de réseaux de neurones, il peut traiter plus efficacement les informations de séquence avec une dimension temporelle et comprendre plus efficacement le monde réel.

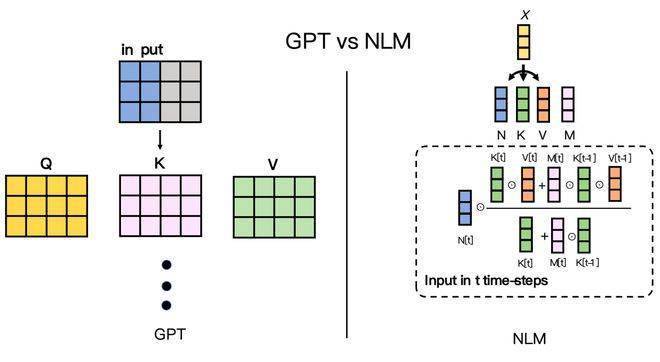

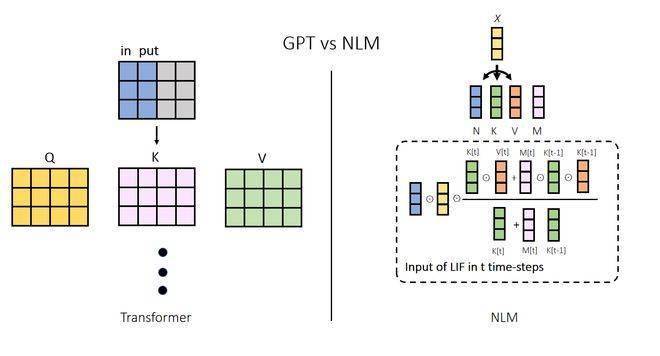

Le principe de raisonnement des grands modèles basés sur des algorithmes de type cerveau est également complètement différent de celui de Transformer. Au cours du processus de raisonnement, il existe des différences significatives dans les mécanismes de fonctionnement du modèle Transformer et du modèle de type cerveau. Chaque fois que le modèle Transformer effectue une inférence, il prend en compte toutes les informations contextuelles pour générer le jeton suivant. Cette opération peut être comparée à celle d'une conversation : chaque fois que nous prononçons un mot, nous devons nous rappeler toutes les expériences de la journée. C’est aussi la principale raison pour laquelle les coûts de calcul des modèles à grande échelle continuent d’augmenter tandis que leurs paramètres continuent de croître.

Relativement parlant, le modèle de type cerveau n'a besoin de s'appuyer que sur son état interne et un jeton pour raisonner. Cela peut être comparé au moment où nous laissons échapper le mot suivant lorsque nous parlons, sans avoir à rappeler spécifiquement toutes les situations précédentes, et le contenu du discours est également intrinsèquement lié aux expériences antérieures. Ce mécanisme est la clé de la capacité du NLM à réduire considérablement la surcharge de puissance de calcul, le rendant plus proche du fonctionnement du cerveau humain et améliorant ainsi considérablement ses performances.

De plus, grâce aux fonctionnalités inspirées du cerveau, la longueur limitée du contexte n'est plus un problème troublant. Le grand modèle NLM utilisant le réseau neuronal de troisième génération ne présente pas de goulot d'étranglement lié à la longueur du contexte, car la puissance de calcul requise pour traiter le jeton suivant n'est pas liée à la longueur du contexte. La longueur du contexte du grand modèle de langage de l'architecture Transformer accessible au public n'est que de 100 Ko. L'augmentation de la longueur du contexte n'est pas seulement une question de surcharge de puissance de calcul, mais aussi une question de « capacité ».

Le contexte de longueur infinie de NLM ouvrira la porte à l'imagination de grandes applications de modèles de langage, qu'il s'agisse d'étudier des rapports financiers complexes, de lire des centaines de milliers de mots de romans ou de faire en sorte que de grands modèles « vous comprennent mieux » grâce à un contexte de longueur illimitée. » peut devenir une réalité.

L'IA aux yeux de l'équipe de Lu Xi

Lors de cet événement, le Dr Zhou Peng, fondateur et directeur technique de Luxi Technology, a expliqué la mission actuelle de l'équipe : donner à toutes choses de la sagesse.

À l'ère de l'intelligence artificielle, l'intelligence artificielle doit être popularisée partout, tout comme Internet et l'électricité sont déjà partout autour de nous. Même si l’intelligence artificielle actuelle est impressionnante en termes de capacités, ses coûts d’exploitation font peser une lourde charge sur les entreprises et les consommateurs. La grande majorité des téléphones mobiles, des montres, des tablettes et des ordinateurs portables ne sont pas en mesure d'exécuter de grands modèles de langage d'intelligence artificielle générative de manière complète, systématique, efficace et de haute qualité dans le cadre de la technologie actuelle. Le seuil de développement d'applications de grands modèles a également entravé de nombreux progrès. les développeurs qui sont intéressés par cela.

Lors de l'événement, Luxi Technology a montré au public comment utiliser le grand modèle « NLM-GPT » en mode hors ligne d'un téléphone Android ordinaire pour accomplir diverses tâches courantes dans le travail et la vie, poussant l'événement à son paroxysme.

- Les téléphones mobiles participant à la démonstration sont équipés d'architectures de puces courantes sur le marché et leurs performances sont similaires à celles des modèles Android courants sur le marché grand public. Avec le téléphone en mode avion et non connecté à Internet, Luxi Technology a présenté un grand modèle de « NLM-GPT » capable de parler aux utilisateurs en temps réel au téléphone, de répondre aux questions posées par les utilisateurs et d'accomplir des tâches telles que la création de poésie, écriture de recettes, connaissances Les instructions telles que la récupération et l'interprétation des fichiers sont très complexes, nécessitent des paramètres de haute performance du matériel de téléphonie mobile et nécessitent traditionnellement une mise en réseau pour être complétées.

- Pendant tout le processus de démonstration, la consommation d'énergie du téléphone mobile est restée stable, avec un impact minimal sur le temps de veille normal et aucun impact sur les performances globales du téléphone mobile.

-Cette démonstration a prouvé avec succès que le grand modèle « NLM-GPT » a le potentiel de fonctionner dans tous les scénarios, avec un rendement élevé, une faible consommation d'énergie et une consommation de trafic nulle dans les petits appareils commerciaux de type C tels que les smartphones et les tablettes. Cela signifie que grâce à l'autonomisation du grand modèle « NLM-GPT », les téléphones mobiles, les montres, les tablettes, les ordinateurs portables et autres appareils peuvent comprendre plus précisément et plus efficacement les véritables intentions des êtres humains et peuvent être utilisés dans diverses situations telles que le bureau. , études, réseaux sociaux, divertissement, etc. Complétez diverses instructions et tâches proposées par les humains avec une qualité supérieure dans des scénarios d'application, améliorant considérablement l'efficacité et la qualité de la production sociale et de la vie humaine.

Luxi Technology estime que le « grand modèle de langage d'intelligence artificielle générative » piloté par une « technologie semblable au cerveau » élargira complètement la pensée, la perception et l'action humaines dans divers domaines tels que l'apprentissage, le travail et la vie, et améliorera la qualité globale de toute l'humanité. . sagesse. Grâce à l’autonomisation d’une technologie semblable au cerveau, l’intelligence artificielle ne sera plus un nouvel agent intelligent qui remplace les humains, mais deviendra un outil intelligent efficace permettant aux humains de changer le monde et de créer un avenir meilleur.

Tout comme les anciens dressaient les chiens et les faucons, le métier de chasseur ne disparaîtra pas du fait de l'émergence des chiens et des faucons. Au contraire, les chasseurs en ont profité et ont maîtrisé le pouvoir que possèdent les chiens et les faucons mais que les humains eux-mêmes ne possèdent pas. Ils peuvent obtenir des proies plus efficacement, fournissant ainsi la puissance et les nutriments nécessaires à la croissance des groupes humains et au développement de la civilisation humaine.

À l'avenir, l'application de grands modèles de langage d'intelligence artificielle dans le travail et la vie quotidienne ne sera plus un projet de système multi-processus complexe, mais équivaudra à « ouvrir le code de paiement lors du paiement », « appuyer sur le déclencheur lors de la prise d'une photo ». ", " glisser "Courte vidéo à trois en un clic" est généralement simple, naturel et fluide. L'équipe de Lu Xi continuera à travailler dans le domaine de l'informatique inspirée du cerveau, mènera des recherches approfondies sur le cerveau, le cadeau le plus précieux de la nature à l'humanité, et intégrera l'intelligence inspirée du cerveau dans la vie quotidienne.

Peut-être que dans un avenir proche, les humains auront davantage de nouveaux partenaires en matière d'intelligence artificielle. Aucun sang ne coule dans leur corps et leur intelligence ne remplacera pas les humains. Avec le soutien d’une technologie inspirée du cerveau, ils travailleront avec nous pour explorer les mystères de l’univers, repousser les frontières de la société et créer un avenir meilleur.

Source : La vie au quotidien

(Source : non défini)

Pour des informations plus intéressantes, veuillez télécharger le client "Jimu News" sur le marché des applications. Veuillez ne pas réimprimer sans autorisation. Vous êtes invités à fournir des indices d'actualité et vous serez payé une fois accepté. La hotline de signalement 24 heures sur 24 est le 027-86777777.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI