Maison >Périphériques technologiques >IA >Ensemble de données synthétiques sur la perception amodale AmodalSynthDrive : une solution innovante pour la conduite autonome

Ensemble de données synthétiques sur la perception amodale AmodalSynthDrive : une solution innovante pour la conduite autonome

- 王林avant

- 2023-10-11 12:09:031404parcourir

- Lien de papier: https://arxiv.org/pdf/2309.06547.pdf

- Dataset Lien: http: //amodalsynthdrive.cs.uni-freiburg.de

abstract

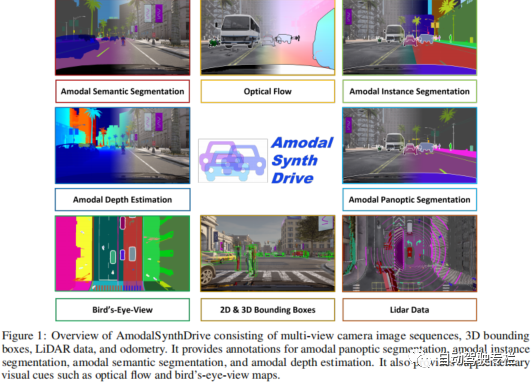

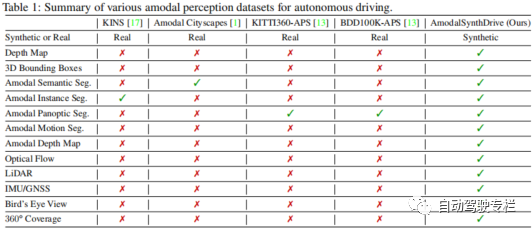

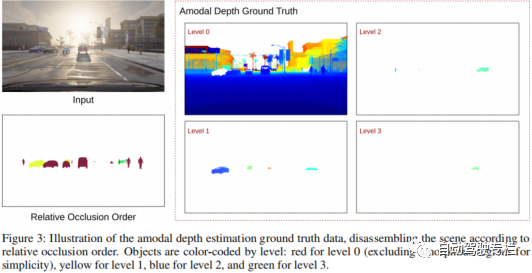

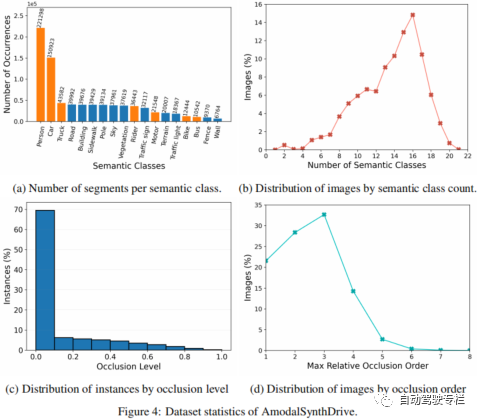

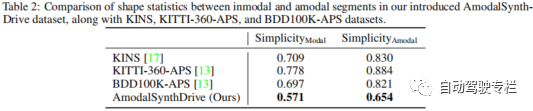

Cet article présente AmodalSynthDrive : un ensemble de données synthétiques de perception amodale pour la conduite autonome. Contrairement aux humains, qui peuvent facilement estimer l’intégralité d’un objet même en présence d’une occlusion partielle, les algorithmes modernes de vision par ordinateur trouvent encore cet aspect extrêmement difficile. L’exploitation de cette perception amodale pour la conduite autonome reste largement inexplorée en raison du manque d’ensembles de données adaptés. La génération de ces ensembles de données est principalement affectée par le coût élevé de l'annotation et par la nécessité d'atténuer les interférences causées par la subjectivité de l'annotateur dans l'étiquetage précis des zones masquées. Pour remédier à ces limitations, cet article présente AmodalSynthDrive, un ensemble de données synthétiques multitâches sur la perception amodale. L'ensemble de données fournit des images de caméra multi-vues, des cadres de délimitation 3D, des données lidar et une odométrie pour 150 séquences de conduite, y compris plus d'un million d'annotations d'objets dans diverses conditions de circulation, météorologiques et d'éclairage. AmodalSynthDrive prend en charge une variété de tâches de compréhension de scène amodale, y compris l'introduction de l'estimation de profondeur amodale pour améliorer la compréhension spatiale. Cet article évalue plusieurs références pour chaque tâche afin d'illustrer les défis et met en place un serveur de référence public.

Principales contributions

Les contributions de cet article sont résumées comme suit :

1) Cet article propose l'ensemble de données AmodalSynthDrive, un ensemble de données synthétique complet de perception amodale pour des scénarios de conduite urbaine avec plusieurs sources de données ;

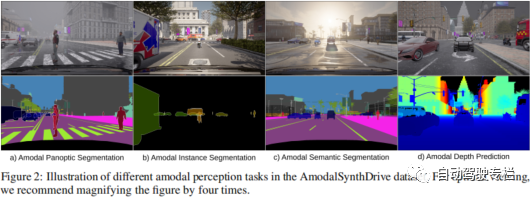

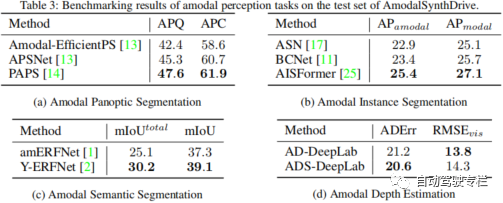

Cet article propose une référence pour les tâches de perception non modale, y compris la segmentation sémantique non modale, la segmentation d'instance non modale et la segmentation panoramique non modale

3) Le but de la nouvelle tâche d'estimation de profondeur non modale Dans la promotion d'une meilleure compréhension spatiale. Cet article démontre la faisabilité de cette nouvelle tâche à travers plusieurs références.

Images et tableaux en papier

Résumé

La perception est une tâche clé pour les véhicules autonomes, mais les méthodes actuelles manquent encore de la compréhension amodale nécessaire pour interpréter des scènes de circulation complexes. Par conséquent, cet article propose AmodalSynthDrive, un ensemble de données de perception synthétique multimodale pour la conduite autonome. Avec des images synthétiques et des nuages de points lidar, nous fournissons un ensemble de données complet qui comprend des données annotées de vérité terrain pour les tâches de base de perception amodale et introduisons une nouvelle tâche pour améliorer la compréhension spatiale appelée estimation de la profondeur amodale. Cet article fournit plus de 60 000 ensembles d'images individuels, chacun contenant une segmentation d'instance amodale, une segmentation sémantique amodale, une segmentation panoramique amodale, un flux optique, des cadres de délimitation 2D et 3D, une profondeur amodale et des données relatives aux figures à vol d'oiseau. Grâce à AmodalSynthDrive, cet article fournit diverses bases de référence et estime que ces travaux ouvriront la voie à de nouveaux types de recherche sur la compréhension des scènes amodales dans des environnements urbains dynamiques

Lien original : https://mp.weixin .qq.com /s/7cXqFbMoljcs6dQOLU3SAQ

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!