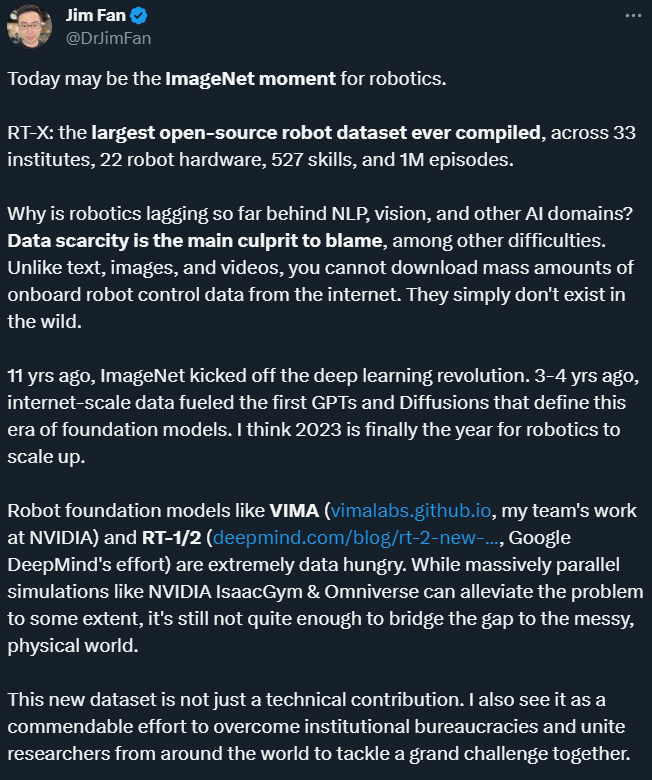

Pourquoi la robotique est-elle loin derrière le traitement du langage naturel (NLP), la vision et d'autres domaines de l'intelligence artificielle ? Entre autres difficultés, le manque de données en est la principale raison. Afin de résoudre ce problème, Google DeepMind et d'autres institutions ont lancé l'ensemble de données ouvert X-Embodiment et ont réussi à former un modèle RT-X plus puissant

Percées continues dans les grands modèles En 2023, la recherche les robots intelligents incarnés qui utilisent de grands modèles comme cerveaux pour faciliter le fonctionnement progressent également rapidement. Il y a plus de 2 mois, Google DeepMind a lancé le premier modèle Vision-Langage-Action (VLA) pour contrôler les robots - RT-2. Ce modèle permet au robot non seulement d'interpréter des instructions humaines complexes, mais également de comprendre l'objet devant lui (même si l'objet n'a jamais été vu auparavant) et d'agir conformément aux instructions. Par exemple, vous demandez au robot de ramasser « l’animal disparu » sur la table. Il attrapera la poupée dinosaure devant lui.

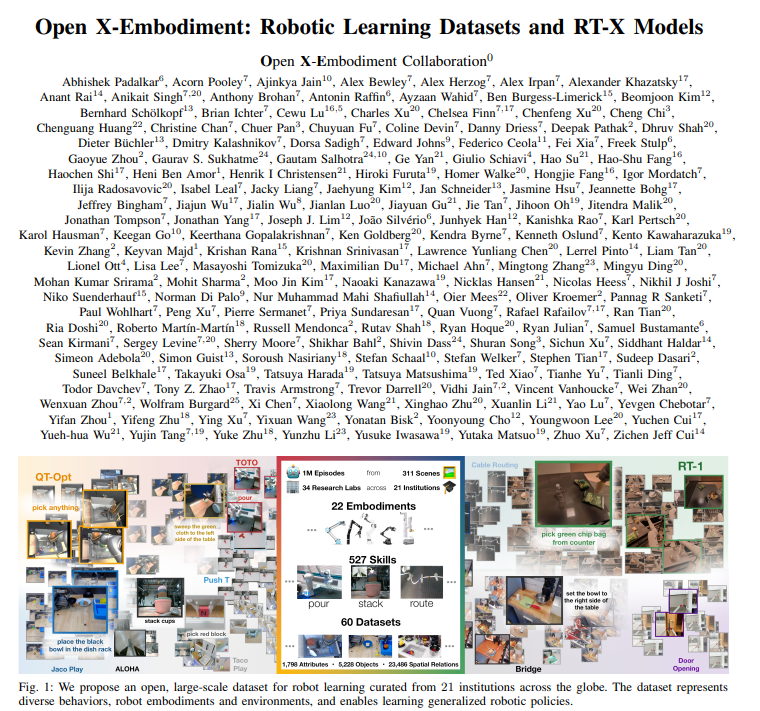

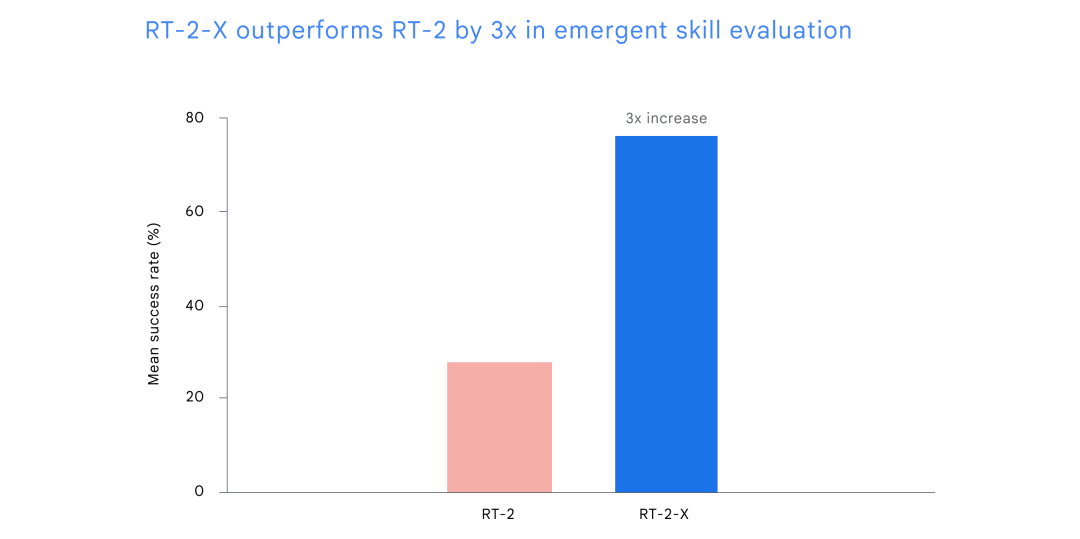

À l'époque, un dirigeant de Google avait déclaré que le RT-2 constituait un grand pas en avant dans la manière dont les robots sont construits et programmés. "En raison de ce changement, nous avons dû repenser l'ensemble de notre plan de recherche." Ce qui est encore plus surprenant, c'est qu'un peu plus de deux mois se sont écoulés et que le modèle du robot de DeepMind s'est encore amélioré et a triplé instantanément. Comment cela est-il réalisé ? Nous savons que les robots sont généralement très spécialisés dans une seule chose, mais ont de faibles capacités générales. En règle générale, vous devez former un modèle pour chaque tâche, robot et environnement. Changer une variable nécessite souvent de repartir de zéro. Mais et si nous pouvions combiner les connaissances de divers domaines de la robotique pour créer un moyen de former des robots universels ? C'est ce que fait DeepMind depuis quelques temps. Ils ont regroupé les données de 22 types de robots différents pour créer l'ensemble de données Open X-Embodiment, puis ont formé un RT-X plus performant (RT-1-X et RT-2-X respectivement). Ils ont testé le modèle RT-1-X dans cinq laboratoires de recherche différents et les résultats ont montré que la nouvelle méthode a eu le même succès sur cinq robots différents couramment utilisés par rapport aux méthodes développées indépendamment pour chaque robot, le taux a augmenté de 50 %. . Ils montrent également que le RT-2-X formé sur l'ensemble de données ci-dessus améliore d'un facteur 2 les performances des compétences robotiques du monde réel, et qu'en apprenant de nouvelles données, le RT-2-X maîtrise de nombreuses nouvelles compétences. Ce travail montre qu'un modèle unique formé sur les données de plusieurs types de robots fonctionne nettement mieux sur plusieurs robots qu'un modèle formé sur les données d'un seul type de robot.

Il convient de mentionner que cette recherche n'a pas été réalisée par DeepMind de manière indépendante, mais est le résultat de leur collaboration avec 33 laboratoires universitaires. Ils s’engagent à développer cette technologie de manière ouverte et responsable. Actuellement, l'ensemble de données Open X-Embodiment et les points de contrôle du modèle RT-1-X sont disponibles pour la vaste communauté de recherche. Jim Fan, scientifique principal en intelligence artificielle chez Nvidia, a déclaré qu'aujourd'hui pourrait être le moment ImageNet pour les robots.

Karol Hausman, chercheuse chez Google, a également exprimé le même soupir : le moment ImageNet des robots est enfin arrivé.

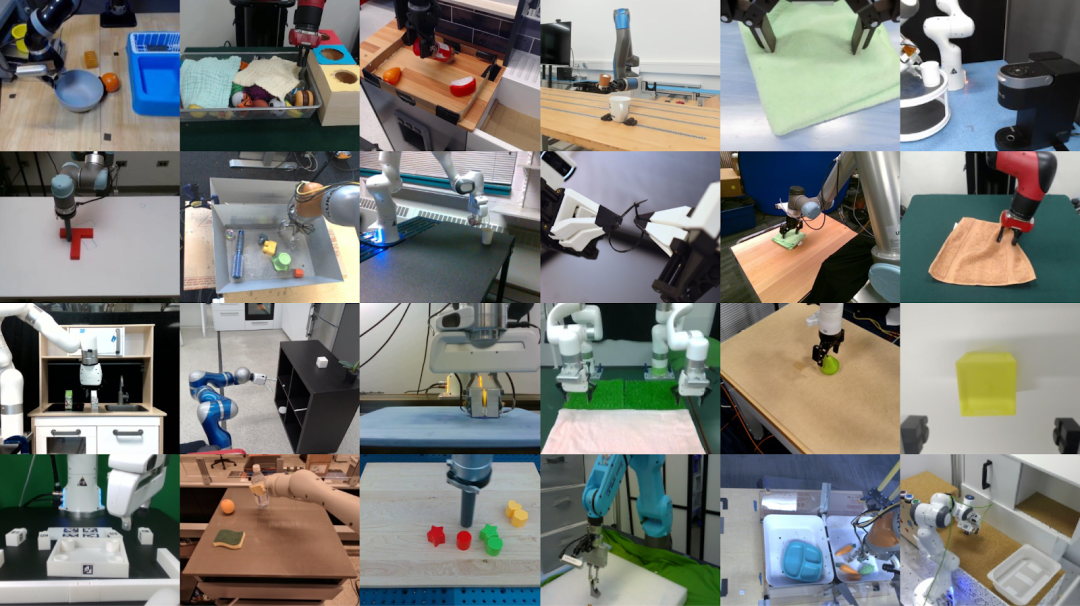

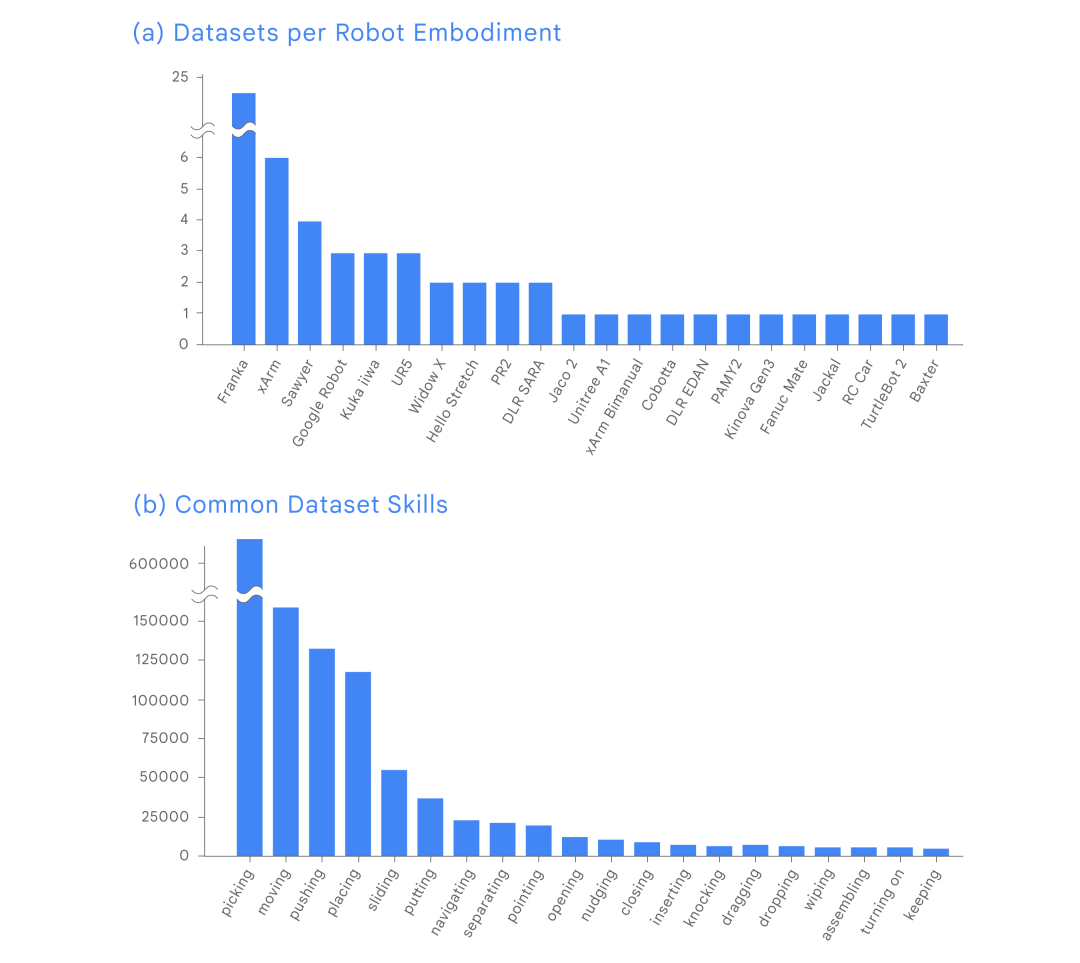

Open X-Embodiment Dataset, ImageNet Moment for RoboticsLes ensembles de données et les modèles formés sur ceux-ci ont joué un rôle clé dans l'avancement des progrès de l'IA. Tout comme ImageNet a fait progresser la recherche en vision par ordinateur, Open X-Embodiment a également fait progresser la robotique. La création d'ensembles de données diversifiés a toujours été la clé de la formation de modèles universels. Ces modèles formés peuvent contrôler de nombreux types de robots différents, suivre différentes instructions, effectuer un raisonnement de base sur des tâches complexes et effectuer efficacement des modifications générales. Cependant, la collecte d’un tel ensemble de données nécessiterait trop de ressources pour un seul laboratoire. À cette fin, DeepMind a collaboré avec des laboratoires de recherche universitaires de 33 institutions pour créer l'ensemble de données Open X-Embodiment. Ils ont collecté des données provenant de 22 instances de robots couvrant plus d'un million de clips démontrant les performances des robots dans plus de 500 compétences et 150 000 tâches. Cet ensemble de données est l’ensemble de données robotique le plus complet de ce type. RT-1-X : Le taux de réussite est augmenté de 50 %

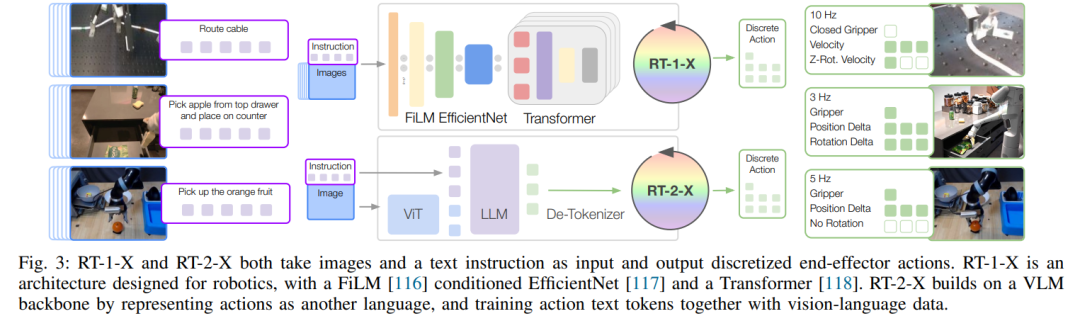

RT-X est basé sur deux modèles de transformateurs robotiques (RT) construits. Plus précisément, ils ont formé RT-1-X à l'aide de RT-1, qui est un réseau de paramètres de 35 millions construit sur l'architecture Transformer et conçu pour le contrôle des robots, comme le montre la figure 3. De plus, ils ont formé RT-2-X sur RT-2, une famille de modèles d'action de langage visuel (VLA) à grande échelle, sur des données de vision et de langage à l'échelle Internet ainsi que sur des données de contrôle de robot entraînées. Pour évaluer RT-1-X, DeepMind l'a comparé à des modèles développés sur des tâches spécifiques, comme l'ouverture de portes. Les résultats montrent que le RT-1-X formé à l'aide de l'ensemble de données Open X-Embodiment surpasse le modèle d'origine de 50 % en moyenne. Le taux de réussite moyen du RT-1-X est 50 % supérieur à celui de la méthode originale. 关于 L'affichage des effets du RT-1-X de différentes agences de coopération

RT-2-X : Nouvelles compétences de déverrouillage sans barrière Afin d'étudier la migration des connaissances de RT-X capacités, DeepMind a mené d’autres expériences. Ces expériences impliquaient des objets et des compétences qui n'étaient pas présents dans l'ensemble de données RT-2, mais qui étaient présents dans l'ensemble de données d'un autre robot. Les résultats ont montré que le RT-2-X réussissait trois fois plus à maîtriser de nouvelles compétences que son précédent meilleur modèle, le RT-2. Cela illustre également qu'une formation conjointe avec des données provenant d'autres plates-formes peut donner au RT-2-X des compétences supplémentaires non présentes dans l'ensemble de données d'origine, lui permettant ainsi d'effectuer de nouvelles tâches. L’image ci-dessus montre la compréhension de RT-2-X de la relation spatiale entre les objets.

Une série de résultats montrent que RT-2-X atteint des compétences auparavant inaccessibles avec RT-2, notamment une meilleure compréhension de l'espace. Par exemple, si nous demandons au robot de « déplacer la pomme près du tissu », ou si nous demandons au robot de « déplacer la pomme vers le tissu », afin d'atteindre les exigences de l'objectif, le robot empruntera des trajectoires complètement différentes. Changez simplement la préposition de « près » à « on » pour ajuster les actions entreprises par le robot.

Une série de résultats montrent que RT-2-X atteint des compétences auparavant inaccessibles avec RT-2, notamment une meilleure compréhension de l'espace. Par exemple, si nous demandons au robot de « déplacer la pomme près du tissu », ou si nous demandons au robot de « déplacer la pomme vers le tissu », afin d'atteindre les exigences de l'objectif, le robot empruntera des trajectoires complètement différentes. Changez simplement la préposition de « près » à « on » pour ajuster les actions entreprises par le robot.

RT-2-X montre que l'intégration de données provenant d'autres robots dans la formation RT-2-X peut améliorer l'éventail de tâches du robot, mais seulement si une architecture de capacité suffisamment élevée est utilisée.

RT-2-X (55B) : l'un des plus grands modèles à ce jour effectuant des tâches inconnues dans un laboratoire universitaire Même chose

La recherche en robotique en est à ses débuts passionnants. Cette nouvelle recherche de DeepMind montre qu’en adaptant l’apprentissage avec des données plus diversifiées et de meilleurs modèles, il pourrait être possible de développer des robots d’assistance plus utiles. La collaboration et le partage de ressources avec des laboratoires du monde entier sont essentiels pour faire progresser la recherche en robotique de manière ouverte et responsable. DeepMind espère réduire les barrières et accélérer la recherche en ouvrant les sources de données et en fournissant des modèles sécurisés mais limités. L’avenir de la robotique dépend de l’apprentissage des robots les uns des autres et, surtout, de la possibilité pour les chercheurs d’apprendre les uns des autres.

La recherche en robotique en est à ses débuts passionnants. Cette nouvelle recherche de DeepMind montre qu’en adaptant l’apprentissage avec des données plus diversifiées et de meilleurs modèles, il pourrait être possible de développer des robots d’assistance plus utiles. La collaboration et le partage de ressources avec des laboratoires du monde entier sont essentiels pour faire progresser la recherche en robotique de manière ouverte et responsable. DeepMind espère réduire les barrières et accélérer la recherche en ouvrant les sources de données et en fournissant des modèles sécurisés mais limités. L’avenir de la robotique dépend de l’apprentissage des robots les uns des autres et, surtout, de la possibilité pour les chercheurs d’apprendre les uns des autres.

Ces travaux prouvent que le modèle peut être généralisé dans différents environnements, et que ses performances sont significativement améliorées que ce soit sur les robots de Google DeepMind ou sur les robots de différentes universités à travers le monde. Des recherches futures pourraient explorer comment combiner ces avancées avec les propriétés d’auto-amélioration de RoboCat, permettant au modèle de s’améliorer continuellement en fonction de sa propre expérience. Une autre orientation future consiste à explorer davantage comment le mélange de différents ensembles de données affecte la généralisation des agents inter-incarnés, et comment cette généralisation est réalisée. Si vous souhaitez en savoir plus sur RT-X, vous pouvez vous référer à cet article publié par DeepMind :

Lien article : https://robotics-transformer-x.github.io / paper.pdf

Lien du projet : https://robotics-transformer-x.github.io/Lien de référence : https://www.deepmind.com/blog/scaling - apprentissage ultérieur sur de nombreux types de robots différents

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

La recherche en robotique en est à ses débuts passionnants. Cette nouvelle recherche de DeepMind montre qu’en adaptant l’apprentissage avec des données plus diversifiées et de meilleurs modèles, il pourrait être possible de développer des robots d’assistance plus utiles. La collaboration et le partage de ressources avec des laboratoires du monde entier sont essentiels pour faire progresser la recherche en robotique de manière ouverte et responsable. DeepMind espère réduire les barrières et accélérer la recherche en ouvrant les sources de données et en fournissant des modèles sécurisés mais limités. L’avenir de la robotique dépend de l’apprentissage des robots les uns des autres et, surtout, de la possibilité pour les chercheurs d’apprendre les uns des autres.

La recherche en robotique en est à ses débuts passionnants. Cette nouvelle recherche de DeepMind montre qu’en adaptant l’apprentissage avec des données plus diversifiées et de meilleurs modèles, il pourrait être possible de développer des robots d’assistance plus utiles. La collaboration et le partage de ressources avec des laboratoires du monde entier sont essentiels pour faire progresser la recherche en robotique de manière ouverte et responsable. DeepMind espère réduire les barrières et accélérer la recherche en ouvrant les sources de données et en fournissant des modèles sécurisés mais limités. L’avenir de la robotique dépend de l’apprentissage des robots les uns des autres et, surtout, de la possibilité pour les chercheurs d’apprendre les uns des autres.