Maison >Périphériques technologiques >Industrie informatique >Alibaba Cloud a annoncé qu'il ouvrirait le modèle Qwen-14B de 14 milliards de paramètres de Tongyi Qianwen et son modèle de dialogue, qui seront gratuits pour un usage commercial.

Alibaba Cloud a annoncé qu'il ouvrirait le modèle Qwen-14B de 14 milliards de paramètres de Tongyi Qianwen et son modèle de dialogue, qui seront gratuits pour un usage commercial.

- 王林avant

- 2023-09-26 20:05:012673parcourir

Alibaba Cloud a annoncé aujourd'hui un projet open source appelé Qwen-14B, qui comprend un modèle paramétrique et un modèle de conversation. Ce projet open source permet une utilisation commerciale gratuite

Déclaration de ce site : Alibaba Cloud a déjà open source un modèle de paramètres Qwen-7B d'une valeur de 7 milliards, et le volume de téléchargement a dépassé 1 million de fois en plus d'un mois

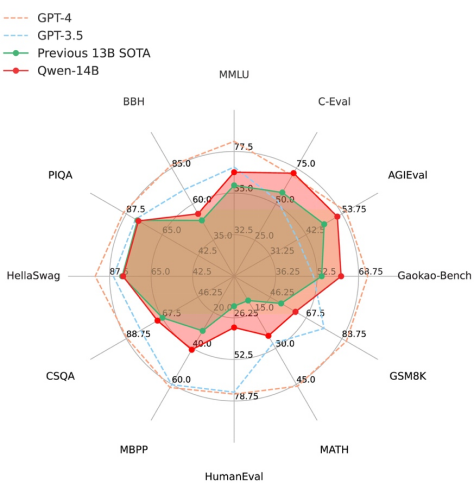

À en juger par les données fournies par Alibaba Cloud, Qwen-14B surpasse les modèles de même taille dans plusieurs évaluations faisant autorité, et certains indicateurs sont même proches de Llama2-70B.

Selon les rapports, Qwen-14B est un modèle open source hautes performances prenant en charge plusieurs langues. Ses données d'entraînement globales dépassent 3 000 milliards de jetons, ont des capacités de raisonnement, de cognition, de planification et de mémoire plus fortes, et prennent en charge une longueur maximale de fenêtre de contexte de 8 000

En revanche, Qwen-14B-Chat est basé sur le modèle de base Le modèle de dialogue obtenu grâce SFT raffiné peut apporter un contenu plus précis, plus conforme aux préférences humaines, et élargit également l'imagination et la richesse de la création de contenu.

À partir d'aujourd'hui, les utilisateurs peuvent télécharger directement des modèles depuis la communauté Alibaba Moda, et peuvent également accéder et appeler Qwen-14B et Qwen-14B-Chat via la plateforme Alibaba Cloud Lingji.

Zhou Jingren, CTO d'Alibaba Cloud, a déclaré qu'Alibaba Cloud continuera à adopter l'open source et l'ouverture et à promouvoir la construction du grand écosystème modèle chinois. Alibaba Cloud croit fermement au pouvoir de l'open source et prend la tête des grands modèles open source auto-développés, dans l'espoir d'apporter plus rapidement la technologie des grands modèles aux petites et moyennes entreprises et aux développeurs individuels.

Adresse de l'expérience d'espace de création de code zéro modèle :

https://modelscope.cn/stud/qwen/Qwen-14B-Chat-Demo

Configuration et installation de l'environnement

python version 3.8 et supérieure

-

Pytorch version 1.12 et supérieure, version 2.0 et supérieure recommandée

Il est recommandé d'utiliser CUDA 11.4 et supérieure (les utilisateurs de GPU doivent considérer cette option)

Étapes d'utilisation

Remarque : Exécuter sous la configuration de l'environnement de PAI-DSW (vous pouvez utiliser une seule carte pour exécuter, la mémoire vidéo minimale requise est de 11 Go)

Lien du modèle Qwen-14B-Chat :

https://modelscope.cn/models/qwen/Qwen -14B-Chat

Lien modèle Qwen-14B :

https://modelscope.cn/models/qwen/Qwen-14B

Lien modèle Qwen-14B-Chat-Int4 :

https://www .modelscope.cn/models/qwen/Qwen-14B-Chat-Int4

La communauté prend en charge le téléchargement direct du repo du modèle :

from modelscope.hub.snapshot_download import snapshot_download<br>model_dir = snapshot_download('qwen/Qwen-14B-Chat', 'v1.0.0')

Déclaration publicitaire : Saut externe liens (y compris, mais sans s'y limiter, les hyperliens) contenus dans l'article, code QR, mot de passe, etc.), utilisés pour transmettre plus d'informations et gagner du temps de sélection. Les résultats sont uniquement à titre de référence. Tous les articles de ce site incluent cette déclaration.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tutoriel détaillé pour installer php7.3 sur Alibaba Cloud centos7.6

- Que dois-je faire si la base de données Alibaba Cloud ne parvient pas à se connecter à phpmyadmin ?

- [Compilation et partage] Les 15 meilleurs projets open source front-end d'Alibaba, voyez lesquels vous avez utilisés !

- Le « moment Android » des grands modèles d'IA domestiques est arrivé ! Alibaba Cloud Tongyi Qianwen est gratuit, open source et disponible pour un usage commercial