Maison >Périphériques technologiques >IA >Le modèle Alibaba Cloud Tongyi Qianwen 14B est open source ! Les performances surpassent celles du Llama2 et des autres modèles de même taille

Le modèle Alibaba Cloud Tongyi Qianwen 14B est open source ! Les performances surpassent celles du Llama2 et des autres modèles de même taille

- 王林avant

- 2023-09-25 22:25:051085parcourir

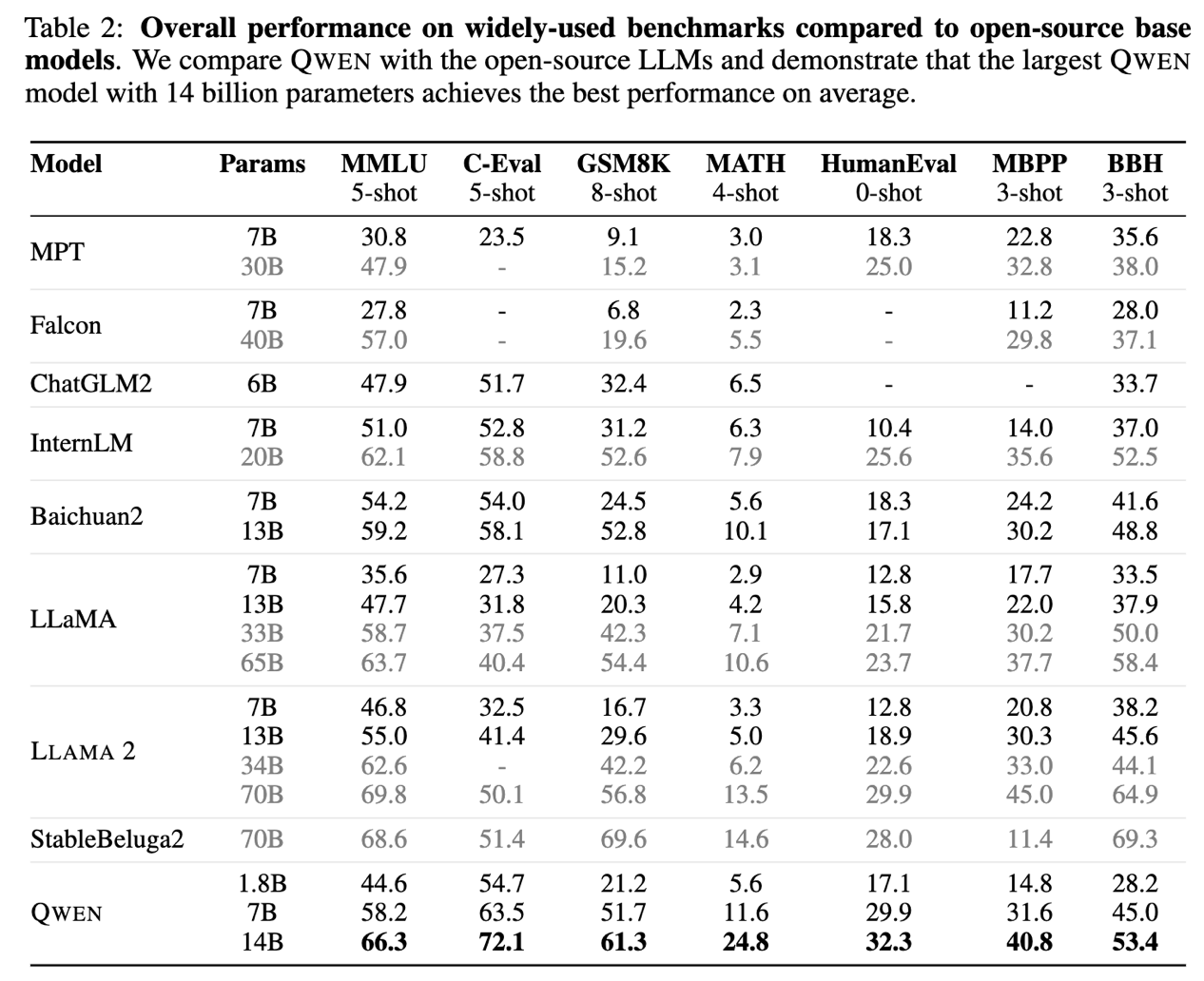

Le 25 septembre 2021, Alibaba Cloud a publié le projet open source Tongyi Qianwen, modèle à 14 milliards de paramètres Qwen-14B et son modèle de conversation Qwen-14B-Chat, et ils sont gratuits pour un usage commercial. Qwen-14B a obtenu de bons résultats dans plusieurs évaluations faisant autorité, surpassant les modèles de même taille, et possède même certains indicateurs proches de Llama2-70B. Auparavant, Alibaba Cloud a également open source le modèle Qwen-7B à 7 milliards de paramètres. Le nombre de téléchargements a dépassé le million en un peu plus d'un mois, ce qui en fait un projet populaire dans la communauté open source

Qwen-14B est un modèle haute performance. qui prend en charge plusieurs langues. Le modèle open source utilise plus de données de haute qualité que les modèles similaires, et les données de formation globales dépassent 3 000 milliards de jetons, ce qui rend le modèle plus puissant en termes de capacités de raisonnement, de cognition, de planification et de mémoire. Qwen-14B prend en charge une longueur maximale de fenêtre contextuelle de 8 Ko.

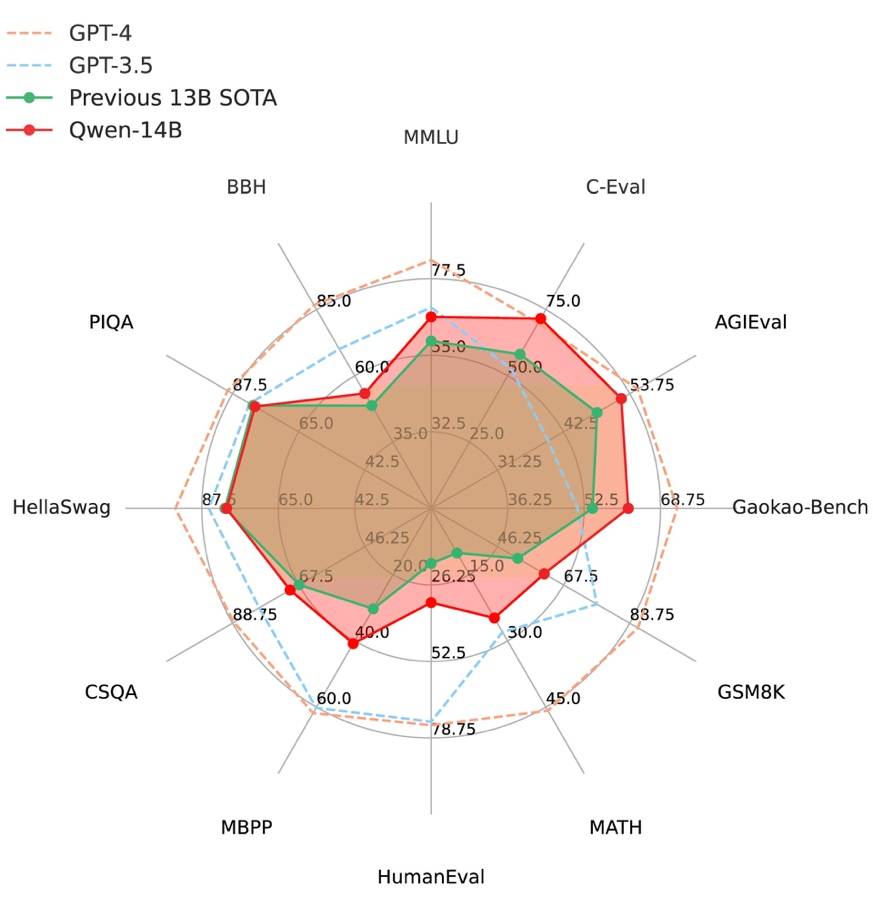

Figure 1 : Qwen-14B a surpassé les grands modèles SOTA de la même échelle dans tous les aspects dans douze évaluations faisant autorité

Qwen-14B-Chat est un modèle de conversation obtenu par SFT fin sur le modèle de base. Grâce aux performances puissantes du modèle de base, la précision du contenu généré par Qwen-14B-Chat a été grandement améliorée et il est plus conforme aux préférences humaines. L'imagination et la richesse de la création de contenu ont également été considérablement élargies.

Qwen dispose d'excellentes capacités d'appel d'outils, qui peuvent aider les développeurs à créer plus rapidement des agents basés sur Qwen. Les développeurs peuvent utiliser des instructions simples pour apprendre à Qwen à utiliser des outils complexes, tels que l'utilisation de l'outil Code Interpreter pour exécuter du code Python pour des calculs mathématiques complexes, l'analyse de données et le dessin de graphiques. En outre, Qwen peut également développer des « assistants numériques avancés » dotés de fonctionnalités telles que les questions et réponses multidocuments et l'écriture de textes longs. Les grands modèles de langage avec des niveaux de paramètres de l'ordre de plusieurs dizaines de milliards sont actuellement le choix courant des développeurs pour développer et itérer des applications. Qwen-14B a encore amélioré la limite supérieure de performance des modèles de petite taille et a obtenu les meilleurs résultats dans 12 évaluations faisant autorité, notamment MMLU, C-Eval, GSM8K, MATH, GaoKao-Bench, etc., surpassant SOTA (State-Of) en toutes les évaluations. -The-Art) grand modèle, a également complètement surpassé Llama-2-13B. Dans le même temps, le Qwen-7B a également été entièrement mis à niveau, avec des indicateurs de base augmentés jusqu'à 22,5 %

Utilisateurs Vous pouvez télécharger des modèles directement depuis la communauté Moda, ou accéder et appeler Qwen-14B et Qwen-14B-Chat via la plateforme Alibaba Cloud Lingji. Alibaba Cloud fournit aux utilisateurs des services complets, y compris la formation, l'inférence, le déploiement et le réglage du modèle.

En août, Alibaba Cloud a ouvert le modèle de base de 7 milliards de paramètres Tongyi Qianwen Qwen-7B, qui a été lancé sur HuggingFace et Github. liste des tendances. En un peu plus d'un mois, les téléchargements cumulés ont dépassé le million. Plus de 50 modèles basés sur Qwen sont apparus dans la communauté open source, et de nombreux outils et frameworks bien connus de la communauté ont intégré Qwen.

Tongyi Qianwen est le modèle à grande échelle le plus approfondi et le plus utilisé en Chine. Il existe déjà de nombreuses applications nationales connectées à Tongyi Qianwen, et le nombre d'utilisateurs actifs mensuels de ces applications a dépassé les 100 millions. De nombreuses petites et moyennes entreprises, instituts de recherche scientifique et développeurs individuels utilisent Tongyi Qianwen pour développer des modèles ou des produits d'application exclusifs à grande échelle. Par exemple, Taobao, DingTalk et Future Wizards d'Alibaba, ainsi que des instituts de recherche scientifique externes et des entreprises entrepreneuriales

Tongyi Qianwen est le modèle à grande échelle le plus approfondi et le plus utilisé en Chine. Il existe déjà de nombreuses applications nationales connectées à Tongyi Qianwen, et le nombre d'utilisateurs actifs mensuels de ces applications a dépassé les 100 millions. De nombreuses petites et moyennes entreprises, instituts de recherche scientifique et développeurs individuels utilisent Tongyi Qianwen pour développer des modèles ou des produits d'application exclusifs à grande échelle. Par exemple, Taobao, DingTalk et Future Wizards d'Alibaba, ainsi que des instituts de recherche scientifique externes et des entreprises entrepreneuriales

Zhejiang University and Higher Education Press ont développé le modèle vertical d'éducation Zhihai-Sanle basé sur Qwen-7B, qui a été utilisé dans 12 pays. à travers le pays Application dans toutes les universités. Le modèle a des fonctions telles que la réponse intelligente aux questions, la génération de questions de test, la navigation dans l'apprentissage et l'évaluation de l'enseignement. Le modèle a été fourni sur la plateforme Alibaba Cloud Lingji et peut être appelé avec une seule ligne de code. Zhejiang Youlu Robot Technology Co., Ltd. a intégré Qwen-7B dans son robot de nettoyage des routes, permettant au robot d'interagir avec les utilisateurs en temps réel et de comprendre leurs besoins. Il peut analyser et désassembler les instructions de haut niveau de l'utilisateur, effectuer une analyse logique et une planification des tâches, et ainsi terminer la tâche de nettoyage.

Le directeur technique d'Alibaba Cloud, Zhou Jingren, a déclaré qu'Alibaba Cloud continuera à soutenir et à promouvoir l'open source et s'engage à promouvoir l'open source. construction du grand écosystème modèle chinois . Alibaba Cloud croit fermement au pouvoir de l'open source et est le premier à ouvrir sa propre technologie à grand modèle, dans l'espoir de permettre à davantage de petites et moyennes entreprises et de développeurs individuels d'accéder et d'appliquer plus rapidement la technologie à grand modèle

Alibaba Cloud est également à la tête de la plus grande IA de Chine. La construction de ModelScope, une communauté modèle open source, unit la puissance de l'ensemble de l'industrie pour promouvoir conjointement la vulgarisation et l'application de la technologie des grands modèles. Au cours des deux derniers mois, le nombre de téléchargements de modèles dans la communauté Moda est passé de 45 millions à 85 millions, soit une augmentation de près de 100 %

Le contenu réécrit est le suivant : Pièce jointe :

Adresse du modèle de la communauté Moda :

- https://www.php.cn/link/7463afe23eae7efe3c72737a5d3d693f

- https://www.php.cn/link/9578a63fbe545bd82cc5bbe749636af1

Quelle est l'expérience du modèle communautaire Moda ?

Adresse de la plateforme Alibaba Cloud Lingji

- https://www.php.cn/link/e44cf9762b402f 5d8b5bc36f60304a15

- https ://www.php.cn/link/1662d1307aaa81230b651ecf00d27180

Le contenu qui doit être réécrit est : Lien papier Qwen

https://www.php.cn/link/da796dcc49ab9fc5ac26db17e02a9 e33

Github :

HuggingFace :

- https://www.php.cn/link/0247f3dd84906223 785fdd b18353bafe

- https://www .php.cn/link/0247f3dd84906223785fddb18353bafe-Chat

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment ChatGPT affecte-t-il l'industrie chinoise des puces ?

- Ministère de la Science et de la Technologie : apporter un soutien fort à l'intelligence artificielle en tant qu'industrie stratégique émergente

- Tesla envisage de créer une usine de véhicules électriques en Inde pour dynamiser l'industrie indienne des véhicules électriques

- Xiaoyu Yilian est apparue à l'Exposition internationale de l'industrie intelligente de Chine

- Construisons ensemble le Guangxi numérique et allons ensemble vers un avenir numérique ! La conférence écologique de l'industrie de l'intelligence artificielle du Guangxi Kunpeng Shengteng 2023 s'est tenue avec succès