Maison >Périphériques technologiques >IA >Robot caché dans iPhone : basé sur l'architecture GPT-2, avec emoji tokenizer, développé par des anciens élèves du MIT

Robot caché dans iPhone : basé sur l'architecture GPT-2, avec emoji tokenizer, développé par des anciens élèves du MIT

- PHPzavant

- 2023-09-20 13:05:09986parcourir

Des passionnés ont révélé le "secret" du Transformer d'Apple

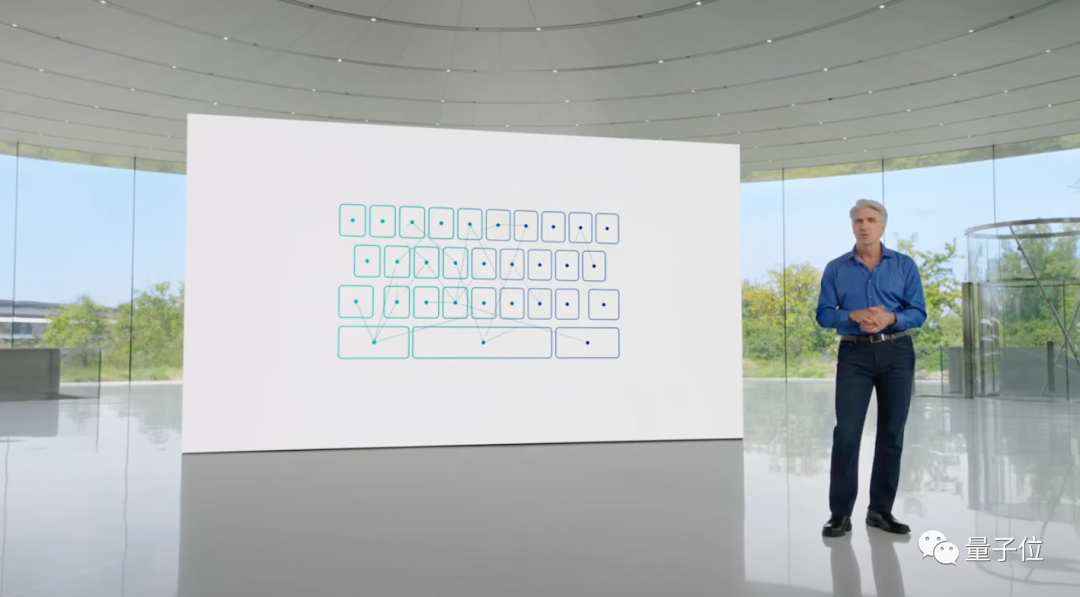

Sous l'influence de la vague des grands modèles, même le conservateur Apple mentionnera certainement "Transformer" à chaque conférence de presse

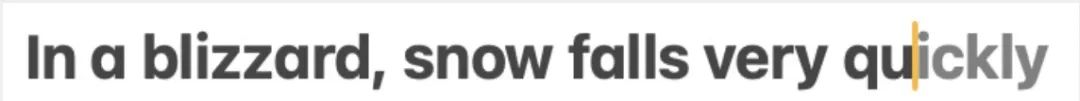

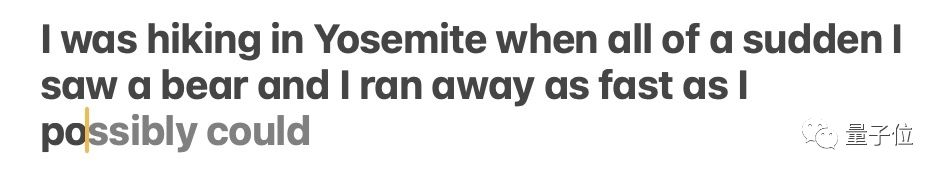

Par exemple, cette année à la WWDC, Apple a annoncé que les nouvelles versions d'iOS et de macOS auront des modèles de langage Transformer intégrés pour fournir des méthodes de saisie avec des capacités de prédiction de texte.

Bien que les responsables d'Apple n'aient pas révélé plus d'informations, les passionnés de technologie ne peuvent pas attendre

Un gars nommé Jack Cook a ouvert avec succès un nouveau chapitre de la version bêta de macOS Sonoma et a découvert de manière inattendue beaucoup de nouvelles informations

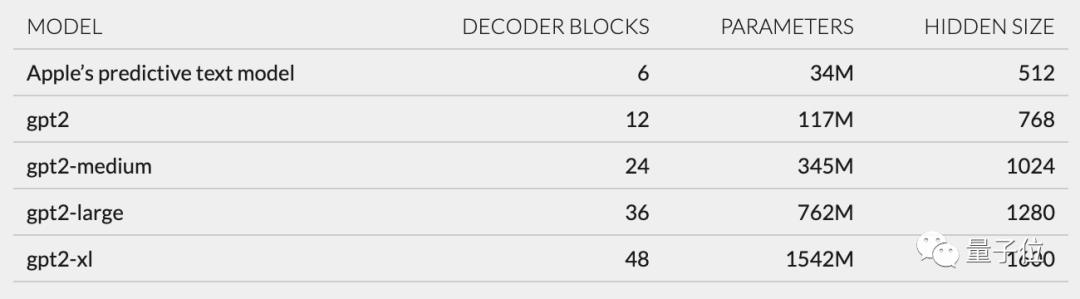

- En termes de modèle architecture, Cook estime que le modèle linguistique d'Apple est plus susceptible d'être basé sur GPT-2.

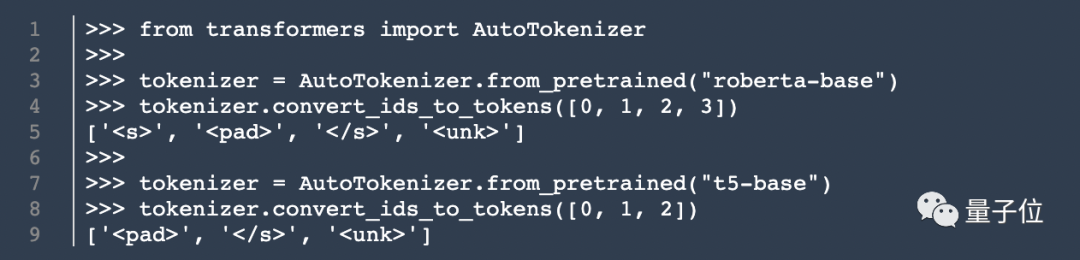

- En termes de tokenizer, emoticon est très important parmi eux.

- De nombreux fichiers dans unilm.bundle n'existent pas dans macOS Ventura (13.5), mais n'apparaissent que dans la nouvelle version de macOS Sonoma bêta (14.0).

- Il existe un fichier sp.dat dans unilm.bundle, qui peut être trouvé dans les versions bêta de Ventura et de Sonoma, mais la version bêta de Sonoma a été mise à jour avec un ensemble de jetons qui ressemblent évidemment à un tokenizer.

- Le nombre de jetons dans sp.dat peut correspondre aux deux fichiers dans unilm.bundle - unilm_joint_cpu.espresso.shape et unilm_joint_ane.espresso.shape. Ces deux fichiers décrivent la forme de chaque couche dans le modèle Espresso/CoreML.

. Il a trouvé un ensemble de 15 000 jetons dans unilm.bundle/sp.dat. Il convient de noter qu'il contient 100 emoji. Bien que ce Cook ne soit pas ce Cook, mon article de blog a quand même attiré beaucoup d'attention dès sa publication Sur la base de ses découvertes, les internautes ont discuté avec enthousiasme de l'expérience utilisateur et des avancées d'Apple applications technologiques. Retour à Jack Cook lui-même. Il est diplômé du MIT avec un baccalauréat et une maîtrise en informatique, et étudie actuellement pour une maîtrise en sciences sociales de l'Internet à l'Université d'Oxford. Il a précédemment effectué un stage chez NVIDIA, se concentrant sur la recherche de modèles de langage tels que BERT. Il est également ingénieur R&D senior pour le traitement du langage naturel au New York Times Cook révèle Cook

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!