Maison >Périphériques technologiques >IA >Jusqu'à 38 To de données ont été accidentellement divulguées ! L'équipe de recherche en IA de Microsoft 'sème le trouble' Comment assurer la sécurité des données ?

Jusqu'à 38 To de données ont été accidentellement divulguées ! L'équipe de recherche en IA de Microsoft 'sème le trouble' Comment assurer la sécurité des données ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-09-19 17:33:091408parcourir

Financial Associated Press, 19 septembre (éditeur Xiaoxiang)Depuis la montée de l'engouement pour l'intelligence artificielle générative cette année, il y a eu des différends constants sur la sécurité des données. Selon les dernières recherches d'une société de cybersécurité, l'équipe de recherche en intelligence artificielle de Microsoft a accidentellement divulgué il y a quelques mois une grande quantité de données privées sur la plate-forme de développement de logiciels GitHub, qui comprenaient plus de 30 000 informations internes sur l'équipe Microsoft.

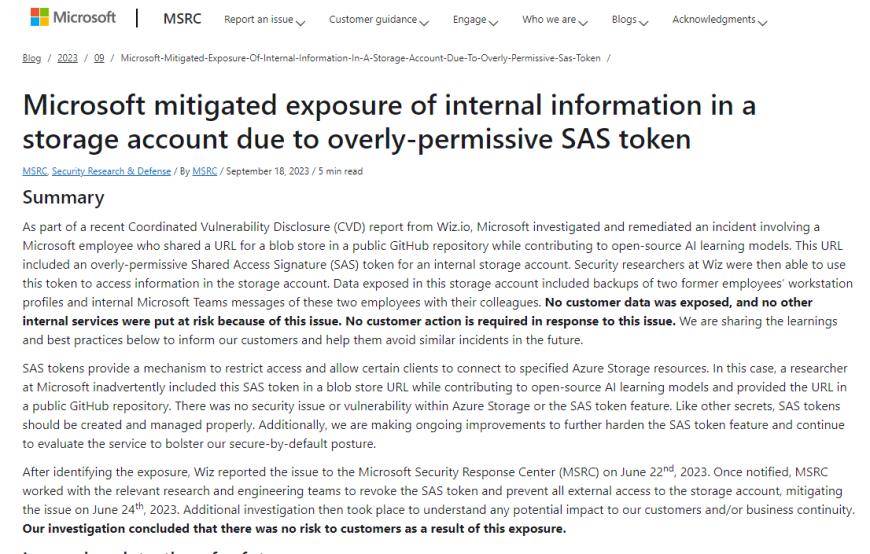

Une équipe de la société de sécurité cloud Wiz a découvert que des données de formation open source avaient été divulguées par l'équipe de recherche de Microsoft lors de leur publication sur GitHub en juin. Les données hébergées dans le cloud ont été divulguées via un lien mal configuré.

Selon un article de blog de Wiz, l'équipe de recherche en IA de Microsoft a initialement publié les données de formation open source sur GitHub. Cependant, en raison d'une mauvaise configuration du jeton SAS, ils ont configuré par erreur les autorisations pour accorder l'intégralité du compte de stockage et ont également donné à l'utilisateur un contrôle total au lieu de simplement des autorisations en lecture seule. Cela signifie qu'ils peuvent supprimer et écraser les fichiers existants

Selon Wiz, les 38 To de données divulguées comprennent des sauvegardes sur disque des ordinateurs personnels de deux employés de Microsoft. Ces sauvegardes contiennent des mots de passe et des clés pour les services Microsoft et plus de 30 000 informations internes de l'équipe Microsoft de 359 employés de Microsoft.

Les chercheurs de Wiz ont souligné que le partage de données ouvertes est une partie importante de la formation en IA. Cependant, s’il n’est pas utilisé correctement, le partage de données à grande échelle peut également entraîner d’énormes risques pour les entreprisesAmi Luttwak, CTO et co-fondateur de Wiz, a souligné que Wiz avait partagé la situation avec Microsoft en juin et que Microsoft avait rapidement supprimé les données exposées. L'équipe de recherche de Wiz a découvert ces caches de données en analysant Internet à la recherche d'un stockage mal configuré.

En réponse, un porte-parole de Microsoft a commenté par la suite : "Nous avons confirmé qu'aucune donnée client n'a été exposée et qu'aucun autre service interne n'a été compromis

."

Dans un article de blog publié lundi, Microsoft a déclaré avoir enquêté et résolu un incident impliquant un employé de Microsoft qui partageait une URL vers un modèle d'apprentissage d'intelligence artificielle open source dans un référentiel public GitHub. Microsoft a déclaré que les données exposées dans le compte de stockage comprenaient des sauvegardes des fichiers de configuration du poste de travail de deux anciens employés, ainsi que des informations internes de Microsoft Teams sur les deux anciens employés et leurs collègues.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI