Maison >Périphériques technologiques >IA >Le raisonnement H100 s'est envolé 8 fois ! NVIDIA a officiellement annoncé TensorRT-LLM open source, prenant en charge plus de 10 modèles

Le raisonnement H100 s'est envolé 8 fois ! NVIDIA a officiellement annoncé TensorRT-LLM open source, prenant en charge plus de 10 modèles

- 王林avant

- 2023-09-10 16:41:011753parcourir

Les « pauvres GPU » sont sur le point de faire leurs adieux à leur situation difficile !

Tout à l'heure, NVIDIA a publié un logiciel open source appelé TensorRT-LLM, qui peut accélérer le processus d'inférence de grands modèles de langage exécutés sur H100

Alors, combien de fois peut-il être amélioré ?

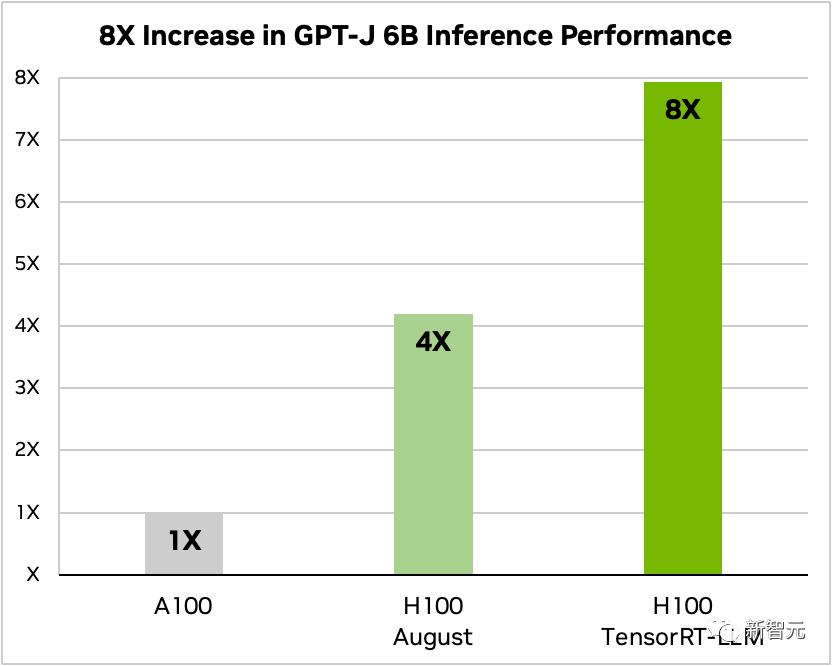

Après l'ajout de TensorRT-LLM et de sa série de fonctions d'optimisation (y compris le traitement par lots en vol), le débit total du modèle a augmenté de 8 fois.

Comparaison des GPT-J-6B A100 et H100 avec et sans TensorRT-LLM

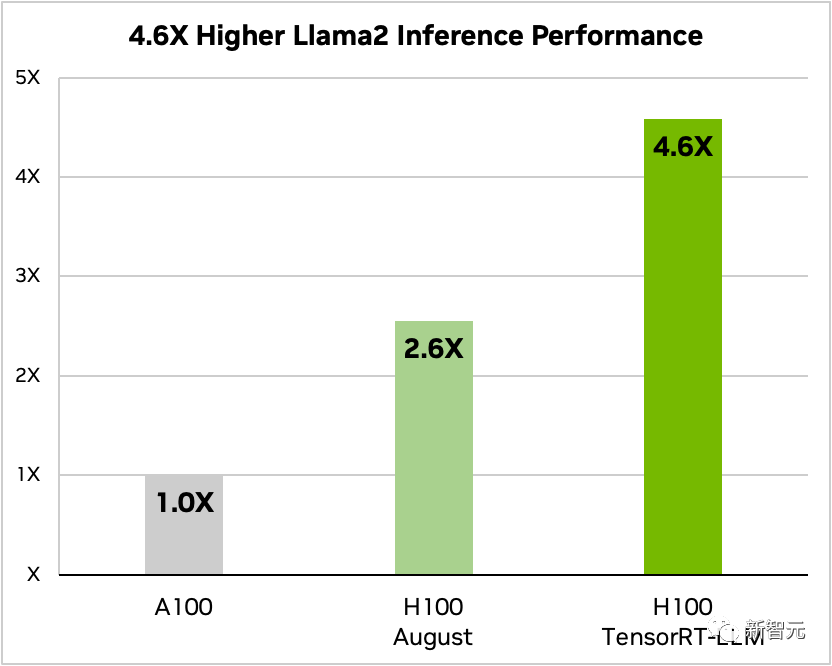

De plus, en prenant Llama 2 comme exemple, TensorRT-LLM peut améliorer les performances d'inférence par rapport à l'utilisation indépendante de A100 Amélioration de 4,6 fois

Comparaison de Llama 2 70B, A100 et H100 avec et sans TensorRT-LLM

Les internautes ont dit que le super H100, combiné avec TensorRT-LLM, est sans aucun doute Cela changera complètement le courant situation d'inférence de grand modèle de langage !

TensorRT-LLM : artefact d'accélération d'inférence de grand modèle

Actuellement, en raison de l'énorme échelle de paramètres des grands modèles, la difficulté et le coût du « déploiement et de l'inférence » ont toujours été élevés.

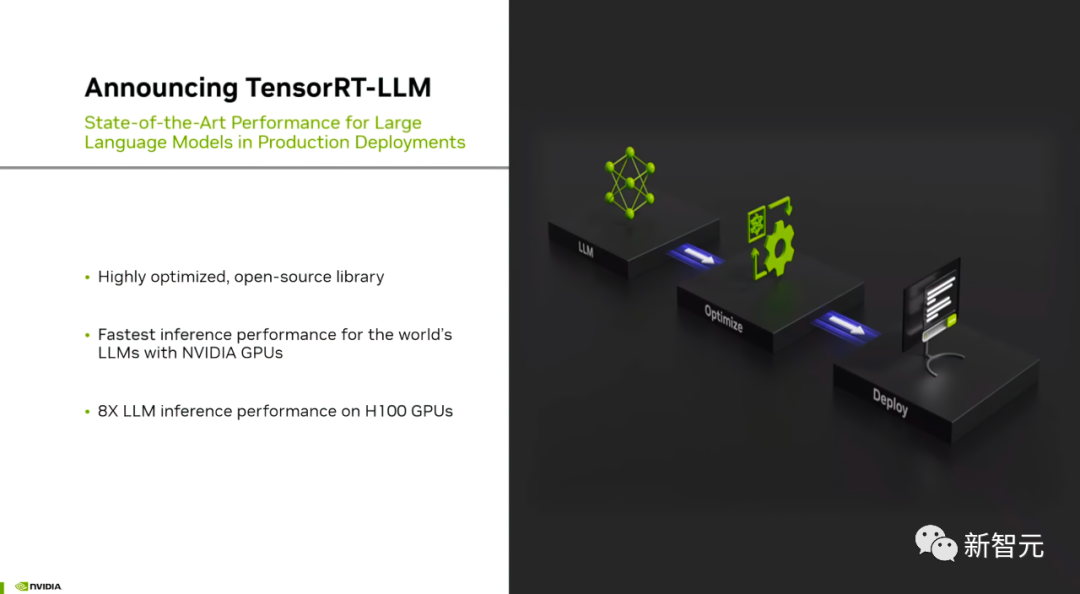

TensorRT-LLM développé par NVIDIA vise à améliorer considérablement le débit de LLM et à réduire les coûts grâce au GPU

Plus précisément, TensorRT-LLM optimise le compilateur d'apprentissage profond de TensorRT et le noyau FasterTransformer, le pré- et post-traitement , et la communication multi-GPU/multi-nœuds sont encapsulés dans une simple API Python open source

NVIDIA a encore amélioré FasterTransformer pour en faire une solution de production.

On peut voir que TensorRT-LLM fournit une interface de programmation d'applications Python facile à utiliser, open source et modulaire.

Les codeurs qui n'ont pas besoin de connaissances approfondies en C++ ou CUDA peuvent déployer, exécuter et déboguer divers modèles de langage à grande échelle, et obtenir d'excellentes performances et une personnalisation rapide

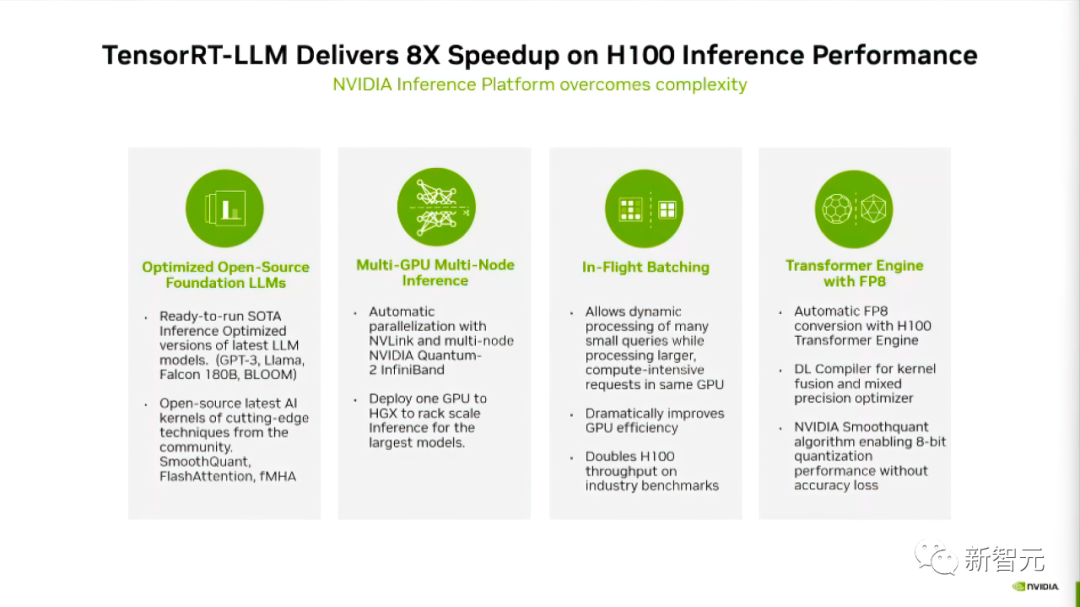

Selon le blog officiel de NVIDIA , TensorRT-LLM adopte quatre méthodes pour améliorer les performances d'inférence LLM sur les GPU Nvidia

Tout d'abord, TensorRT-LLM est introduit pour les plus de 10 grands modèles actuels, permettant aux développeurs de l'exécuter immédiatement.

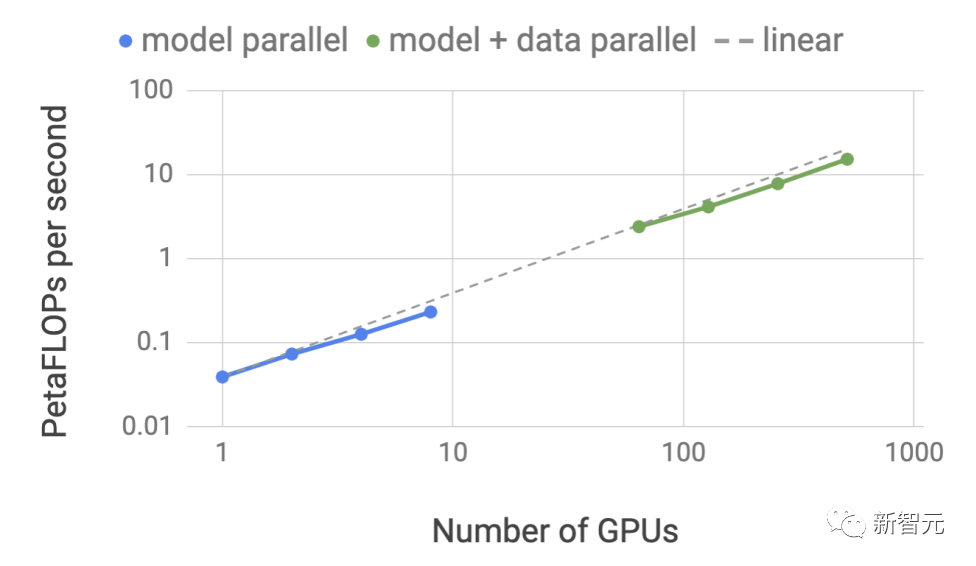

Deuxièmement, TensorRT-LLM, en tant que bibliothèque logicielle open source, permet à LLM d'effectuer une inférence sur plusieurs GPU et plusieurs serveurs GPU simultanément.

Ces serveurs sont connectés respectivement via les interconnexions NVLink et InfiniBand de NVIDIA.

Le troisième point concerne le "traitement par lots in-machine", qui est une nouvelle technologie de planification qui permet à des tâches de différents modèles d'entrer et de sortir du GPU indépendamment des autres tâches

Enfin, TensorRT-LLM a été optimisé, vous pouvez utiliser le moteur de transformateur H100 pour réduire l'utilisation de la mémoire et la latence lors de l'inférence de modèle.

Examinons en détail comment TensorRT-LLM améliore les performances des modèles

Prend en charge un riche écosystème LLM

TensorRT-LLM fournit un excellent support pour l'écosystème de modèles open source

Ce qui doit être réécrit Oui : Les modèles de langage les plus grands et les plus avancés, tels que Llama 2-70B de Meta, nécessitent que plusieurs GPU travaillent ensemble pour fournir des réponses en temps réel

Auparavant, pour obtenir les meilleures performances d'inférence LLM, les développeurs devaient réécrire manuellement le Modélisez l'IA et décomposez-le en plusieurs morceaux, puis coordonnez l'exécution entre les GPU

TensorRT-LLM utilise la technologie tenseur parallèle pour distribuer la matrice de poids à chaque appareil, simplifiant ainsi le processus et permettant une inférence efficace à grande échelle

Chaque modèle peut être exécuté sur plusieurs appareils connectés via NVLink Fonctionne en parallèle sur plusieurs GPU et plusieurs serveurs sans intervention du développeur ni modification du modèle.

Avec le lancement de nouveaux modèles et architectures de modèles, les développeurs peuvent utiliser le dernier noyau open source NVIDIA AI (Kernal) dans TensorRT-LLM pour optimiser les modèles

Ce qui doit être réécrit est : Noyau pris en charge Fusion inclut la dernière implémentation de FlashAttention, ainsi qu'une attention multi-têtes masquée pour le contexte et les étapes de génération de l'exécution du modèle GPT, etc.

De plus, TensorRT-LLM inclut également de nombreux grands modèles de langage actuellement populaires. version optimisée et prête à l'emploi.

Ces modèles incluent Meta Llama 2, OpenAI GPT-2 et GPT-3, Falcon, Mosaic MPT, BLOOM et plus de dix autres. Tous ces modèles peuvent être appelés à l'aide de l'API Python TensorRT-LLM facile à utiliser

Ces fonctions peuvent aider les développeurs à créer des modèles de langage volumineux personnalisés plus rapidement et avec plus de précision pour répondre aux différents besoins de diverses industries.

Traitement par lots en vol

De nos jours, les grands modèles de langage sont extrêmement polyvalents.

Un modèle peut être utilisé simultanément pour plusieurs tâches apparemment disparates : des simples réponses aux questions-réponses dans un chatbot, au résumé de documents ou à la génération de longs blocs de code, les charges de travail sont très dynamiques et les tailles de sortie doivent être respectées. différents ordres de grandeur.

La diversité des tâches peut rendre difficile le regroupement efficace des requêtes et leur exécution parallèle efficace, ce qui peut entraîner l'exécution de certaines requêtes plus tôt que d'autres.

Pour gérer ces charges dynamiques, TensorRT-LLM inclut une technologie de planification optimisée appelée « In-flight batching ».

Le principe de base des grands modèles de langage est que l'ensemble du processus de génération de texte peut être réalisé via plusieurs itérations du modèle

Avec le traitement par lots en vol, le runtime TensorRT-LLM est immédiatement libéré du lot lorsque il s'agit d'une séquence terminée au lieu d'attendre que l'ensemble du lot soit terminé avant de passer à l'ensemble de requêtes suivant.

Lors de l'exécution d'une nouvelle demande, d'autres demandes du lot précédent qui n'ont pas été complétées sont toujours en cours de traitement.

Utilisation améliorée du GPU grâce au traitement par lots sur la machine et à des optimisations supplémentaires au niveau du noyau, ce qui entraîne au moins le double du débit des tests de requêtes réels pour LLM sur H100

Utilisation du moteur H100 Transformer du FP 8

TensorRT- LLM fournit également une fonctionnalité appelée H100 Transformer Engine, qui peut réduire efficacement la consommation de mémoire et la latence lors de l'inférence de grands modèles.

Étant donné que LLM contient des milliards de poids de modèle et de fonctions d'activation, il est généralement entraîné et représenté avec des valeurs FP16 ou BF16, chacune occupant 16 bits de mémoire.

Cependant, au moment de l'inférence, la plupart des modèles peuvent être représentés efficacement avec une précision moindre à l'aide de techniques de quantification, telles que des entiers de 8 bits ou même de 4 bits (INT8 ou INT4).

La quantification est le processus de réduction du poids du modèle et de la précision d'activation sans sacrifier la précision. L’utilisation d’une précision inférieure signifie que chaque paramètre est plus petit et que le modèle occupe moins d’espace dans la mémoire GPU.

De cette façon, vous pouvez utiliser le même matériel pour déduire des modèles plus grands, tout en réduisant la consommation de temps sur les opérations de mémoire pendant le processus d'exécution

Grâce à la technologie H100 Transformer Engine, combinée à TensorRT-LLM Le H100 Le GPU permet aux utilisateurs de convertir facilement les poids des modèles au nouveau format FP8 et de compiler automatiquement les modèles pour tirer parti des cœurs FP8 optimisés.

Et ce processus ne nécessite aucun codage ! Le format de données FP8 introduit par H100 permet aux développeurs de quantifier leurs modèles et de réduire considérablement la consommation de mémoire sans réduire la précision du modèle.

Par rapport à d'autres formats de données tels que INT8 ou INT4, la quantification FP8 conserve une plus grande précision tout en atteignant les performances les plus rapides et est la plus pratique à mettre en œuvre. Par rapport à d'autres formats de données tels que INT8 ou INT4, la quantification FP8 conserve une plus grande précision tout en atteignant les performances les plus rapides et est la plus pratique à mettre en œuvre

Comment obtenir TensorRT-LLM

Bien que TensorRT-LLM ne soit pas encore officiel, mais les utilisateurs peuvent désormais en faire l'expérience à l'avance

Le lien de l'application est le suivant :

https://developer.nvidia.com/tensorrt-llm-early-access/join

Nvidia l'a également dit Will TensorRT-LLM a été rapidement intégré au framework NVIDIA NeMo.

Ce framework fait partie de AI Enterprise récemment lancé par NVIDIA, offrant aux entreprises clientes une plate-forme logicielle d'IA de niveau entreprise sécurisée, stable et hautement gérable

Les développeurs et les chercheurs peuvent utiliser le framework NeMo sur NVIDIA NGC ou un projet sur GitHub pour accéder à TensorRT-LLM

Cependant, il convient de noter que les utilisateurs doivent s'inscrire au programme pour développeurs NVIDIA pour postuler à la version à accès anticipé.

Discussion animée parmi les internautes

Les utilisateurs de Reddit ont eu une discussion animée sur la sortie de TensorRT-LLM

Il est difficile d'imaginer à quel point l'effet sera amélioré après l'optimisation du matériel spécifiquement pour LLM.

Mais certains internautes pensent que le but de cette chose est d'aider Lao Huang à vendre plus de H100.

Certains internautes ont des opinions différentes à ce sujet. Ils pensent que Tensor RT est également utile pour les utilisateurs qui déploient un apprentissage profond localement. Tant que vous disposez d'un GPU RTX, vous pourrez également bénéficier de produits similaires à l'avenir

D'un point de vue plus macro, peut-être pour LLM, il y aura une série de mesures d'optimisation spécifiquement au niveau matériel, et peut-être même que du matériel spécialement conçu pour LLM est apparu pour améliorer ses performances. Cette situation s'est produite dans de nombreuses applications populaires, et LLM ne fait pas exception

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Comment exporter un modèle dans Navicat

- Que signifie le modèle Python IPO ?

- Comment calculer la taille du modèle de boîte CSS

- À quelle couche du modèle osi la fonction de sélection de chemin est-elle terminée ?

- Révélation de la conférence AMD : le processeur EPYC de nouvelle génération et la carte graphique MI300 rivalisent avec NVIDIA