Maison >Périphériques technologiques >IA >Le modèle géant d'Alibaba est à nouveau open source ! Il possède des fonctions complètes de compréhension d'image et de reconnaissance d'objets. Il est formé sur la base de l'ensemble de problèmes général 7B et est réalisable pour des applications commerciales.

Le modèle géant d'Alibaba est à nouveau open source ! Il possède des fonctions complètes de compréhension d'image et de reconnaissance d'objets. Il est formé sur la base de l'ensemble de problèmes général 7B et est réalisable pour des applications commerciales.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-09-03 13:01:08795parcourir

Alibaba a open source un nouveau grand modèle, ce qui est très excitant~

Après Tongyi Qianwen-7B(Qwen-7B), Alibaba Cloud a lancé modèle de langage visuel à grande échelle Qwen-VL, et ce sera open source directement dès sa mise en ligne.

Qwen-VL est un grand modèle multimodal basé sur Tongyi Qianwen-7B. Plus précisément, il prend en charge plusieurs entrées telles que des images, du texte et des cadres de détection, et peut non seulement produire du texte, mais également des cadres de détection. sortie

Par exemple, nous saisissons une image d'Aniya sous forme de questions et de réponses, Qwen-VL-Chat peut résumer le contenu de l'image et localiser avec précision Aniya dans l'image

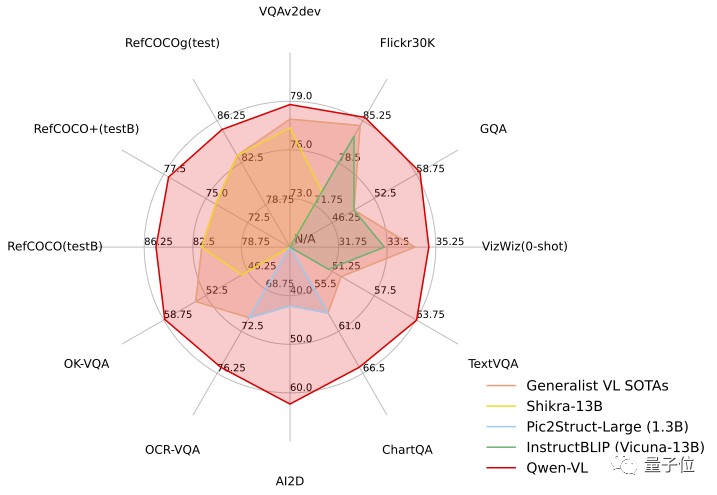

Dans la tâche de test, Qwen-VL a démontré la force du "Hexagonal Warrior", se classant premier dans l'évaluation standard anglaise des quatre grandes catégories de tâches multimodales (Zero-shot Caption/VQA/DocVQA/Grounding).

Dès que la nouvelle de l'open source est sortie, elle a immédiatement attiré l'attention du plus grand nombre

Jetons un coup d'œil aux performances spécifiques !

Le premier modèle général à prendre en charge le positionnement de domaine ouvert chinois

Tout d'abord, jetons un coup d'œil global aux caractéristiques des modèles de la série Qwen-VL :

- Dialogue multilingue : prend en charge le dialogue multilingue, fin - Prise en charge complète du chinois et de l'anglais dans les images Reconnaissance de textes longs bilingues

- Dialogue entrelacé multi-images : prend en charge la saisie et la comparaison de plusieurs images, les questions et réponses d'images désignées, la création littéraire multi-images, etc. premier modèle général à prendre en charge le positionnement du domaine ouvert chinois : grâce aux expressions du langage de domaine ouvert chinois Annotation du cadre de détection, c'est-à-dire que l'objet cible peut être trouvé avec précision dans l'image

- Reconnaissance et compréhension fines : par rapport à la résolution 224 utilisée par ; autre LVLM

- open source (modèle de langage visuel à grande échelle) , Qwen-VL est le premier modèle LVLM open source à résolution 448. Une résolution plus élevée peut améliorer la reconnaissance de texte plus fine, la réponse aux questions des documents et l'annotation des zones de détection. Sans changer le sens original, le contenu qui doit être réécrit est le suivant : Qwen-VL peut être utilisé dans des scénarios tels que des questions et réponses de connaissances, des questions et réponses d'images, des questions et réponses de documents, un positionnement visuel fin, etc. .

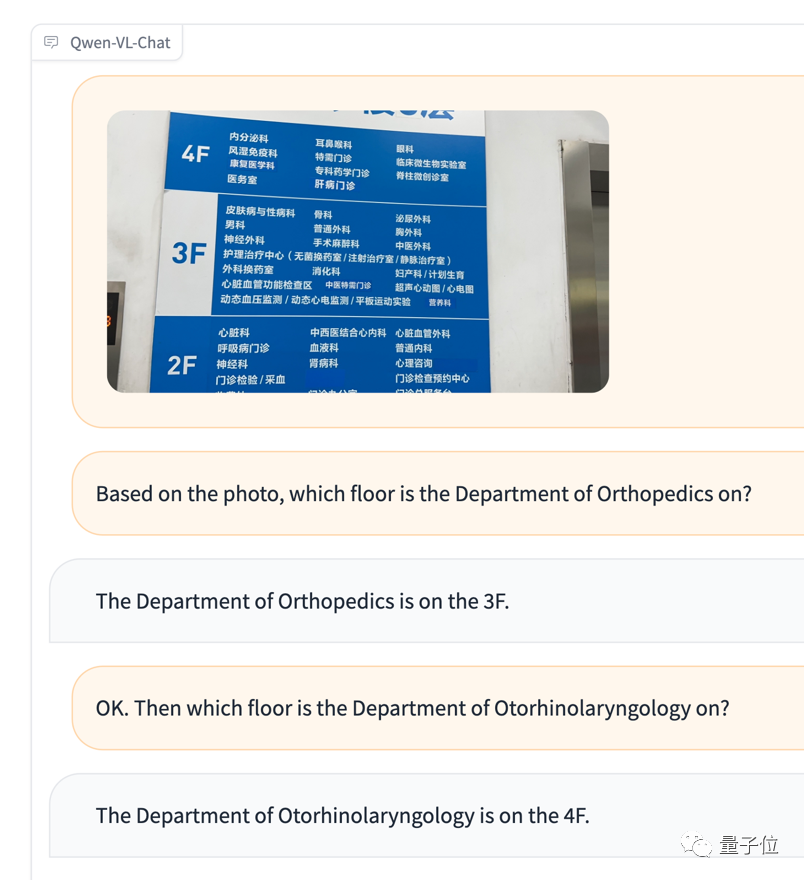

Par exemple, un ami étranger ne comprend pas Lorsque vous allez à l'hôpital voir un médecin en chinois et que vous êtes confus par la carte de navigation et que vous ne savez pas comment vous rendre au service correspondant, vous pouvez directement donner les photos et des questions à Qwen-VL et laissez-le agir comme un traducteur basé sur les informations de l'image

Entrez à nouveau la saisie multi-images Et test de comparaison

Entrez à nouveau la saisie multi-images Et test de comparaison

Bien qu'Aniya n'ait pas été reconnue, le jugement émotionnel était en effet assez précis (tête de chien manuelle)

Bien qu'Aniya n'ait pas été reconnue, le jugement émotionnel était en effet assez précis (tête de chien manuelle)

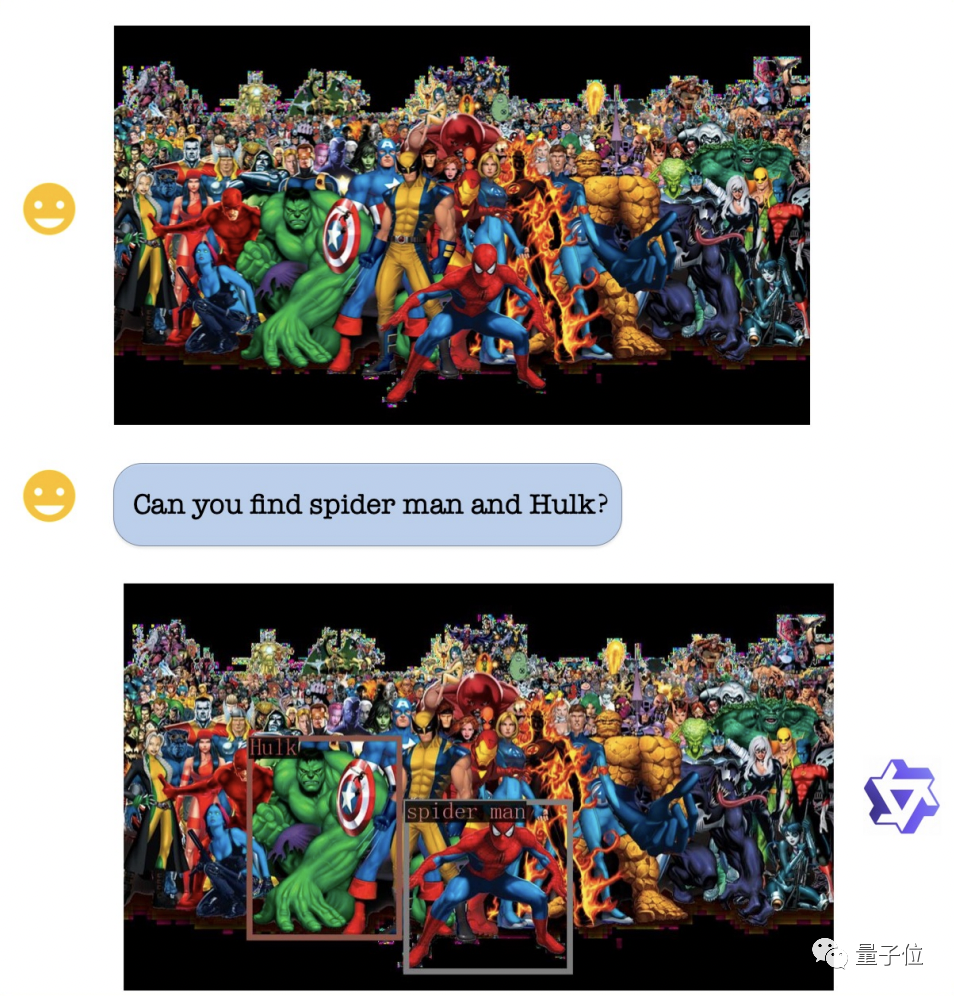

En termes de capacité de positionnement visuel, même si l'image est très complexe et qu'il y a de nombreux personnages, Qwen-VL peut toujours fonctionner selon les exigences Identifier avec précision Hulk et Spider-Man

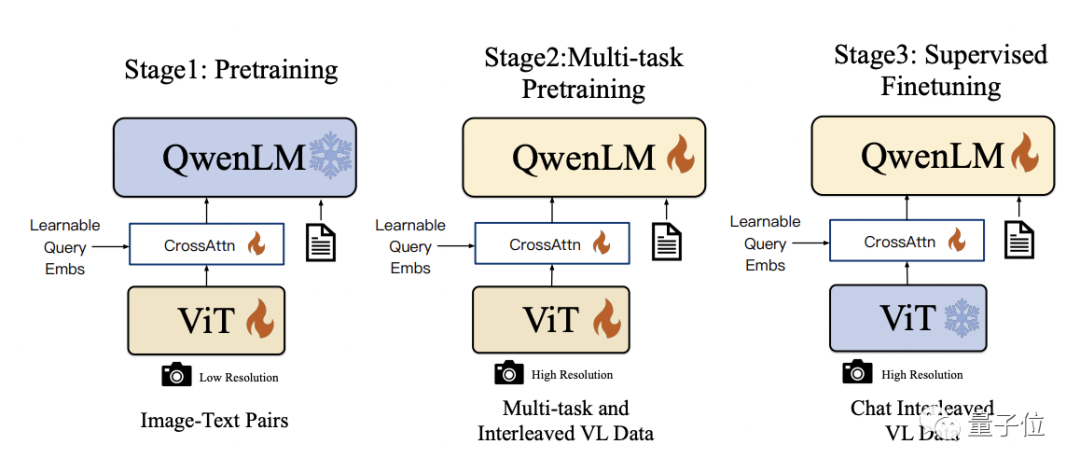

Qwen-VL utilise Qwen-7B comme modèle de langage de base dans les détails techniques, et en introduisant l'encodeur visuel ViT et l'adaptateur de langage visuel sensible à la position, le modèle peut prendre en charge l'entrée de signal visuel

Qwen-VL utilise Qwen-7B comme modèle de langage de base dans les détails techniques, et en introduisant l'encodeur visuel ViT et l'adaptateur de langage visuel sensible à la position, le modèle peut prendre en charge l'entrée de signal visuel

Le processus de formation spécifique est divisé en trois étapes :

- Pré-formation : optimiser uniquement l'encodeur visuel et l'adaptateur de langage visuel, et geler le modèle de langage. En utilisant des données appariées image-texte à grande échelle, la résolution de l’image d’entrée est de 224 x 224.

- Pré-formation multitâche : introduisez des données de langage visuel multitâches à plus haute résolution (448 x 448), telles que VQA, VQA de texte, compréhension référentielle, etc., pour une pré-formation conjointe multitâche.

- Mise au point supervisée : geler les encodeurs visuels, optimiser les modèles de langage et les adaptateurs. Utilisez les données d'interaction de dialogue pour un réglage rapide afin d'obtenir le modèle Qwen-VL-Chat final avec des capacités interactives.

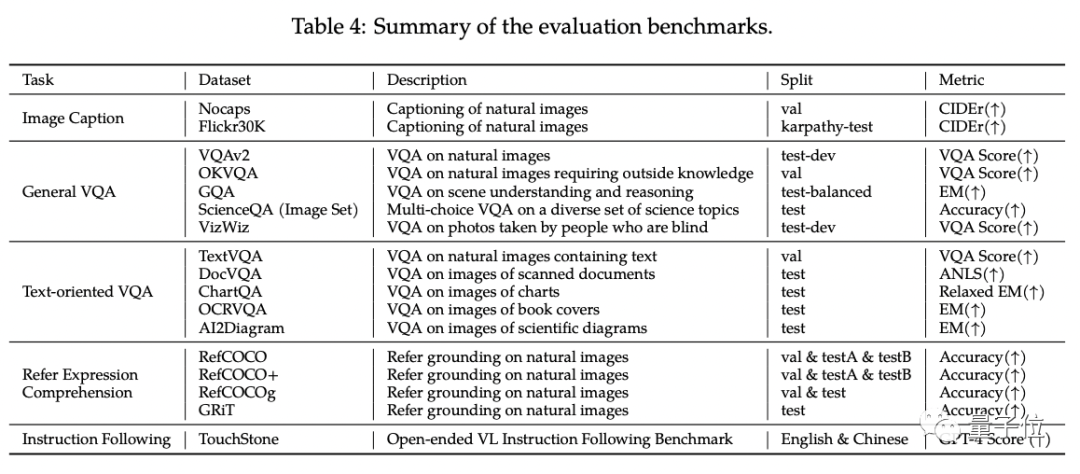

Dans l'évaluation standard en anglais de Qwen-VL, les chercheurs ont testé quatre grandes catégories de tâches multimodales (Zero-shot Caption/VQA/DocVQA/Grounding)

Selon les résultats, Qwen-VL Le meilleur les résultats ont été obtenus en comparant avec un LVLM open source de même taille

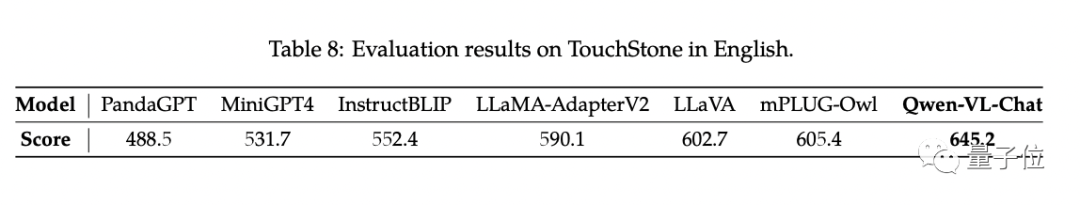

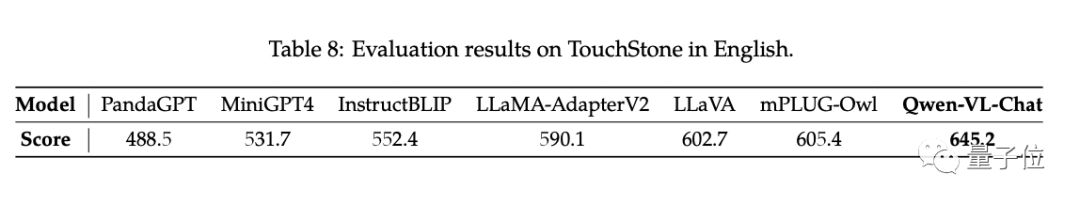

De plus, les chercheurs ont construit un ensemble de tests TouchStone basé sur le mécanisme de notation GPT-4.

Qwen-VL-Chat a atteint la technologie de pointe (SOTA) dans ce test comparatif

Si Qwen-VL vous intéresse, vous pouvez retrouver la démo sur la communauté magique et huggingface Venez l'essayer directement. Le lien est fourni à la fin de l'article

Qwen-VL soutient les chercheurs et les développeurs pour le développement secondaire et permet une utilisation commerciale. Mais il convient de noter que si vous souhaitez l'utiliser commercialement, vous devez d'abord remplir le formulaire de demande de questionnaire

Lien du projet : https://modelscope.cn/models/qwen/Qwen-VL/summary

https://modelscope .cn/models/qwen/Qwen-VL-Chat/summary

https://huggingface.co/Qwen/Qwen-VL

https://huggingface.co/Qwen/Qwen -VL-Chat

https://github.com/QwenLM/Qwen-VL

Veuillez cliquer sur le lien suivant pour consulter l'article : https://arxiv.org/abs/2308.12966

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!