Maison >Périphériques technologiques >IA >Tout le monde a un « petit film » ! La version vidéo de Midjourney est disponible gratuitement et un blockbuster sympa est créé en une seule phrase, qui stupéfie les internautes

Tout le monde a un « petit film » ! La version vidéo de Midjourney est disponible gratuitement et un blockbuster sympa est créé en une seule phrase, qui stupéfie les internautes

- 王林avant

- 2023-06-13 09:55:511731parcourir

Après trois mois d’attente, Runway’s Gen-2 est enfin disponible en essai gratuit !

On peut dire que c'est une journée qui mérite d'être enregistrée dans l'histoire du développement des outils vidéo d'IA.

Adresse d'essai : https://app.runwayml.com

Cet outil d'IA peut générer rapidement une vidéo de 4 secondes à l'aide de texte et d'images. En d’autres termes, la manière de générer des vidéos consiste à « créer quelque chose à partir de rien ».

Après avoir regardé la démo ci-dessous, je me suis exclamé : le réalisateur et les acteurs vont-ils vraiment être éliminés en un seul clic ?

Des internautes enthousiastes ont couru pour le tester les uns après les autres. Leurs pensées étaient : L'effet est si explosif. Cette IA est-elle folle ?

Le seul regret est que la vidéo actuellement générée ne dure que 4 secondes. (Mais si les scènes avant et après ne sont pas brusques, assembler quelques vidéos supplémentaires de 4 secondes suffit en fait)

Cœur excité, mains tremblantes, le monteur qui exécute souvent automatiquement divers blockbusters dans son crâne, est-ce vraiment que je peux Je ne le retiens plus. (Alors la scène de mon rêve peut-elle devenir réalité ?)

Test de la rédaction : Tout le monde peut faire un court métrage !

Sans plus attendre, voici le test proprement dit.

Après avoir accédé à la page, essayez une invite simple : "La scène des humains atterrissant sur Mars pour la première fois et construisant une base."

Le contenu de l'écran généré par Gen-2 est conforme à la description du mot d'invite, mais les éléments de l'écran sont trop simples et le sens artistique n'est pas satisfaisant.

L'éditeur a donc ajouté du contenu lié au style de l'environnement : "Les humains ont atterri sur Mars pour la première fois et ont construit une base sur Mars, des images de style film, un style futur."

Effectivement, le contenu et les effets générés par Gen-2 cette fois sont en effet plus riches qu'avant.

Cependant, il y a toujours un problème avec cette vidéo : les images et les personnages sont quasiment statiques, avec très peu de changements.

Après des tests répétés, nous avons trouvé du contenu incontournable pour les mots rapides : style, objectif, contenu, action, environnement et lumière.

Tant que vous ajoutez ces contenus aux mots d'invite, l'animation générée sera immédiatement considérablement améliorée.

Pour le thème du simple atterrissage sur Mars, l'éditeur a tenté de réécrire un mot invite :

"Style film, style science-fiction, deux astronautes construisant une tour de travail dans la base de Mars, très fort ensoleillement »

Par rapport aux deux précédentes, l'animation désormais générée a évidemment été grandement améliorée en termes de style d'image, de richesse du contenu, d'effets d'action et d'effets de lumière et d'ombre.

Enfin, l'éditeur a téléchargé une image basée sur le même mot d'invite et a demandé à Gen-2 de générer une animation basée sur le mot d'invite et l'image.

On peut voir que par rapport à la troisième vidéo avec le même mot d'invite mais pas d'image, la quatrième vidéo avec invite d'image a une corrélation considérable avec le contenu de l'image.

Avec la description précise des mots et des images rapides, pratiquement n'importe qui peut générer instantanément un contenu vidéo idéal.

Les temps ont changé : rien n'est impossible à moins de l'imaginer

Par rapport à la dernière fois, le slogan de Runway va cette fois plus loin : "Tant que vous pouvez l'imaginer, il peut être créé pour vous." (La dernière fois, le slogan était "dis-le, vois-le")

Est-ce que ça va ? Si nous voulons parler de l'écart entre les gens ordinaires et les grands réalisateurs, outre les connaissances et l'expérience professionnelles, la seule différence réside dans l'équipe de photographie professionnelle et les acteurs.

Cette dernière lacune est désormais entièrement comblée par des outils d'IA comme Gen-2 Pas de caméras, pas de caméras vidéo, pas de modélisation 3D, pas de Cinema 4D...

Tant que votre imagination est libre, apprenez le. le « sort » habile et « chacun peut faire son propre film » n'est plus un rêve !

Qu'il s'agisse d'une image réaliste -

ou de quelque chose de plus abstrait -

Vous pouvez même générer des animations, effectuer diverses opérations dessus, puis vous insérer dans la vidéo.

Le seuil de génération de vidéo a été considérablement abaissé, ce qui est vraiment une bonne nouvelle pour la majorité des créateurs de contenu.

On peut dire que l'IA de Wensheng Video/Tusheng Video a vraiment apporté trop de changements perturbateurs à l'industrie.

Dans le passé, si Scissorhands voulait trouver un matériau approprié (comme des couleurs éclaboussant dans l'espace), ils devaient rechercher sur des sites Web de matériaux tels que des séquences d'archives. La gamme de matériaux était très limitée et tout le monde était disponible. le matériel n’est pas exclusif.

Ou, prenez de la peinture et jetez-la dans le studio et capturez-la vous-même avec un appareil photo. Cela prend du temps et demande beaucoup de travail, et cela rend également l'environnement en désordre.

Vous pouvez également le faire vous-même dans Blender, ce qui prend généralement des heures, voire des jours.

Ou, vous devez embaucher une équipe professionnelle pour filmer ce processus. Le coût varie probablement de quelques centaines à quelques milliers de dollars.

Maintenant, Gen-2 a réduit tous ces coûts !

La Gen-1 est à nouveau populaire

En fait, la précédente Gen-1 était déjà assez explosive.

Avec la sortie de Gen-2, la vidéo ci-dessous est redevenue populaire récemment.

J'ai vu que l'oncle se transformait en noble en un claquement de doigts et voyageait dans les cours européennes aux XVIIe et XVIIIe siècles.

Bientôt, d'un claquement de doigts, il s'est transformé en protagoniste de "Rise of the Planet", traversant le champ de bataille en ruine.

Ce n'est rien, le changement de genre qui s'ensuit est un chef d'oeuvre !

Qui aurait pensé qu'une femme aussi en forme était en fait le "vieil homme" de tout à l'heure.

Je dois dire qu'avec la formation des internautes, les arrière-plans, visages et vêtements générés par Gen-2 sont non seulement assez naturels, mais semblent également avoir une forte cohérence.

Mais les mains, qui sont les plus difficiles à gérer, présentent encore souvent des bugs.

Un MV, 30 dollars

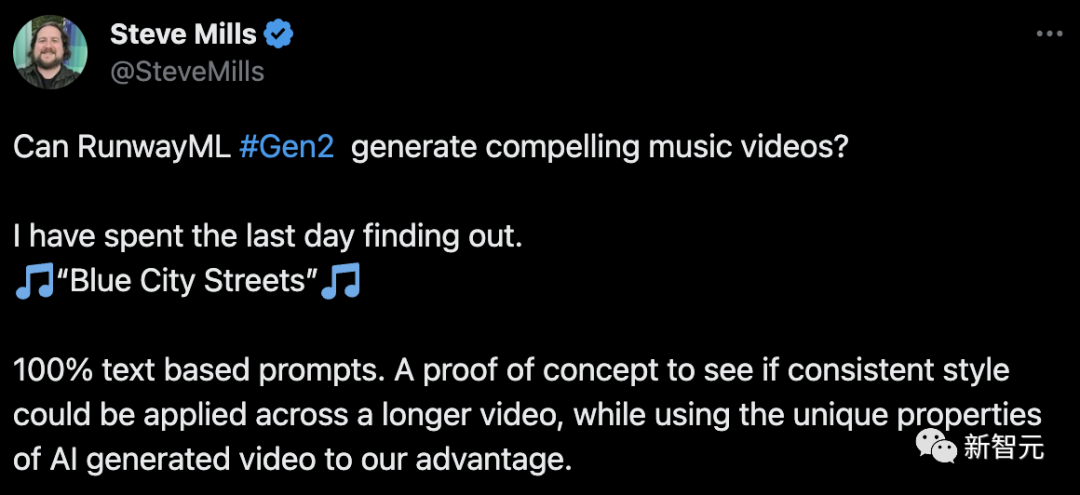

Certains utilisateurs de Twitter aux mains rapides ont déjà testé la capacité de Gen-2 à générer des MV.

La pratique a prouvé qu'il faut un délai assez long pour produire des résultats de qualité et contrôlables. Cependant, il peut être affiné en ajoutant ou en modifiant un mot.

De plus, il existe un autre facteur d'influence important : le verrouillage des graines.

Le reste, c'est juste beaucoup d'efforts.

Par exemple, ce Steve Mills a généré un total d'environ 500 secondes de vidéo et l'a finalement monté en un MV de 140 secondes.

Veuillez profiter ensuite : "Blue City Streets".

Il convient de noter que cette vidéo a en fait été réalisée dans la version bêta.

Selon l'estimation de l'auteur, si le prix de la version publique est utilisé, l'ensemble de la production coûtera au moins 30 dollars américains. Couplé à l'étape précédente d'apprentissage et d'exploration, le prix sera encore plus élevé.

Apprenez à l'utiliser étape par étape

Après avoir vu tant d'exemples, comment pouvez-vous devenir réalisateur hollywoodien ? Allons-y étape par étape.

Tout d'abord, créez un compte.

Après avoir accédé à la page d'accueil, sélectionnez Gen-2 : Texte en vidéo.

Ensuite, la boîte de dialogue apparaît. C'est ici que vous devez montrer vos compétences !

Une fois l'invite terminée, vous pouvez également ouvrir la carte des paramètres d'options pour mettre à niveau vos résultats, comme choisir d'insérer des images, rendre la transition vidéo plus fluide, augmenter la résolution, supprimer les filigranes, etc.

Ensuite, cliquez sur Générer, et l'étape suivante consiste à être témoin du miracle !

Mais de nombreux amis doivent dire qu'ils sont morts prématurément et ne pouvaient pas écrire des invites trop complexes et trop magnifiques.

Ne vous inquiétez pas, le Gen-2 lancé cette fois nous a réservé une grosse surprise - même pour de simples invites, la vidéo produite par Gen-2 n'est pas mauvaise.

Par exemple, si vous saisissez simplement "un arbre", la vidéo générée ressemblera à ceci -

Si vous saisissez "un arbre sur une montagne herbeuse dans le Midwest américain, des films professionnels "Style, faible profondeur de champ, mise au point du sujet, bel éclairage, mouvement dynamique fluide", la vidéo générée est comme ceci -

C'est-à-dire que nous n'avons pas besoin d'avancer pour inviter le maître , nous, les utilisateurs ordinaires, pouvons également générer rapidement des vidéos sympas !

Discussion animée parmi les internautes

En réponse à cela, les internautes de la Station B ont commencé à réfléchir.

Certaines personnes ont également commencé à le tester.

Les internautes étrangers se sont également exclamés en voyant Gen-2

Je t'ai enfin attendu, mais heureusement je n'ai pas abandonné.

Alors que l'IA générative continue de produire du contenu vidéo, l'industrie du divertissement est sur le point de changer.

Il y a quelques décennies, les films de cette époque étaient différents des peintures maintenant La qualité est encore très différente.

Maintenant, avec la bénédiction d'outils d'IA comme Gen-2, peut-être que les limites des films du futur ne seront plus que celles de l'imagination humaine, et non plus de la technologie. Bordé.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI