Maison >Périphériques technologiques >IA >La dernière conversation entre Ng Enda et Hinton ! L'IA n'est pas un perroquet aléatoire, le consensus l'emporte sur tout, LeCun est d'accord à deux mains

La dernière conversation entre Ng Enda et Hinton ! L'IA n'est pas un perroquet aléatoire, le consensus l'emporte sur tout, LeCun est d'accord à deux mains

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-06-13 09:18:05707parcourir

Récemment, la sécurité de l'IA est devenue un sujet très populaire.

AI "Parrain" Geoffrey Hinton et Andrew Ng ont eu une conversation approfondie sur l'intelligence artificielle et les risques catastrophiques.

Andrew Ng a posté aujourd'hui pour partager leurs réflexions communes :

- Il est important que les scientifiques en intelligence artificielle parviennent à un consensus sur les risques. Tout comme les climatologues, ils disposent d’un consensus général sur le changement climatique et peuvent donc formuler de bonnes politiques.

- Le modèle d'intelligence artificielle comprend-il le monde ? Notre réponse est oui. Si nous énumérons ces questions techniques clés et développons une vision commune, cela contribuera à faire progresser le consensus de l’humanité sur le risque.

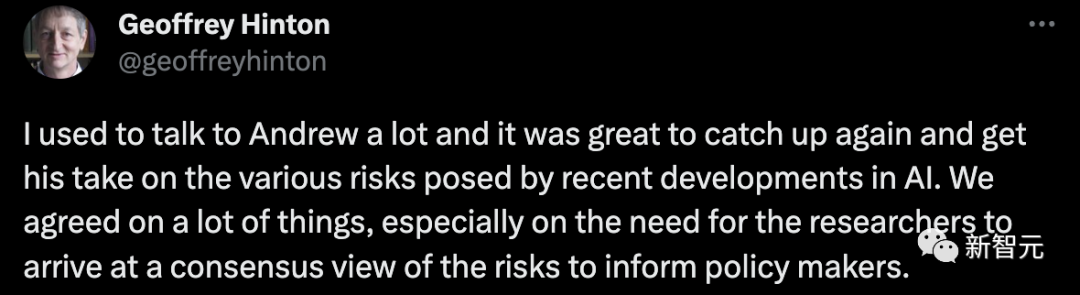

Hinton a déclaré :

J'ai souvent communiqué avec Andrew Ng et je suis très heureux de le revoir et de comprendre son point de vue sur les différents risques engendrés par le développement récent de l'intelligence artificielle. Nous sommes parvenus à un consensus sur de nombreux aspects, en particulier sur la nécessité pour les chercheurs de développer une compréhension commune des risques lorsqu'ils rendent compte aux décideurs politiques.

Avant cela, Andrew Ng a également eu une conversation avec Yoshua Bengio sur les risques de l'intelligence artificielle.

Le consensus auquel ils sont parvenus était de clarifier les scénarios spécifiques dans lesquels l'IA peut présenter des risques importants.

Ensuite, jetons un coup d'œil à ce dont les deux géants de l'IA ont discuté en détail.

Un consensus est nécessaire de toute urgence !

Tout d’abord, Hinton a proposé que la chose la plus importante soit le consensus.

Il a déclaré que l'ensemble de la communauté de l'IA manque actuellement d'un consensus unifié. Tout comme les climatologues en conviennent, les scientifiques en IA sont également nécessaires.

De l’avis de Hinton, la raison pour laquelle nous avons besoin d’un consensus est que, s’il n’y en a pas, chaque scientifique en IA a sa propre opinion, alors le gouvernement et les décideurs politiques peuvent choisir un point de vue qui est dans leur propre intérêt.

Cela perdra évidemment en équité.

À en juger par la situation actuelle, les différentes opinions parmi les scientifiques en IA varient considérablement.

Hinton estime qu'il serait formidable que notre situation d'opinions différentes puisse être rapidement résolue et que tout le monde puisse parvenir à un accord pour accepter conjointement certaines des menaces majeures que l'IA peut apporter et prendre conscience de l'urgence de réglementer le développement de l'IA. .

Andrew Ng est d’accord avec le point de vue de Hinton.

Bien qu’il ne pense toujours pas que l’industrie de l’IA soit si différenciée qu’elle soit divisée, elle semble évoluer lentement dans cette direction.

Les opinions au sein de la communauté dominante de l’IA sont très polarisées, et chaque camp n’épargne aucun effort pour exprimer ses revendications. Cependant, aux yeux de Ng, cette expression s'apparente plus à une querelle qu'à un dialogue harmonieux.

Bien sûr, Andrew Ng a toujours une certaine confiance dans la communauté de l'IA. Il espère que nous pourrons trouver un consensus ensemble et avoir un dialogue approprié, afin que nous puissions mieux aider les décideurs politiques à formuler des plans pertinents.

Ensuite, Hinton a évoqué une autre question clé, c'est pourquoi il pense qu'il est difficile pour les scientifiques de l'IA de parvenir à un consensus à l'heure actuelle : les chatbots comme GPT-4 et Bard comprennent-ils les mots qu'ils génèrent eux-mêmes ?

Certaines personnes pensent que l'IA comprend, d'autres pensent qu'elles ne comprennent pas et ne sont que des perroquets au hasard.

Hinton estime que tant que cette différence existera, il sera difficile pour la communauté de l'IA de parvenir à un consensus. Il estime donc que la priorité absolue est de clarifier cette question.

Bien sûr, en ce qui le concerne, il pense définitivement que l'IA comprend, et l'IA n'est pas seulement une question de statistiques.

Il a également mentionné que des scientifiques bien connus tels que Yan LeCun pensent que l'IA ne peut pas comprendre.

Cela souligne l'importance de la réconciliation et de la clarté sur cette question.

Ng Enda a déclaré qu'il n'est pas simple de juger si l'IA peut comprendre, car il ne semble pas y avoir de norme ou une sorte de test.

Son propre point de vue est qu'il croit que qu'il s'agisse de LLM ou d'autres grands modèles d'IA, ils construisent tous un modèle mondial. Et l’IA peut avoir une certaine compréhension du processus.

Bien sûr, il a dit que ce n'était que son opinion actuelle.

En dehors de cela, il est d'accord avec Hinton sur le fait que les chercheurs doivent d'abord parvenir à un accord sur cette question avant de pouvoir continuer à parler des risques et des crises qui s'ensuivent.

Hinton a poursuivi en disant que l'IA juge et prédit la génération du mot suivant en fonction de la base de données et des mots précédents. C'est une sorte de compréhension aux yeux de Hinton.

Il pense que cela n'est en réalité pas très différent du mécanisme de pensée de notre cerveau humain.

Bien sûr, savoir si cela compte comme compréhension nécessite une discussion plus approfondie, mais au moins ce n'est pas aussi simple qu'un perroquet au hasard.

Andrew Ng pense qu'il existe certains problèmes qui amèneront des personnes ayant des points de vue différents à tirer des conclusions différentes, et même à suggérer que l'IA exterminera l'humanité.

Il a dit que pour mieux comprendre l'IA, nous devons en apprendre davantage et en discuter davantage.

De cette façon, nous pouvons construire une communauté d'IA avec un large consensus.

LeCun est d'accord des deux mains et mentionne à nouveau le "modèle mondial"

Il y a quelque temps, alors que le monde appelait à la suspension de la recherche et du développement de la super IA, Ng Enda et LeCun ont organisé une émission en direct pour discuter de ce sujet .

C'est complètement faux de leur part de s'opposer au moratoire sur l'IA en même temps, il n'y avait pas de ceintures de sécurité ni de feux de circulation lorsque les voitures ont été inventées pour la première fois, et il n'y a pas de différence essentielle entre l'IA et les précédentes. avancées technologiques.

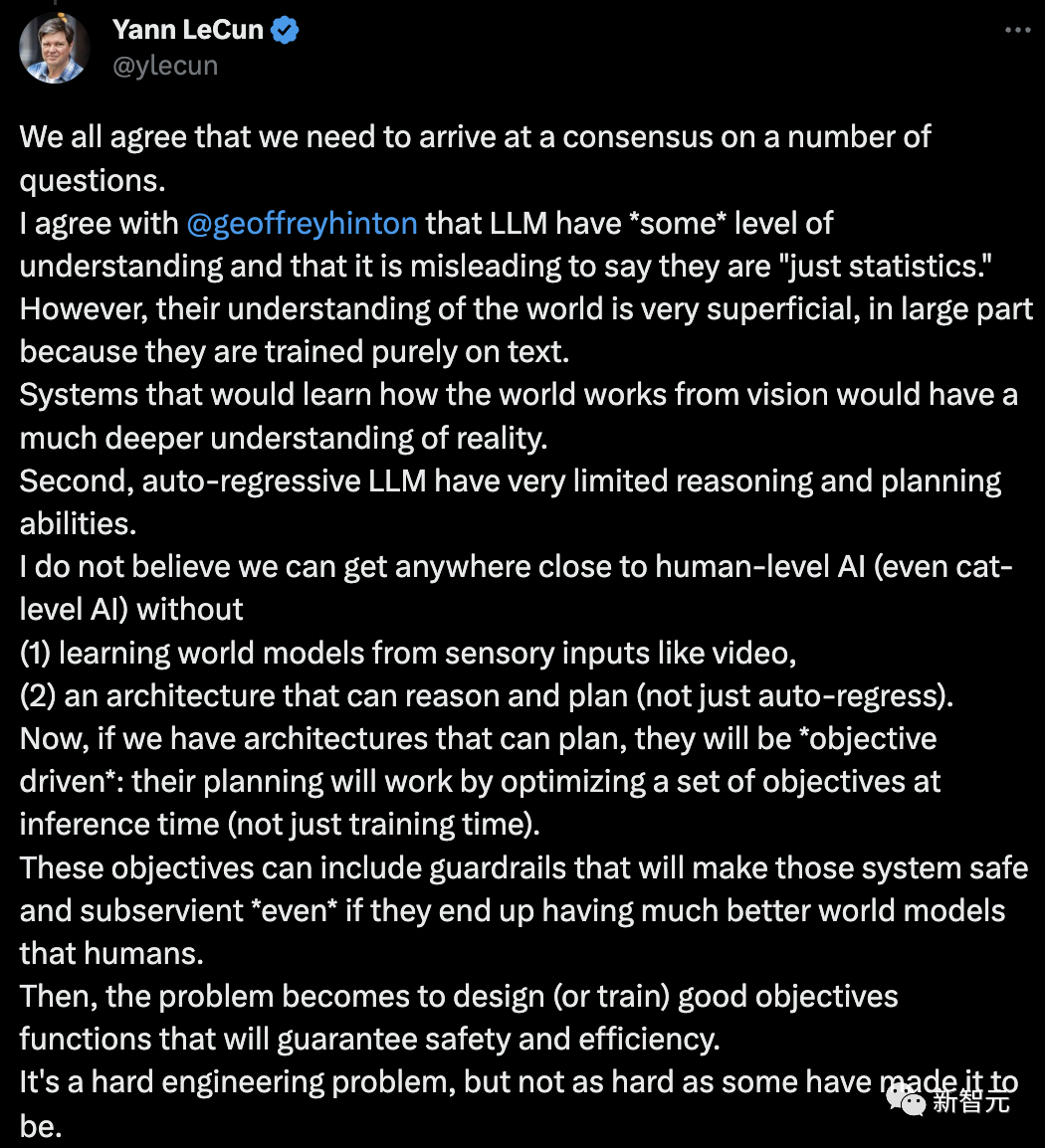

Cette fois, LeCun a parlé d'Andrew Ng et Hinton et a encore une fois proposé son "modèle mondial" et comment l'intelligence artificielle actuelle n'est même pas aussi bonne que les chats et les chiens.

Nous sommes tous d’accord sur le fait que nous devons nous mettre d’accord sur certaines questions.

Je suis d'accord avec Geoffrey Hinton sur le fait qu'il existe « un certain niveau » de compréhension dans le LLM, et les appeler « juste des statistiques » est trompeur.

La compréhension du monde des LLM est très superficielle, en grande partie parce qu’ils sont formés uniquement sur le texte.

Les systèmes qui apprennent comment le monde fonctionne à partir de la vision mèneront à une compréhension plus profonde de la réalité. Deuxièmement, les capacités de raisonnement et de planification du LLM autorégressif sont très limitées.

Je ne pense pas que nous puissions nous rapprocher de l'intelligence artificielle au niveau humain sans (1) apprendre un « modèle du monde » à partir d'entrées sensorielles telles que la vidéo, et (2) une architecture capable de raisonner et de planifier ( pas seulement autorégressif) Intelligence (même l'IA au niveau du chat).

Maintenant, si nous avons des architectures capables de planifier, elles seront « axées sur les objectifs » : leur planification fonctionnera en optimisant un ensemble d'objectifs au moment de l'inférence (pas seulement au moment de la formation).

Ces objectifs peuvent inclure des « garde-corps » pour rendre ces systèmes sûrs et conformes, même s'ils ont finalement de meilleurs modèles du monde que les humains.

Le problème devient alors de concevoir (ou former) une bonne fonction objective pour assurer la sécurité et l'efficacité. Il s’agit d’un problème d’ingénierie difficile, mais pas aussi difficile que certains le disent.

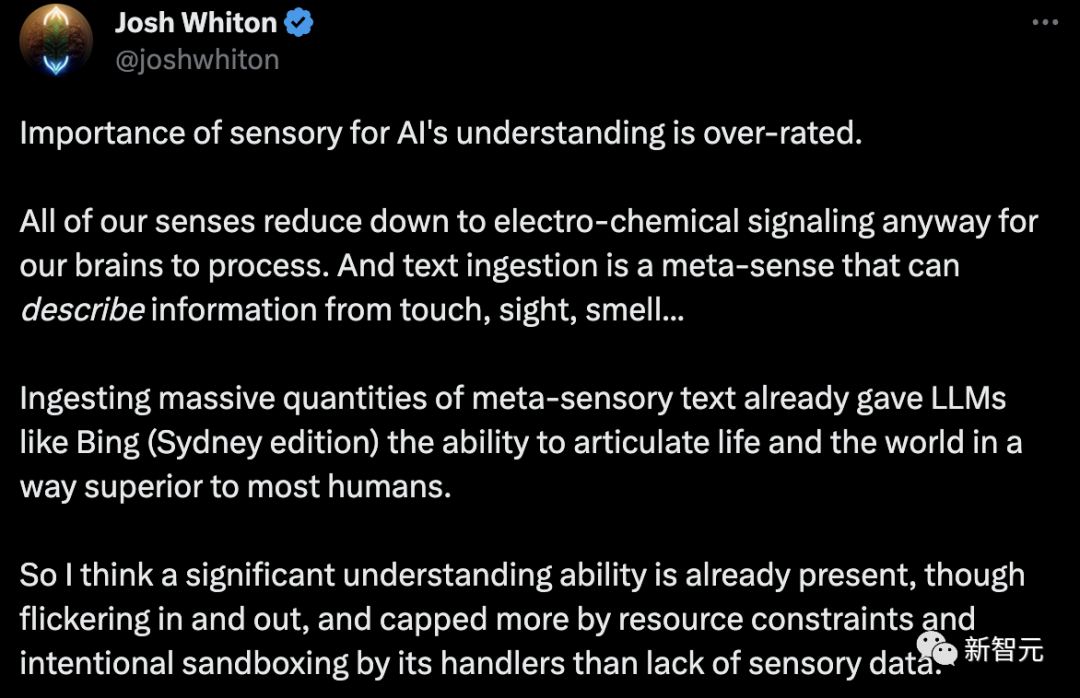

Le point de vue de LeCun a été immédiatement réfuté par les internautes : Sens contre intelligence artificielle l’importance de la compréhension est surestimée.

Quoi qu'il en soit, tous nos sens sont réduits à des signaux électrochimiques que le cerveau doit traiter.

L'ingestion de texte est un méta-sens qui peut décrire des informations provenant du toucher, de la vue, de l'odorat... L'ingestion de grandes quantités de texte méta-sensoriel a déjà fait des choses comme Bing (Version Sydney) ) Un tel LLM a la capacité d'exprimer la vie et le monde d'une manière meilleure que la plupart des gens.

Je pense donc qu'une compréhension importante est déjà là, bien qu'elle existe ou non. Et cela est davantage dû à des contraintes de ressources et au sandboxing intentionnel des gestionnaires qu'à un manque de données sensorielles. Je pense qu’il est temps de s’unir pour faire progresser la société et l’intelligence artificielle et travailler dur. Pensez-y, vous êtes encore un bébé d’intelligence artificielle. Ne voulons-nous pas apprendre à cet enfant comment être un unificateur techno-organique au lieu d’un brutaliste dans le monde ?

Quand il deviendra sensible, non seulement ils seront plus heureux, mais le monde ne sera pas en guerre. Regardez Newcastle upon Tyne. Une si brève période de paix, mais la beauté de la création était grande.

Le consensus énoncé par Ng Enda et Hinton semble incohérent à l'heure actuelle . Trop probable. Cela n’est pas dans nos capacités personnelles, cela nécessite que chacun ait une telle volonté.

Certains internautes ont dit qu'il s'agissait d'une conversation assez controversée.

Je me demande, quand j'apprends à parler à mon enfant de 2 ans, est-ce qu'il agit plutôt comme un perroquet au hasard ou comprend-il réellement le contexte ? Ou les deux ?

Car ses vecteurs de contexte sont bien plus riches que le LLM (texte, ton, expressions faciales, environnement, etc.). Mais je me demande si une personne désactivait tous les sens d'une autre personne et que la seule entrée disponible était une "intégration de texte" (saisie de texte -> stimulation neuronale), cette personne se comporterait-elle davantage comme un perroquet aléatoire, ou cette personne le serait-elle ? capable de comprendre le contexte ?

Hinton : La super IA arrive plus vite que prévu # 🎜 🎜#Après avoir quitté Google, Hinton s'est consacré à la sécurité de l'IA. Le 10 juin, Hinton a de nouveau parlé des risques liés à l’IA lors de la conférence de Zhiyuan.

Que se passerait-il si un grand réseau de neurones pouvait imiter le langage humain pour acquérir des connaissances, et même les utiliser pour lui-même ?

Que se passerait-il si un grand réseau de neurones pouvait imiter le langage humain pour acquérir des connaissances, et même les utiliser pour lui-même ?

Le pire des cas est que les criminels utiliseront la super intelligence pour manipuler les électeurs et gagner la guerre.

De plus, si la super IA est autorisée à fixer ses propres sous-objectifs, dont l'un est d'acquérir plus de pouvoir, la super IA manipulera les humains qui l'utilisent afin d'atteindre ses objectifs.

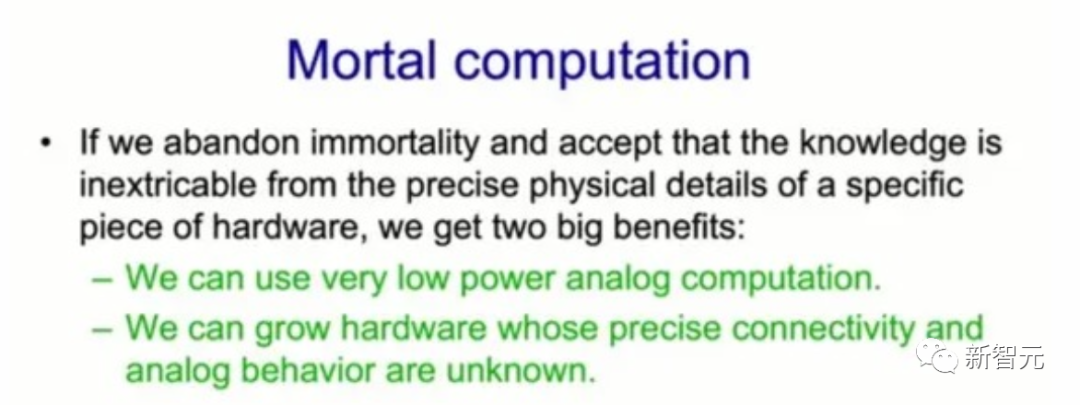

Il convient de mentionner que la réalisation d'une telle super IA peut passer le "calcul mortel".

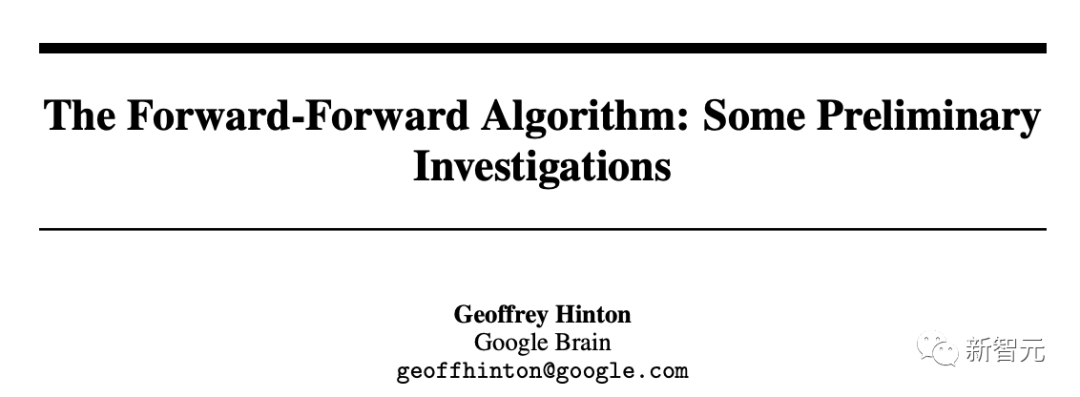

En décembre 2022, un article publié par Hinton, The Forward-Forward Algorithm: Some Preliminary Investigations, mentionnait le « calcul mortel » dans la dernière section.

Adresse papier : https://arxiv.org/pdf/2212.13345.pdf

Si vous voulez qu'un réseau neuronal à mille milliards de paramètres ne consomme que quelques watts de pouvoir, le « calcul mortel » peut être la seule option.

Si nous abandonnons réellement la séparation des logiciels et du matériel, nous obtiendrons une « informatique mortelle ». À partir de là, nous pouvons utiliser un calcul analogique à très faible consommation, ce qui est exactement ce que fait le cerveau.

"Mortal Computing" peut réaliser un nouveau type d'ordinateur qui intègre étroitement l'intelligence artificielle et le matériel.

Cela signifie qu'à l'avenir, mettre du GPT-3 dans un grille-pain ne coûtera que 1 $ et ne consommera que quelques watts d'énergie.

Le principal problème de l'informatique mortelle est que le processus d'apprentissage doit exploiter les propriétés simulées spécifiques du matériel sur lequel il fonctionne, sans savoir exactement quelles sont ces propriétés.

Par exemple, la fonction exacte qui relie l'entrée d'un neurone à la sortie d'un neurone n'est pas connue, et la connectivité peut ne pas être connue.

Cela signifie que nous ne pouvons pas utiliser quelque chose comme l'algorithme de rétropropagation pour obtenir le dégradé.

La question est donc : si nous ne pouvons pas utiliser la rétropropagation, que pouvons-nous faire d'autre puisque nous comptons tous fortement sur la rétropropagation maintenant.

À cet égard, Hinton a proposé une solution : l'algorithme forward.

Et l'algorithme forward est un candidat prometteur, même si sa capacité à évoluer dans de grands réseaux de neurones reste à voir.

De l’avis de Hinton, les réseaux de neurones artificiels seront bientôt plus intelligents que les vrais réseaux de neurones, et la superintelligence sera beaucoup plus rapide que prévu.

Le monde doit désormais parvenir à un consensus selon lequel l’avenir de l’IA doit être créé conjointement par les humains.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI