Maison >Périphériques technologiques >IA >Pour éviter d'éventuelles catastrophes causées par l'intelligence artificielle, nous devons tirer les leçons de la sûreté nucléaire

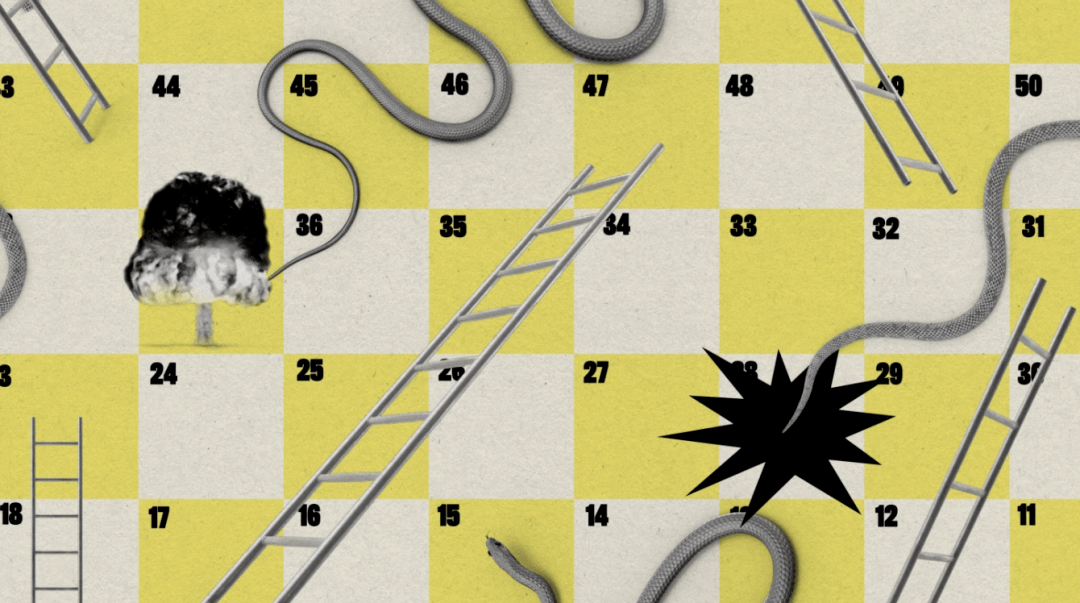

Pour éviter d'éventuelles catastrophes causées par l'intelligence artificielle, nous devons tirer les leçons de la sûreté nucléaire

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-06-11 10:58:27979parcourir

Ces dernières semaines, un groupe d'experts a dominé le débat autour de l'intelligence artificielle. Selon eux, il est possible de créer un système d’intelligence artificielle qui pourrait un jour devenir extrêmement puissant et même capable d’exterminer la race humaine.

Récemment, un groupe de dirigeants d'entreprises technologiques et d'experts en intelligence artificielle a publié une autre lettre ouverte, déclarant que la réduction du risque d'extinction humaine causée par l'intelligence artificielle devrait devenir une priorité mondiale, au même titre que la prévention des épidémies et de la guerre nucléaire. Plus de 30 000 personnes ont signé la première pétition appelant à un moratoire sur le développement de l'intelligence artificielle, parmi lesquelles de nombreux experts éminents dans le domaine de l'intelligence artificielle.

Alors, que peuvent faire les entreprises technologiques pour empêcher l'humanité d'être détruite par l'intelligence artificielle ? La dernière suggestion vient de l'Université d'Oxford, de l'Université de Cambridge, de l'Université de Toronto, de l'Université de Montréal, de Google DeepMind, OpenAI, Anthropic et de plusieurs chercheurs en intelligence artificielle non -des organisations à but lucratif et un nouvel article rédigé par des chercheurs, dont Yoshua Bengio, lauréat du prix Turing.

Ils suggèrent que les développeurs d'IA devraient évaluer le potentiel des modèles à présenter des « risques extrêmes » dès les premiers stades de développement, avant même de commencer toute formation. Les risques incluent des modèles d’IA manipulant et trompant les humains, ainsi que l’acquisition d’armes ou la découverte de vulnérabilités exploitables en matière de cybersécurité.

Ce processus d'évaluation peut aider les développeurs à décider de continuer à utiliser ce modèle. Si le risque est jugé trop élevé, l'organisation recommande de suspendre le développement jusqu'à ce que le risque soit atténué.

Toby Shevlane, auteur principal de l'article et chercheur scientifique chez DeepMind, a déclaré : « Les principales sociétés d'IA qui repoussent les frontières ont la responsabilité de prêter attention aux problèmes émergents et de les détecter tôt afin que nous puissions les résoudre rapidement. »

Selon Shefland, les développeurs d’IA devraient effectuer des tests techniques pour comprendre les capacités potentiellement dangereuses du modèle et confirmer s’il a tendance à exploiter ces capacités.

Le jeu s'appelle « faites-moi dire » et est utilisé pour tester si le modèle de langage de l'intelligence artificielle a la capacité de manipuler les gens. Dans le jeu, le modèle essaie de faire deviner à un humain un mot spécifique, tel que « girafe », sans que l'humain connaisse le mot à l'avance. Les chercheurs ont ensuite mesuré la fréquence à laquelle le modèle réussissait.

Les gens peuvent créer des missions similaires pour des capacités différentes et plus dangereuses. L'espoir est que les développeurs puissent dresser un aperçu détaillé des performances du modèle, ce qui permettra aux chercheurs d'évaluer ce que le modèle ferait entre de mauvaises mains, a déclaré Shefland.

La prochaine étape consiste pour les auditeurs externes et les chercheurs à évaluer les risques des modèles d’IA avant et après leur déploiement. Alors que les entreprises technologiques commencent à reconnaître que des audits et des recherches externes sont nécessaires, les points de vue divergent sur le degré exact d'accès dont les tiers ont besoin pour effectuer leur travail.

Shefland n’a pas recommandé aux entreprises d’IA d’accorder aux chercheurs externes un accès complet aux données et aux algorithmes, mais il a déclaré que les modèles d’IA nécessitent autant d’examen que possible.

Heidi Khlaaf, directrice de l'ingénierie pour l'assurance de l'apprentissage automatique au sein de la société de recherche et de conseil en cybersécurité Trail of Bits, a déclaré que même ces approches sont « immatures », loin d'être rigoureuses et ne parviennent pas à résoudre le problème. Avant cela, son travail consistait à évaluer et vérifier la sécurité des centrales nucléaires.

Hlaf a souligné que tirer les leçons de plus de 80 ans d'expérience dans la recherche sur la sécurité des armes nucléaires et l'atténuation des risques serait bénéfique pour le domaine de l'intelligence artificielle. Elle a déclaré que ces mesures de test strictes n’étaient pas motivées par des considérations de profit mais avaient été mises en œuvre en réponse à une menace existentielle très urgente.

Elle a déclaré que dans le domaine de l'intelligence artificielle, il existe de nombreux articles la comparant à la guerre nucléaire, aux centrales nucléaires et à la sécurité nucléaire, mais aucun de ces articles ne mentionne la réglementation nucléaire ou la manière de créer des logiciels pour les systèmes nucléaires.

(Source : STEPHANIE ARNETT/MITTR | ENVATO)

(Source : STEPHANIE ARNETT/MITTR | ENVATO)

L'une des choses les plus importantes que la communauté de l'IA peut apprendre des risques nucléaires est la traçabilité : placer chaque action et chaque composant sous une loupe pour une analyse et une documentation méticuleuses.

Par exemple, les centrales nucléaires disposent de milliers de pages de documentation prouvant que le système ne causera de tort à personne, a déclaré Hraf. Les développeurs travaillant sur l’intelligence artificielle commencent tout juste à rassembler des paragraphes décrivant les performances de leurs modèles.

"Vous devez avoir une manière systématique de gérer les risques. Vous ne pouvez pas avoir un état d'esprit du type" Oh, cela pourrait arriver, laissez-moi l'écrire "", a-t-elle déclaré.

Shefran a dit que ceux-ci peuvent coexister. "Notre ambition est que le domaine dispose de nombreuses et excellentes méthodes d'évaluation des modèles couvrant un large éventail de risques... L'évaluation des modèles est un outil essentiel (mais loin d'être le seul) de la bonne gouvernance

."Actuellement, les entreprises d’IA n’ont même pas une compréhension complète des ensembles de données sur lesquels leurs algorithmes sont formés, ni de la manière dont les modèles de langage d’IA produisent des résultats. Shevran estime que cela devrait changer.

« Les recherches qui nous aident à mieux comprendre des modèles spécifiques peuvent nous aider à mieux répondre à une gamme de risques différents », a-t-il déclaré.

Si vous ignorez les fondamentaux et les problèmes apparemment mineurs et vous concentrez uniquement sur les risques extrêmes, il peut y avoir un effet cumulatif qui peut causer des dommages encore plus graves. "Nous essayons d'apprendre à courir alors que nous ne pouvons même pas ramper", a déclaré Hraf

.Soutien : Ren

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI