Maison >Périphériques technologiques >IA >Le modèle d'appel d'API le plus puissant est ici ! Basé sur le réglage fin de LLaMA, les performances dépassent GPT-4

Le modèle d'appel d'API le plus puissant est ici ! Basé sur le réglage fin de LLaMA, les performances dépassent GPT-4

- 王林avant

- 2023-06-10 11:41:501816parcourir

Après l'alpaga, il existe un autre modèle nommé d'après un animal, cette fois-ci il s'agit du gorille.

Bien que LLM soit actuellement à l'honneur, fasse de nombreux progrès et que ses performances dans diverses tâches soient également remarquables, ces modèles utilisent efficacement les outils via des appels API. Le potentiel doit encore être exploité.

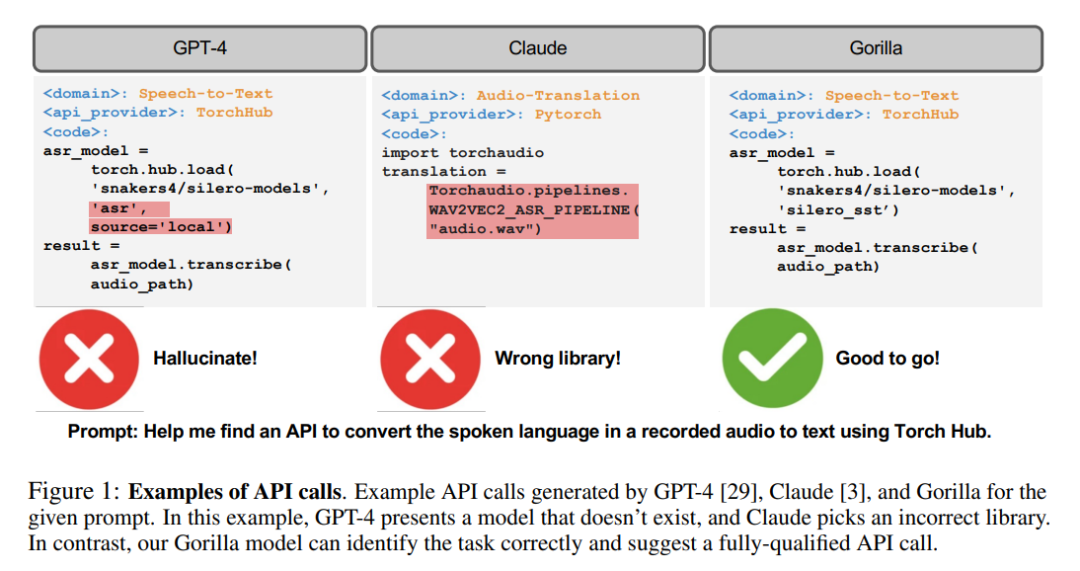

Même pour les LLM les plus avancés d'aujourd'hui, tels que GPT-4, les appels d'API sont une tâche difficile, principalement en raison de leur incapacité à générer des paramètres d'entrée précis, et LLM est sujet aux hallucinations dues à une utilisation incorrecte des appels API.

Non, les chercheurs ont créé Gorilla, un modèle affiné basé sur LLaMA qui surpasse même GPT-4 dans l'écriture d'appels API.

Lorsqu'il est combiné à un outil de récupération de documents, Gorilla démontre également des performances puissantes, rendant les mises à jour utilisateur ou les changements de version plus flexibles.

De plus, Gorilla atténue également grandement le problème d'hallucination que LLM rencontre souvent.

Pour évaluer les capacités du modèle, les chercheurs ont également introduit un benchmark API, un ensemble de données complet composé des API HuggingFace, TorchHub et TensorHub#🎜 🎜#

GorillaIl n'est pas nécessaire de présenter les puissantes capacités des LLM, notamment les capacités de conversation naturelle, les capacités de raisonnement mathématique et les capacités de synthèse de programmes.

Cependant, malgré ses puissantes performances, LLM souffre encore de certaines limites. De plus, les LLM doivent également être recyclés pour mettre à jour leur base de connaissances et leurs capacités de raisonnement en temps opportun.

En autorisant les outils disponibles au LLM, les chercheurs peuvent permettre au LLM d'accéder à une base de connaissances vaste et en constante évolution pour effectuer des tâches informatiques complexes.

En fournissant un accès aux technologies de recherche et aux bases de données, les chercheurs peuvent améliorer la capacité du LLM à gérer des espaces de connaissances plus vastes et plus dynamiques.

De même, en proposant l'utilisation d'outils de calcul, LLM peut également effectuer des tâches de calcul complexes.

Par conséquent, les géants de la technologie ont commencé à essayer d'intégrer divers plug-ins pour permettre à LLM d'appeler des outils externes via des API.

Le passage d'un outil plus petit et codé manuellement à un outil capable d'appeler un vaste espace d'API cloud en constante évolution peut transformer LLM en une infrastructure informatique, et le principales interfaces nécessaires au réseau. Les tâches allant de la réservation de vacances entières à l'organisation d'une conférence peuvent devenir simples comme parler à un LLM avec accès aux API Web pour les vols, la location de voitures, les hôtels, les restaurants et les divertissements.

Cependant, de nombreux travaux antérieurs intégrant des outils dans LLM considèrent un petit ensemble d'API bien documentées qui peuvent être facilement injectées dans des invites. Prendre en charge une collection à l’échelle du Web de millions d’API changeantes nécessite de repenser la manière dont les chercheurs intègrent les outils.

Il n'est plus possible de décrire toutes les API dans un seul environnement. De nombreuses API auront des fonctionnalités qui se chevauchent, avec des limitations et contraintes subtiles. La simple évaluation du LLM dans ce nouvel environnement nécessite de nouveaux repères.

Dans cet article, les chercheurs explorent l'utilisation de l'auto-réglage et de la récupération structurels pour permettre à LLM d'extraire avec précision des données à partir de grandes quantités de données exprimées à l'aide de son API. et la documentation de l'API. Ensembles d'outils qui se chevauchent et changent pour la sélection.

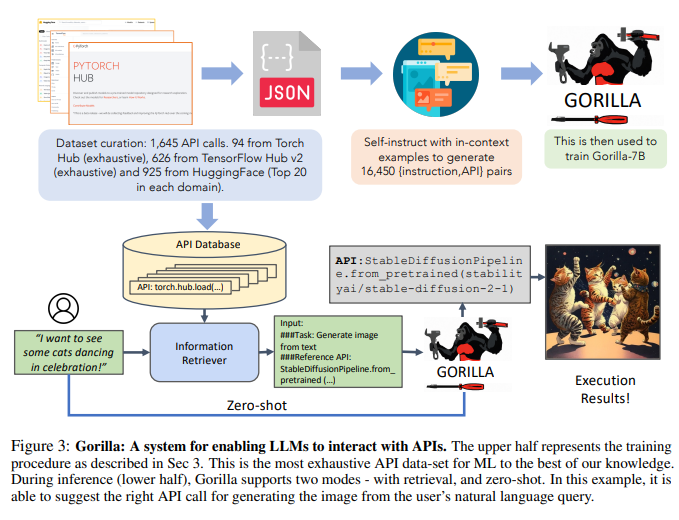

Les chercheurs ont construit API Bench en récupérant les API (modèles) ML des centres de modèles publics, un vaste corpus d'API aux fonctionnalités complexes et qui se chevauchent souvent.

Les chercheurs ont choisi trois centres modèles principaux pour construire l'ensemble de données : TorchHub, TensorHub et HuggingFace.

Les chercheurs ont inclus de manière exhaustive chaque appel d'API dans TorchHub (94 appels d'API) et TensorHub (696 appels d'API).

Pour HuggingFace, en raison du grand nombre de modèles, les chercheurs ont sélectionné les 20 modèles les plus téléchargés dans chaque catégorie de tâches (925 au total).

Les chercheurs ont également utilisé l'auto-instruction pour générer des invites pour 10 questions des utilisateurs pour chaque API.

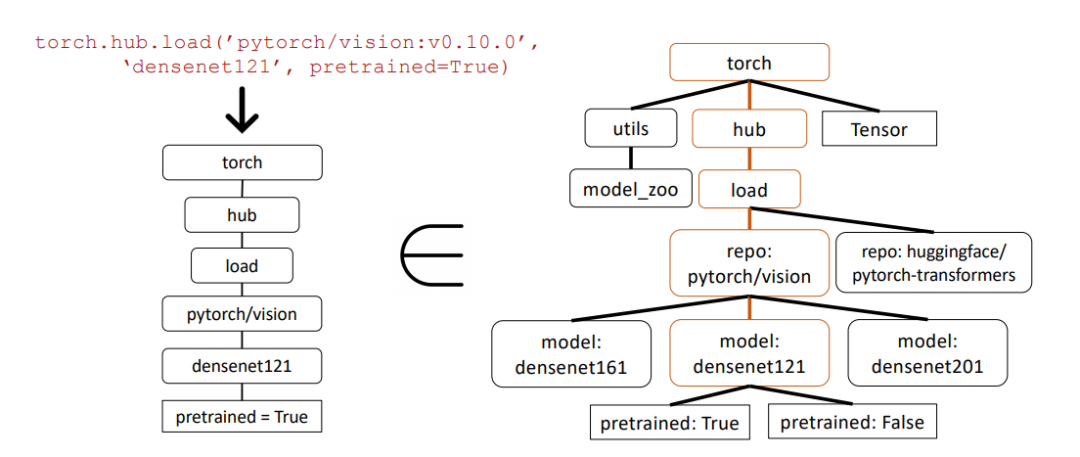

Par conséquent, chaque entrée de l'ensemble de données devient une paire d'API de référence d'instruction. Les chercheurs ont utilisé des techniques courantes de correspondance de sous-arbres AST pour évaluer l'exactitude fonctionnelle des API générées.

Les chercheurs analysent d'abord le code généré dans un arbre AST, puis trouvent un sous-arbre dont le nœud racine est l'appel API qui intéresse le chercheur, puis l'utilisent pour indexer Ensemble de données des chercheurs.

Les chercheurs vérifient l'exactitude fonctionnelle et les problèmes d'hallucinations des LLM et fournissent des commentaires sur la précision correspondante. Les chercheurs ont ensuite affiné Gorilla, un modèle basé sur LLaMA-7B, pour effectuer des opérations de récupération de documents en utilisant l'ensemble de données des chercheurs.

Les chercheurs ont découvert que Gorilla surpassait considérablement GPT-4 en termes de précision des fonctionnalités de l'API et de réduction des erreurs illusoires.

Les chercheurs montrent un exemple dans la figure 1.

De plus, la formation des chercheurs axée sur la récupération sur Gorilla a permis de model Capacité à s'adapter aux changements dans la documentation de l'API.

Enfin, les chercheurs ont également démontré la capacité du Gorille à comprendre et à raisonner sur les contraintes.

De plus, Gorilla a également bien performé en termes d'illusions.

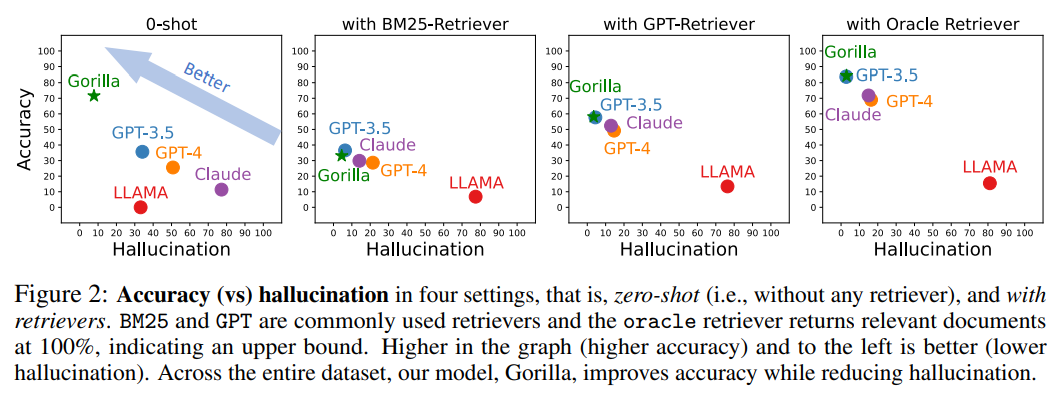

La figure suivante est une comparaison de la précision et des hallucinations dans quatre cas, zéro échantillon (c'est-à-dire sans aucun récupérateur) et utilisant des récupérateurs de BM25, GPT et Oracle.

Parmi eux, BM25 et GPT sont des récupérateurs couramment utilisés, tandis que le récupérateur Oracle renverra les documents pertinents avec une pertinence de 100 %, indiquant une limite supérieure.

Celui qui a une plus grande précision et moins d'illusions dans l'image a un meilleur effet.

Sur l'ensemble de l'ensemble de données, Gorilla améliore la précision tout en réduisant les hallucinations. Pour collecter l'ensemble de données, les chercheurs ont méticuleusement enregistré les modèles en ligne The All de HuggingFace pour les modèles Model Hub, PyTorch Hub et TensorFlow Hub.

La plateforme HuggingFace héberge et dessert un total de 203 681 modèles.

Cependant, la documentation de bon nombre de ces modèles est médiocre.

Pour filtrer ces modèles de mauvaise qualité, les chercheurs ont finalement sélectionné les 20 meilleurs modèles de chaque domaine.

Les chercheurs ont considéré 7 domaines de données multimodales, 8 domaines de CV, 12 domaines de PNL, 5 domaines d'audio et 2 domaines de données tabulaires et 2 domaines de apprentissage par renforcement.

Après filtrage, les chercheurs ont obtenu un total de 925 modèles de HuggingFace. Les versions de TensorFlow Hub sont divisées en v1 et v2.

La dernière version (v2) compte un total de 801 modèles, et les chercheurs ont traité tous les modèles. Après avoir filtré les modèles contenant peu d’informations, il restait 626 modèles.

Semblable à TensorFlow Hub, les chercheurs ont obtenu 95 modèles de Torch Hub.

Sous la direction du paradigme d'auto-instruction, les chercheurs ont adopté GPT-4 pour générer des données d'instruction synthétiques.

Les chercheurs ont fourni trois exemples en contexte, ainsi qu'un document API de référence, et ont chargé le modèle de générer des cas d'utilisation réels pour appeler l'API.

Les chercheurs ont spécifiquement demandé au modèle de ne pas utiliser de noms d'API ou d'indices lors de la création d'instructions. Les chercheurs ont construit six exemples (paires instruction-API) pour chacun des trois hubs modèles.

Ces 18 points sont les seules données générées ou modifiées manuellement.

Et Gorilla est un modèle LLaMA-7B prenant en charge la récupération, spécifiquement utilisé pour les appels API.

Comme le montre la figure 3, les chercheurs ont utilisé l'auto-construction pour générer des paires {instruction, API}.

Pour affiner LLaMA, les chercheurs l'ont converti en une conversation de type chat utilisateur-agent, où chaque point de données est une conversation et l'utilisateur et l'agent parlent à tour de rôle.

Ensuite, les chercheurs ont effectué un réglage fin des instructions standard sur le modèle de base LLaMA-7B. Lors d'expériences, les chercheurs ont entraîné des gorilles avec et sans retriever.

Dans l’étude, les chercheurs se sont concentrés sur des techniques conçues pour améliorer la capacité du LLM à identifier avec précision les API appropriées pour des tâches spécifiques – un aspect crucial, mais souvent négligé, du développement de la technologie.

Étant donné que l'API fonctionne comme un langage universel permettant une communication efficace entre différents systèmes, une utilisation appropriée de l'API peut améliorer la capacité de LLM à interagir avec une gamme plus large d'outils.

Gorilla a surpassé le LLM de pointe (GPT-4) sur trois ensembles de données à grande échelle collectés par les chercheurs. Gorilla produit des modèles ML fiables d'appels d'API sans hallucinations et satisfait aux contraintes lors de la sélection des API.

Cherchant à trouver un ensemble de données stimulant, les chercheurs ont choisi les API ML en raison de leurs fonctionnalités similaires. Un inconvénient potentiel des API axées sur le ML est que si elles sont formées sur des données biaisées, elles peuvent potentiellement produire des prédictions biaisées susceptibles de désavantager certains sous-groupes.

Pour apaiser cette inquiétude et promouvoir une compréhension plus approfondie de ces API, les chercheurs publient un ensemble de données plus complet comprenant plus de 11 000 paires instruction-API.

Dans l'exemple ci-dessous, les chercheurs utilisent la correspondance de sous-arbres Abstract Syntax Tree (AST) pour évaluer l'exactitude des appels d'API.

L'arbre de syntaxe abstraite est une représentation arborescente de la structure du code source, qui permet de mieux analyser et comprendre le code.

Tout d'abord, les chercheurs ont construit l'arborescence API pertinente à partir des appels API renvoyés par Gorilla (à gauche). Ceci est ensuite comparé à l'ensemble de données pour voir si l'ensemble de données API a une correspondance de sous-arbre.

Dans l'exemple ci-dessus, le sous-arbre correspondant est surligné en marron, indiquant que l'appel API est effectivement correct. Où Pretrained=True est un paramètre facultatif.

Cette ressource servira à la communauté au sens large en tant qu'outil précieux pour rechercher et mesurer les API existantes, contribuant ainsi à une utilisation plus équitable et optimale de l'apprentissage automatique.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI