Maison >Périphériques technologiques >IA >5 millions de monstres symboliques, lisez l'intégralité de 'Harry Potter' d'un seul coup ! Plus de 1000 fois plus long que ChatGPT

5 millions de monstres symboliques, lisez l'intégralité de 'Harry Potter' d'un seul coup ! Plus de 1000 fois plus long que ChatGPT

- 王林avant

- 2023-06-10 10:42:301176parcourir

Une mauvaise mémoire est le principal problème des modèles linguistiques à grande échelle actuels. Par exemple, ChatGPT ne peut saisir que 4 096 jetons (environ 3 000 mots). J'oublie souvent ce que j'ai dit auparavant en discutant, et ce n'est même pas suffisant. lire une courte histoire de.

La fenêtre de saisie courte limite également les scénarios d'application du modèle linguistique. Par exemple, lors de la synthèse d'un article scientifique (environ 10 000 mots), vous devez segmenter manuellement l'article puis le saisir dans le modèle en différents chapitres. Les informations associées sont perdues.

Bien que GPT-4 puisse prendre en charge jusqu'à 32 000 jetons et que Claude mis à niveau puisse prendre en charge jusqu'à 100 000 jetons, ils ne peuvent que atténuer le problème de la capacité cérébrale insuffisante.

Récemment, une équipe entrepreneuriale Magic a annoncé qu'elle lancerait bientôt le Modèle LTM-1, qui prend en charge jusqu'à 5 millions de jetons, soit environ 500 000 lignes de code ou 5 000 fichiers, soit 50 fois plus élevé que Claude. C'est fondamentalement ok. Couvre la plupart des besoins de stockage, cela fait vraiment une différence en quantité et en qualité !

Le principal scénario d'application de LTM-1 est la complétion de code, par exemple, il peut générer des suggestions de code plus longues et plus complexes.

Vous pouvez également réutiliser et synthétiser des informations dans plusieurs fichiers.

La mauvaise nouvelle est que Magic, le développeur de LTM-1, n'a pas publié les principes techniques spécifiques, mais a seulement déclaré avoir conçu une toute nouvelle méthode, le réseau de mémoire à long terme (LTM Net).

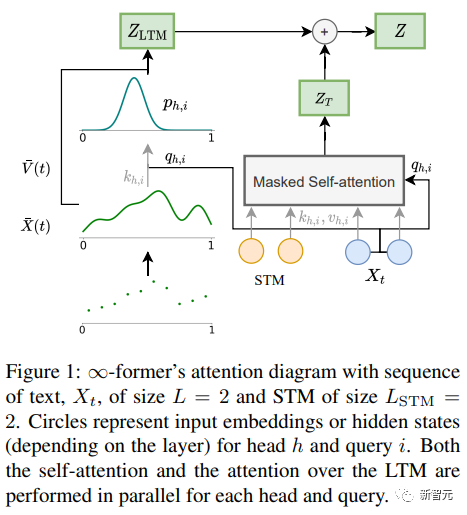

Mais il y a aussi une bonne nouvelle. En septembre 2021, des chercheurs de DeepMind et d'autres institutions ont proposé un modèle appelé ∞-former, qui inclut un mécanisme de mémoire à long terme (LTM). La théorie peut rendre le modèle Transformer infini. mémoire, mais il n'est pas clair s'il s'agit de la même technologie ou d'une version améliorée. LTM Nets peut voir plus de contexte que GPT, LTM Le nombre de LTM Nets peut voir plus de contexte que GPT, LTM Le nombre de Les paramètres du modèle -1 sont beaucoup plus petits que ceux du modèle sota actuel, donc le niveau d'intelligence est également inférieur. Cependant, continuer à augmenter la taille du modèle devrait améliorer les performances des LTM Nets.

Actuellement, LTM-1 a ouvert des applications de test alpha. LTM -1 développeur Magic a été fondé en 2022 et développe principalement des GitHub Copilot similaires Le produit peut aider les ingénieurs logiciels à écrire, réviser, déboguer et modifier le code. L'objectif est de créer un collègue IA pour les programmeurs. Son principal avantage concurrentiel est que le modèle peut lire du code plus long.

En février de cette année, Magic a reçu un financement de série A de 23 millions de dollars dirigé par CapitalG, une filiale d'Alphabet. Les investisseurs comprennent également l'ancien PDG de GitHub et coproducteur de Copilot, Nat Friedman, qui est actuellement le directeur de la société. président, le montant des fonds a atteint 28 millions de dollars américains.

Eric Steinberger, PDG et co-fondateur de Magic, est diplômé de l'Université de Cambridge avec un baccalauréat en informatique et a effectué des recherches sur l'apprentissage automatique au FAIR.

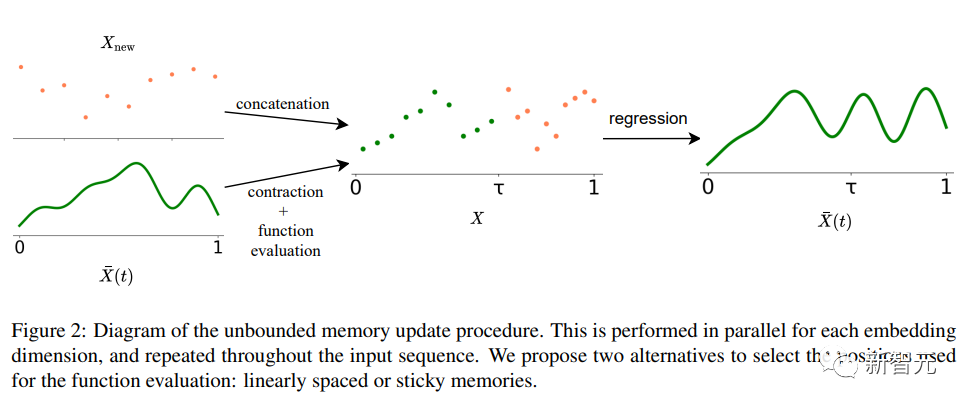

Avant de fonder Magic, Steinberger a également fondé ClimateScience pour aider les enfants du monde entier à découvrir les impacts du changement climatique. La conception du mécanisme d'attention dans le composant central du modèle de langage, Transformer, entraînera à chaque fois la longueur de la séquence d’entrée est augmentée, la complexité temporelle augmentera quadratiquement. Bien qu'il existe déjà quelques variantes du mécanisme d'attention, comme l'attention éparse, etc. pour réduire la complexité de l'algorithme, sa complexité est toujours liée à l'entrée longueur et ne peut pas être étendu à l’infini. ∞-former La clé du modèle de transformateur à mémoire à long terme (LTM) qui peut étendre la séquence d'entrée à l'infini est un cadre d'attention spatiale continue qui utilise des Cette manière de représenter la granularité augmente le nombre d’unités d’informations mémoire (fonctions de base). Dans le cadre, la séquence d'entrée est représentée comme un "signal continu", représente une combinaison linéaire de N fonctions de base radiales (RBF). De cette manière, la complexité d'attention de ∞-former est réduite à O(L^2 + L). × N), tandis que la complexité d'attention du transformateur d'origine est O (L×(L+L_LTM)), où L et L_LTM correspondent respectivement à la taille d'entrée du transformateur et à la longueur de la mémoire à long terme. Cette méthode de représentation présente deux avantages principaux : Infinite Memory Transformer

1. de jetons Il est représenté par la fonction de base N, qui réduit le coût de calcul de l'attention ; n'augmente pas la complexité du mécanisme d'attention.

Bien sûr, il n'y a pas de repas gratuit au monde, le prix est la réduction de la résolution : l'utilisation d'un plus petit nombre de fonctions de base entraîne une précision réduite lors de la représentation de la séquence d'entrée sous forme de signal continu.

Pour atténuer le problème de réduction de résolution, les chercheurs ont introduit le concept de « mémoires collantes » pour attribuer des espaces plus grands dans le signal LTM à des zones mémoire plus fréquentes. de « permanence » dans LTM, permettant au modèle de mieux capturer le contexte à long terme sans perdre les informations pertinentes. Il s'inspire également du potentiel à long terme et de la plasticité du cerveau.

Partie expérimentale

Partie expérimentale

Afin de vérifier si ∞-ancien Pour modéliser des contextes longs, les chercheurs ont d'abord expérimenté une tâche de synthèse, qui consiste à trier les jetons par fréquence dans une longue séquence ; puis ils ont expérimenté la modélisation du langage et la génération de dialogues basés sur des documents en affinant les modèles de langage pré-entraînés.

Trier

Fr ter Comprend une séquence de jetons échantillonnés selon une distribution de probabilité (inconnue du système), dans le but de générer des jetons par ordre décroissant de fréquence dans la séquence 🎜#Pour étudier si la mémoire à long terme est efficace utilisés et si le Transformer trie simplement en modélisant les balises les plus récentes, les chercheurs ont conçu la distribution de probabilité des balises pour qu'elle change au fil du temps.

Il y a 20 jetons dans le vocabulaire. Des expériences ont été menées avec des séquences de longueurs de 4 000, 8 000 et 16 000 respectivement et un transformateur compressif a été utilisé comme modèle de base. pour comparaison.

Les résultats expérimentaux montrent que dans le cas d'une longueur de séquence courte (4 000), le Transformer-XL atteint une précision légèrement supérieure à celle des autres modèles, mais lorsque la longueur de la séquence augmente, sa précision diminue également rapidement. mais pour ∞-ancien, cette diminution n’est pas évidente, ce qui indique qu’elle présente plus d’avantages lors de la modélisation de longues séquences.

Modélisation du langage

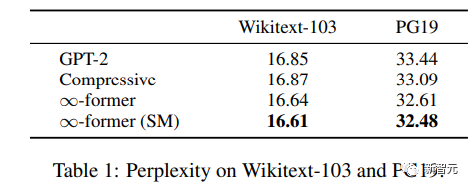

#🎜 🎜 # Pour comprendre si la mémoire à long terme peut être utilisée pour mettre à l'échelle des modèles de langage pré-entraînés, les chercheurs ont affiné GPT-2 sur un sous-ensemble de Wikitext103 et PG-19, comprenant environ 200 millions de jetons.

Les résultats expérimentaux montrent que ∞-former peut réduire Wikitext- 103 et PG19, et le premier ∞ permet d'obtenir de plus grandes améliorations sur l'ensemble de données PG19 car les livres s'appuient davantage sur la mémoire à long terme que les articles Wikipédia. # 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 # Conversation basée sur Doc # 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 #Dans la génération de dialogue basée sur des documents, en plus de l'historique du dialogue, le modèle peut également obtenir des documents sur le sujet de la conversation.

Dans l'ensemble de données CMU Document Grounded Conversation (CMU-DoG), la conversation porte sur le film, et un résumé du film est donné comme document à l'appui ; que la conversation contient plusieurs discours continus différents, les documents auxiliaires sont divisés en plusieurs parties. Pour évaluer l’utilité de la mémoire à long terme, les chercheurs n’ont donné accès au fichier au modèle qu’avant le début de la conversation, ce qui a rendu la tâche plus difficile. Après avoir affiné GPT-2 small, afin de permettre au modèle de garder l'intégralité du document en mémoire, un LTM continu avec N=512 fonctions de base (∞ - ancien) étend GPT-2.

Afin d'évaluer l'effet de modèle, les indicateurs de perplexité, de score F1, Rouge-1 et Rouge-L, et Meteor sont utilisés.

À partir des résultats, le ∞-former et le Transformer compressif peuvent générer plus de For bon corpus, même si la perplexité des deux est fondamentalement la même, ∞-former obtient de meilleurs scores sur d’autres indicateurs.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI