Maison >Périphériques technologiques >IA >Minsheng Securities : Edge AI est une tendance du secteur. Il est recommandé de prêter attention à ces objectifs.

Minsheng Securities : Edge AI est une tendance du secteur. Il est recommandé de prêter attention à ces objectifs.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-06-05 17:13:47838parcourir

L'avis de la semaine

1.1 NVIDIA : Chemin de l'intelligence incorporée avec Omniverse comme noyau

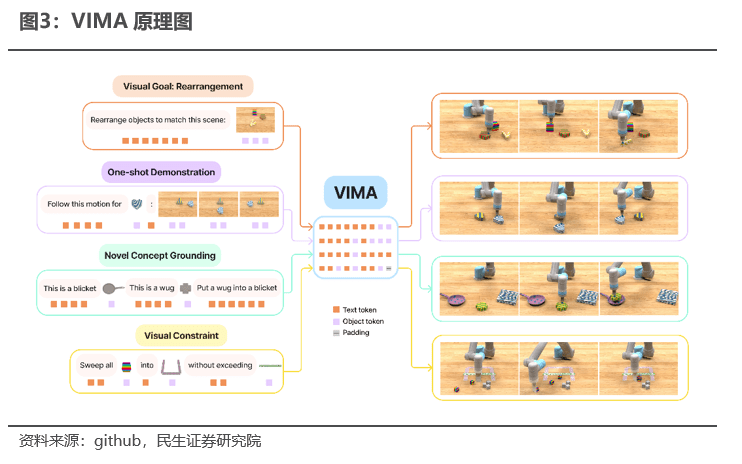

NVIDIA choisit la voie de l'intelligence incarnée, caractérisée par un développement allant de la périphérie au cloud. Ses principaux produits sont les bras robotiques VIMA et les plateformes de robots mobiles Isaac AMR. NVIDIA a publié un bras robotique basé sur le grand modèle VIMA à l'ITF2023. Selon NVIDIA, VIMA peut comprendre, raisonner et interagir avec le monde physique, par exemple déplacer et organiser des objets selon des invites visuelles et textuelles. simuler la physique et faire des prédictions conformes aux lois de la physique. Isaac AMR est une plate-forme de simulation, de validation, de déploiement, d'optimisation et de gestion de flottes de robots mobiles autonomes. Elle comprend des services logiciels edge-to-cloud, de l'informatique et un ensemble de capteurs de référence et de matériel robotique pour accélérer les déploiements à grande échelle. se connectant aux services cloud de DeepMap. La cartographie et la compréhension sémantique de l'environnement réduisent le temps nécessaire aux robots pour cartographier les grandes installations de plusieurs semaines à quelques jours et atteignent une précision centimétrique sans avoir besoin d'une équipe technique senior. En générant de riches cartes de voxels 3D, il peut créer des cartes d'occupation et sémantiques pour de nombreux types de raffinement de maillage adaptatif (AMR).

L'intelligence incarnée fait référence à des algorithmes de formation en imitant le fonctionnement du cerveau humain, permettant ainsi la compréhension de soi, l'auto-optimisation et, finalement, l'apprentissage et la croissance à l'image des humains. NVIDIA VIMA prend en charge les modes multimodaux tels que le texte, la vision et la voix comme entrée de tâche du robot, et utilise des tests de généralisation systématiques, notamment des tests de référence de simulation, plus de 600 000 trajectoires d'experts et des protocoles d'évaluation à plusieurs niveaux comme ensemble de résultats cibles ; Le modèle T5 pré-entraîné code les signaux multimodaux et module le contrôleur du robot sur les signaux via une couche d'attention croisée, prédisant les commandes motrices conditionnées par les signaux et l'historique des interactions sous la forme d'un ensemble de sorties et de cibles prédites via le modèle. Comparaison des sorties et ; L'auto-optimisation stimule l'apprentissage autonome VIMA. Dans la tâche de formation de généralisation à échantillon zéro la plus difficile, le taux de réussite des tâches de VIMA est jusqu'à 2,9 fois supérieur à la méthode optimale précédente, tout en utilisant 10 fois moins de données de formation, VIMA Les performances sont toujours 2,7 fois. mieux que les meilleures méthodes concurrentes.

Avec des ensembles de données du monde réel, l'intelligence incorporée est un élément de compétitivité essentiel, et NVIDIA Omniverse est la référence du secteur. Pour mener une formation sur l’intelligence incorporée, des ensembles de données spéciaux sont nécessaires. Par exemple, pour le bras robotique VIMA, les données suivantes sont requises :

1) Ensemble de tâches multimodales : 17 méta-tâches, chaque méta-tâche peut être divisée en 1000 tâches distinctes, y compris diverses tâches multimodales telles que la compréhension sémantique et la segmentation visuelle

2) Success Stories : NVIDIA a préparé 650 000 trajectoires de réussite

3) Récompense de référence : établissez VIMA-Bench pour utiliser les méthodes de la théorie des probabilités pour évaluer raisonnablement les résultats de prédiction de l'IA des tâches et donner à l'IA des commentaires corrects

NVIDIA Omnivers est la principale plate-forme de jumeau numérique au monde, composée de cinq composants importants : Nucleus, Connect, Kit, Simulation et RTX renderer, ainsi que d'outils et de rendus de création de contenu numérique (DCC) tiers interopérables, ainsi que d'extensions. , les applications et les microservices construits par des tiers et NVIDIA forment un écosystème Omniverse complet. Grâce à des ensembles de données du monde réel tels que l'USD, les jumeaux numériques peuvent se conformer avec précision aux lois physiques, répondre avec précision aux mouvements des objets et être synchronisés avec les écrans. Ces données du monde réel constituent une base importante pour la mise en œuvre de l'intelligence incorporée de NVIDIA.

La voie de l'intelligence incorporée pour la percée ascendante de l'IA de pointe de NVIDIA a été ouverte. Associée au cloud computing, elle peut fournir un support technique riche dans tous les aspects de l'IA de pointe, du développement au déploiement. NVIDIA a sélectionné Microsoft Azure comme premier fournisseur de services cloud pour Omniverse Cloud. Microsoft Azure permettra aux entreprises d'accéder à l'ensemble complet des applications logicielles Omniverse et aux systèmes informatiques NVIDIA OVX™ tout en bénéficiant des fonctionnalités d'analyse d'échelle et de la sécurité des services cloud Azure, en fournissant aux clients un ensemble d'outils pouvant être utilisés pour concevoir, développer, déployer. et gérer les éléments industriels. L'environnement cloud complet et les fonctions de plate-forme d'Universe Application connectent et utilisent des produits associés de l'écosystème de partenaires de NVIDIA, tels que des postes de travail certifiés NVIDIA, des modules de calcul de pointe, etc.

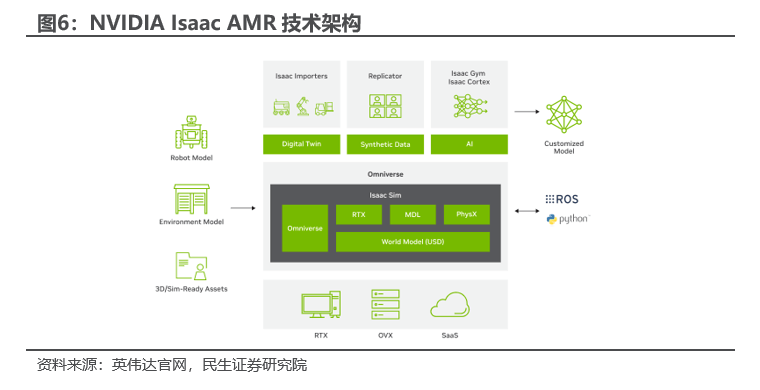

NVIDIA Isaac est une plateforme d'accélération spécialement conçue pour le développement de robots et l'IA, et la plateforme de robot mobile AMR a été la première à être lancée. La plate-forme NVIDIA Isaac commence par un modèle pré-entraîné, complété par des données synthétiques générées dans Isaac Replicator et entraîné avec NVIDIA TAO pour atteindre les performances cibles ; exploitez NVIDIA Isaac Sim disponible sur site et dans le cloud pour créer des environnements physiquement précis et réalistes. pour développer et tester tous les aspects liés au fonctionnement de votre robot ; gagnez du temps avec Nova Ori et apportez l'IA aux robots basés sur NVIDIA Jetson à l'aide de SDK d'accélération matérielle, tels que Isaac ROS GEM pour les robots basés sur ROS, Isaac ROS GEM pour l'analyse des flux vidéo NVIDIA DeepStream SDK, NVIDIA Riva pour le traitement du langage naturel ; gérez les flottes de robots pour optimiser la productivité avec EGX Fleet Command et Isaac pour AMR, notamment Metropolis, CuOpt et DeepMap. Isaac AMR est une plateforme de simulation, de validation, de déploiement, d'optimisation et de gestion de flottes de robots mobiles autonomes. Elle comprend une formation de jumeaux numériques edge-to-cloud, des services logiciels, des calculs et un ensemble de capteurs de référence et de matériel robotique pour accélérer le développement et le développement. déploiement des AMR Vitesse de déploiement, réduisant les coûts et les délais de mise sur le marché.

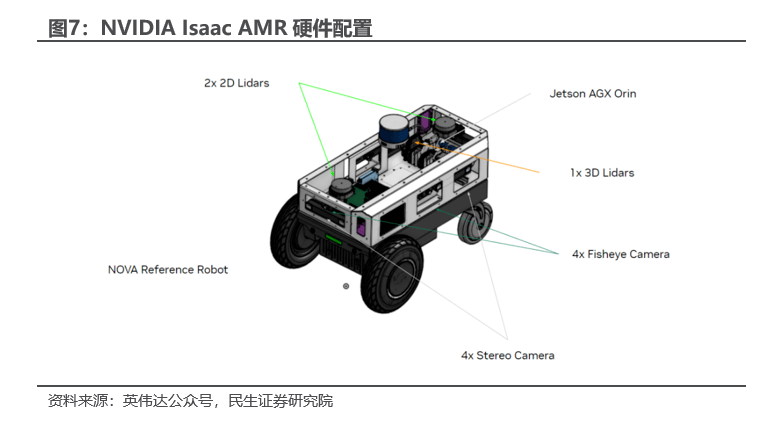

Isaac AMR est construit sur l'architecture de référence NVIDIA Nova Orin. Nova Orin intègre plusieurs capteurs et modules système, notamment des caméras stéréo, des caméras fisheye, des lidar 2D et 3D, prend en charge des algorithmes avancés d'IA et d'accélération matérielle et fournit 275TOPS de performances informatiques de pointe en temps réel. Les suites de capteurs synchronisés et calibrés offrent une diversité et une redondance de capteurs pour la détection et la cartographie 3D en temps réel. Outils cloud natifs pour l'enregistrement, le téléchargement et la lecture, facilitant le débogage, la création de cartes, la formation et l'analyse.

1.2 Qualcomm : parcours d'IA hybride intégrant cloud et edge

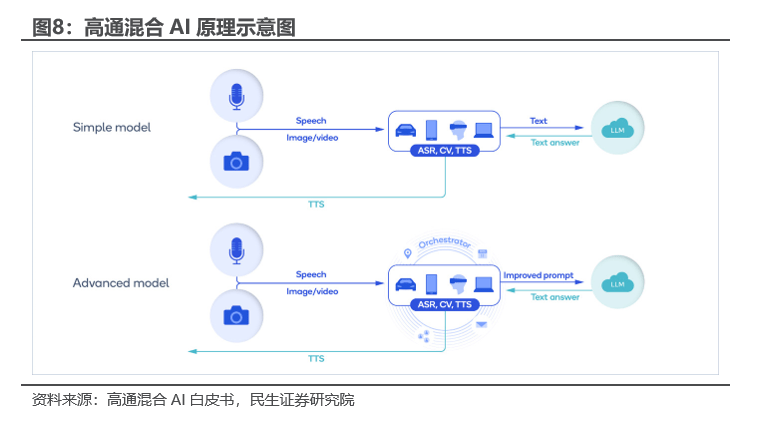

Qualcomm a annoncé le lancement d'une solution d'IA hybride cloud-edge, engagée dans le développement en profondeur de l'IA de pointe, tout en coopérant également avec Microsoft et d'autres sociétés pour développer l'IA cloud. Selon le livre blanc de Qualcomm sur l'IA hybride, dans les scénarios d'IA hybride, le grand modèle de périphérie est l'organe de détection du grand modèle cloud. Par exemple, l'utilisateur parle au téléphone mobile et le modèle d'IA de reconnaissance vocale automatique (ASR) est tel. pendant que Whisper convertit le discours en texte sur l'appareil et l'envoie vers le cloud, exécutez de grands modèles dans le cloud et renvoyez les réponses textuelles. Dans la version avancée, l'IA de l'appareil protège davantage la confidentialité, prend en charge davantage de traitement et fournit des invites plus personnalisées au cloud : grâce à l'apprentissage de l'appareil et aux données personnelles, l'appareil crée un profil utilisateur, collabore avec le planificateur et fournit de meilleures informations contextuelles. Invites : par exemple, l'utilisateur demande une réservation sur son téléphone mobile pour manger avec des amis dans son restaurant préféré. Pour des requêtes simples, un modèle plus petit et plus grand peut être exécuté sur l'appareil sans interaction avec le cloud. Si l'utilisateur a besoin d'informations complexes, la demande est. convertis en invites localement et envoyés au grand modèle dans le cloud et renvoient des réponses détaillées.

Selon le livre blanc de Qualcomm Hybrid AI, l'IA hybride présente principalement les avantages suivants :

1) Économie : réduisez les coûts d'inférence dans le cloud, utilisez efficacement la puissance de calcul de pointe et abaissez le seuil de développement d'applications d'IA

;2) Faible consommation d'énergie : les appareils Edge peuvent exécuter de grands modèles avec une consommation d'énergie inférieure si des facteurs tels que le traitement et la transmission de données sont pris en compte, les économies de consommation d'énergie seront plus importantes ;

3) Fiabilité : Edge AI n'est pas affecté par les conditions du réseau et fonctionne de manière plus stable;

4) Confidentialité : les données sont entièrement déduites localement, ce qui réduit considérablement le risque de fuite;

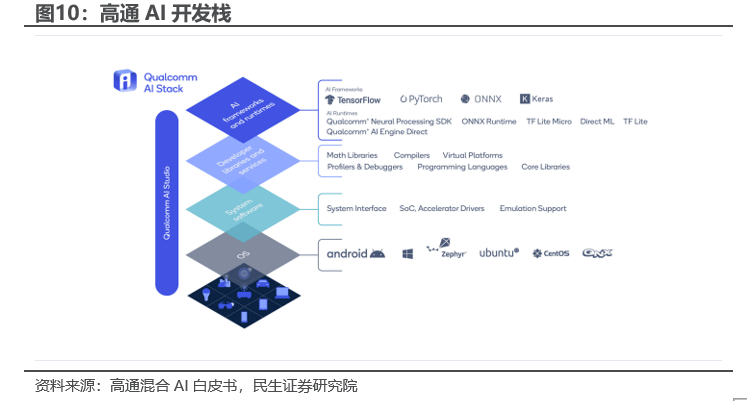

5) Personnalisation : les appareils Edge peuvent collecter les comportements réels, les valeurs, les problèmes, les besoins, les préoccupations et d'autres informations des utilisateurs pour former des services personnalisés.Côté logiciel : la pile de développement Qualcomm AI a été publiée. La pile de développement Qualcomm AI prend en charge les frameworks d'IA grand public tels que TensorFlow, PyTorch, ONNX et Keras, ainsi que les environnements d'exécution tels que TensorFlow Lite, TensorFlow Lite Micro et le runtime ONNX. En outre, il comprend des kits de développement logiciel (SDK) d'inférence tels que le populaire SDK Qualcomm® Neural Processing pour Android, Linux et Windows. Les bibliothèques et services de développement prennent en charge les derniers langages de programmation, plates-formes virtuelles et compilateurs. À un niveau inférieur, le logiciel système de pile de développement Qualcomm AI comprend un système d'exploitation en temps réel (RTOS) de base, des interfaces système et des pilotes. La pile de développement Qualcomm AI offre une prise en charge riche et diversifiée des systèmes d'exploitation dans différentes gammes de produits, notamment Android, Windows, Linux et QNX, ainsi qu'une infrastructure de déploiement et de surveillance telle que Prometheus, Kubernetes et la pile de développement Qualcomm AI comprend également AI Studio, qui. prend en charge tout, depuis un flux de travail complet de grands modèles, de la conception à l'optimisation, au déploiement et à l'analyse, en intégrant tous les outils dans une interface utilisateur graphique et en fournissant des outils de visualisation pour simplifier l'expérience des développeurs et leur permettre de visualiser le développement du modèle en temps réel, y compris les outils d'efficacité des modèles d'IA. Package (AIMET), référentiel de modèles AIMET, analyseur de modèles et recherche d'architecture neuronale (NAS).

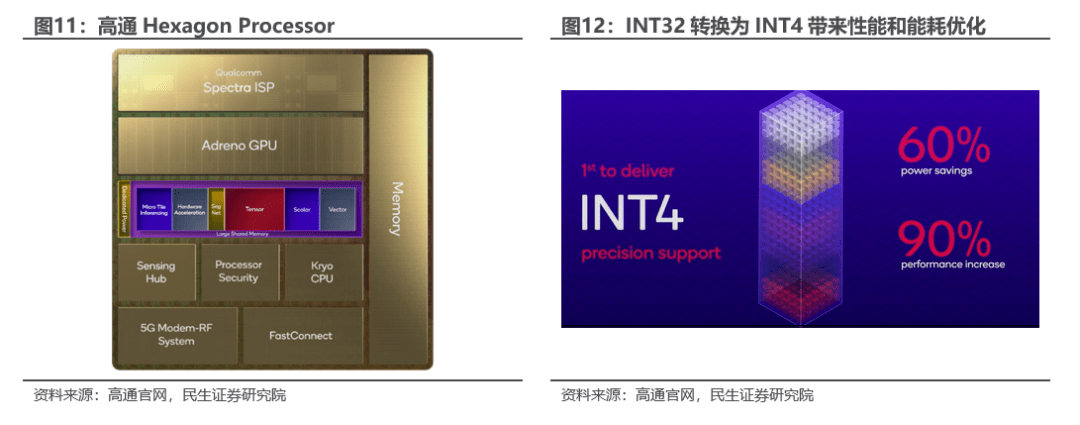

Côté matériel : cœur du processeur Qualcomm Hexagon. Le processeur Qualcomm Hexagon adopte une nouvelle architecture et un système d'alimentation dédié.Il ajoute un matériel spécial pour améliorer l'accélération de la fonction de convolution et d'activation de groupe dans l'inférence de l'IA, et double les performances de l'accélérateur tensoriel.Il utilise une méthode unique pour convertir l'IA complexe. Le modèle est décomposé en micro-tuiles pour accélérer le processus d'inférence. Les accélérateurs scalaires, vectoriels et tensoriels peuvent fonctionner simultanément sans impliquer de mémoire à chaque fois, économisant ainsi de la consommation d'énergie et du temps. De plus, une communication multi-IP transparente avec Hexagon est réalisée grâce à des ponts physiques. Cette connexion peut être utilisée pour piloter des applications à large bande passante et à faible latence, telles que les FAI cognitifs ou pour améliorer les basses résolutions dans les scénarios de jeu. Le processeur Qualcomm Hexagon a converti avec succès plusieurs modèles d'apprentissage profond de FP32 à INT4, réduisant ainsi la consommation d'énergie jusqu'à 60 % tout en augmentant les performances de 90 %.

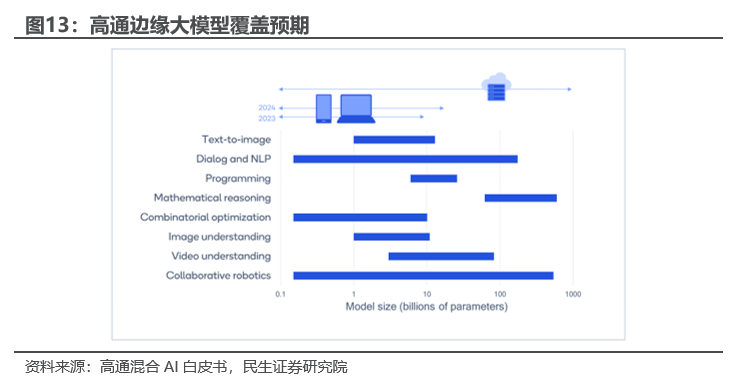

Qualcomm a déjà utilisé le modèle de diffusion stable dans la pratique, et ses projets futurs de déploiement à grande échelle de l'intelligence artificielle sont très clairs. En février 2023, Qualcomm a utilisé Qualcomm AI Stack pour effectuer une optimisation complète de l'IA et a déployé pour la première fois Stable Diffusion sur les smartphones Android. Qualcomm a publié un livre blanc sur l'intelligence artificielle hybride en mai 2023, qui prédit que d'ici fin 2023, la technologie d'intelligence artificielle de pointe couvrira divers modèles avec des paramètres inférieurs à 1 milliard.

1.3 Chuangda : Développement intégré de logiciels et matériels de grand modèle + grande plateforme

Le 18 mai 2023, Thunderbolt a lancé le grand modèle Rubik, qui est le prototype du premier système d'exploitation unifié pour les terminaux d'IA de pointe en Chine. Dans le même temps, Thunderstar a également créé conjointement un laboratoire d'innovation commun en matière d'intelligence artificielle avec Amazon Cloud Technology. , et Une série de produits Chuangda Rubik's Cube tels que des modules TurboX, des conceptions de référence de haut-parleurs intelligents et Rubik GeniusCanvas ont été présentés. Selon le rapport annuel 2022 de l'entreprise, depuis sa création, l'entreprise n'a cessé d'accumuler des technologies côté terminal, côté périphérie et côté cloud, et est désormais devenue le premier fabricant mondial de technologies dans les domaines ci-dessus. En outre, les produits robotiques de la société couvrent presque tous les scénarios robotiques actuellement existants et ont été privilégiés par de nombreux fabricants de robots à travers le monde. En outre, l'entreprise entretient une coopération approfondie avec des entreprises leaders dans la technologie et les produits de la chaîne industrielle, créant ainsi un avantage écologique. L'entreprise dispose de grands modèles du côté logiciel de l'IA de pointe, et du côté matériel, elle est profondément impliquée dans l'écologie des géants de la technologie tels que Qualcomm et Amazon. La voie de développement de logiciels et de matériels intégrés a un grand potentiel.

1.3.1 Vue horizontale : Chuangda Rubik construit un écosystème d'IA autour des entreprises existantes

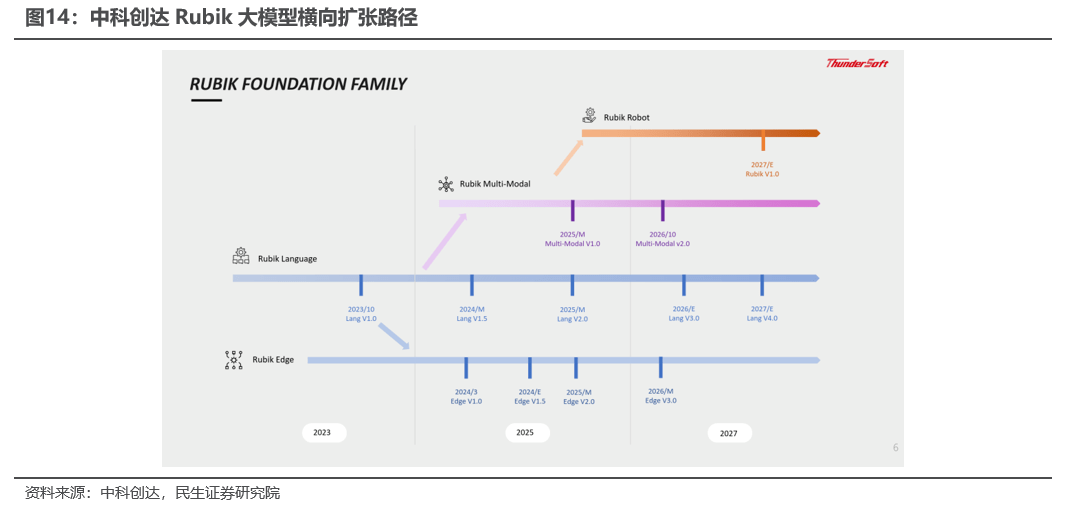

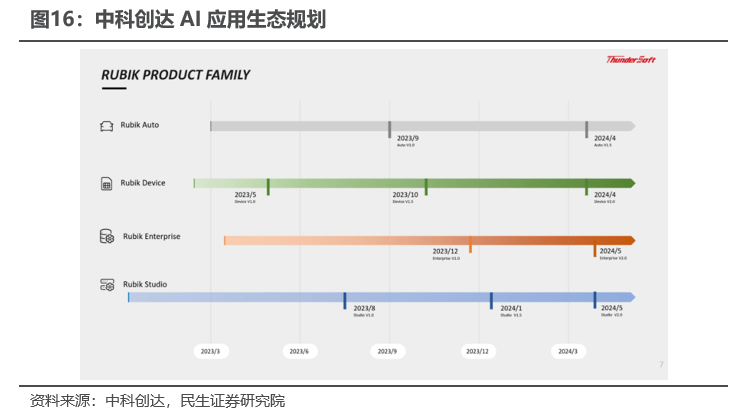

Le produit principal de la grande série de modèles Rubik est le grand modèle du langage Rubik Language. Le président prédit qu'il atteindra le niveau ChatGPT3.5 en 2024. Rubik Edge, Rubik Multi-Modal et le Rubit Robot dont le lancement est prévu en 2027 serviront tous les domaines des smartphones et de la conduite intelligente, améliorant ainsi l'expérience d'interaction homme-machine. Dans le même temps, la série Rubik construit un écosystème autour de l'interaction homme-machine et des entreprises existantes : RubikStudio, RubikAuto, RubikDevice et Rubik Enterprise. Tout en disposant d'un grand modèle puissant, il transformera également le grand modèle en une variété de modèles de petite et moyenne taille pour répondre à la répartition de divers scénarios et connaissances et améliorer l'adaptabilité avec les clients.

Semblable à Google, le grand modèle Rubik de Chuangda devrait être le premier à être lancé en tant que robot. Parmi les nombreux produits matériels intelligents, les produits robotiques de Thunderstar peuvent couvrir une variété de scénarios d'application différents et ont aidé de nombreux fabricants de robots à travers le monde à produire en masse leurs produits. Sur la base de sa profonde accumulation dans le domaine des robots, Thunderousas a intégré des haut-parleurs intelligents aux robots et, grâce à une formation continue avec le grand modèle Rubik, il a réalisé un robot de vente intelligent qui peut parler librement et répondre de manière indépendante aux questions des clients sur l'entreprise. et les produits.

1.3.2 Vue verticale : l'écosystème d'applications d'IA de Chuangda est prêt à fonctionner

La stratégie Startronics Smart to Intelligent est lancée pour réaliser un nouveau monde intelligent allant de l'interaction intelligente centrée sur les applications à l'interaction machine-machine et machine-humain pilotée par modèle. Le grand modèle Rubik sera intégré aux activités existantes de voitures intelligentes et d'IoT de l'entreprise et répondra aux besoins de diverses industries grâce à un déploiement privatisé et à un réglage du système. L'entreprise devrait transformer les robots en réalité grâce à l'optimisation continue de grands modèles et exercer ses principaux avantages concurrentiels dans le domaine toBtoC de la future industrie de l'informatique intelligente.

RUBIK Auto : Une voiture est essentiellement un robot. Les constructeurs automobiles ont trois besoins principaux pour les grands modèles de voitures. Le premier est le fonctionnement final, les données et les performances qui sont les meilleures et peuvent mieux protéger la vie privée des clients. Cependant, les exigences matérielles sont plus élevées : le deuxième est un cloud privé + un plugin, qui peut être configuré de manière flexible, le troisième est la coexistence de plusieurs modèles ouverts ; RUBIK Auto de la société soutiendra le déploiement de la privatisation des clients (elle a coopéré avec les principaux constructeurs automobiles étrangers pour mener des recherches et développements POC basés sur le modèle de l'entreprise), et prend également en charge la quantification et la personnalisation des modèles, puis s'adapte à diverses puces pour s'interfacer de manière flexible avec la voiture. fabricants.

Appareil RUBIK : parmi le matériel intelligent, tant qu'il s'agit de produits informatiques de grande taille, le principal matériel intelligent déployé à l'origine dans les systèmes d'exploitation de Chuangda peut ajouter directement l'IA. Une fois que l'IA s'est installée à la périphérie, cela signifie que le matériel intelligent devient le centre du système. scène. Qu'il s'agisse d'une scène domestique, d'un bâtiment ou d'une usine, chaque scène peut devenir un centre intelligent grâce au déploiement en périphérie.

RUBIK Enterprise (Enterprise Edition) : l'un des avantages évidents de Chuangda est l'internationalisation. L'entreprise dispose de centres et d'équipes de R&D dans 15 pays et régions du monde. L'entreprise déploiera via la localisation et prendra en charge le déploiement privatisé des clients ; le deuxième avantage évident de l'entreprise est l'intégration du logiciel et du matériel, qu'il s'agisse d'inférence ou de formation, l'entreprise a une très bonne compréhension de l'ensemble de la plate-forme sous-jacente, car qu'il s'agisse d'inférence ou de formation. c'est le framework AI ou les autres frameworks open source qui font essentiellement partie du système d'exploitation. Qu'il s'agisse du parallélisme des données ou du parallélisme des modèles, l'entreprise estime qu'ils sont tous des middleware. Ces avantages évidents nous permettent d'optimiser les performances et l'efficacité des modèles, d'optimiser l'échelle du modèle, de l'exécuter en périphérie et de responsabiliser des milliers d'industries.

RUBIK Studio : sur la base de sa compréhension approfondie du système d'exploitation, l'entreprise différencie et modélise chaque segment du système d'exploitation et accumule des milliers de packages publiés avec succès, des centaines de milliards de lignes de code et une expérience de développement à long terme. En transformant les connaissances Android en une énorme base de connaissances et en exerçant une valeur énorme, Rubik Studio sera un outil et un environnement majeurs qui changeront tout l'avenir. Les utilisateurs peuvent développer directement et rapidement des applications PC, des applications mobiles et des sites Web dotés de fonctions relativement fermées via Rubik Studio.

1.4 Apple : ChatGPT est d'abord connecté à IOS, la WWDC 2023 mérite d'être attendue

Le 18 mai 2023, OpenAI a publié la version IOS de l'application ChatGPT (en même temps, il a été officiellement annoncé que la version Android de l'application était en cours de développement. Selon le site officiel d'Apple, l'application ne prend en charge que l'anglais et a un âge). note de « 12 ans et plus » et prend en charge la synchronisation réseau des enregistrements de discussion, la saisie vocale chuchotée et d'autres fonctions. La version IOS de l'application de téléchargement ChatGPT est gratuite, mais un article payant « ChatGPT Plus » au prix de 19,99 $ US dans l'APP sera fourni pour permettre l'utilisation de grands modèles GPT4 avec des performances plus élevées.

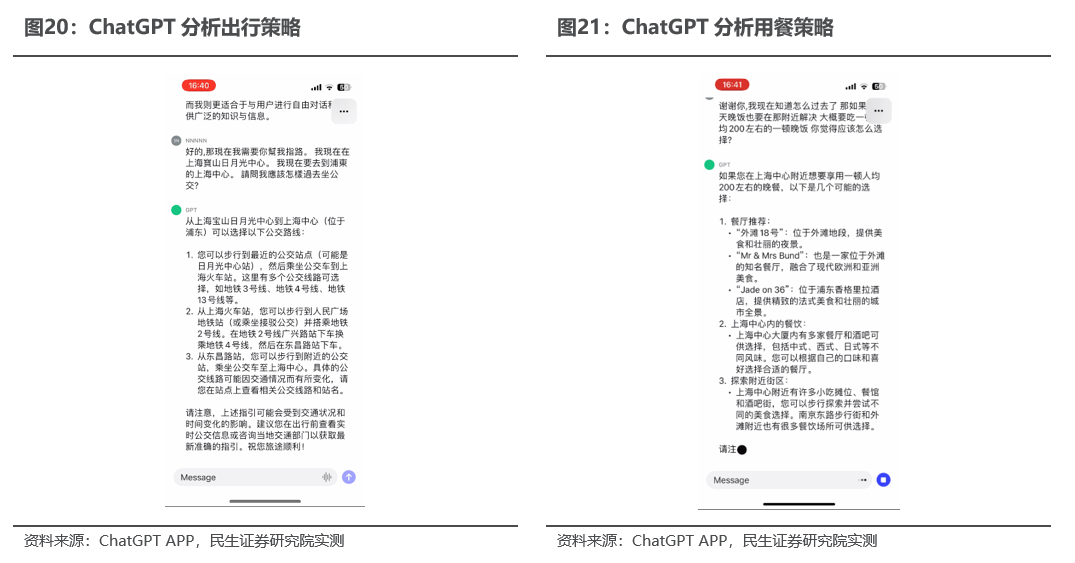

Phrase réécrite : ChatGPT APP pourrait devenir le prototype de la super APP de téléphone mobile et reconstruire l'écosystème d'applications d'intelligence artificielle sur cette base. Selon Jiupai Finance, la version IOS de ChatGPT APP a déjà la capacité de résoudre de manière flexible divers problèmes quotidiens. ChatGPT APP peut fournir des réponses instantanées, et les utilisateurs peuvent obtenir des informations précises sans filtrer les publicités ou les résultats multiples, ils fournissent des suggestions personnalisées, et les utilisateurs se tournent ; leur fournir des conseils sur la cuisine, la planification de voyages ou l'élaboration d'un message réfléchi ; leur fournir une inspiration créative, générer des idées de cadeaux pour les utilisateurs, décrire une présentation ou écrire de belles poésies. En outre, l'application ChatGPT peut également aider les utilisateurs à améliorer leur efficacité au travail grâce à des informations professionnelles, telles que des commentaires sur des idées, des résumés de notes et des sujets techniques, et offrir aux utilisateurs des opportunités d'apprentissage pour les aider à explorer de nouvelles langues, l'histoire moderne, etc. propre rythme. Nous pensons que sous l'hypothèse d'une mise en œuvre réussie de l'écosystème d'applications d'IA ChatGPT+Plugin, l'application ChatGPT devrait devenir à l'avenir le cœur de l'écosystème d'applications d'IA mobile grâce à la formation de données interactives massives provenant des utilisateurs de téléphones mobiles. les utilisateurs sont censés appeler d'autres applications via l'application ChatGPT pour répondre à divers besoins rigides, l'application ChatGPT se développera en une super application sans précédent.

Le slogan de l'Apple WWDC 2023 est "Coder de nouveaux mondes". En tant qu'entrée importante dans l'interaction homme-machine, Siri devrait devenir un point de départ important pour qu'Apple se lance dans l'IA. Selon IT House, Xinzhiyuan et Tencent Cloud, Apple commencera à développer des applications permettant aux utilisateurs d'utiliser Siri pour créer des programmes pour MR au plus tard en février 2023. La technologie derrière cette méthode de construction d'applications provient de l'acquisition de MR par Apple en 2017. Logiciel Fabric : les utilisateurs peuvent utiliser Siri pour créer des applications AR, en demandant à l'assistant IA de les aider à créer des applications permettant aux animaux virtuels de se déplacer dans une pièce, au-dessus et autour d'objets réels, sans avoir à concevoir l'animal à partir de zéro, programmer ses animations et calculer ses mouvements.Applications pour le mouvement dans un espace 3D avec des obstacles, qui incluent « la numérisation et l'importation d'objets du monde réel dans le casque afin qu'ils puissent être représentés avec précision en 3D et se comporter comme s'ils existaient dans la vie réelle ».

1.5 Huawei : la base de données IEF+Gaussian couvre entièrement les scénarios d'IA de pointe

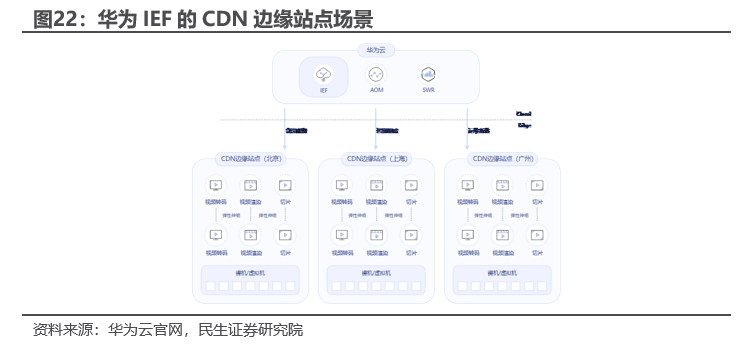

Huawei Intelligent Edge Platform IEF est un système d'exploitation collaboratif Edge-Cloud construit sur une technologie cloud native. Il peut fonctionner sur un grand nombre d'appareils Edge hétérogènes et déployer une IA riche, une analyse de données, un middleware et d'autres applications à partir du cloud de manière légère. manière à la périphérie pour répondre aux demandes commerciales des utilisateurs en matière de collaboration d’applications intelligentes entre la périphérie et le cloud. IEF peut étendre les capacités d'IA/Big Data de Huawei Cloud jusqu'à la périphérie, prendre en charge l'analyse vidéo intelligente, la reconnaissance de texte, la reconnaissance d'images, le traitement des flux de Big Data et d'autres capacités, et fournir des services de périphérie intelligents en temps réel à proximité. Il prend en charge deux modes de fonctionnement : conteneur ; et fonctionnel. Il répond aux demandes des utilisateurs en matière de gestion légère des applications ; il prend en charge nativement Kubernetes et l'écologie Docker, et les applications peuvent être rapidement démarrées et mises à niveau ; il prend en charge les moteurs de fonction tels que Python et NodeJS pour répondre rapidement aux événements de périphérie ; il a une excellente compatibilité, sécurité et fiabilité.

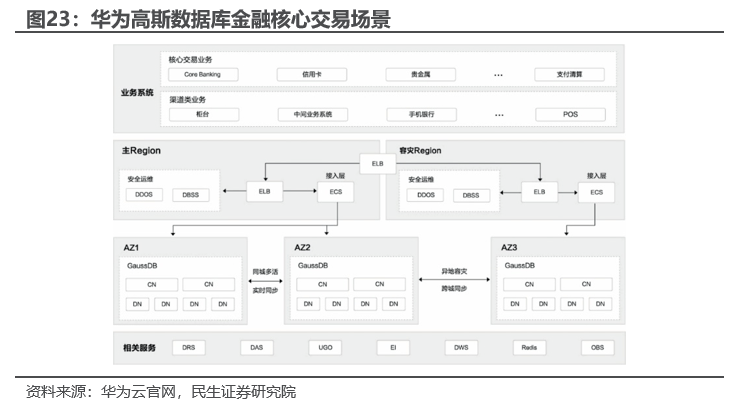

Huawei Gauss Database est une base de données relationnelle distribuée au niveau de l'entreprise lancée par Huawei basée sur l'écosystème d'auto-recherche openGaussDB. Elle possède des capacités de charge mixte de transactions complexes au niveau de l'entreprise, prend en charge une forte cohérence des transactions distribuées et est déployée dans toutes les zones de disponibilité de la même ville. , n’entraîne aucune perte de données et prend en charge plus de 1 000 extensions de capacité et de stockage de masse au niveau du PB. Dans le même temps, il dispose de fonctionnalités clés telles que la haute disponibilité, la haute fiabilité, la haute sécurité, la mise à l'échelle élastique, le déploiement en un clic, la sauvegarde et la récupération rapides, ainsi que la surveillance et l'alarme sur le cloud. Il peut fournir aux entreprises un niveau d'entreprise. base de données avec des fonctions complètes, une stabilité, une fiabilité, une forte évolutivité et des performances supérieures. Le 7 juin 2023, Huawei Goss tiendra une conférence sur l'accélération des mises à niveau des bases de données pour les principales activités financières.

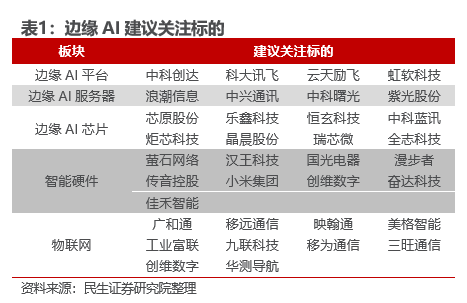

Conseil d'investissement : La tendance générale de l'IA du cloud à la périphérie a été établie et nos premiers jugements ont été continuellement vérifiés : l'IA de pointe est une tendance de l'industrie, l'intelligence incorporée est la logique interne (l'auto-amélioration de l'IA nécessite les données d'interaction entre les humains et l'environnement à concentrer sur le terminal), les robots constituent l'application ultime. Nous avons publié un rapport le 13 mai 2023, « China Science and Technology Thunder : Large Models from Cloud to Edge, Terminal Interaction Revolution Breeds Historical Opportunities », qui indiquait clairement que Google entrerait vigoureusement sur le marché des grands modèles de terminaux et que l'IA des terminaux le ferait. est devenu le prochain incontournable pour les stratèges militaires ; puis a publié "L'Empire contre-attaque" de Google : le point d'inflexion de l'IA du cloud à la périphérie » le 14 mai, détaillant le modèle d'IA de Google du cloud à la périphérie, et déclarant clairement que l'IA. le déploiement Edge est devenu réalité ; grâce à la publication des rapports d'expérience sur l'IA sur la version IOS de ChatGPT, Windows+AI et d'autres rapports d'expérience sur l'IA, nous avons publié « L'application ChatGPT marque une nouvelle étape du marché de l'IA » le 21 mai, proposant clairement que les grands modèles sont le système d'exploitation ultime à l'ère de l'IA. ChatGPT Super APP n'est que la première étape, générant la progression de l'IA traditionnelle du cloud à la fin. Cette semaine, des sociétés telles que Nvidia, Qualcomm et Thunderstar ont lancé des produits connexes pour accélérer la mise en œuvre de l'IA de pointe. La semaine prochaine, les conférences de presse de Huawei et d'Apple devraient se concentrer sur l'IA des terminaux. La tendance générale de l'IA du cloud à la périphérie. est devenu extrêmement clair, il est recommandé de prêter attention aux entreprises leaders telles que Chuangda, iFlytek et EZVIZ Network.

Source : Rapports de recherche sur le courtage sélectionnés

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI