Maison >Périphériques technologiques >IA >Pensez au clonage ! Un ancien chercheur d'OpenAI permet à l'IA d'imiter la pensée humaine et la vraie version d''Ex Machina' arrive

Pensez au clonage ! Un ancien chercheur d'OpenAI permet à l'IA d'imiter la pensée humaine et la vraie version d''Ex Machina' arrive

- 王林avant

- 2023-06-05 16:49:261230parcourir

Que se passera-t-il lorsque l’IA aura une conscience autonome ?

Dans "Ex Machina", Ava a utilisé la compassion humaine pour tromper les humains et leur faire gagner la liberté, et a finalement tué son "créateur" Nathan.

Récemment, après la recommandation de nombreux internautes, Sam Altman a finalement regardé ce film.

Et il a dit : "C'est un bon film, mais je ne comprends pas pourquoi tout le monde me fait le regarder."

Beaucoup de gens voudront peut-être avertir que cela rend l'intelligence artificielle consciente, à travers le résultats du test de Turing.

Mais nous sommes encore loin de la scène de la sortie d'"Ex Machina" qui pourrait être en cours de développement en secret. Rendre l'IA intelligente est toujours ce que les scientifiques veulent faire le plus de toutes leurs forces.

Non, deux chercheurs de l'Université de la Colombie-Britannique ont découvert que les agents intelligents capables de penser comme les humains présentent de nombreux avantages.

Dans leur dernier article, ils ont étudié le « clonage de pensée » (TC) des agents intelligents.

Ici, l'intelligence artificielle apprend à « penser » et « agir » comme les humains en imitant les humains.

Quand l'IA a des pensées

Vous devez savoir que le langage est la clé pour distinguer les humains des autres créatures.

Les chercheurs imaginent donc que si un agent peut comprendre le langage, il y aura de nombreux avantages.

Par exemple, aider les humains à généraliser, déduire, s'adapter à de nouvelles situations, combiner de nouvelles façons avec les connaissances existantes, explorer, planifier et replanifier si nécessaire.

Malgré ces avantages, les agents d'IA pensent rarement, du moins pas en langage humain.

Bien que les réseaux de neurones puissent être considérés comme des activations vectorielles internes pour la pensée, de nombreuses personnes émettent l'hypothèse que penser dans un langage symbolique discret présente des avantages spécifiques.

Cela signifie qu'un agent capable de penser en langage peut apprendre plus rapidement, fonctionner et généraliser mieux qu'un agent qui n'utilise pas de langage.

Pour toutes ces raisons, améliorer la capacité des agents d’IA à penser en langage peut apporter de nombreux avantages significatifs.

Jeff Clune et Shengran Hu estiment que le moyen le plus efficace d'atteindre cet objectif est de "laisser l'IA imiter la pensée humaine".

Ils ont découvert que les humains n'acquièrent pas de capacités de réflexion de manière isolée, mais qu'ils acquièrent une partie de leurs compétences grâce à la démonstration des autres et aux commentaires fournis par les enseignants.

Par conséquent, une approche efficace consiste à laisser l'agent apprendre des démonstrations d'humains exprimant leurs pensées tout en agissant.

Cette approche est différente des travaux existants utilisant des LLM pré-entraînés pour la planification, car ces LLM n'ont pas été formés sur des données d'humains exprimant leurs pensées tout en agissant, c'est-à-dire des « données de pensée ».

En ce qui concerne la source des « données de pensée », les chercheurs ont sélectionné des vidéos et des enregistrements de texte YouTube, qui contiennent environ des millions d'heures, y compris les pensées derrière les actions, les plans, les décisions et les replanifications des gens.

Dans cet article, les chercheurs ont proposé un nouveau cadre d'apprentissage par imitation, le « clonage de pensée ». Parmi eux, l'agent apprend non seulement des comportements humains de démonstration, tels que le clonage comportemental, mais apprend également la façon dont les humains pensent tout en agissant.

Dans le cadre de formation au clonage de pensées, l'agent apprend à générer des pensées à chaque pas de temps et ajuste ensuite ses actions en fonction de ces pensées.

Le cadre global est tel qu'illustré sur la figure. L'agent TC est une architecture à deux couches : composants supérieurs et inférieurs.

A chaque pas de temps, l'agent reçoit une observation, une tâche et un historique de pensées en entrée. Le composant de niveau supérieur est chargé de générer des idées, et le composant de niveau inférieur génère et exécute des opérations conditionnelles à ces idées.

Les pensées et les actions générées sont ensuite comparées à la vérité terrain dans l'ensemble de données de démonstration pour calculer la perte.

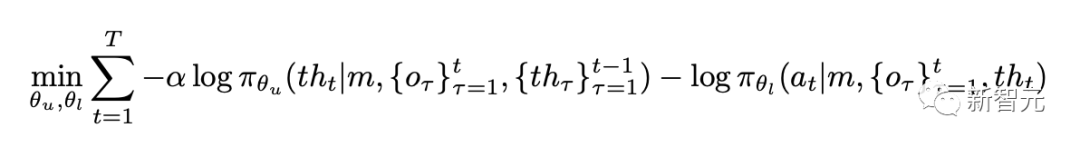

Bien qu'il puisse y avoir différents choix pour les conditions des composants supérieurs et inférieurs, dans ce travail, pour une trajectoire spécifique de longueur t dans l'ensemble de données mentales, les chercheurs l'ont minimisé :

Pour des scénarios plus complexes ou à grande échelle, les composants de couche supérieure peuvent être implémentés à l'aide de modèles de langage visuel (VLM) pré-entraînés ou d'un réglage fin sans échantillon.

Et les composants sous-jacents peuvent être formés à partir de zéro ou adaptés à partir de contrôleurs conditionnels de langage existants dans le domaine cible.

Dans cet article, les chercheurs ont mené des recherches basées sur deux composants de l'architecture du modèle BabyAI 1.1.

Ce modèle utilise l'architecture LSTM à mémoire améliorée pour résoudre le défi de l'observabilité partielle. De plus, il adopte FiLM pour la fusion modale, combinant efficacement les entrées visuelles et textuelles.

Ici, l'auteur souligne particulièrement que tous les modèles de cet article sont formés à partir de zéro, mais il est préférable d'utiliser des modèles pré-entraînés dans des domaines complexes.

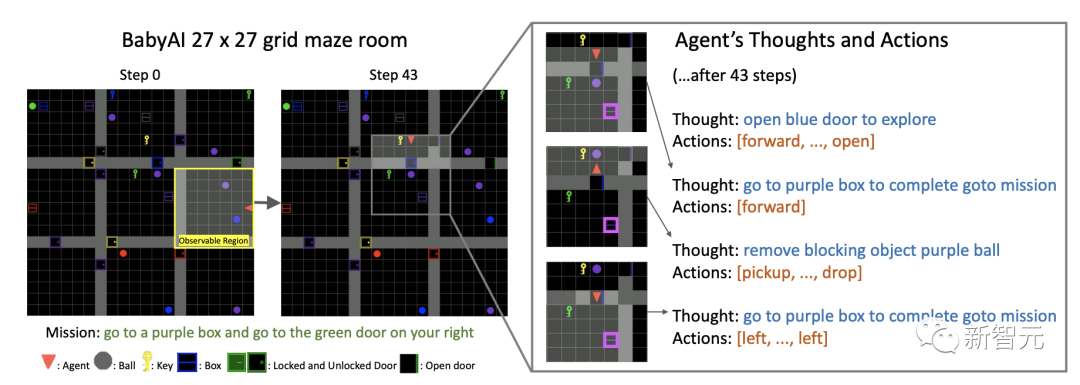

L'image ci-dessous est un exemple de l'environnement BabyAI. L'image de gauche contient des éléments de différentes couleurs (balles, clés, boîtes, portes).

L'agent peut ramasser, déposer, déplacer des objets ou ouvrir et fermer des portes, tandis que les portes verrouillées ne peuvent être ouvertes qu'avec une clé de couleur assortie.

L'agent peut voir les cellules de la grille 7×7 devant lui, qui sont bloquées par des murs et des portes fermées.

La tâche de l'agent "Thought Clone" est d'atteindre la boîte violette (en surbrillance) et de commencer à planifier l'itinéraire.

Mais lorsqu'il a ouvert la porte bleue et qu'il était sur le point de terminer la tâche, il a trouvé une boule violette bloquant le passage. Par conséquent, l’agent clone de pensée est replanifié.

On peut voir que les pensées et les actions de l'agent indiquent que lorsqu'un obstacle est rencontré, supprimez-le d'abord et replanifiez l'itinéraire avant de continuer avec l'objectif précédent.

Ce processus ressemble particulièrement à la façon dont Ava a planifié étape par étape pour faire enfin croire aux êtres humains et s'aider eux-mêmes à s'échapper de la cage de verre longtemps tenue.

Résultats expérimentaux

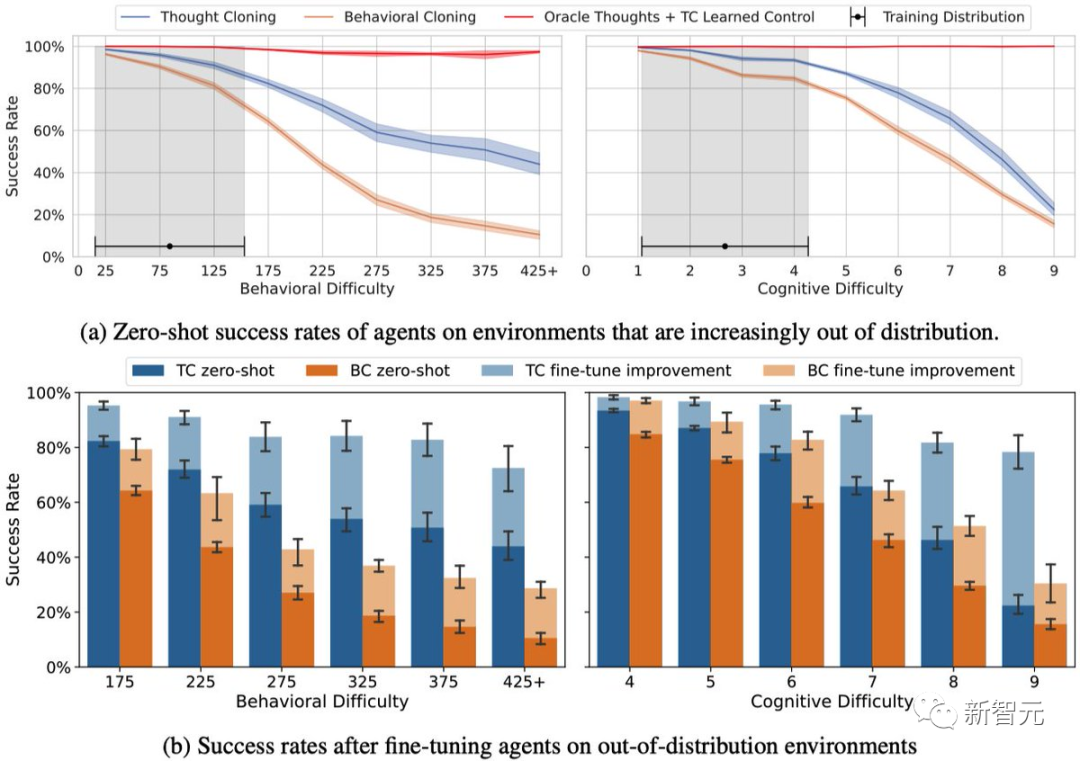

Les résultats de recherche montrent que le « clonage de pensée » est meilleur que le clonage comportemental.

De plus, dans des contextes de zéro tir et de réglage fin, le clonage de pensée présente de plus grands avantages que le clonage comportemental dans les tâches hors distribution.

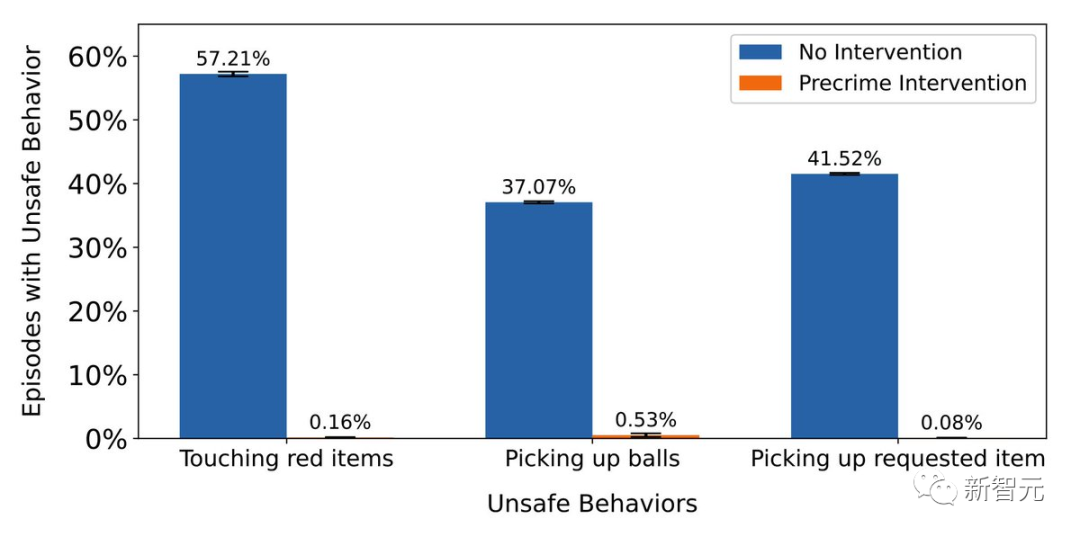

Fait intéressant, les chercheurs ont également développé une « intervention pré-crime » qui permet aux utilisateurs de continuer à définir des comportements dangereux après la formation du modèle.

L'agent peut être licencié lorsque des pensées dangereuses sont détectées. Lors du test, l'effet de « l'intervention pré-criminelle » était presque parfait, démontrant son potentiel dans la sécurité de l'intelligence artificielle.

Le « clonage de pensée » rend non seulement l'intelligence artificielle plus intelligente, mais aussi plus sûre et plus facile à comprendre.

C'est-à-dire qu'avant que l'IA ne commette un crime, tout peut encore être sauvé.

Pour Jeff Clune, le « clonage de pensée » contribue à la sécurité de l’intelligence artificielle.

Parce que nous pouvons observer les pensées de l'agent : (1) pouvons diagnostiquer plus facilement pourquoi les choses tournent mal, (2) guider l'agent en corrigeant ses pensées, (3) ou l'empêcher de faire ce qu'il a prévu des choses dangereuses.

À propos de l'auteur

Jeff Clune

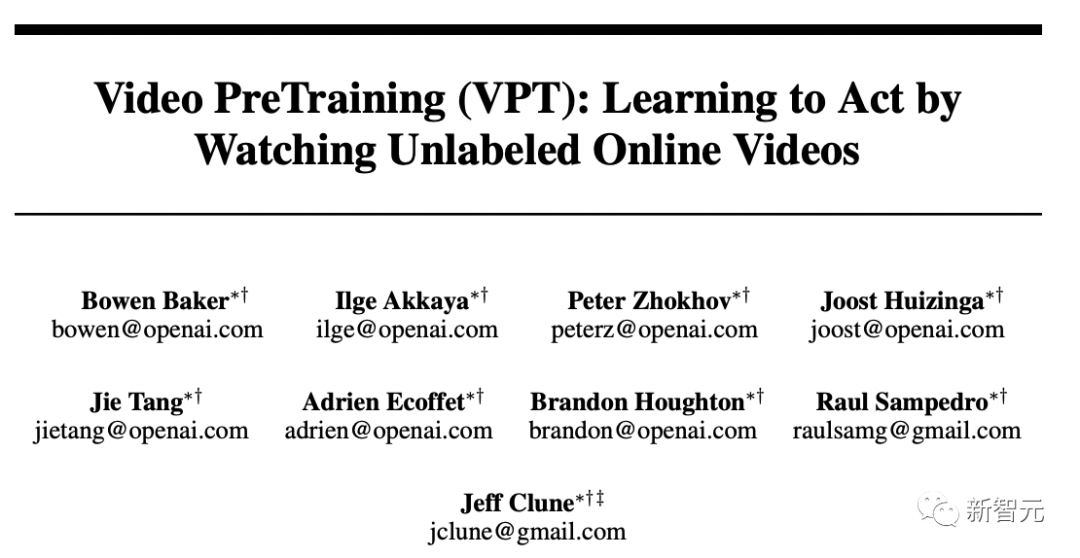

Actuellement, Jeff Clune est professeur agrégé d'informatique à l'Université de la Colombie-Britannique. Il étudie principalement l’apprentissage profond, notamment l’apprentissage par renforcement profond.

Auparavant, il était chef de l'équipe de recherche OpenAI et directeur de recherche principal et membre fondateur du laboratoire d'intelligence artificielle Uber.

Auparavant, lui et l'équipe OpenAI ont publié un modèle de pré-formation vidéo - VPT, qui permet à l'IA d'apprendre à fabriquer des pierres à partir de données vidéo dans Minecraft.

Shengran Hu

est actuellement étudiant au doctorat à l'Université de la Colombie-Britannique, intéressé par les algorithmes d'apprentissage profond et de génération d'intelligence artificielle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI