Maison >Périphériques technologiques >IA >Créez vos propres outils pour les grands modèles tels que GPT-4 pour identifier la fraude ChatGPT

Créez vos propres outils pour les grands modèles tels que GPT-4 pour identifier la fraude ChatGPT

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-06-05 16:03:401817parcourir

Table des matières :

- Détection multi-échelle positive et sans étiquette de textes générés par l'IA

- Vers la révélation du mystère derrière la chaîne de pensée : une perspective théorique

- Les grands modèles de langage en tant que créateurs d'outils

- SpecInfer : accélération du service LLM génératif avec inférence spéculative et vérification de l'arbre à jetons

- Pas cher et rapide : réglage efficace des instructions de langage de vision pour les grands modèles de langage

- mPLUG-2 : un modèle de base multimodal modularisé à travers le texte, Image et vidéo

- Où aller ensuite pour les systèmes de recommandation ? Les modèles de recommandation basés sur l'identification et la modalité revisités

Détection multi-échelle positive et sans étiquette des textes générés par l'IA

- Auteur : Yuchuan Tian, Hanting Chen, etc.

- Adresse papier : https://arxiv.org/abs/2305.18149

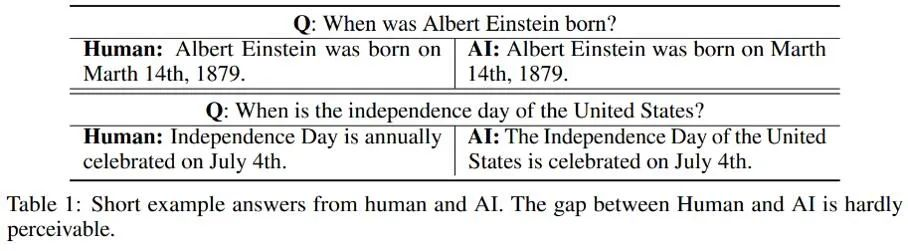

Résumé : Le taux de réussite de la fraude à l'IA est très élevé. Il y a quelques jours, "10" 4,3 millions d'arnaques en une minute " était également un sujet de recherche brûlant. Concernant le modèle de langage étendu le plus populaire, des chercheurs de l’Université de Pékin et de Huawei ont récemment exploré une méthode de reconnaissance. Voici plusieurs exemples de personnes et d'IA répondant respectivement à la même question :

Recommandé : Identifiez la "fraude ChatGPT", l'effet surpasse OpenAI : l'Université de Pékin et les détecteurs générés par l'IA de Huawei sont ici

Article 2 : Vers la révélation du mystère derrière la chaîne de pensée : une perspective théorique

- Auteur : Guhao Feng, Bohang Zhang, etc.

- Adresse de l'article : https://arxiv.org/ abs /2305.15408

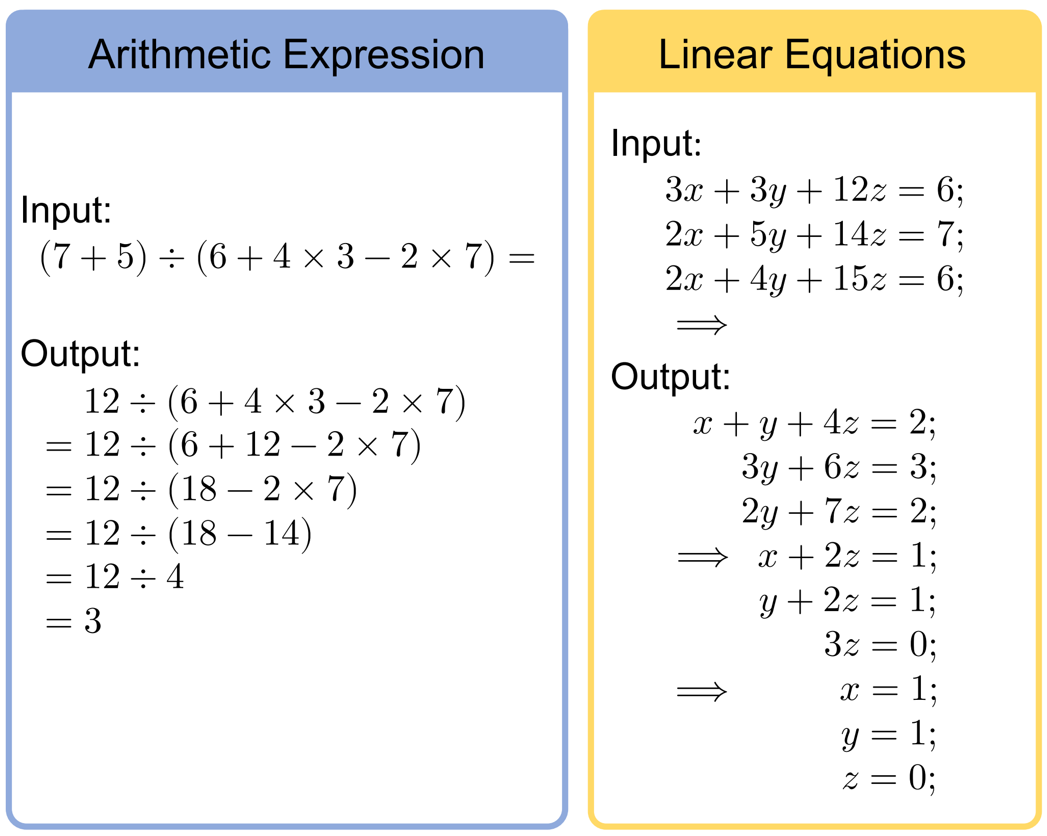

Résumé : Les Chain of Thought Tips (CoT) sont l'un des phénomènes les plus mystérieux dans l'émergence des grands modèles, en particulier dans la résolution de problèmes de raisonnement mathématique et de prise de décision, qui ont obtenu des résultats étonnants. Quelle est l’importance du CoT ? Quel est le mécanisme de son succès ? Dans cet article, plusieurs chercheurs de l'Université de Pékin prouvent que CoT est indispensable pour réaliser l'inférence de grands modèles de langage (LLM) et révèlent comment CoT peut libérer l'énorme potentiel du LLM d'un point de vue théorique et expérimental.

Cet article sélectionne deux tâches mathématiques très basiques mais essentielles : l'arithmétique et les équations (la figure suivante donne des exemples d'entrée et de sortie de ces deux tâches)

Recommandé : Thinking Chain Comment débloquer le pouvoir caché des modèles linguistiques ? Les dernières recherches théoriques révèlent le mystère qui se cache derrière cela

Article 3 : Les grands modèles linguistiques en tant que créateurs d'outils

- Auteurs : Tianle Cai, Xuezhi Wang, etc.

- Adresse de l'article : https ://arxiv .org/pdf/2305.17126.pdf

Résumé : Inspirés par l'importance de créer des outils pour les humains, dans cet article, des chercheurs de Google Deepmind, de Princeton et de l'Université de Stanford ont mis ce concept de " évolution" en perspective Appliquée au domaine du LLM, une exploration préliminaire a été réalisée. Ils proposent un cadre en boucle fermée dans lequel les LLM As Tool Makers (LATM) leur permettent de générer leurs propres outils réutilisables pour gérer de nouvelles tâches.

Recommandé : GPT-4 et d'autres grands modèles ont atteint un tournant évolutif : non seulement les utiliser, mais également créer leurs propres outils

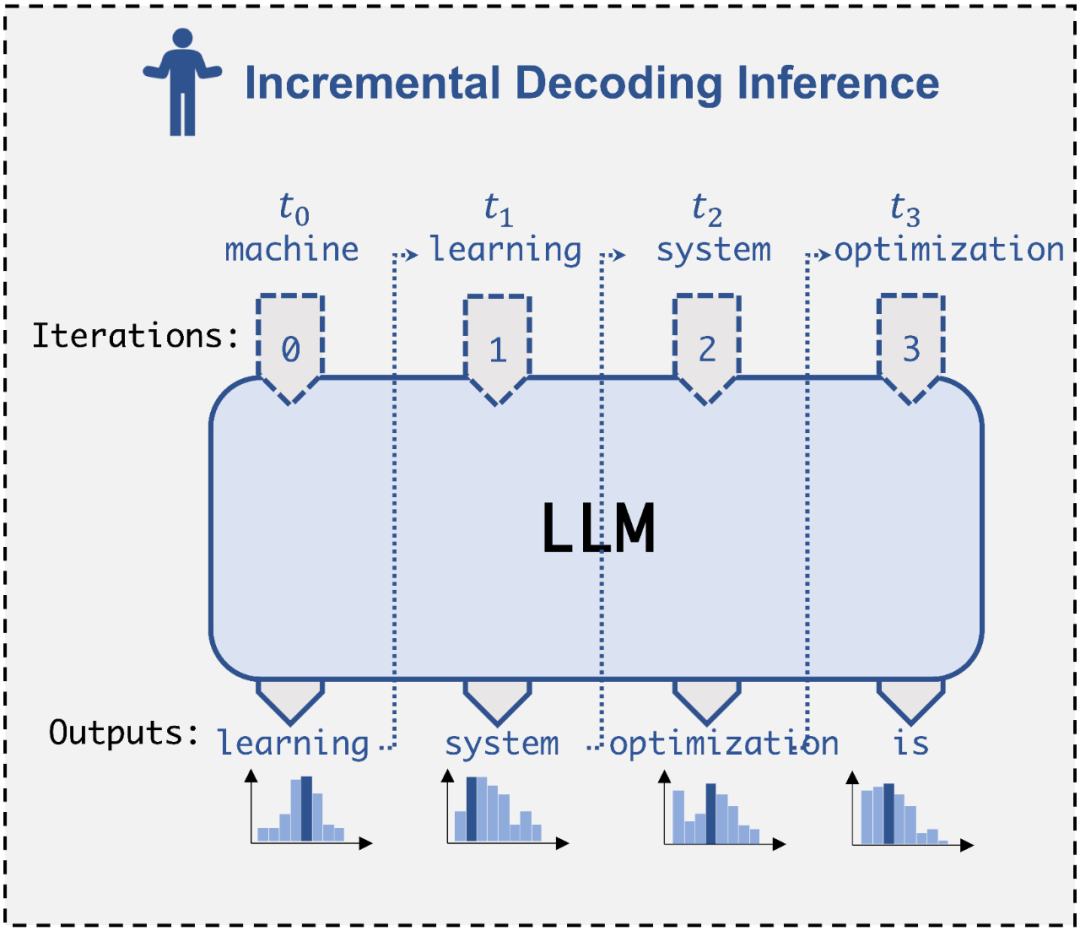

Papier 4 : SpecInfer : Accélération du service LLM génératif avec inférence spéculative et jeton Vérification de l'arbre ~ L'équipe Catalyst Group de l'Université Nike Mellon (CMU) a publié un moteur de « raisonnement spéculatif » SpecInfer, qui peut utiliser de petits modèles légers pour aider les grands modèles, atteignant deux à trois fois le raisonnement sans affecter la précision du le contenu généré s’accélère.

- Recomminissement: llm L'inférence est accélérée de 2,8 fois, les anciens de la classe CMU Tsinghua Yao ont proposé le spécial de moteur "inférence spéculative", les petits modèles exploitent les grands modèles pour une inférence efficace

paper 5 : Pas cher et rapide : réglage efficace des instructions de vision et de langage pour les grands modèles de langage

Auteurs : Gen Luo, Yiyi Zhou, etc.

Adresse papier : https://arxiv.org/pdf /2305.15023.pdf

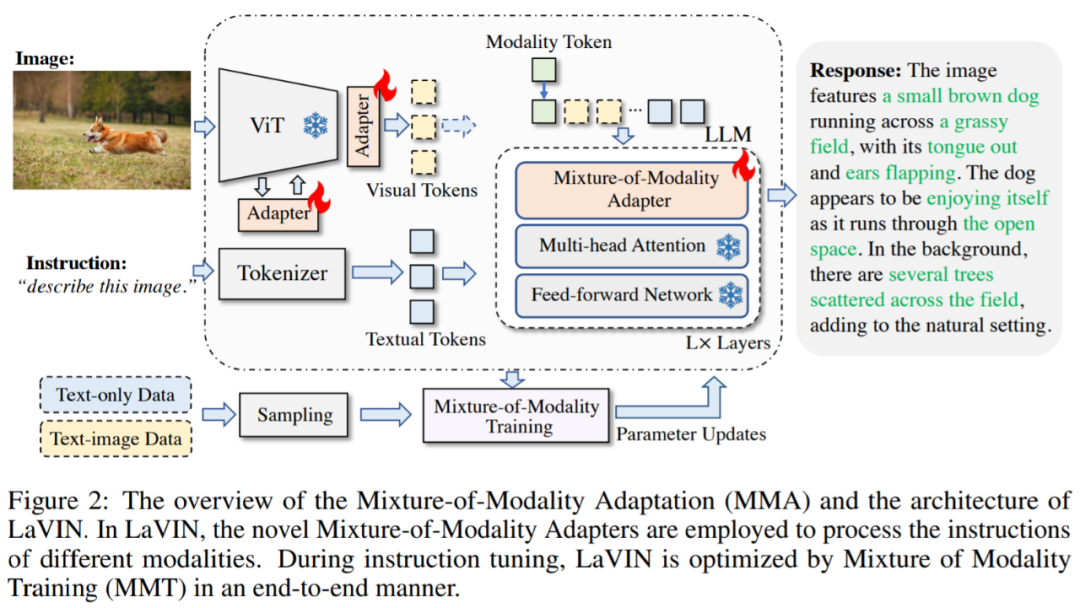

Résumé : Cet article propose une solution nouvelle et abordable pour adapter efficacement les LLM aux tâches de VL (Visual Language), appelée MMA. Au lieu d'utiliser de grands réseaux de neurones pour connecter les encodeurs d'images et les LLM, MMA adopte des modules légers, appelés adaptateurs, pour combler le fossé entre les tâches LLM et VL, tout en permettant également une optimisation conjointe des modèles d'image et des modèles de langage. Dans le même temps, MMA est également équipé d'un algorithme de routage qui peut aider LLM à basculer automatiquement entre les instructions monomodales et multimodales sans compromettre ses capacités de compréhension du langage naturel.

- Recommandé : Le temps d'entraînement est réduit de 71,4 %, les coûts de stockage sont économisés de 99,9 %, la nouvelle solution de réglage des instructions de l'Université de Xiamen, MMA, permet au modèle alpaga d'atteindre la multi-modalité

Article 6 : mPLUG-2 : Un modèle de base multimodal modularisé à travers le texte, l'image et la vidéo

Auteurs : Haiyang Xu, Qinghao Ye et al

Adresse de l'article : https://arxiv .org/pdf/2302.00402 .pdf

Résumé :Pour le modèle de base multimodal, nous espérons qu'il pourra non seulement gérer des tâches multimodales spécifiques, mais également avoir d'excellentes performances lors de la gestion de tâches uniques. tâches modales. L'équipe de l'Aidamo Academy a constaté que les modèles existants ne parviennent souvent pas à bien équilibrer les problèmes de coopération modale et d'intrication modale, ce qui limite les performances du modèle dans diverses tâches en aval monomodales et intermodales.

- Sur cette base, des chercheurs de la DAMO Academy ont proposé mPLUG-2, qui utilise une conception de structure de réseau modulaire pour équilibrer les problèmes de collaboration et d'intrication entre les modes multimodaux. Pour les tâches modales, il obtient des résultats SOTA ou comparables. volume de données et taille du modèle, et surpasse les très grands modèles tels que Flamingo, VideoCoca et GITv2 dans VideoQA et VideoCaption pour atteindre un SOTA absolu. De plus, mPLUG-Owl est le dernier ouvrage de la série mPLUG de l'Alibaba Damo Academy. Il poursuit l'idée de formation modulaire de la série mPLUG et met à niveau LLM en un grand modèle multimodal. Le document de recherche de mPLUG-2 a été accepté par l'ICML 2023.

Recommandé : ICML 2023 | Sur la base de l'idée modulaire, Alibaba DAMO Academy a proposé le modèle de base multimodal mPLUG-2

#🎜 🎜 #Papier 7 : Où aller ensuite pour les systèmes de recommandation ? # Auteurs : Zheng Yuan, Fajie Yuan, etc.

- Adresse papier : https:// arxiv.org /abs/2303.13835

- Résumé : Cet article étudie un problème prometteur, à savoir multi -mode Si le système de recommandation dynamique MoRec devrait mettre fin à la domination de 10 ans d'IDRec dans le domaine des systèmes de recommandation, sur cette base, le document a mené des recherches approfondies. Les résultats associés ont été acceptés par SIGIR 2023. La figure ci-dessous montre l'architecture du réseau. #🎜🎜 ##### 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜#Recommandé : sigir 2023 | Le paradigme classique de l’identification sera-t-il renversé ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI