Maison >Périphériques technologiques >IA >Pour résoudre le plus gros obstacle à la mise en œuvre de l'IA, OpenAI a-t-il trouvé un moyen ?

Pour résoudre le plus gros obstacle à la mise en œuvre de l'IA, OpenAI a-t-il trouvé un moyen ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-06-03 16:49:091473parcourir

OpenAI semble avoir trouvé une solution aux « graves absurdités » de l’intelligence artificielle générative.

Le 31 mai, OpenAI a annoncé sur son site officiel avoir formé un modèle qui peut aider à éliminer les « illusions » courantes et d'autres problèmes courants de l'IA générative.

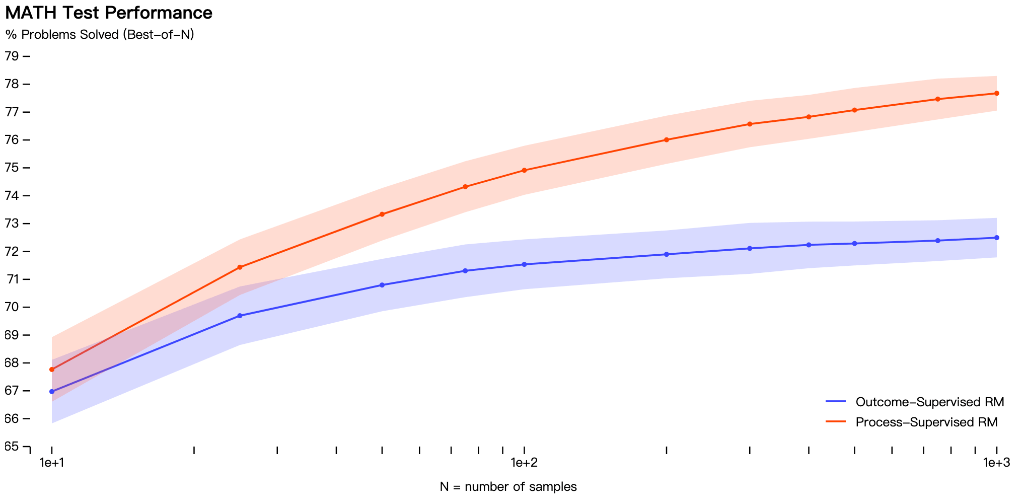

OpenAI a déclaré que les modèles de récompense peuvent être entraînés pour détecter les hallucinations, et les modèles de récompense sont divisés en modèle de supervision des résultats (fournissant un retour d'information basé sur le résultat final) ou de supervision du processus (fournissant un retour d'information pour chaque étape de la chaîne de réflexion).

C'est-à-dire que la supervision des processus récompense chaque étape correcte du raisonnement, tandis que la supervision des résultats récompense simplement les réponses correctes.

OpenAI dit qu'en revanche, la supervision des processus présente un avantage important - Elle entraîne directement le modèle à produire des chaînes de pensée approuvées par l'homme :

La supervision des processus présente plusieurs avantages en termes de cohérence par rapport à la supervision des résultats. Chaque étape est supervisée avec précision, elle récompense donc un comportement qui suit un modèle de chaîne de pensée cohérent.

La supervision des processus est également plus susceptible de produire un raisonnement explicable car elle encourage le modèle à suivre un processus approuvé par l'homme

Le suivi des résultats peut récompenser un processus incohérent et est souvent plus difficile à examiner.

OpenAI a testé les deux modèles sur un ensemble de données mathématiques, constatant que l'approche de supervision des processus aboutissait à « des performances nettement meilleures ».

Mais il est important de noter que jusqu’à présent, l’approche de supervision de processus n’a été testée que dans le domaine mathématique, et des travaux supplémentaires sont nécessaires pour voir comment elle fonctionne de manière plus générale.

De plus, OpenAI n'a pas indiqué combien de temps il faudrait pour que cette recherche soit appliquée à ChatGPT, qui est encore en phase de recherche.

Bien que les premiers résultats soient bons, OpenAI mentionne que l'approche la plus sûre entraîne une réduction des performances, appelée taxe d'alignement.

Les résultats actuels montrent que la supervision des processus ne génère pas de taxes d'alignement lorsqu'il s'agit de problèmes mathématiques, mais la situation en termes d'informations générales n'est pas encore connue.

L'« illusion » de l'IA générative

Depuis l’avènement de l’IA générative, les accusations de fabrication de fausses informations et de « génération d’hallucinations » n’ont jamais disparu. C’est également l’un des plus gros problèmes des modèles d’IA générative actuels.

En février de cette année, Google a lancé à la hâte le chatbot Bard en réponse au ChatGPT financé par Microsoft. Cependant, il a été constaté que des erreurs de bon sens avaient été commises lors de la démonstration, provoquant la chute du cours de l'action de Google.

Il existe de nombreuses raisons qui provoquent des hallucinations dans l'IA. L'une d'entre elles est la saisie de données pour inciter le programme d'IA à effectuer une mauvaise classification.

Par exemple, les développeurs utilisent des données (telles que des images, du texte ou d'autres types) pour entraîner des systèmes d'intelligence artificielle. Si les données sont modifiées ou déformées, l'application interprétera l'entrée différemment et produira des résultats incorrects.

Une illusion peut se produire dans de grands modèles basés sur le langage comme ChatGPT en raison d'un décodage incorrect du convertisseur, ce qui amène le modèle de langage à produire potentiellement une histoire ou un récit qui n'est ni illogique ni ambigu.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI