Maison >Périphériques technologiques >IA >AIGC+robot=intelligence incorporée ? Deux des hommes les plus cool de la Silicon Valley coïncident et les actions A donnent un aperçu de la « prochaine vague »

AIGC+robot=intelligence incorporée ? Deux des hommes les plus cool de la Silicon Valley coïncident et les actions A donnent un aperçu de la « prochaine vague »

- PHPzavant

- 2023-05-31 10:26:071716parcourir

De nouveaux thèmes d'IA émergent les uns après les autres. Cette fois, c'est au tour du concept d'intelligence incarnée formé par l'intégration de « robot + IA ».

Musk, "l'homme de fer de la Silicon Valley", et Jen-Hsun Huang, le "parrain des cartes graphiques" qui adore les vestes en cuir noir, ont tous deux fait des déclarations positives, qui coïncident.

Le 16 mai, heure locale, s'est tenue l'assemblée annuelle des actionnaires de Tesla 2023, Musk a déclaré lors de la réunion que Les robots humanoïdes seront la principale source de valeur à long terme de Tesla à l'avenir, « Si le rapport entre les robots humanoïdes et les humains est si. le rapport est d'environ 2 pour 1, alors la demande des gens en robots pourrait être de 10 milliards, voire 20 milliards, dépassant de loin le nombre de véhicules électriques.

Le même jour, le fondateur et PDG de Nvidia, Jensen Huang, a déclaré lors de la conférence ITF World 2023 sur les semi-conducteurs queReflétés sur le marché secondaire des actions A, les objectifs associés ont fortement augmenté aujourd'hui, de nombreuses actions atteignant leurs limites quotidiennes. À la clôture, MOONS Electric, Youde Precision et OBI Zhongguang avaient atteint leur limite quotidienne, tandis que Robotics, ArcSoft Technology, Yuntian Lifei, Haozhi Electromechanical, Eft, etc. avaient augmenté de plus de 10 %.La prochaine vague d'IA sera « l'intelligence incorporée » Il a également annoncé Nvidia VIMA, une intelligence artificielle incarnée multimodale pour les systèmes intelligents. capable d'effectuer des tâches complexes guidées par des indices textuels visuels.

Musk met l'accent sur le potentiel de ses robots humanoïdes depuis 2021, et propose sans relâche les larges perspectives des « robots + intelligence artificielle ». À l’heure où l’AIGC (IA générative) est en vogue, la vulgarisation du terme « intelligence incarnée » arrive à point nommé, replaçant « robot + IA » sur le devant de la scène.

AIGC, intelligence incarnée et robots, comment les trois sont-ils connectés ?

Robot humanoïde Tesla≈Robot intelligent incarné

Les gens connaissent déjà les robots humanoïdes de Musk. Du point de vue de l'utilisation finale, lesLes robots humanoïdes Tesla et les robots intelligents incarnés sont presque égaux.

L'objectif à long terme de Musk pour les robots Tesla est de permettre aux robots de s'adapter à l'environnement et de faire ce que font les humains, afin qu'ils puissent servir des milliers de foyers, comme cuisiner, tondre la pelouse, prendre soin des personnes âgées, etc.Un robot intelligent incarné est un agent intelligent qui possède une entité physique, peut interagir de manière multimodale avec le monde réel, percevoir et comprendre l'environnement comme les humains et accomplir des tâches grâce à un apprentissage autonome. Dieter Fox, directeur principal de la recherche en robotique chez NVIDIA et professeur à l'Université de Washington, a précédemment souligné que l'un des objectifs clés de la recherche en robotique est de construire des robots utiles aux humains dans le monde réel.

AIGC propose de nouvelles idées pour l'intelligence incarnée afin de surmonter les goulots d'étranglement techniques

L'intelligence incorporée est une question fondamentale dans la science du renseignement et un gros problème. L'AIGC fournit de nouvelles idées pour la réalisation de l'intelligence incarnée.En 1950, Turing a proposé pour la première fois le concept d'intelligence incarnée dans son article « Computing Machinery and Intelligence ». Au cours des décennies suivantes, l’intelligence physique n’a pas fait de grands progrès en raison de contraintes techniques.

Comme l'a dit Fei-Fei Li, professeur d'informatique à l'Université de Stanford : "

Le sens de l'incarnation n'est pas le corps lui-même, mais les besoins et les fonctions globales d'interaction avec l'environnement et de faire des choses dans l'environnement."

L'interaction avec les gens et l'environnement est la première étape pour que les robots intelligents incarnés développent la capacité de comprendre et de transformer le monde objectif À cet égard, l'obstacle le plus direct est que les gens s'appuient fortement sur des codes manuscrits pour contrôler les humains. et Face à l’intelligence artificielle, la « Tour de Babel » s’élève.

À l'ère de l'AIGC, les grands modèles d'IA tels que GPT ont fourni de nouvelles solutionsDe nombreux chercheurs ont essayé d'utiliser de grands modèles de langage multimodaux comme pont pour la communication entre les humains et les robots. Autrement dit, en entraînant conjointement des images, du texte et des données incarnées, et en introduisant une entrée multimodale, le modèle peut améliorer la compréhension des objets réels et aider les robots à gérer des tâches de raisonnement incarné.

Microsoft, Google, Alibaba, etc. explorent activement

À l'heure actuelle, l'intelligence incarnée est devenue une direction de recherche académique internationale de pointe. Des institutions, dont la National Science Foundation des États-Unis, promeuvent le développement de l'intelligence incarnée. Les grandes conférences universitaires internationales ont également commencé à accorder de plus en plus d'attention à l'intelligence incarnée. sujets de travail, les meilleures universités des États-Unis ont commencé à former des communautés de recherche sur l’intelligence incarnée.L'industrie fait également des progrès rapides,

Google et Microsoft prennent les devants en essayant d'injecter de l'âme dans les robots avec de grands modèles. Le modèle PaLM-E du premier est indissociable de l'intelligence incarnée. La réalisation de tâches robotiques incarnées a toujours été au centre des recherches sur ce modèle. Le second explore la manière d'étendre le ChatGPT développé par OpenA au domaine de la robotique, nous permettant de contrôler intuitivement. des machines telles que des machines à langage, des drones, des robots d'assistance à domicile et d'autres plates-formes.

Au niveau national,Alibaba expérimente également la connexion du grand modèle Qianwen à des robots industriels En saisissant une phrase en langage humain dans la boîte de dialogue DingTalk, le robot peut être commandé à distance pour fonctionner.

L'axe principal d'investissement devient de plus en plus clair

Techniquement, la réalisation de l'intelligence incarnée est indissociable de trois liens majeurs : la perception, l'imagination et l'exécution. Plus précisément, pour réaliser un robot intelligent incarné, il doit avoir une pensée flexible, une forte capacité d'exécution, une excellente capacité de communication avec les gens et une capacité d'auto-apprentissage semblable à celle d'un humain.Une exécution puissante repose sur les périphériques physiques du robot, c'est-à-dire le corps mécanique et le contrôle de base des mouvements. La perception et l'imagination peuvent être externalisées dans la capacité du robot à entendre, voir et parler, ce qui nécessite l'utilisation de la vision industrielle, en profondeur. apprentissage et renforcement L'apprentissage et d'autres technologies d'IA optimisent les logiciels et les algorithmes et utilisent un grand nombre d'ensembles de données couvrant différents environnements tels que le texte, la vision, la parole et les scènes pour la formation.

De nombreuses institutions pensent que l'industrie de la robotique, les grands modèles multimodaux et la technologie de vision industrielle sont de nouvelles directions pour gagner de l'argent. Guosheng Securities a déclaré que le GPT multimodal peut grandement contribuer au développement de l'industrie de la robotique. Au cours des 5 à 10 prochaines années, les grands modèles combinés à des solutions multimodales complexes devraient avoir des capacités complètes pour interagir avec le monde et être appliqués. des domaines tels que les robots généraux ; Tianfeng International Securities a déclaré que l'IA est la mère de la vision industrielle et que l'apprentissage profond est la forteresse technique de la vision industrielle. La récente publication du modèle SAM par Meta devrait aider la vision industrielle à inaugurer le moment GPT. .

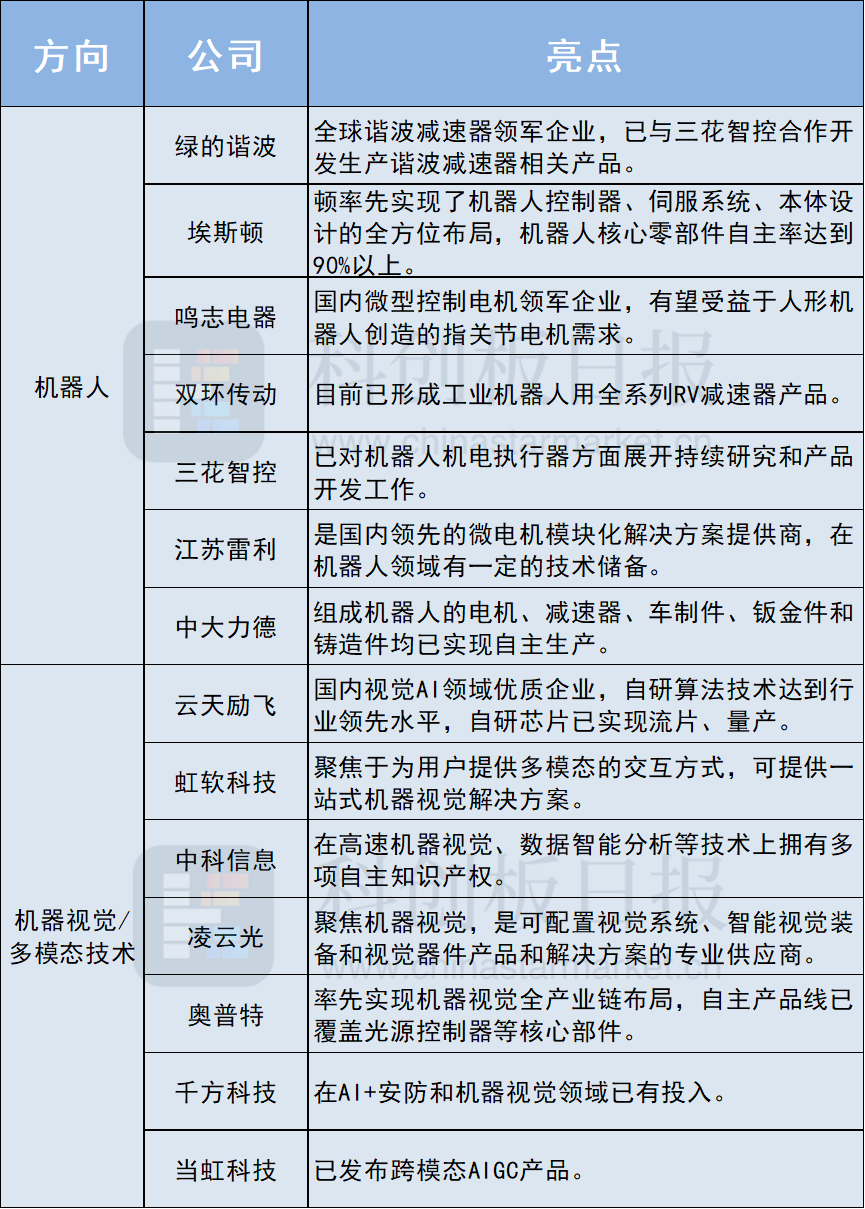

Les entreprises des secteurs ci-dessus ou disposant des technologies correspondantes sont devenues le centre d'attention. Les sociétés cotées telles qu'Interactive Yishang, Lingyunguang, Huichuan Technology, Haitian Ruixiang, etc. ont toutes été interrogées par les investisseurs sur leur lien avec l'intelligence incarnée. Parmi elles, Lingyunguang est l'une des rares entreprises à avoir donné une réponse claire, affirmant qu'elle utilise la technologie de fusion multimodale pour répondre aux besoins de fabrication intelligente multi-scénarios des clients, ce qui constitue une étape nécessaire dans le développement de l'intelligence incorporée. Combinées aux rapports de recherche institutionnels, selon un examen incomplet du Science and Technology Innovation Board Daily, ces entreprises ont également retenu l'attention :

Source : Conseil quotidien de l'innovation scientifique et technologique

Source : Conseil quotidien de l'innovation scientifique et technologique

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI