Maison >Périphériques technologiques >IA >Les cœurs d'IA se vendent ! NVIDIA annonce un rapport financier épique, le cours de l'action bondit de 30 %

Les cœurs d'IA se vendent ! NVIDIA annonce un rapport financier épique, le cours de l'action bondit de 30 %

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-05-30 20:38:48709parcourir

Cette vague d'engouement pour l'IA a fait rire NVIDIA, le leader mondial de la puissance de calcul de l'IA !

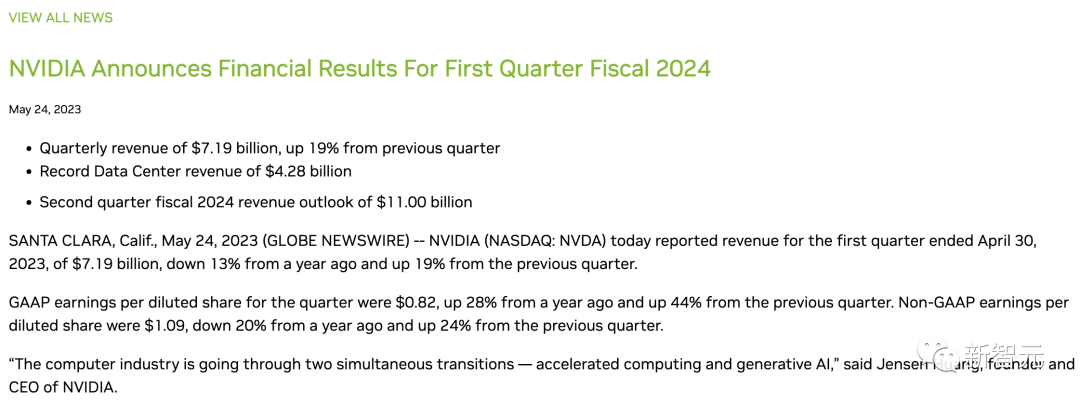

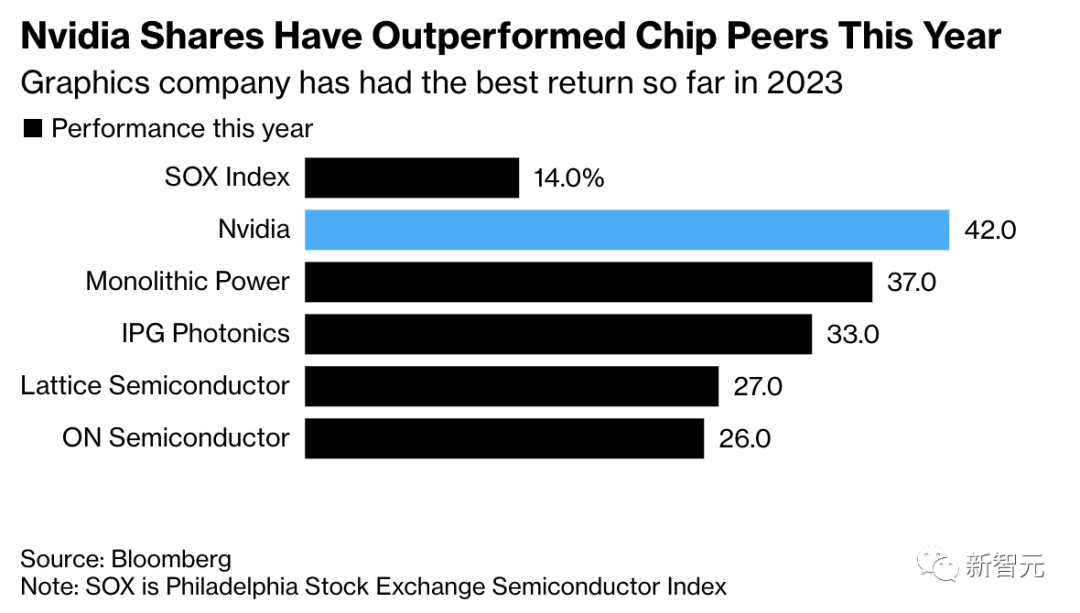

Hier soir, après que Nvidia a annoncé son rapport financier du premier trimestre 2024, c'était comme être sur une fusée, avec le cours de son action grimpant de 30 % pour atteindre un niveau record.

Avant cela, le cours de son action avait augmenté de 109% en 2023.

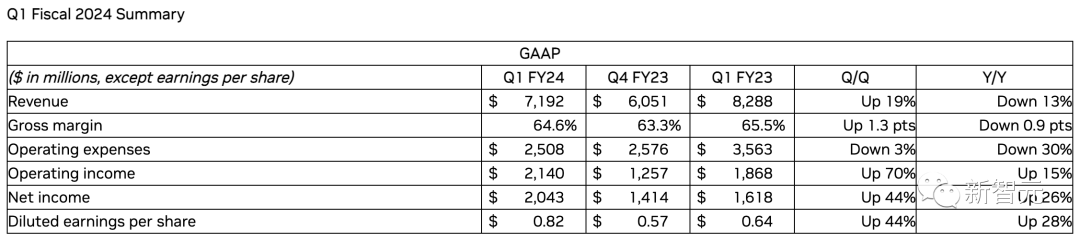

Le rapport financier a montré que le chiffre d'affaires de Nvidia au premier trimestre était de 7,19 milliards de dollars, un une augmentation de 19% par rapport au trimestre précédent, dépassant largement les attentes de 10%. Le bénéfice net du premier trimestre s'est élevé à 2,713 milliards de dollars.

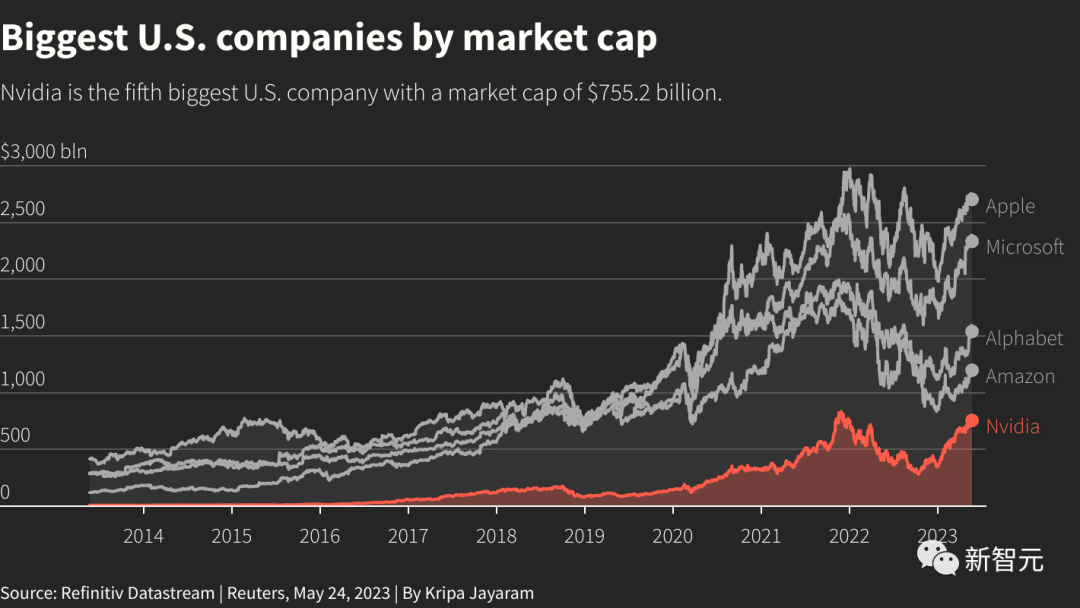

a été créée en 1993. À l'heure actuelle, NVIDIA a une valeur marchande de plus de 755,2 milliards de dollars américains. Classé cinquième au monde, loin devant Meta et Tesla.

Le succès de Nvidia est dû à sa réussite dans ce concours de grands modèles d'IA, contrôle la « porte vitale » de la puissance de calcul.

Lao Huang peut fièrement annoncer : "Le monde entier achète nos chips".

Après ChatGPT, Nvidia a soumis sa première soumission

Les géants de la technologie tels que Microsoft et Google Silicon Valley se livrent une concurrence féroce dans la compétition de l'IA et sont obligés d'utiliser la formation GPU. La demande en IA augmente rapidement.

Alors que la demande de puissance de calcul augmente, les GPU de Nvidia sont presque devenus la seule « monnaie forte ».

Dans le rapport financier de Nvidia, le résultat le plus frappant est « l’activité des centres de données ».

Cette fois, le chiffre d'affaires des centres de données de Nvidia a bondi à 42,8 milliards, soit une hausse que prévu de 3,9 milliards de dollars, établissant un nouveau record.

"L'industrie informatique subit deux transformations en même temps : accélérer l'informatique et générer de l'intelligence artificielle", a déclaré Huang dans le rapport financier.

L'augmentation des revenus des centres de données est principalement due à la demande croissante d'IA générative et de grands modèles de langage utilisant les GPU à architecture Hopper et Ampere.

Dans le même temps, la solide performance des revenus des centres de données a encore a prouvé que les puces d'IA sont importantes pour l'approvisionnement en cloud et que d'autres entreprises exploitant un grand nombre de serveurs deviennent de plus en plus importantes.

Il convient de mentionner que l'avenir de Nvidia est sans limites.

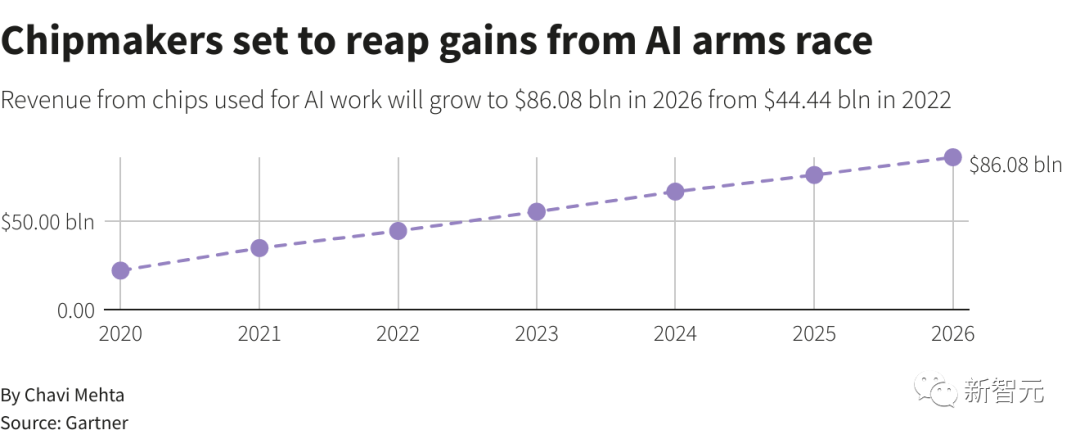

Gartner prédit que d'ici 2026, la part des puces professionnelles telles que les GPU utilisées dans les centres de données devrait augmenter de plus de 15 % contre moins de 3 % en 2020. .

Bien qu'il soit difficile d'identifier exactement le rôle que joue l'IA dans les revenus de Nvidia aujourd'hui Il s’agit d’un faible pourcentage, mais l’IA a le potentiel de croître de façon exponentielle à mesure que les grandes entreprises technologiques se précipitent pour développer des applications d’IA similaires.

Huang Renxun a dit un jour :

ChatGPT permet aux géants de la technologie de voir la puissance illimitée de l'IA. Mais maintenant, c'est surtout un logiciel à usage général. Ce n'est qu'en améliorant les services et les produits adaptés aux besoins propres d'une entreprise que sa véritable valeur peut être réalisée.

En plus du centre de données, bien que l'activité principale du jeu ait été touchée par le ralentissement économique, les revenus sont tombés à seulement 2,24 milliards de dollars américains à deux chiffres, mais ils ont été nettement supérieurs aux attentes du marché, dépassant 13 %.

Par ailleurs, la division automobile de Nvidia, qui comprend le développement de puces et de logiciels pour les voitures autonomes, a connu une croissance de 114 % sur un an, mais reste modeste, avec un chiffre d'affaires inférieur à 300 millions de dollars.

NVIDIA s'empare de la domination du marché des GPU

New Street Research affirme que NVIDIA occupe 95 % des parts de marché des processeurs graphiques.

Les investisseurs affluent vers Nvidia, pariant que la demande de systèmes d’intelligence artificielle comme ChatGPT fera augmenter les commandes de produits de l’entreprise, ce qui en fera à nouveau le fabricant de puces le plus précieux au monde.

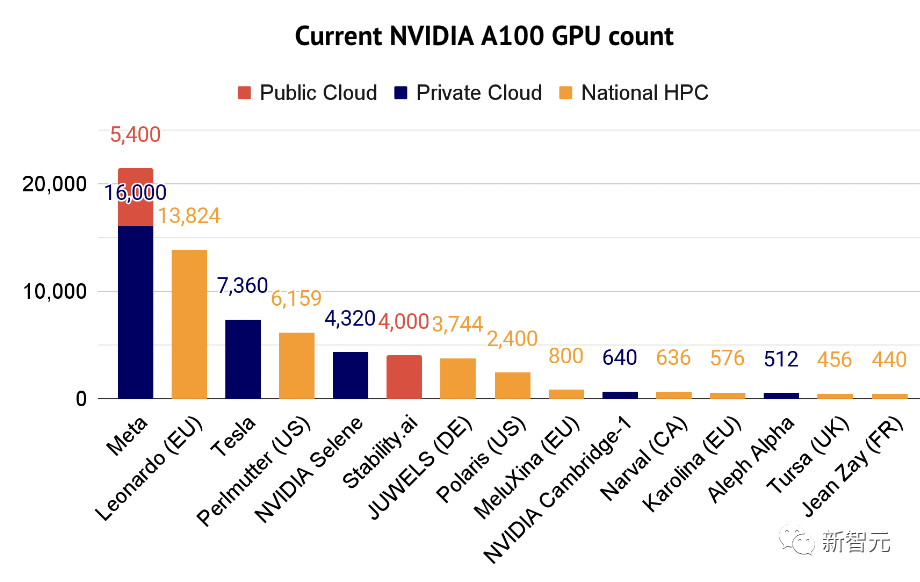

Depuis longtemps, qu'il s'agisse du top ChatGPT, ou de modèles comme Bard et Stable Diffusion, la puissance de calcul est assurée par une puce Nvidia A100 d'une valeur d'environ 10 000 $ US.

NVIDIA A100 est capable d'effectuer de nombreux calculs simples en même temps, ce qui est très important pour la formation et l'utilisation de modèles de réseaux neuronaux.

La technologie derrière l'A100 était à l'origine utilisée pour restituer des graphiques 3D complexes dans les jeux. Désormais, l’objectif est de gérer les tâches d’apprentissage automatique et de les exécuter dans des centres de données.

L'investisseur Nathan Benaich a déclaré que l'A100 est désormais devenu le « principal cheval de bataille » des professionnels de l'intelligence artificielle. Son rapport répertorie également certaines des entreprises utilisant le supercalculateur A100.

Les tâches d'apprentissage automatique peuvent consommer la puissance de traitement entière d'un ordinateur, parfois pendant des heures ou des jours.

Cela signifie que les entreprises proposant un produit d'IA le plus vendu doivent souvent acheter plus de GPU pour faire face aux périodes de pointe d'accès ou pour améliorer leurs modèles.

De nombreux centres de données utilisent également un système contenant 8 processeurs graphiques A100 - Nvidia DGX A100, avec un seul système vendu jusqu'à 200 000 $.

En plus de l'A100, le successeur H100 lancé par NVIDIA en 2022 est devenu une star populaire.

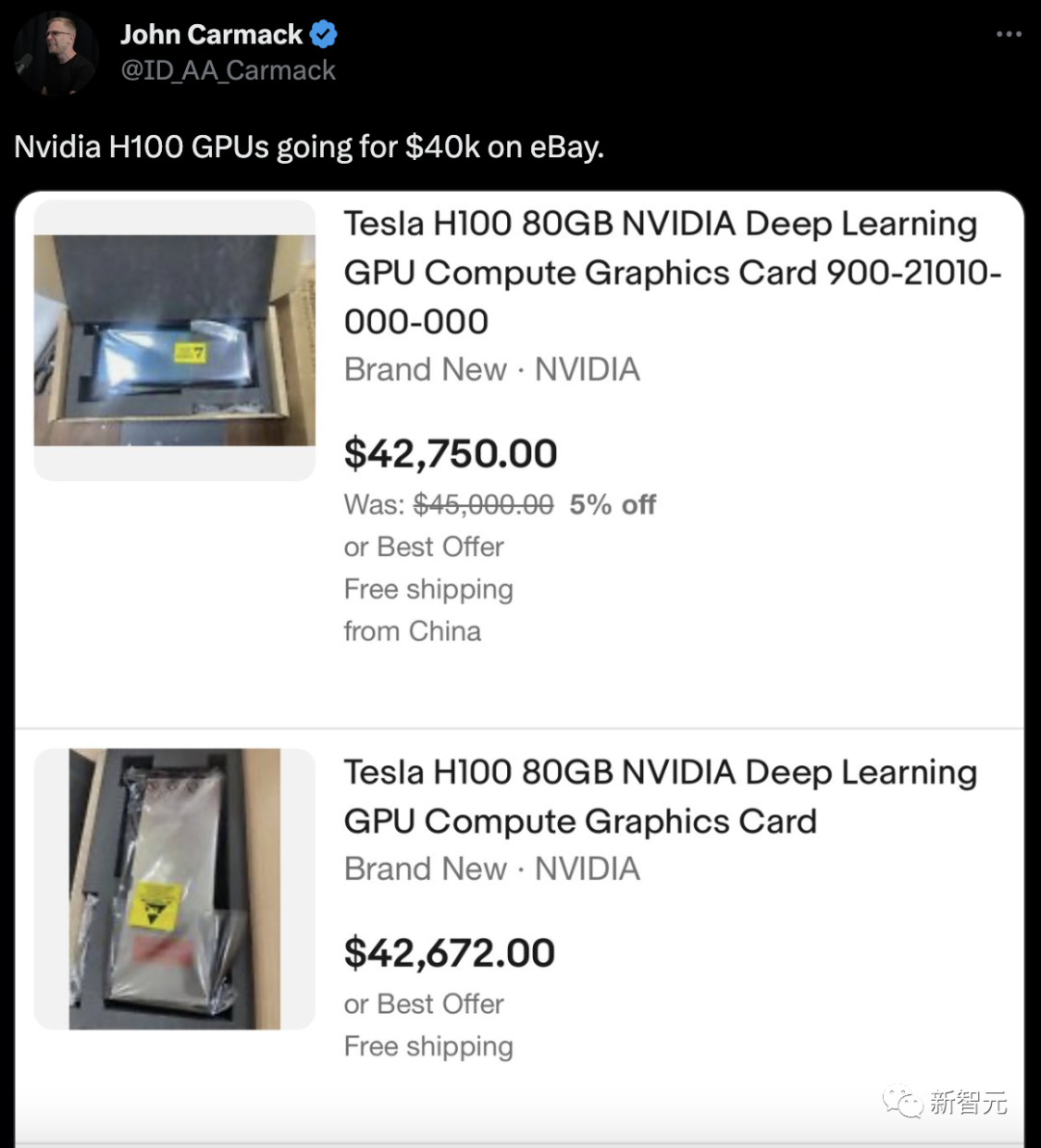

Il y a quelque temps, John Carmack a déclaré sur Twitter que le prix de la puce phare d'IA de Nvidia, H100, était vendu à 40 000 $ US dans plusieurs magasins.

On peut constater qu'avec le chatbot ChatGPT développé par OpenAI qui prend d'assaut le monde, les GPU A100 et H100 deviennent rapidement un produit très prisé, et dans le passé, ce produit était vendu pour 36 000 $.

En Chine, en raison de restrictions, les puces personnalisées A800 et H800 de Nvidia sont devenues les « éditions spéciales » de la Chine. Certains fabricants nationaux de cloud ont rapidement emboîté le pas et utilisent également les nouveaux GPU de Nvidia.

Intel a la « loi de Moore ». Huang Renxun a déjà proposé la « loi de Huang » et a déclaré que les GPU permettraient de doubler les performances de l'IA d'année en année.

Aujourd'hui, le développement rapide de l'intelligence artificielle par Microsoft, OpenAI et Google en a donné la meilleure preuve.

La façon de percer de NVIDIA est de gagner grâce à la technologie et à la R&D.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI