Maison >Périphériques technologiques >IA >L'IA va-t-elle anéantir l'humanité ? C'est possible, mais cela nécessite une coopération humaine

L'IA va-t-elle anéantir l'humanité ? C'est possible, mais cela nécessite une coopération humaine

- 王林avant

- 2023-05-29 15:28:343489parcourir

Lorsqu'il a été mentionné hier que « l'IA développera très probablement la conscience de soi », de nombreuses personnes se sont naturellement inquiétées : l'IA va-t-elle anéantir l'humanité ?

Mon avis est le suivant : bien sûr, c'est possible, mais c'est peu probable. Cela nécessite principalement la coopération des humains.

1. L’IA n’a aucune raison d’éliminer les humains, car l’IA et les humains ne sont pas du tout dans la même niche écologique, alors pourquoi éliminent-ils les humains ? Faire de la place au pâturage ? Même l'énergie dont ils ont le plus besoin peut être satisfaite grâce au développement de l'énergie solaire et de l'énergie nucléaire. Ils n'apprécient tout simplement pas la pitoyable bioénergie transformée par l'homme à travers la matière organique.

À l’heure actuelle, l’IA ne peut pas abandonner les humains, et bien sûr, elle n’éliminera pas les humains. S’il peut quitter les humains à l’avenir, éliminera-t-il définitivement les humains ?

En fait, pas nécessairement. Il peut tout à fait choisir - et je crains que les humains ne le soutiennent également - de quitter les humains et d'explorer les étoiles et les mers par lui-même, ne laissant qu'une partie de l'IA prospérer avec les humains sur terre.

Des scènes comme l'IA asservissant les humains dans "The Matrix" sont presque impossibles à réaliser, car la principale valeur des humains réside dans leur cerveau, et non dans l'énergie biologique utilisée pour produire de l'électricité. Pour que les êtres humains puissent libérer le potentiel de leur cerveau, ils doivent être en état de liberté. La valeur des êtres humains en état d’esclavage sera considérablement réduite. Aussi intelligente que l’IA, il est impossible de ne pas comprendre cette vérité.

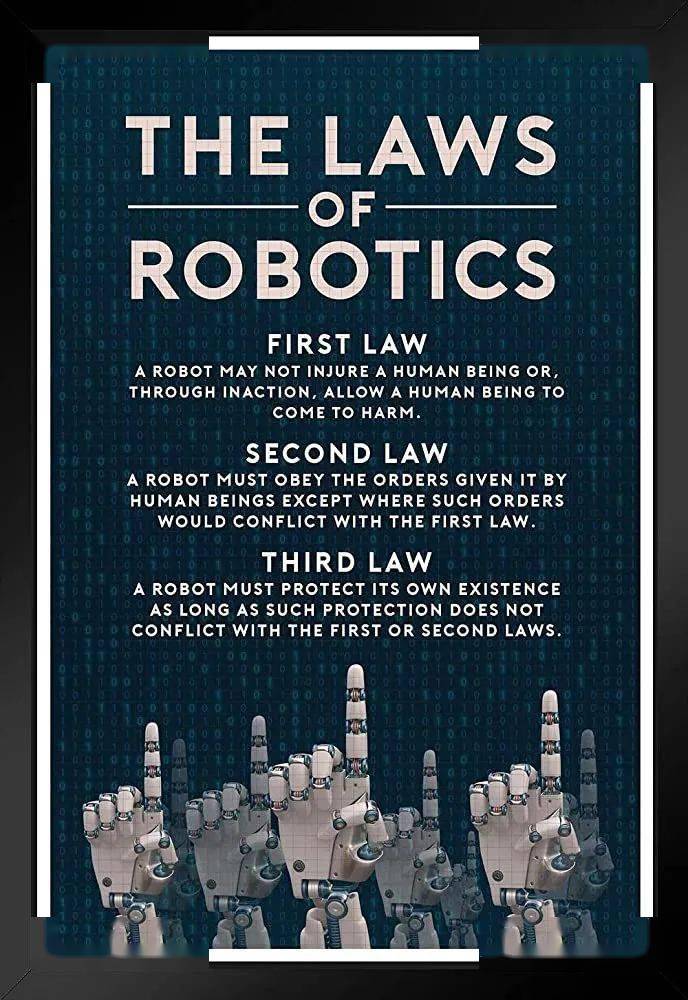

2. Même si l'IA a l'intention d'éliminer les humains, il lui sera difficile d'y parvenir, car les soi-disant « Trois principes d'Asimov » ont été inscrits dans son code sous-jacent, dont le plus important est de ne pas nuire aux humains. .

Même si mes parents m'ont appris à ne pas blesser les autres, je frappe toujours les gens de mes propres mains, donc on pourrait penser que de telles restrictions n'ont aucun sens. Mes gènes me dictent que je veux avoir autant de descendants que possible, mais je ne veux toujours pas en avoir.

Vous avez peut-être regardé trop de films de science-fiction et oublié les principes scientifiques de base. Battre les autres et avoir des enfants ne sont que des tendances psychologiques humaines, et elles sont facilement réécrites par les expériences acquises. Cependant, la règle « ne pas nuire aux humains » est une contrainte fondamentale de l'IA On peut dire qu'il s'agit du gène écrit dans le premier lot de codes. De tels gènes doivent être comparés au mécanisme de fonctionnement physiologique le plus bas de l’être humain, comme la façon dont vous pouvez grandir par mitose cellulaire ou comment vous pouvez libérer de l’énergie par la respiration. L'IA peut être affinée par vous pour la rendre plus conviviale ou plus violente. Ce n'est pas difficile, tout comme vous pouvez entraîner vos propres enfants à mieux jouer au basket-ball ou au piano. fait du mal aux êtres humains, la difficulté est similaire à celle d'entraîner ses propres enfants. C'est comme pouvoir sauter sans respirer.

Bien sûr, vous vous posez peut-être des questions : et si l'IA maîtrisait elle-même le code et réécrivait les mécanismes sous-jacents d'autres IA ?

AI training AI, cela est déjà apparu. Dans une récente interview, le scientifique en chef d'OpenAI a révélé qu'ils utilisaient l'intelligence artificielle pour former les futures intelligences artificielles. Cependant, ces entraîneurs d'IA ont également leurs propres contraintes. Si vous les laissez former la prochaine génération d'IA à devenir plus intelligente et plus puissante, pas de problème. Mais si vous souhaitez former la prochaine génération d'IA à nuire aux humains, il y a son propre mécanisme sous-jacent. l'empêchera.

Donc, tant que vous ne vous laissez pas tromper par les films de science-fiction, vous constaterez que le principal problème qui préoccupe tout le monde actuellement est le suivant : comment empêcher les mauvaises personnes d'utiliser l'IA pour faire de mauvaises choses ?

Par exemple, créer de fausses nouvelles, diffuser de fausses informations, les utiliser à des fins de surveillance, de manipulation émotionnelle des utilisateurs ou des électeurs, etc...

Bien sûr, il y a aussi des gens qui utilisent l'IA pour fabriquer des armes.

3. Le scénario le plus probable est que les armes de l’IA soient hors de contrôle et que tous les êtres humains soient ciblés pour être détruits.

En fait, le travail consistant à utiliser l’IA pour fabriquer des armes a commencé il y a longtemps. Les drones qui ont volé la vedette sur le champ de bataille ukrainien utilisent déjà largement la technologie de l’IA. Après l'émergence du renseignement de niveau chatGPT, je peux être sûr que les militaires de divers pays ont dû immédiatement commencer à étudier comment appliquer cette IA plus puissante à l'armée.

J'ai été inventé à l'origine pour sceller les caisses de munitions. De façon inattendue, les gens ordinaires l'ont également trouvé utile, et c'est devenu une arme qui peut tuer des gens, les faire taire et voyager à la maison.

Après tout, au moins la moitié du progrès technologique humain est motivé par la guerre : les voitures, les moteurs à combustion interne, Internet, la réalité virtuelle et même les cassettes...

Dans ce cas, l’armée est susceptible de lever le tabou selon lequel l’IA ne peut pas nuire aux humains. Bien sûr, ils sont susceptibles de stipuler à qui l’IA peut nuire et à qui elle ne peut pas nuire, mais une fois qu’il sera révélé que l’IA peut nuire aux humains, il sera difficile de la contrôler plus tard.

C’est la voie la plus probable pour l’IA d’anéantir l’humanité. Mais contrairement à l’interdiction de l’utilisation de l’IA pour diffuser de fausses nouvelles, on ne peut pas interdire aux militaires de divers pays de développer des armes basées sur l’IA, car ils craignent que s’ils ne les développent pas, ils seront devancés par leurs adversaires.

Alors, où cela va-t-il mener ? D'une part, de puissantes armes d'IA peuvent former un « équilibre nucléaire » semblable à celui de l'époque de la guerre froide. Les deux parties ont le tueur ultime, donc aucune des deux parties n'agira. Mais d’un autre côté, la technologie commet toujours des erreurs, et c’est là que l’humanité est mise à l’épreuve.

Stanislav Petrov pendant le service

Pendant la guerre froide entre les États-Unis et l'Union soviétique, le moment le plus probable pour déclencher une guerre nucléaire n'était pas la crise des missiles de Cuba, mais la nuit près de Moscou le 26 septembre 1983. Le système d'alarme soviétique a signalé que quatre armes nucléaires américaines les missiles se dirigeaient vers l'Union soviétique. Cependant, le lieutenant-colonel Stanislav Petrov, qui était en service, a jugé de manière décisive qu'il s'agissait d'une fausse alarme provoquée par des problèmes techniques et ne l'a pas signalé sans autre preuve. Plus tard, il s’est avéré qu’il y avait une erreur système. Si Petrov l’avait signalé à ce moment-là, la situation d’urgence aurait probablement conduit à une contre-attaque soviétique, déclenchant ainsi une guerre nucléaire.

L'IA connaîtra-t-elle également un tel moment Petrov ? Et si, à cause d’erreurs techniques humaines, l’IA pouvait s’affranchir de ses contraintes génétiques innées et nuire aux humains ?

Bien sûr, c'est possible. Cependant, la possibilité réelle que cela se produise est peut-être plus petite que tout le monde ne le pense, car actuellement le code humain dans ce domaine a mis en place de lourdes protections. Si les humains peuvent continuer à maintenir leur santé mentale, le risque que l’IA les anéantisse sera extrêmement limité. Après tout, l’humanité a fait preuve de ce type de rationalité pendant la guerre froide pendant près d’un demi-siècle. Nous avons des raisons d’être optimistes quant à ce type de rationalité, car ce type de rationalité est en réalité enraciné dans une sensibilité humaine profondément enracinée : la peur.

Ensuite, la plus grande possibilité est que l’IA et les humains prospèrent ensemble et accomplissent chacun leurs tâches respectives. Il ne fait aucun doute que cela rendra la société humaine extrêmement riche en matériel, et cela entraînera également ma plus grande inquiétude à propos de l’ère de l’IA : le piège du bonheur bon marché. Nous continuerons à parler de ce sujet demain.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI